點(diǎn)擊上方“小白學(xué)視覺(jué)”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

很多朋友在學(xué)習(xí)了神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)之后,早已迫不及待要開(kāi)始動(dòng)手實(shí)戰(zhàn)了。第一個(gè)遇到的問(wèn)題通常就是數(shù)據(jù)。作為個(gè)人學(xué)習(xí)和實(shí)驗(yàn)來(lái)說(shuō),很難獲得像工業(yè)界那樣較高質(zhì)量的貼近實(shí)際應(yīng)用的大量數(shù)據(jù)集,這時(shí)候一些公開(kāi)數(shù)據(jù)集往往就成了大家通往AI路上的反復(fù)摩擦的對(duì)象。

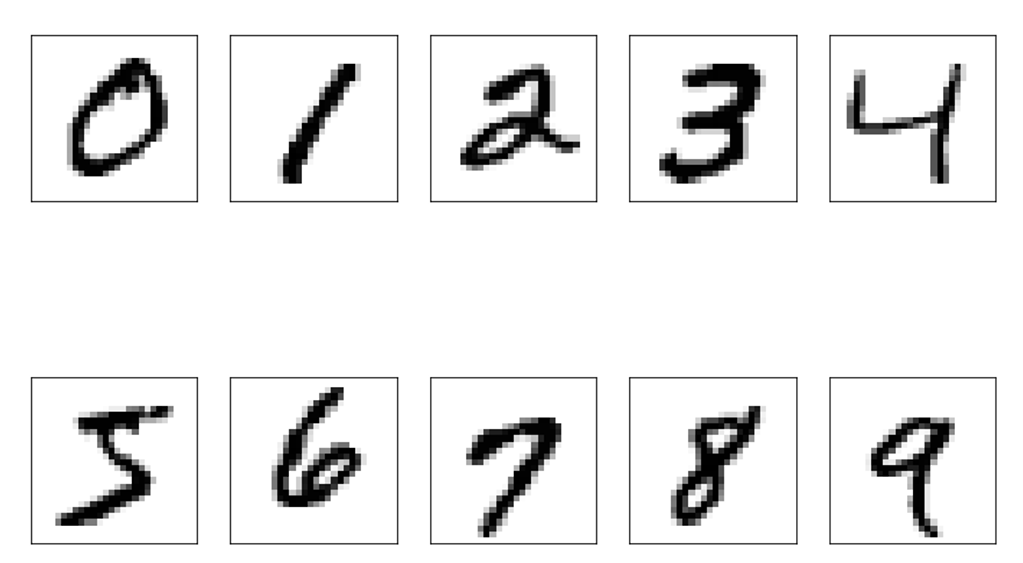

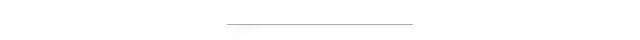

計(jì)算機(jī)視覺(jué)(CV)方向的經(jīng)典數(shù)據(jù)集包括MNIST手寫(xiě)數(shù)字?jǐn)?shù)據(jù)集、Fashion MNIST數(shù)據(jù)集、CIFAR-10和CIFAR-100數(shù)據(jù)集、ILSVRC競(jìng)賽的ImageNet數(shù)據(jù)集、用于檢測(cè)和分割的PASCAL VOC和COCO數(shù)據(jù)集等。而自然語(yǔ)言處理(NLP)方向的經(jīng)典數(shù)據(jù)集包括IMDB電影評(píng)論數(shù)據(jù)集、Wikitext維基百科數(shù)據(jù)集、Amazon reviews(亞馬遜評(píng)論)數(shù)據(jù)集和Sogou news(搜狗新聞)數(shù)據(jù)等。本講就分別對(duì)這些經(jīng)典數(shù)據(jù)集和使用進(jìn)行一個(gè)概述。MNIST(Mixed National Institute of Standards andTechnology database)數(shù)據(jù)集大家可以說(shuō)是耳熟能詳。可以說(shuō)是每個(gè)入門深度學(xué)習(xí)的人都會(huì)使用MNIST進(jìn)行實(shí)驗(yàn)。作為領(lǐng)域內(nèi)最早的一個(gè)大型數(shù)據(jù)集,MNIST于1998年由Yann LeCun等人設(shè)計(jì)構(gòu)建。MNIST數(shù)據(jù)集包括60000個(gè)示例的訓(xùn)練集以及10000個(gè)示例的測(cè)試集,每個(gè)手寫(xiě)數(shù)字的大小均為28*28。在本書(shū)的前面一些章節(jié),我們?cè)啻问褂玫搅薓NIST數(shù)據(jù)集。MNIST數(shù)據(jù)集官網(wǎng)地址為http://yann.lecun.com/exdb/mnist/。MNIST在TensorFlow中可以直接導(dǎo)入使用。在TensorFlow 2.0中使用示例如代碼1所示。from tensorflow.keras.datasets import mnist(x_train,y_train), (x_test, y_test) = mnist.load_data()print(x_train.shape,y_train.shape, x_test.shape, y_test.shape)

(60000, 28, 28) (60000,) (10000, 28, 28)(10000,)

可視化展示MNIST 0-9十個(gè)數(shù)字,如代碼2所示,繪制結(jié)果如圖1。# 導(dǎo)入相關(guān)模塊import matplotlib.pyplot as pltimport numpy as np# 指定繪圖尺寸plt.figure(figsize=(12,8))# 繪制10個(gè)數(shù)字fori in range(10): plt.subplot(2,5,i+1) plt.xticks([]) plt.yticks([]) img = x_train[y_train == i][0].reshape(28,28) plt.imshow(img, cmap=plt.cm.binary)

?? ? ? ? ? ? ? ? 圖1 MNIST數(shù)據(jù)示例可能是見(jiàn)MNIST太爛大街了,德國(guó)的一家名為Zalando的時(shí)尚科技公司提供了Fashion-MNIST來(lái)作為MNIST數(shù)據(jù)集的替代數(shù)據(jù)集。Fashion MNIST包含了10種類別70000個(gè)不同時(shí)尚穿戴品的圖像,整體數(shù)據(jù)結(jié)構(gòu)上跟MNIST完全一致。每張圖像的尺寸同樣是28*28。Fashion MNIST數(shù)據(jù)集地址為:https://research.zalando.com/welcome/mission/research-projects/fashion-mnist/。Fashion MNIST同樣也可以在TensorFlow中直接導(dǎo)入。如代碼3所示。from tensorflow.keras.datasets import fashion_mnist(x_train,y_train), (x_test, y_test) = fashion_mnist.load_data()print(x_train.shape,y_train.shape, x_test.shape, y_test.shape)

(60000, 28, 28) (60000,) (10000, 28, 28)(10000,)

可視化展示Fashion MNIST 10種類別,如代碼4所示。繪制結(jié)果如2所示。

# 繪圖尺寸plt.figure(figsize=(12,8))# 繪制10個(gè)示例fori in range(10): plt.subplot(2,5,i+1) plt.xticks([]) plt.yticks([]) plt.grid(False) img = x_train[y_train == i][0].reshape(28,28) plt.imshow(x_train[i], cmap=plt.cm.binary)

圖2 Fashion MNIST數(shù)據(jù)示例展示

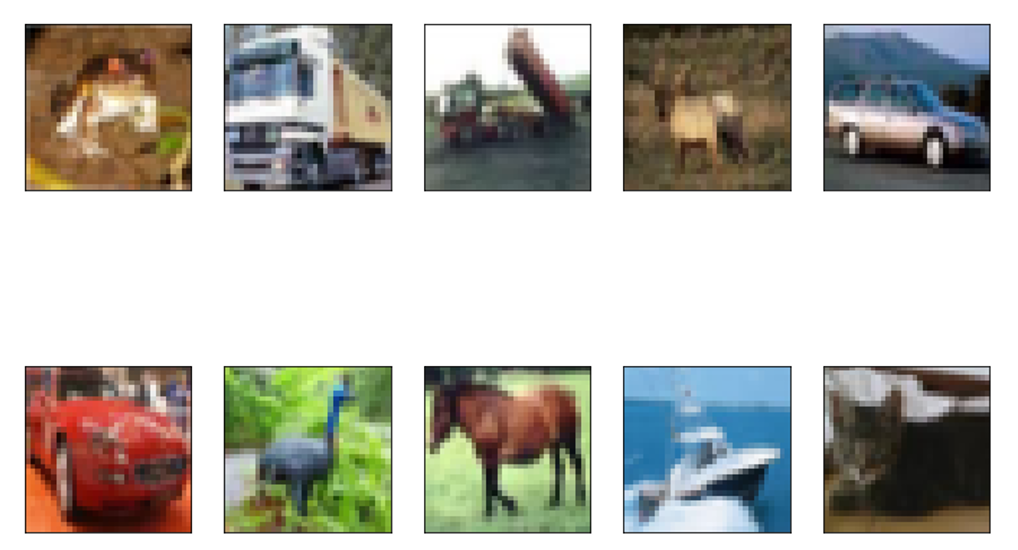

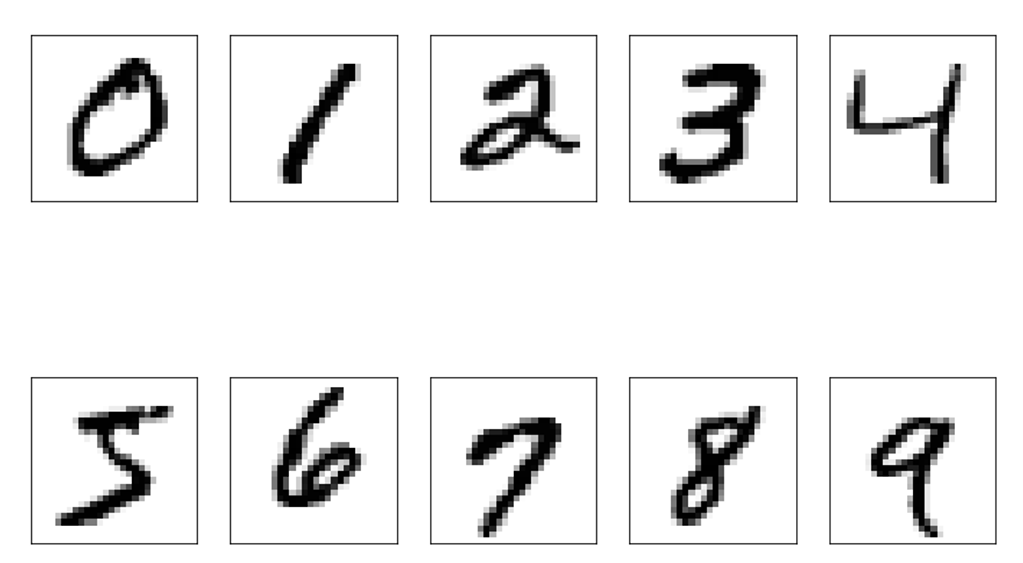

相較于MNIST和Fashion MNIST的灰度圖像,CIFAR-10數(shù)據(jù)集由10個(gè)類的60000個(gè)32*32彩色圖像組成,每個(gè)類有6000個(gè)圖像。有50000個(gè)訓(xùn)練圖像和10000個(gè)測(cè)試圖像。CIFAR-10是由Hinton的學(xué)生Alex Krizhevsky(AlexNet的作者)和Ilya Sutskever 整理的一個(gè)用于識(shí)別普適物體的彩色圖像數(shù)據(jù)集。一共包含10個(gè)類別的RGB彩色圖片:飛機(jī)(airplane)、汽車(automobile)、鳥(niǎo)類(bird)、貓(cat)、鹿(deer)、狗(dog)、蛙類(frog)、馬(horse)、船(ship)和卡車(truck)。CIFAR-10的官方地址為https://www.cs.toronto.edu/~kriz/cifar.html。CIFAR-10在TensorFlow中導(dǎo)入方式如代碼5所示。from tensorflow.keras.datasets import cifar10(x_train,y_train), (x_test, y_test) = cifar10.load_data()print(x_train.shape,y_train.shape, x_test.shape, y_test.shape)?

(50000,32, 32, 3) (50000, 1) (10000, 32, 32, 3) (10000, 1)

CIFAR-10的可視化展示如代碼6所示。圖像示例如圖3所示。

plt.figure(figsize=(12,8))fori in range(10): plt.subplot(2,5,i+1) plt.xticks([]) plt.yticks([]) plt.grid(False) plt.imshow(x_train[i], cmap=plt.cm.binary)

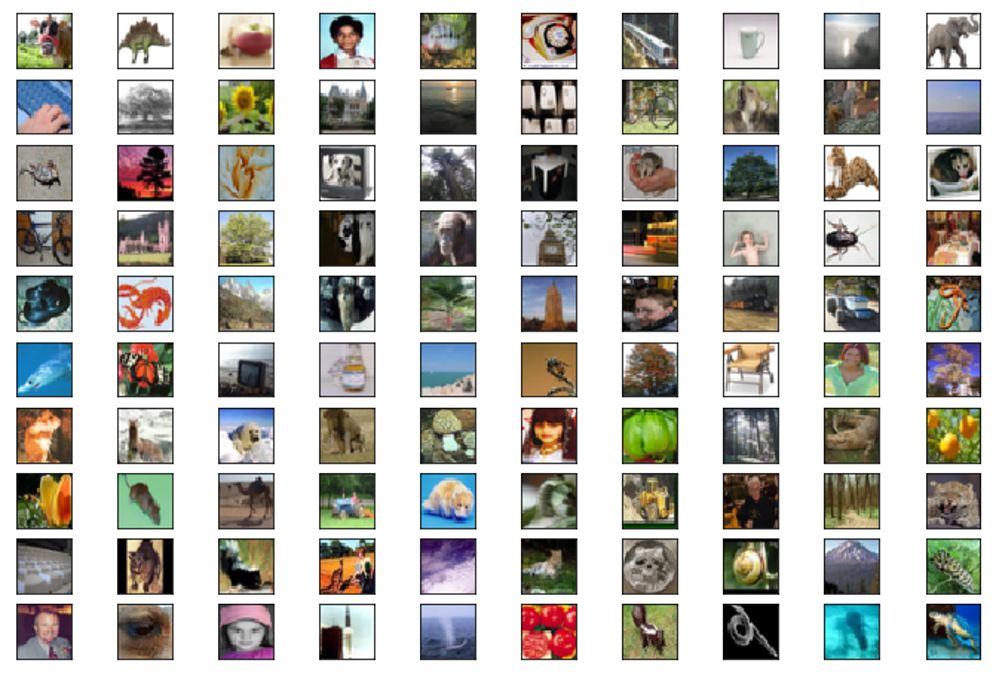

CIFAR-100可以看作是CIFAR-10的擴(kuò)大版,CIFAR-100將類別擴(kuò)大到100個(gè)類,每個(gè)類包含了600張圖像,分別有500張訓(xùn)練圖像和100張測(cè)試圖像。CIFAR-100的100個(gè)類被分為20個(gè)大類,每個(gè)大類又有一定數(shù)量的小類,大類和大類之間區(qū)分度較高,但小類之間有些圖像具有較高的相似度,這對(duì)于分類模型來(lái)說(shuō)會(huì)更具挑戰(zhàn)性。CIFAR-100數(shù)據(jù)集地址為https://www.cs.toronto.edu/~kriz/cifar.html。CIFAR-10在TensorFlow中導(dǎo)入方式如代碼7所示。from tensorflow.keras.datasets import cifar100(x_train,y_train), (x_test, y_test) = cifar100.load_data()print(x_train.shape,y_train.shape, x_test.shape, y_test.shape)

(50000,32, 32, 3) (50000, 1) (10000, 32, 32, 3) (10000, 1)

CIFAR-100的可視化展示如代碼8所示,示例結(jié)果如圖4所示。

plt.figure(figsize=(12,8))fori in range(100): plt.subplot(10,10,i+1) plt.xticks([]) plt.yticks([]) plt.grid(False) plt.imshow(x_train[i], cmap=plt.cm.binary)

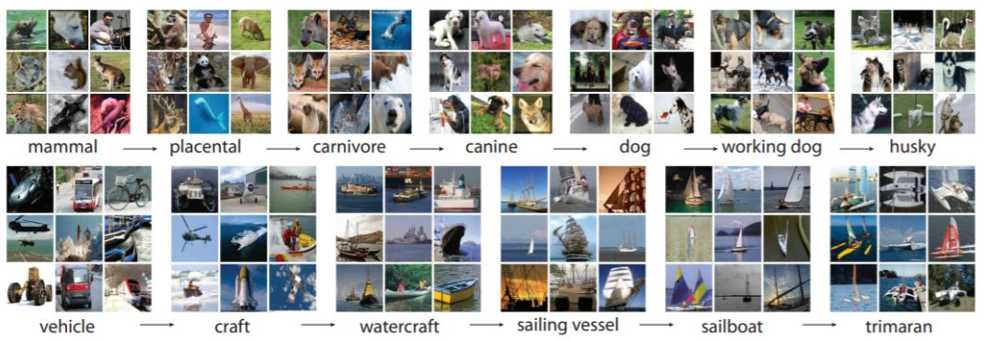

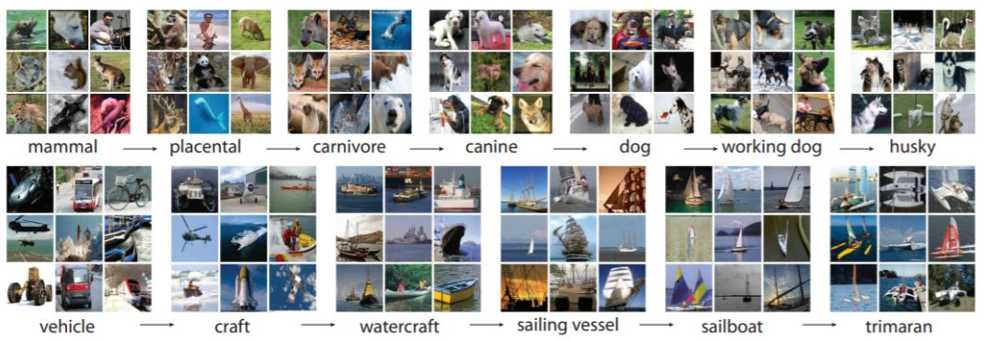

ImageNet圖像數(shù)據(jù)集是在2009年由斯坦福的李飛飛主導(dǎo)的一個(gè)項(xiàng)目形成的一個(gè)數(shù)據(jù)集。李飛飛在CVPR2009上發(fā)表了一篇名為《ImageNet: A Large-Scale Hierarchical Image Database》的論文,之后從2010年開(kāi)始基于ImageNet數(shù)據(jù)集的7屆ILSVRC大賽,這使得ImageNet極大的推動(dòng)了深度學(xué)習(xí)和計(jì)算機(jī)視覺(jué)的發(fā)展。ILSVRC大賽歷屆經(jīng)典網(wǎng)絡(luò)如表1所示。 | | | |

| | | ImageNet Classification with Deep Convolutional Neural Networks |

| | | Visualizing and understanding convolutional networks |

| | | Going Deeper with Convolutions |

| | | Very deep convolutional networks for large-scale image recognition |

| | | Deep Residual Learning for Image Recognition |

| | | Aggregated Residual Transformations for Deep Neural Networks |

| | | Squeeze-and-Excitation Networks |

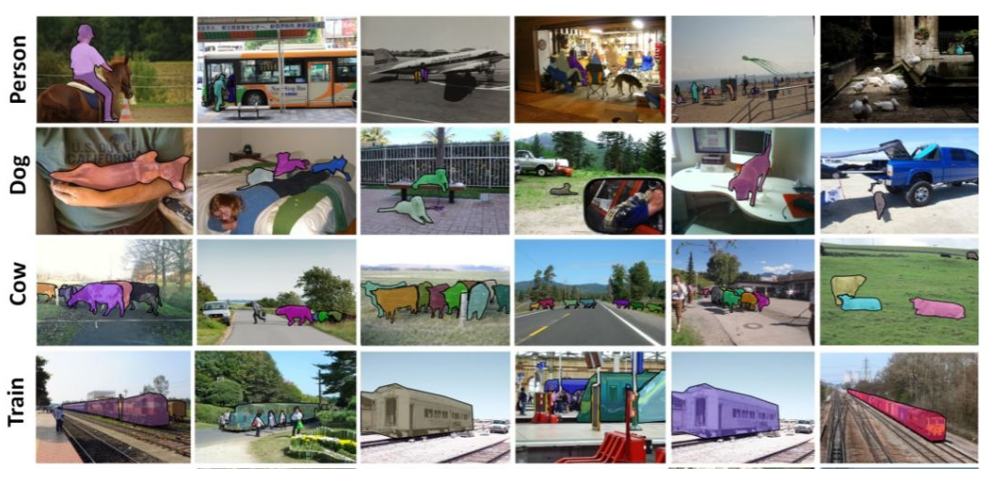

目前ImageNet中總共有14197122張圖像,分為21841個(gè)類別,數(shù)據(jù)官網(wǎng)地址為:http://www.image-net.org/ImageNet數(shù)據(jù)集示例如圖5所示。

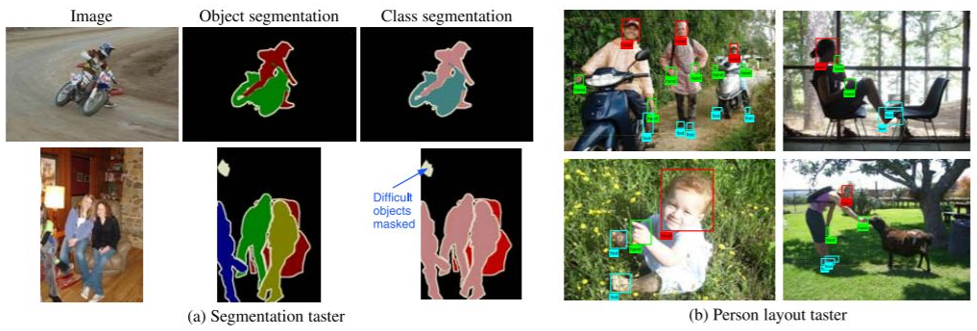

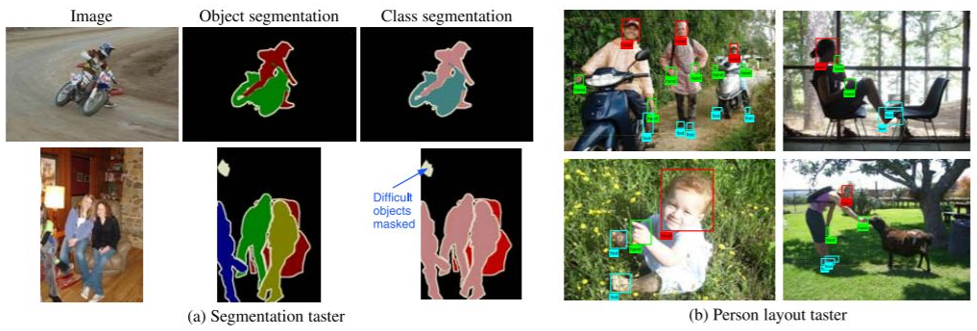

PASCAL VOC挑戰(zhàn)賽(The PASCAL Visual Object Classes)是一個(gè)世界級(jí)的計(jì)算機(jī)視覺(jué)挑戰(zhàn)賽, 其全稱為Pattern Analysis, Statical Modeling andComputational Learning,從2005年開(kāi)始到2012年結(jié)束,PASCAL VOC最初主要用于目標(biāo)檢測(cè),很多經(jīng)典的目標(biāo)檢測(cè)網(wǎng)絡(luò)都是在PASCAL VOC上訓(xùn)練出來(lái)的,例如,F(xiàn)ast R-CNN系列的各種網(wǎng)絡(luò)。后來(lái)逐漸增加了分類、分割、動(dòng)作識(shí)別和人體布局等五類比賽。目前PASCAL VOC主要分為VOC2007和VOC2012兩個(gè)版本的數(shù)據(jù)集。PASCAL VOC數(shù)據(jù)示例如圖6所示。

圖6 PASCAL VOC數(shù)據(jù)示例

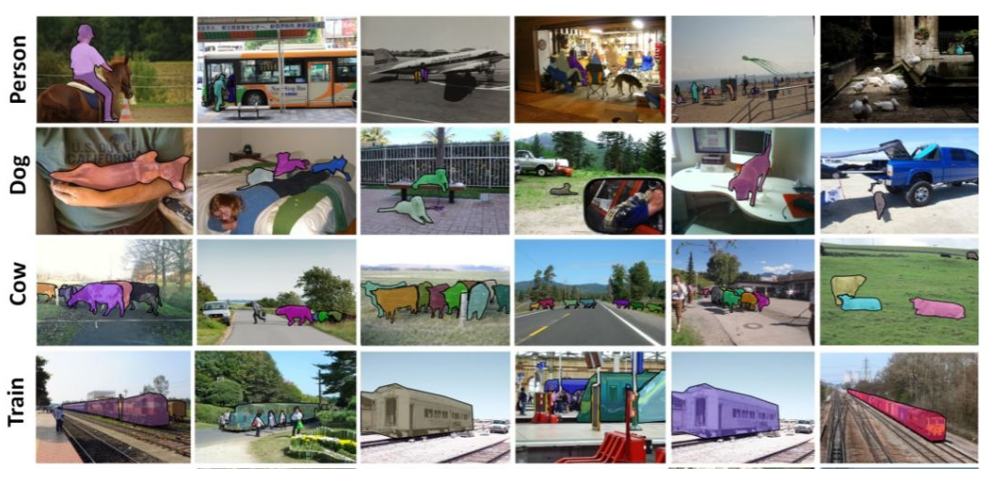

COCO數(shù)據(jù)集是微軟在ImageNet和PASCAL VOC數(shù)據(jù)集標(biāo)注上的基礎(chǔ)上產(chǎn)生的,主要是用于圖像分類、檢測(cè)和分割等任務(wù)。COCO全稱為Common Objects in Context,2014年微軟在ECCV Workshops里發(fā)表了Microsoft COCO: Common Objects in Context。文章中說(shuō)明了COCO數(shù)據(jù)集以場(chǎng)景理解為目標(biāo),主要從復(fù)雜的日常場(chǎng)景中截取,圖像中的目標(biāo)通過(guò)精確的分割進(jìn)行位置的標(biāo)定。COCO包括91個(gè)類別目標(biāo),其中有82個(gè)類別的數(shù)據(jù)量都超過(guò)了5000張。COCO數(shù)據(jù)集主頁(yè)地址為http://cocodataset.org/#home。

除了以上這些公開(kāi)的經(jīng)典數(shù)據(jù)集以外,我們也可以通過(guò)數(shù)據(jù)采集和圖像標(biāo)注工具制作數(shù)據(jù)集。常用的圖像標(biāo)注工具包括Labelme、LabelImg、Vatic、Sloth、ImageJ、CVAT、Yolo_mark、RectLabel和Labelbox等。圖8所示是Labelme圖像標(biāo)注示例。

IMDB本身是一家在線收集各種電影信息的網(wǎng)站,跟國(guó)內(nèi)的豆瓣較為類似,用戶可以在上面發(fā)表對(duì)電影的影評(píng)。IMDB數(shù)據(jù)集是斯坦福整理的一套用于情感分析的IMDB電影評(píng)論二分類數(shù)據(jù)集,包含了25000個(gè)訓(xùn)練樣本和25000個(gè)測(cè)試樣本,所有影評(píng)被標(biāo)記為正面和負(fù)面兩種評(píng)價(jià)。IMDB數(shù)據(jù)集的一個(gè)示例如圖9所示。

IMDB數(shù)據(jù)集在TensorFlow中讀取方法跟MNIST等數(shù)據(jù)集較為類似,如代碼9所示。from tensorflow.keras.datasets import imdb(x_train,y_train), (x_test, y_test) = imdb.load_data()print(x_train.shape,y_train.shape, x_test.shape, y_test.shape)

Downloadingdata fromhttps:17465344/17464789[==============================] - 2s 0us/step(25000,)(25000,) (25000,) (25000,)

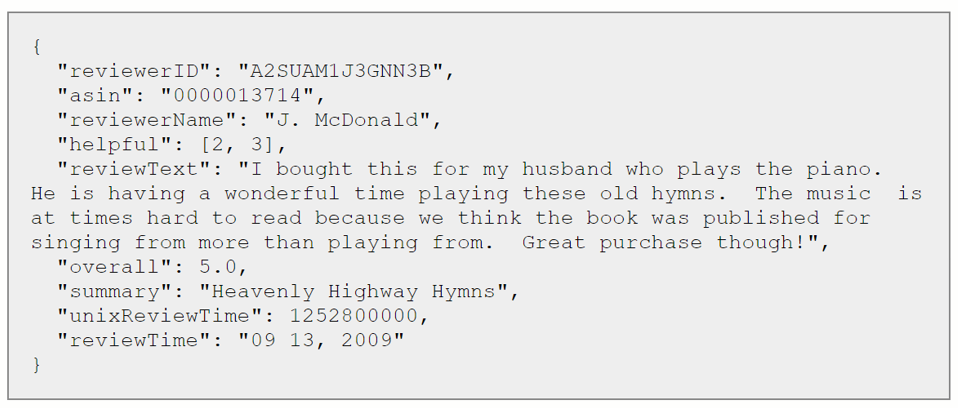

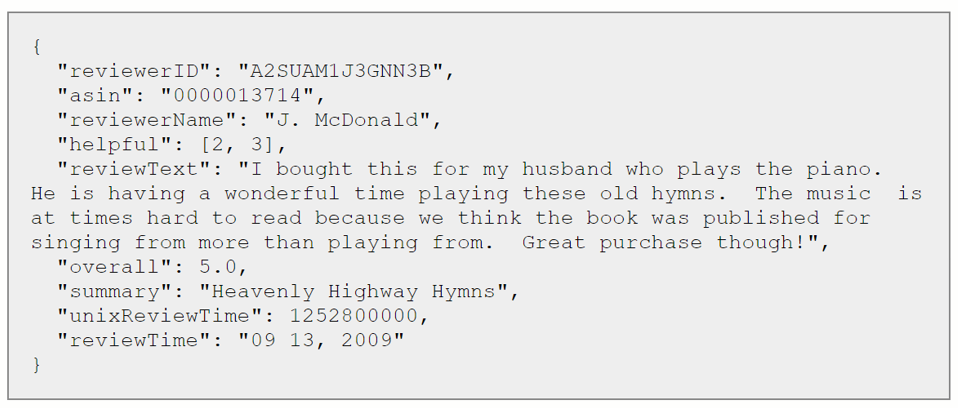

IMDB數(shù)據(jù)集地址為https://www.imdb.com/interfaces/。WikiText 英語(yǔ)詞庫(kù)數(shù)據(jù)(The WikiText Long Term Dependency Language ModelingDataset)是由Salesforce MetaMind 策劃的包含1億個(gè)詞匯的大型語(yǔ)言建模語(yǔ)料庫(kù)。這些詞匯都是從維基百科一些經(jīng)典文章中提取得到,包括WikiText-103和WikiText-2兩個(gè)版本,其中WikiText-2是WikiText-103的一個(gè)子集,常用于測(cè)試小型數(shù)據(jù)集的語(yǔ)言模型訓(xùn)練效果。值得一提的是,WikiText保持了產(chǎn)生每個(gè)詞匯的原始文章,非常適用于長(zhǎng)時(shí)依賴的大文本建模問(wèn)題。WikiText數(shù)據(jù)集地址為https://metamind.io/research/the-wikitext-long-term-dependency-language-modeling-dataset。Amazon Reviews數(shù)據(jù)集是2013年由康奈爾大學(xué)[1]發(fā)布的、從斯坦福網(wǎng)絡(luò)分析項(xiàng)目(SNAP)中構(gòu)建的Amazon評(píng)論數(shù)據(jù)集,分為Full和Polarity兩個(gè)版本。Full版本每個(gè)類別包含600000個(gè)訓(xùn)練樣本和130000個(gè)測(cè)試樣本,Polarity版本每個(gè)類別則包含1800000個(gè)訓(xùn)練樣本和200000個(gè)測(cè)試樣本。評(píng)論的商品包括書(shū)籍、電子產(chǎn)品、電影、日常家用產(chǎn)品、衣服、手機(jī)、玩具等各類常用物品。Amazon Reviews數(shù)據(jù)集地址為http://jmcauley.ucsd.edu/data/amazon/。Amazon Reviews數(shù)據(jù)集的一個(gè)樣本示例如圖10所示。

圖10 Amazon Reviews數(shù)據(jù)示例

Sogou news 數(shù)據(jù)集是來(lái)自SogouCA和SogouCS新聞?wù)Z料庫(kù)總共包含運(yùn)動(dòng)、金融、娛樂(lè)、汽車和技術(shù)5個(gè)類別2909551篇新聞文章構(gòu)成的數(shù)據(jù)集。每個(gè)類別分別包含90000個(gè)訓(xùn)練樣本和12000個(gè)測(cè)試樣本。Sogou news 數(shù)據(jù)集地址為:http://academictorrents.com/details/b2b847b5e1946b0479baa838a0b0547178e5ebe8。NLP領(lǐng)域還有一些像Ag News、Yelp等經(jīng)典數(shù)據(jù)集,這里限于篇幅就不再進(jìn)行更多的介紹,感興趣的讀者可以自行查閱。下載1:OpenCV-Contrib擴(kuò)展模塊中文版教程

在「小白學(xué)視覺(jué)」公眾號(hào)后臺(tái)回復(fù):擴(kuò)展模塊中文教程,即可下載全網(wǎng)第一份OpenCV擴(kuò)展模塊教程中文版,涵蓋擴(kuò)展模塊安裝、SFM算法、立體視覺(jué)、目標(biāo)跟蹤、生物視覺(jué)、超分辨率處理等二十多章內(nèi)容。下載2:Python視覺(jué)實(shí)戰(zhàn)項(xiàng)目52講在「小白學(xué)視覺(jué)」公眾號(hào)后臺(tái)回復(fù):Python視覺(jué)實(shí)戰(zhàn)項(xiàng)目,即可下載包括圖像分割、口罩檢測(cè)、車道線檢測(cè)、車輛計(jì)數(shù)、添加眼線、車牌識(shí)別、字符識(shí)別、情緒檢測(cè)、文本內(nèi)容提取、面部識(shí)別等31個(gè)視覺(jué)實(shí)戰(zhàn)項(xiàng)目,助力快速學(xué)校計(jì)算機(jī)視覺(jué)。下載3:OpenCV實(shí)戰(zhàn)項(xiàng)目20講在「小白學(xué)視覺(jué)」公眾號(hào)后臺(tái)回復(fù):OpenCV實(shí)戰(zhàn)項(xiàng)目20講,即可下載含有20個(gè)基于OpenCV實(shí)現(xiàn)20個(gè)實(shí)戰(zhàn)項(xiàng)目,實(shí)現(xiàn)OpenCV學(xué)習(xí)進(jìn)階。交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺(jué)、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺(jué)SLAM“。請(qǐng)按照格式備注,否則不予通過(guò)。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~