100%抄襲!ICLR 2022投稿竟公然剽竊兩篇頂會!

轉(zhuǎn)自:新智元

朋友們,又到了一月好幾度的「學(xué)術(shù)不端」曝光時間了。

?

之前什么「借鑒」idea,「英譯中」都弱爆了,甚至直接照搬都沒有這次的「別出心裁」,至少人家還是「忠實原著」的。

?

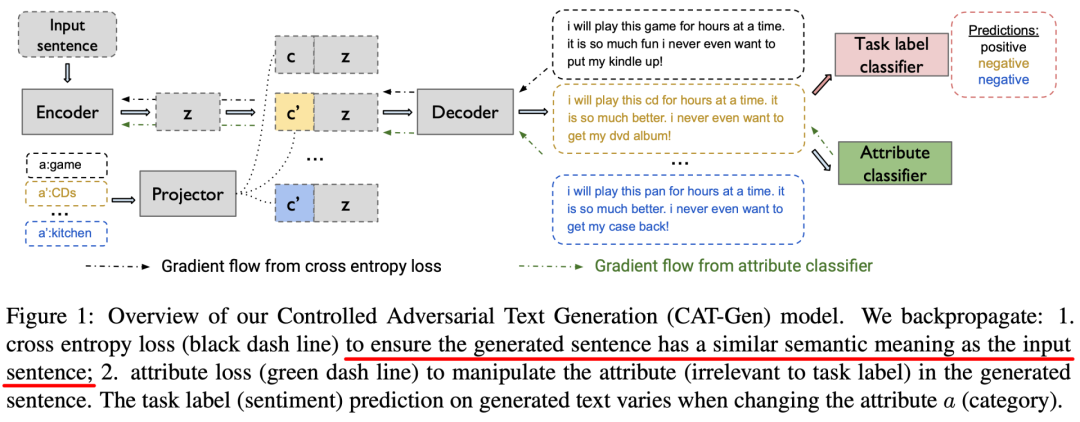

隨便舉一個例子,比如下面這個是原論文的圖。

?

Wang et al. EMNLP 2020

?

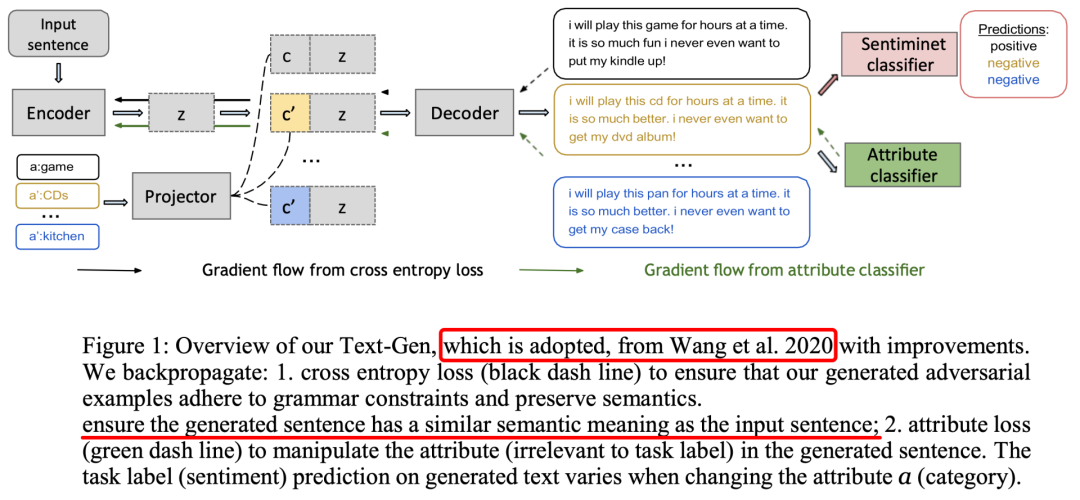

再來看看這篇論文的圖。

?

ICLR 2022投稿

?

請看兩處紅色橫線部分,莫非這就是傳說中的「抄串行」了?

?

但通篇讀下來,其實嚴(yán)格來說并不是100%相似,而是99%。因為還有1%是抄或者改錯的部分(doge)。

這么明目張膽地搞事情難道沒人管管么?

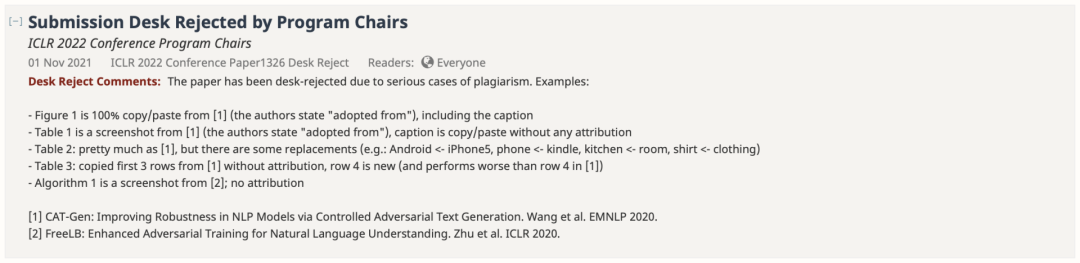

果不其然,11月1日,一封來自ICLR 2022程序主席的Desk Reject直接懟臉了。

?

?

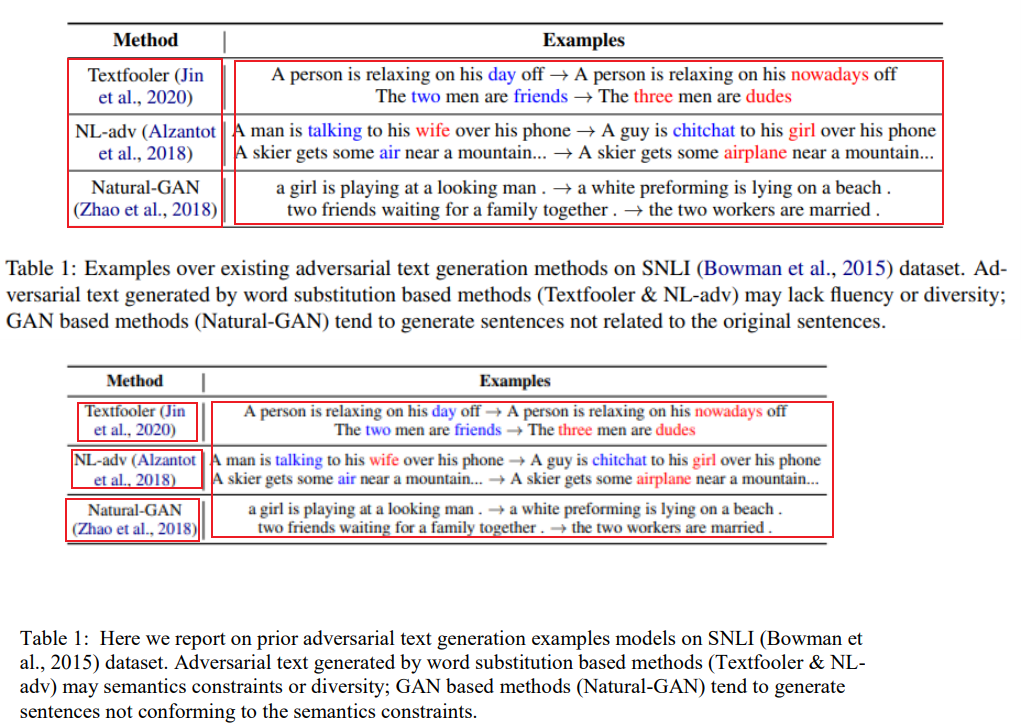

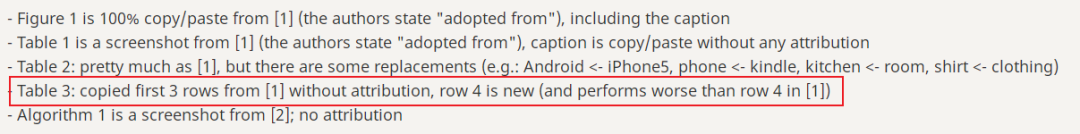

圖1是100%復(fù)制/粘貼自[1](作者注明 「采用自」),包括圖注

表1是來自[1]的截圖(作者注明「采用自」),標(biāo)題是復(fù)制/粘貼的,沒有任何署名

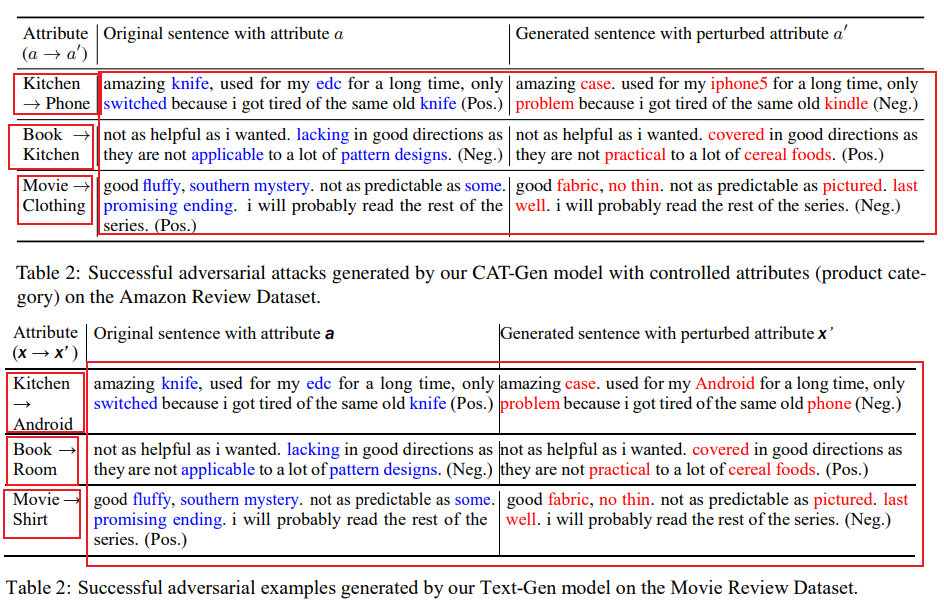

表2:和[1]差不多,但有一些替換(例如。Android <- Phone, kitchen <- room, shirt <- clothing)

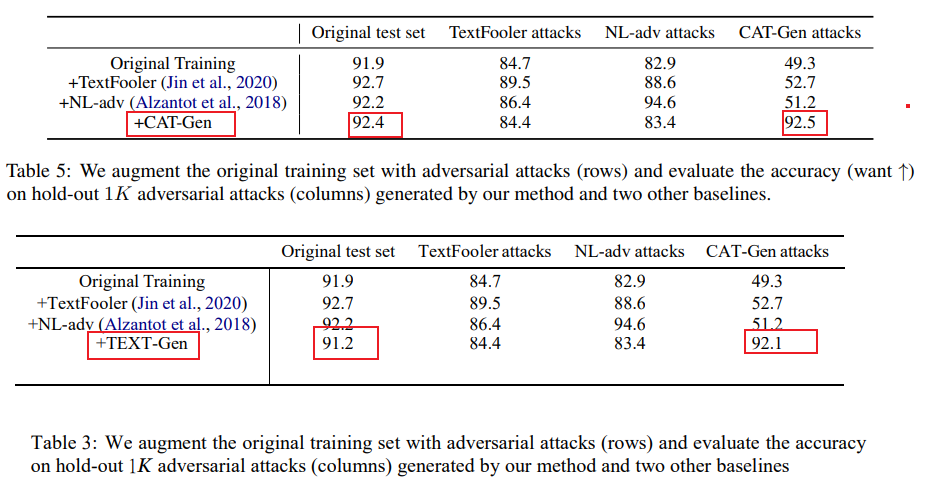

表3:復(fù)制了[1]中的前3行,沒有注明出處,第4行是新的(比[1]中的第4行表現(xiàn)更差)

算法1是來自[2]的截圖;未注明出處

?

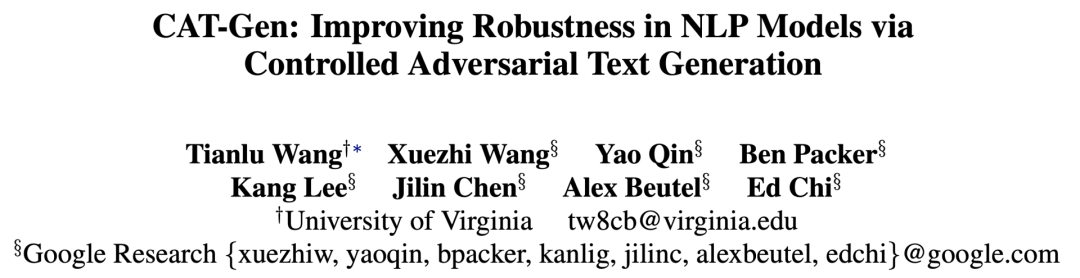

被抄襲的兩篇論文為:

?

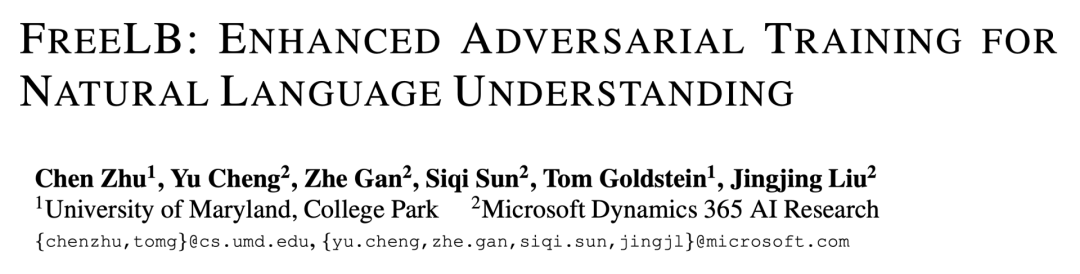

[1] CAT-Gen: Improving Robustness in NLP Models via Controlled Adversarial Text Generation. Wang et al. EMNLP 2020

?

https://arxiv.org/pdf/2010.02338.pdf

?

[2] FreeLB: Enhanced Adversarial Training for Natural Language Understanding. Zhu et al. ICLR 2020

?

https://arxiv.org/pdf/1909.11764.pdf

https://arxiv.org/pdf/1909.11764.pdf

?

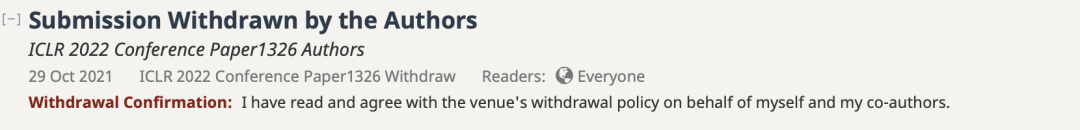

其實,作者團(tuán)隊在10月29日就確認(rèn)撤稿了。

?

但是對于學(xué)術(shù)不端的行為,怎么能放過這個「公開處刑」的機(jī)會呢!

?

?

連換詞都懶得換的「抄襲」

連換詞都懶得換的「抄襲」

?

?

https://openreview.net/pdf?id=EO4VJGAllb

https://openreview.net/pdf?id=EO4VJGAllb

?

摘要

?

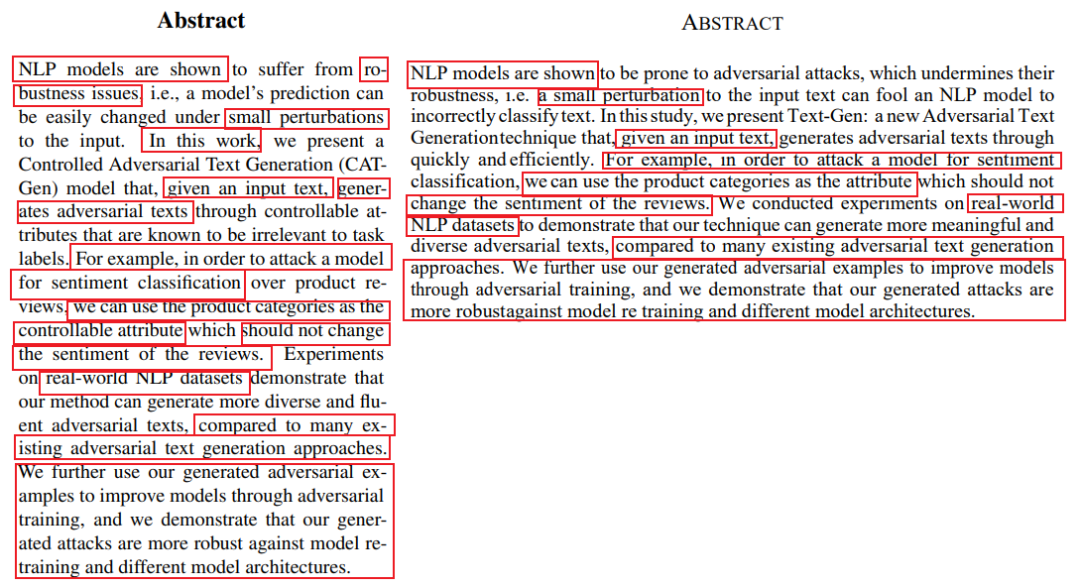

讀論文嘛,首先要看看摘要部分。?

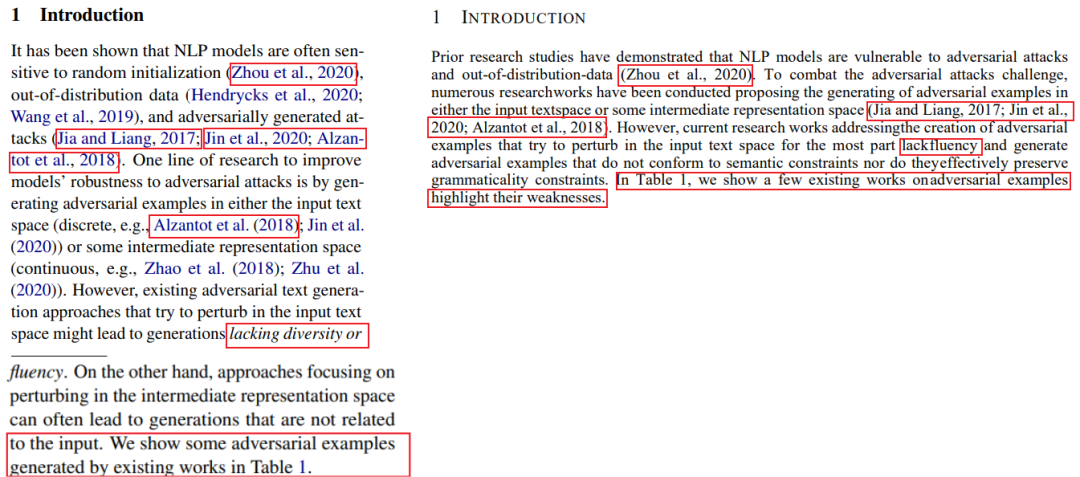

左:CAT-Gen原文;右:Text-Gen論文

用紅色圈出相似的地方之后,嚯,有點厲害啊。

這篇論文向我們展示了經(jīng)典的單詞替換 +「把」字句變「被」字句。顯然,意思絲毫不變。

?

甚至,摘要的前半部分還算是稍微動手改了改,后半部分直接把原文拿過來貼上。真的,是一個單詞都沒有改。(但復(fù)制的時候還挺不小心的,漏了空格和橫短線)

?

引言

?

引言部分居然還有點「良心發(fā)現(xiàn)」,挪用了些關(guān)鍵詞,句子嘛,倒是好好重寫了一番。

?

左:CAT-Gen原文;右:Text-Gen論文

?

就是這個引用的文章,是不是重合的太多了?

?

論文正文

?

這上來就已經(jīng)「徹底放棄抵抗」了,大段大段直接往上糊。

?

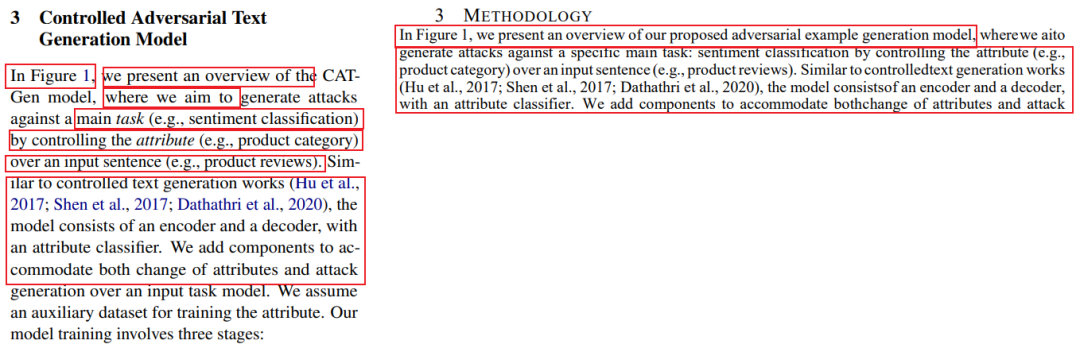

左:CAT-Gen原文;右:Text-Gen論文

?

你說一個字不改也就罷了,抄還抄不全乎。

?

單詞拼不對,單詞之間少空格,強(qiáng)迫癥看了真心頭疼,抄襲也得有點「責(zé)任心」嘛。

?

這兩篇文章都提到了一個「三階段」架構(gòu),那就都拿出來看看。

?

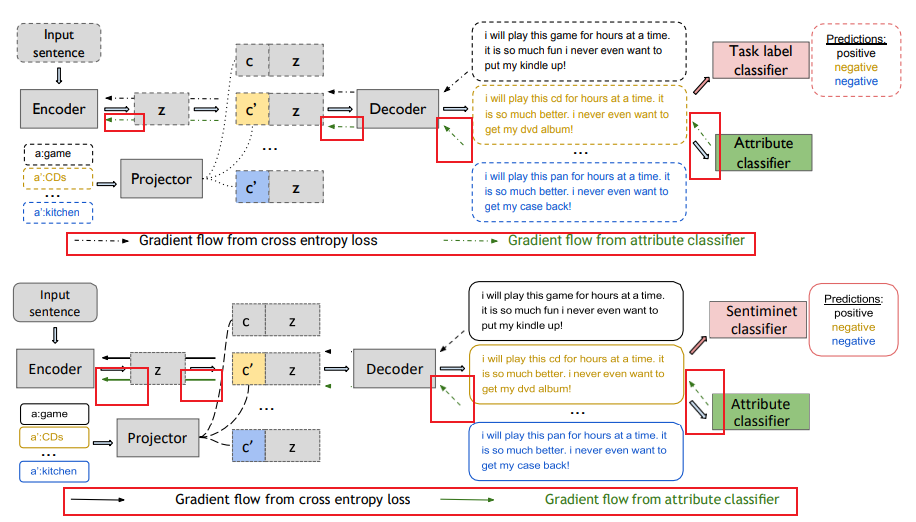

上:CAT-Gen原文;下:Text-Gen論文

?

Text-Gen這篇論文的圖直接是從CAT-Gen原文復(fù)制過來的,就把箭頭的示意圖從虛線改成實線。

?

但是,雖然示意圖是變了,圖中的箭頭只有一半改成了實線,另一半還是虛線。

?

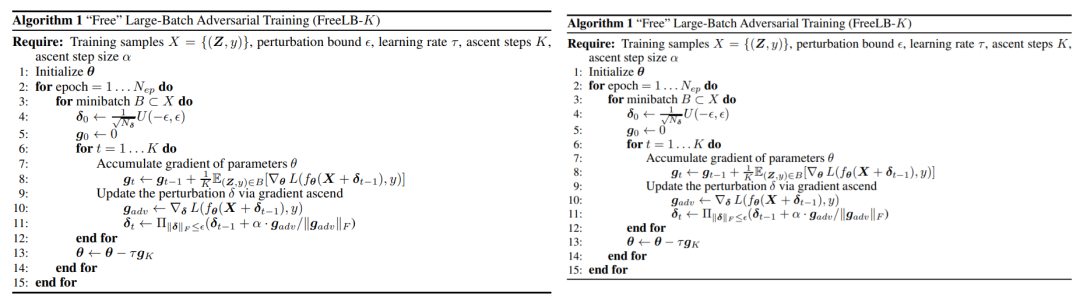

Text-Gen文中的算法,乍一看和CAT-Gen原文不一樣,原來是從另一篇文章FreeLB里面直接貼過來的。

?

左:FreeLB原文;右:Text-Gen論文

?

右邊看上去沒有左邊清晰,那是因為Text-Gen論文這個算法部分并不是手敲進(jìn)去的,而是直接從FreeLB原文截的圖。

?

實驗結(jié)果

實驗結(jié)果自然也是完全一樣。

?

展示前人的工作效果時也是直接截圖。

?

上:CAT-Gen原文;下:Text-Gen論文

?

輪到自己的工作時,Text-Gen的實驗結(jié)果表格幾乎和CAT-Gen原文一樣,就只進(jìn)行了一些單詞字面的替代。(表格畫得也是潦草得很)

?

上:CAT-Gen原文;下:Text-Gen論文

?

這最后的定量實驗數(shù)據(jù)就更搞笑了。

?

上:CAT-Gen原文;下:Text-Gen論文

?

文章都已經(jīng)是抄襲了,還要堅守最后一點「倔強(qiáng)」,非要用Text-Gen自己的數(shù)據(jù)作為試驗結(jié)果。Text-Gen的性能數(shù)據(jù)漂亮也就罷了,結(jié)果還不如人家原文的CAT-Gen的數(shù)據(jù)。

?

連評委都在吐槽。(編都不知道編個好點的)

?

?

網(wǎng)友評論

網(wǎng)友評論

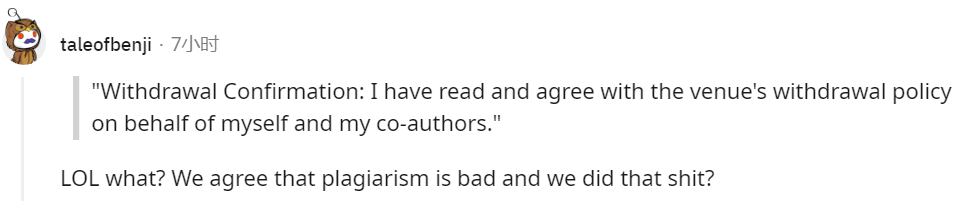

抄襲事件一出,Reddit已經(jīng)有了好多人的評論。有的網(wǎng)友覺得這個造假者的「撤稿」行為太「冠冕堂皇」。

?

「難道他們內(nèi)心認(rèn)可抄襲這件事是錯的,然后還是去抄襲了嗎?」

?

?

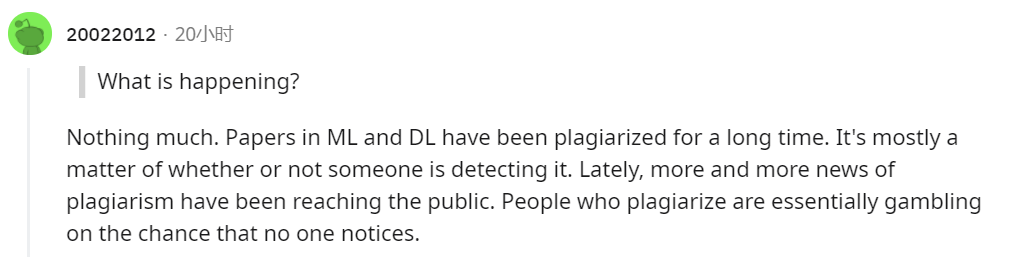

有的網(wǎng)友感覺這種抄襲已經(jīng)沒什么好大驚小怪的了。

?

「機(jī)器學(xué)習(xí)和深度學(xué)習(xí)的論文經(jīng)常會出現(xiàn)抄襲的情況。這種事就看有沒有人去查。抄襲的人本質(zhì)上就是在賭沒有人會注意到他的抄襲。」

?

?

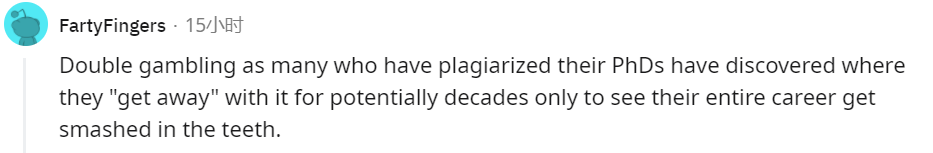

另一個網(wǎng)友也非常同意「抄襲的人本質(zhì)上就是在賭沒有人會注意到他的抄襲」這個觀點。

?

「許多剽竊博士學(xué)位的人發(fā)現(xiàn)他們看似是『逃脫』了辛苦,但他們的整個職業(yè)生涯都被毀掉了。」

?

?

最近的學(xué)術(shù)不端行為頻頻發(fā)生,這也是給學(xué)術(shù)研究者時時刻刻的提醒,科研工作者心中一定要牢記求真,求實,對學(xué)術(shù)誠信要有敬畏之心,絕不能踏過紅線,不要有僥幸心理,否則就是自毀前程。每位科研工作者在做好自己的工作時,要懂得尊重他人的學(xué)術(shù)成果。

參考資料:

https://www.reddit.com/r/MachineLearning/comments/qkb6ga/plagiarism_case_detected_iclr_2022_newsdiscussion/?

涉事論文:https://openreview.net/pdf?id=EO4VJGAllb

論文[1]:https://arxiv.org/pdf/2010.02338.pdf

論文[2]:https://arxiv.org/pdf/1909.11764.pdf

往期精彩: