基于OpenCV的行人目標(biāo)檢測(cè)

點(diǎn)擊上方“小白學(xué)視覺(jué)”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

推薦閱讀

轉(zhuǎn)自|深度學(xué)習(xí)與計(jì)算機(jī)視覺(jué)

介紹

什么是目標(biāo)檢測(cè)

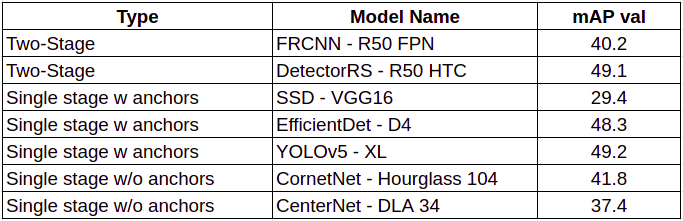

目標(biāo)檢測(cè)方法

-

級(jí)聯(lián)檢測(cè)器:該模型有兩種網(wǎng)絡(luò)類型,一種是RPN網(wǎng)絡(luò),另一種是檢測(cè)網(wǎng)絡(luò)。一些典型的例子是RCNN系列。 -

帶錨框的單級(jí)檢測(cè)器:這類的檢測(cè)器沒(méi)有單獨(dú)的RPN網(wǎng)絡(luò),而是依賴于預(yù)定義的錨框。YOLO系列就是這種檢測(cè)器。 -

無(wú)錨框的單級(jí)檢測(cè)器:這是一種解決目標(biāo)檢測(cè)問(wèn)題的新方法,這種網(wǎng)絡(luò)是端到端可微的,不依賴于感興趣區(qū)域(ROI),塑造了新研究的思路。要了解更多,可以閱讀CornerNet或CenterNet論文。

什么是COCO數(shù)據(jù)集

如何評(píng)估性能

-

PASCAL VOC挑戰(zhàn)(Everingham等人。2010年) -

COCO目標(biāo)檢測(cè)挑戰(zhàn)(Lin等人。2014年) -

開(kāi)放圖像挑戰(zhàn)賽(Kuznetsova 2018)。

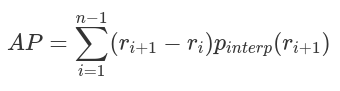

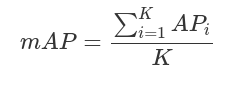

平均精度

mAP

TIDE

實(shí)際問(wèn)題陳述

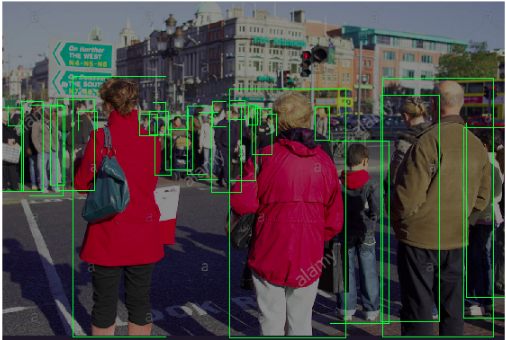

挑戰(zhàn)

-

視角:CCTV是頂裝式的,與普通照片的前視圖不同,它有一個(gè)角度 -

人群:商店/商店有時(shí)會(huì)有非常擁擠的場(chǎng)景 -

背景雜亂:零售店有更多的分散注意力或雜亂的東西(對(duì)于我們的模特來(lái)說(shuō)),比如衣服、架子、人體模型等等,這些都會(huì)導(dǎo)致誤報(bào)。 -

照明條件:店內(nèi)照明條件與室外攝影不同 -

圖像質(zhì)量:來(lái)自CCTVs的視頻幀有時(shí)會(huì)非常差,并且可能會(huì)出現(xiàn)運(yùn)動(dòng)模糊

測(cè)試集創(chuàng)建

第一個(gè)人體檢測(cè)模型

YOLOv5

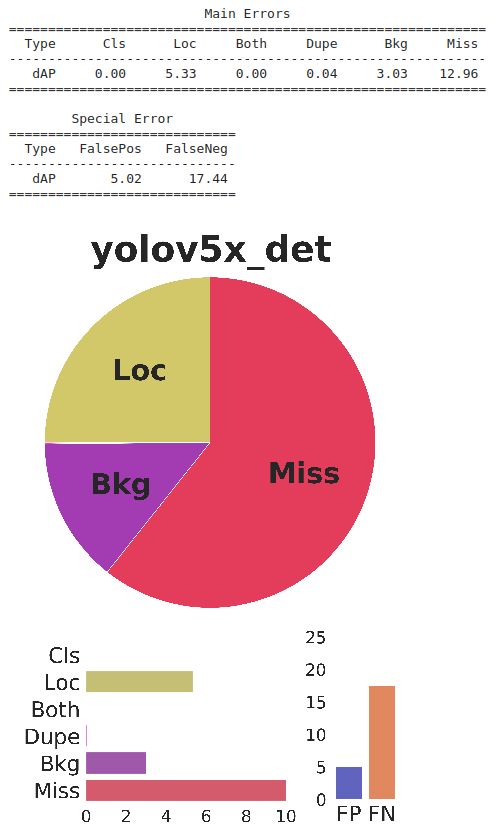

性能

分析

結(jié)論

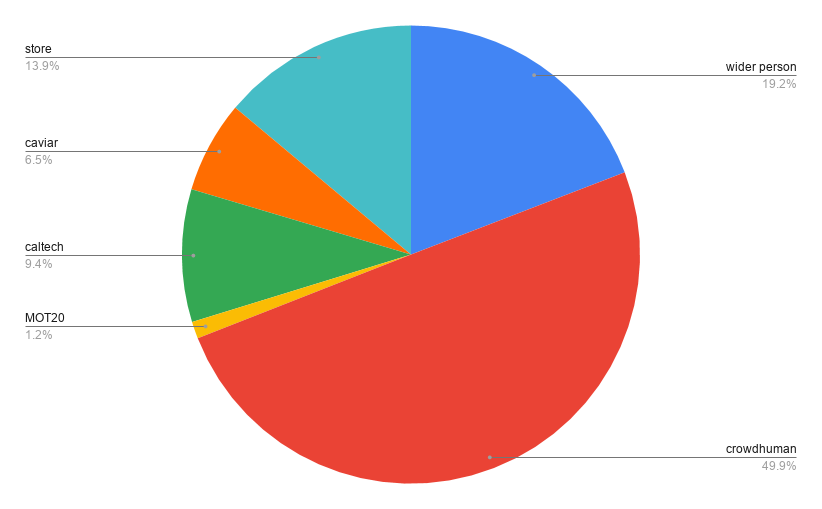

收集公共數(shù)據(jù)

第二個(gè)人體檢測(cè)模型

訓(xùn)練迭代2:

-

主干網(wǎng)絡(luò):YOLOv5x -

模型初始化:COCO預(yù)訓(xùn)練的權(quán)重 -

epoch:10個(gè)epoch

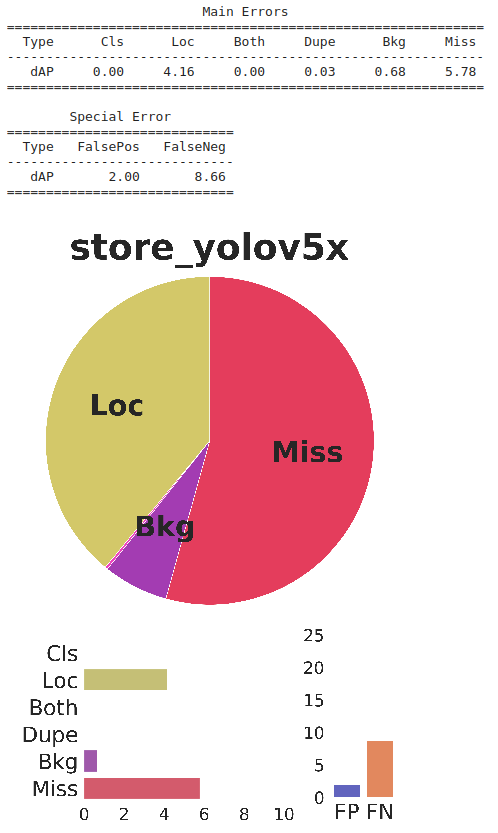

性能

分析

結(jié)論

清理數(shù)據(jù)

-

錯(cuò)誤標(biāo)記的邊界框 -

包含非常小的邊界框或太多人群的圖像 -

重復(fù)幀的附近

第三個(gè)人體檢測(cè)模型

-

主干網(wǎng)絡(luò):YOLOv5x -

模型初始化:COCO預(yù)訓(xùn)練的權(quán)重 -

epoch:~100個(gè)epoch

性能

分析

結(jié)論

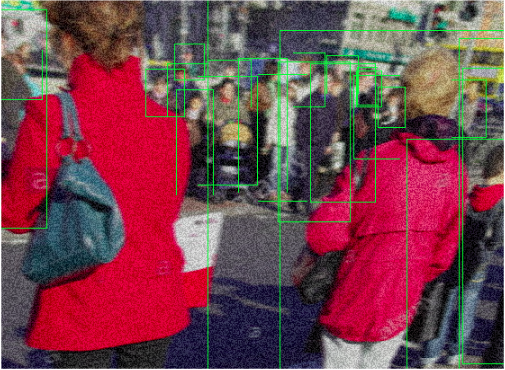

數(shù)據(jù)增強(qiáng)

-

視角 -

視角改變

-

照明條件 -

亮度 -

對(duì)比度

-

圖像質(zhì)量 -

噪音 -

圖像壓縮 -

運(yùn)動(dòng)模糊

第四個(gè)人體檢測(cè)模型

性能

分析

結(jié)論

創(chuàng)建自定義批注

最終人體檢測(cè)模型

性能

分析

結(jié)論

總結(jié)

結(jié)論

參考文獻(xiàn)

-

YOLO v5 by ultralytics, https://github.com/ultralytics/yolov5 -

Cross Stage Partial Network (CSPNet), https://arxiv.org/abs/1911.11929 -

A General Toolbox for Identifying Object Detection Errors, https://github.com/dbolya/tide -

https://blog.zenggyu.com/en/post/2018-12-16/an-introduction-to-evaluation-metrics-for-object-detection/ -

Python library for fast and flexible image augmentations(https://albumentations.ai/#).

數(shù)據(jù)集

-

WiderPerson, https://wider-challenge.org/2019.html -

CAVIAR, http://groups.inf.ed.ac.uk/vision/CAVIAR/CAVIARDATA1/ -

CALTECH Pedestrian dataset, http://www.vision.caltech.edu/Image_Datasets/CaltechPedestrians/

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺(jué)、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺(jué)SLAM“。請(qǐng)按照格式備注,否則不予通過(guò)。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~

評(píng)論

圖片

表情