FloydHub 2020年最佳機器學習書籍之一《可解釋機器學習》中文版來啦!

說到機器學習,想必大家都不陌生。

機器學習是計算機基于數(shù)據(jù)做出和改進預測或行為的一套方法。

那什么是可解釋機器學習呢?

比如,我們通過機器學習的算法得到了某個結(jié)果,那這個結(jié)果是否是可信的呢?我們希望理解這個結(jié)果背后的原因。這就是可解釋機器學習要研究的問題。

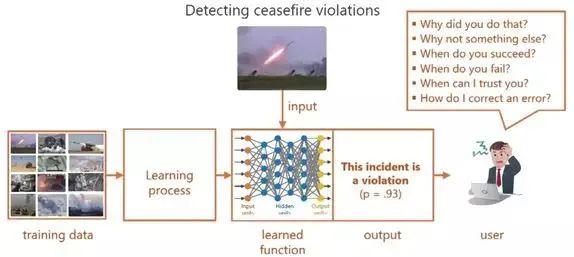

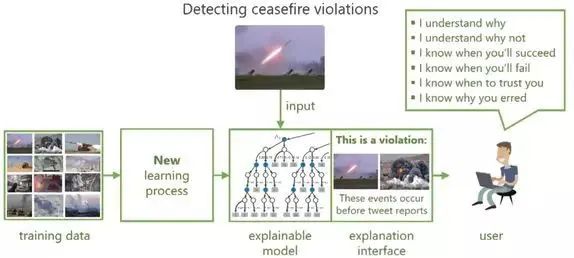

如下圖所示,根據(jù)一般網(wǎng)絡給出的決策時,缺乏可解釋性的結(jié)果讓使用者感到困惑,嚴重限制了其在現(xiàn)實任務中的廣泛應用。

雖然機器學習與人工智能的研究不斷取得了突破性進展,然而高性能的復雜算法、模型及系統(tǒng)普遍缺乏決策邏輯的透明度和結(jié)果的可解釋性,導致在涉及需要做出關鍵決策判斷的國防、金融、醫(yī)療、法律、網(wǎng)絡安全等領域或要求決策合規(guī)的應用中,機器學習技術及系統(tǒng)難以大范圍應用。

比如,醫(yī)生不能僅根據(jù)模型的分類置信度進行診斷,金融機構(gòu)不能僅憑借模型的輸出輕易判斷違約風險,軍方不能僅依賴自動的圖像識別執(zhí)行打擊任務,安全公司也不能僅通過模型檢測結(jié)果完全自動化威脅響應。

而可解釋機器學習主要研究如何使得機器學習系統(tǒng)的行為對人類更透明、更易懂、更可信,因此近年來逐漸成為研究熱點。

Gartner已將可解釋人工智能(XAI)技術列為數(shù)據(jù)和分析技術領域的TOP 10重要趨勢之一。

KDD、ICML、NIPS、AAAI及IJCAI等著名國際性會議都有覆蓋可解釋機器學習話題的Workshop。

由美國國防部資助的美國國防高級研究計劃局(DARPA)于2017年發(fā)起了XAI計劃,全面開展了對可解釋機器學習的研究。

2018年,歐洲委員會向歐洲議會、歐洲理事會等歐洲官方機構(gòu)發(fā)布的有關歐洲人工智能的函件中強調(diào)對可解釋機器學習的需求。

工業(yè)界方面,包括微軟、谷歌、Oracle等諸多科技巨頭,都在開展可解釋機器學習相關技術的研發(fā)。

《可解釋機器學習》(Interpretable Machine Learning)正是在這樣的背景下撰寫和出版的。

本書的作者Christoph Molnar是數(shù)據(jù)科學家和可解釋機器學習博士。

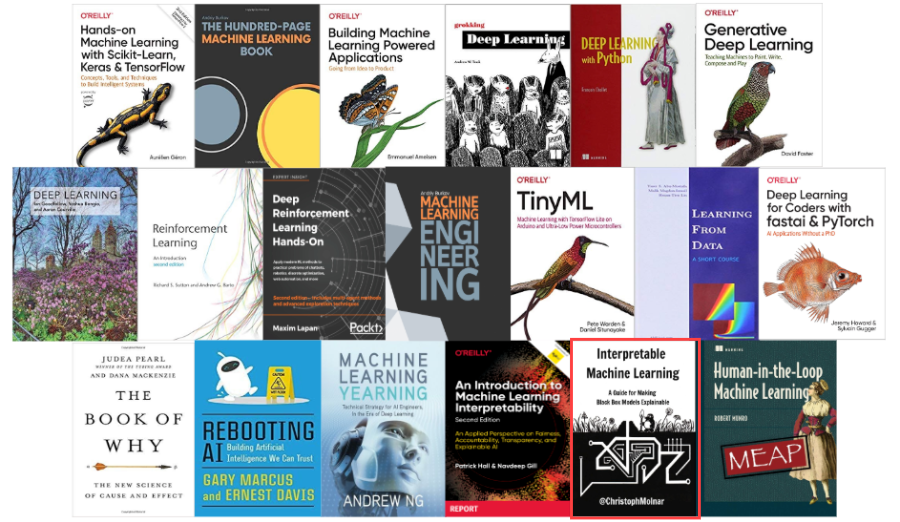

他用兩年時間完成本書第一版,隨機引起業(yè)界轟動,被FloydHub評定為2020年最佳機器學習書籍之一。

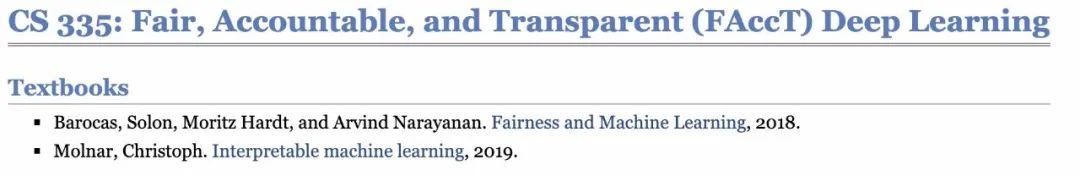

此外,本書還入選了美國斯坦福大學CS335課程教材。

該書作為可解釋機器學習領域的第一本著作,對可解釋機器學習的思想進行了解剖,并對可解釋機器學習的核心概念進行了清晰簡明的描述。同時,該書將可解釋機器學習算法的直觀描述、理論描述、實戰(zhàn)使用過程和優(yōu)缺點結(jié)合起來,從多維度幫助讀者理解算法,具有極強的實用價值。

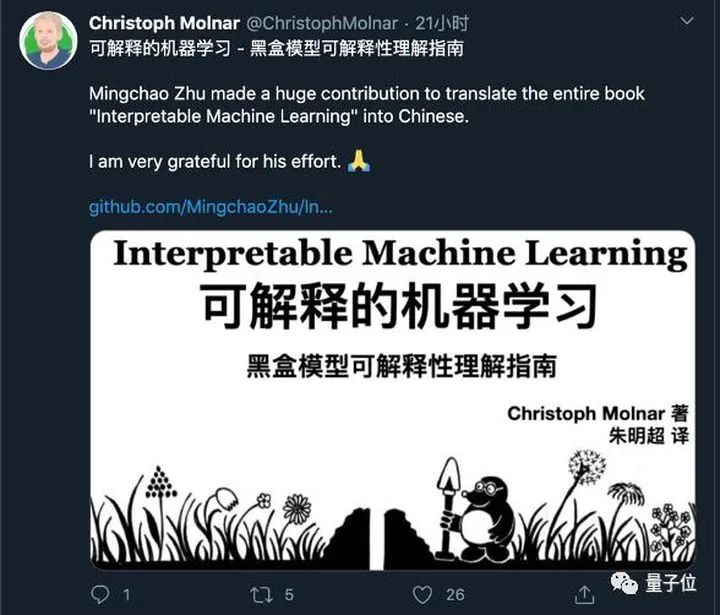

在國內(nèi),該書延續(xù)了在國際上的熱度和口碑。復旦大學朱明超對該書的初步翻譯譯本登上GitHub熱搜榜首,引起眾多關注。

朱明超在翻譯過程中和原作者進行了多次討論,經(jīng)過多次修改和打磨,已經(jīng)將該著作的思想和內(nèi)容以符合中國人理解的思維方式進行了高質(zhì)量的翻譯!中文版還得到了Christoph Molnar本人在Twiter上的推薦。

如今,本書中文版已經(jīng)上市,并受到讀者好評!

▼

希望這本書可以幫你獲得打開黑盒模型的魔法哦!

▊《可解釋機器學習:黑盒模型可解釋性理解指南》

[德] 克里斯托夫·莫爾納(Christoph Molnar) 著

朱明超 譯

打開AI黑盒,揭秘機器學習模型內(nèi)部機制

8種模型+13種方法,帶你跨入模型可解釋之門!

本書探索了可解釋性的概念,介紹了簡單的、可解釋的模型,例如決策樹、決策規(guī)則和線性回歸,重點介紹了解釋黑盒模型的、與模型無關的方法,如特征重要性和累積局部效應,以及用Shapley值和LIME解釋單個實例預測。

本書對所有的解釋方法進行了深入說明和批判性討論,例如它們?nèi)绾卧诤诤邢鹿ぷ鳌⑺鼈兊膬?yōu)缺點是什么、如何解釋它們的輸出。本書將解答如何選擇并正確應用解釋方法。本書的重點是介紹表格式數(shù)據(jù)的機器學習模型,較少涉及計算機視覺和自然語言處理任務。

(掃碼了解本書詳情)

如果喜歡本文

歡迎 在看丨留言丨分享至朋友圈 三連

熱文推薦

▼點擊閱讀原文,獲取本書詳情~