【干貨】本周AI領(lǐng)域優(yōu)秀開源項(xiàng)目分享!

項(xiàng)目一:YOLOv5-PyTorch YOLOv5的PyTorch實(shí)現(xiàn)

項(xiàng)目二:weibo-public-opinion-datasets 持續(xù)維護(hù)的微博輿情數(shù)據(jù)集

項(xiàng)目三:occlusion_person 具有詳細(xì)遮擋標(biāo)簽的多視圖3D人體姿勢估計(jì)數(shù)據(jù)集

項(xiàng)目四:coco-minitrain minicoco數(shù)據(jù)集

項(xiàng)目五:sidechainnet 用于機(jī)器學(xué)習(xí)的全原子蛋白質(zhì)結(jié)構(gòu)數(shù)據(jù)集

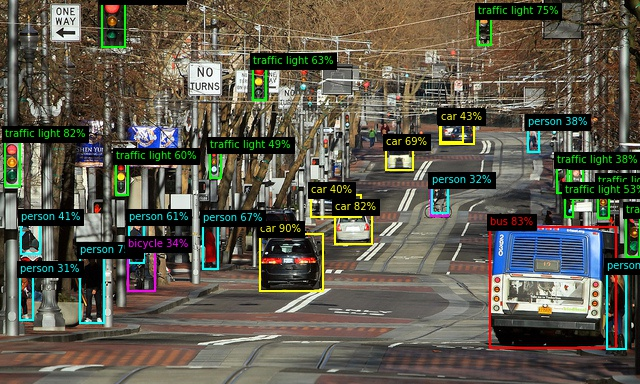

YOLOv5-PyTorch YOLOv5的PyTorch實(shí)現(xiàn)

項(xiàng)目地址:

https://github.com/Okery/YOLOv5-PyTorc

YOLOv5的PyTorch實(shí)現(xiàn)。該存儲庫具有兩個(gè)功能:

純python代碼,無需構(gòu)建即可立即使用PyTorch 1.4運(yùn)行

簡化構(gòu)造并易于理解模型的工作原理

環(huán)境要求:

Windows或Linux,Python≥3.6

PyTorch≥1.4.0

matplotlib-可視化圖像和結(jié)果

pycocotools-用于COCO數(shù)據(jù)集和評估;Windows版本在這里

nvidia dali(僅Linux)-更快的數(shù)據(jù)加載器

數(shù)據(jù)集:

該存儲庫支持VOC和COCO數(shù)據(jù)集。

如果要訓(xùn)練自己的數(shù)據(jù)集,則可以:

編寫相應(yīng)的數(shù)據(jù)集代碼

將您的數(shù)據(jù)集轉(zhuǎn)換為COCO樣式

PASCAL VOC 2012(下載):http://host.robots.ox.ac.uk/pascal/VOC/voc2012/

MS COCO 2017:http://cocodataset.org/

模型訓(xùn)練:

使用 1 GPU在COCO數(shù)據(jù)集上訓(xùn)練 (如果你使用2 GPUs, 設(shè)置 --nproc_per_node=2)

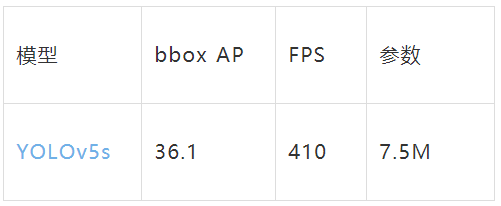

性能:

在單個(gè)RTX 2080Ti GPU上測試COCO 2017

weibo-public-opinion-datasets 持續(xù)維護(hù)的微博輿情數(shù)據(jù)集

項(xiàng)目地址:

https://github.com/nghuyong/weibo-public-opinion-datasets

新浪微博是中國最大的公共社交媒體平臺。最新和最受歡迎的社交活動將盡快在微博上公開和討論。因此,建立一個(gè)實(shí)時(shí),全面的微博輿情數(shù)據(jù)集具有重要意義。

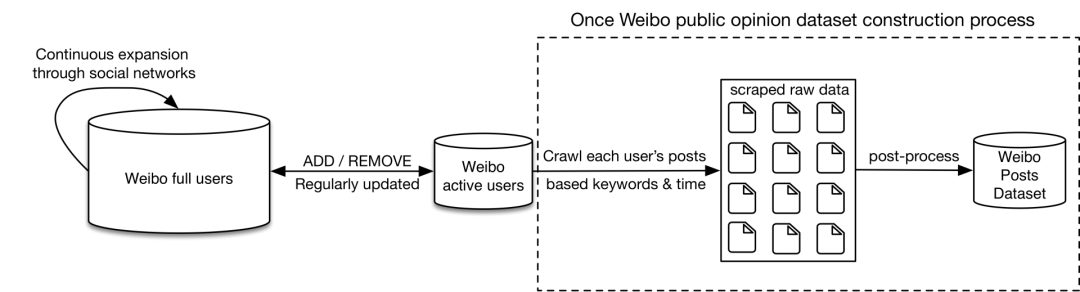

目前,在給定指定關(guān)鍵詞和指定期限的情況下,微博推文數(shù)據(jù)集的構(gòu)建方法有兩種:(1)應(yīng)用微博提供的高級搜索API;(2)遍歷所有微博用戶,收集指定時(shí)間段的所有推文,然后使用指定的關(guān)鍵字過濾推文。

但是,對于第一種方法,由于微博搜索API的限制,一次搜索的結(jié)果最多包含1000條推文,這使得構(gòu)建大型數(shù)據(jù)集變得困難。至于第二種方法,盡管我們可以構(gòu)建幾乎沒有遺漏的大規(guī)模數(shù)據(jù)集,但是遍歷數(shù)十億微博用戶需要非常長的時(shí)間和大量的帶寬資源。另外,大量的微博用戶是不活躍的,遍歷他們的主頁是沒有意義的,因?yàn)樗麄冊谥付ǖ臅r(shí)期內(nèi)可能不會發(fā)布任何推文。

為了緩解這些局限性,我們提出了一種新的方法來構(gòu)建微博推文數(shù)據(jù)集,該方法可以構(gòu)建具有高構(gòu)建效率的大規(guī)模數(shù)據(jù)集。具體來說,我們首先建立并動態(tài)維護(hù)一個(gè)高保密性的微博活躍用戶池(僅占所有用戶的一小部分),然后我們僅遍歷這些用戶并在指定時(shí)期內(nèi)使用指定的關(guān)鍵字收集其所有推文。

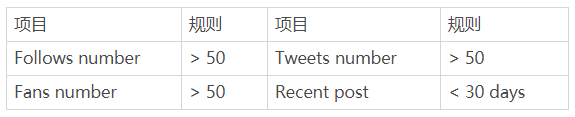

基于初始種子用戶并通過社交關(guān)系不斷擴(kuò)展,我們首先建立了一個(gè)包括超過2.5億用戶的微博用戶池。活躍的微博用戶池是基于微博用戶池構(gòu)建的,遵循4條規(guī)則:

occlusion_person 具有詳細(xì)遮擋標(biāo)簽的多視圖3D人體姿勢估計(jì)數(shù)據(jù)集

項(xiàng)目地址:

https://github.com/zhezh/occlusion_person

該數(shù)據(jù)集是相關(guān)的工作“AdaFuse: Adaptive Multiview Fusion for Accurate Human Pose Estimation in the Wild”,該出版物已發(fā)布在IJCV上。該論文位于(arXiv:2010.13302)。

以前的基準(zhǔn)測試沒有為圖像中的關(guān)節(jié)提供遮擋標(biāo)簽,這阻止了我們對遮擋的關(guān)節(jié)進(jìn)行數(shù)值評估。另外,基準(zhǔn)中的遮擋量是有限的。為了解決這些限制,我們建議構(gòu)建此綜合數(shù)據(jù)集Occlusion-Person。我們采用UnrealCV來渲染3D模型中的多視圖圖像和深度圖。

特別是,將十三種不同衣服的人體模型放置在九個(gè)不同的場景中,例如客廳,臥室和辦公室。人體模型由從CMU Motion Capture數(shù)據(jù)庫中選擇的姿勢驅(qū)動。我們故意使用諸如沙發(fā)和書桌之類的物體遮擋某些身體關(guān)節(jié)。每個(gè)場景中放置了八臺攝像機(jī),以渲染多視圖圖像和深度圖。我們提供15個(gè)關(guān)節(jié)的3D位置作為地面真實(shí)情況。

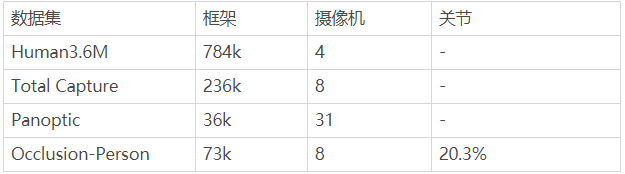

圖像中每個(gè)關(guān)節(jié)的遮擋標(biāo)簽是通過將其深度值(可在深度圖中獲得)與3D關(guān)節(jié)在相機(jī)坐標(biāo)系中的深度進(jìn)行比較而獲得的。如果兩個(gè)深度值之間的差小于30cm,則不會遮擋關(guān)節(jié)。否則,它將被遮擋。下表將此數(shù)據(jù)集與現(xiàn)有基準(zhǔn)進(jìn)行了比較。特別是在我們的數(shù)據(jù)集中,約有20%的身體關(guān)節(jié)被遮擋。

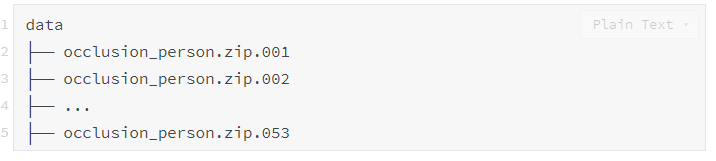

完全下載所有部分后,您應(yīng)該具有以下文件:

coco-minitrain minicoco數(shù)據(jù)集

項(xiàng)目地址:

https://github.com/giddyyupp/coco-minitrain

COCO minitrain是針對COCO的精選小型訓(xùn)練集(25K圖像≈train2017的20%)。這對于超參數(shù)調(diào)整和降低消融實(shí)驗(yàn)的成本很有用。minitrain的對象實(shí)例統(tǒng)計(jì)信息與train2017的那些匹配。在minitrain上訓(xùn)練的模型的val2017性能與在train2017上訓(xùn)練的同一模型的性能強(qiáng)烈正相關(guān)。

COCO minitrain是COCO train2017數(shù)據(jù)集的子集,包含25K圖像(約占train2017集的20%)和跨80個(gè)對象類別的約184K注釋。我們從全套樣本中隨機(jī)采樣了這些圖像,同時(shí)盡可能保留了以下三個(gè)數(shù)量:

每個(gè)類中對象實(shí)例的比例,

小型,中型和大型物體的整體比例,

小型,中型和大型物體的每類比率。

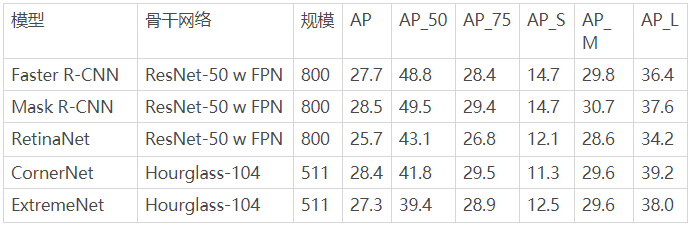

對象檢測器性能。在minitrain上訓(xùn)練模型并在val2017上進(jìn)行評估:

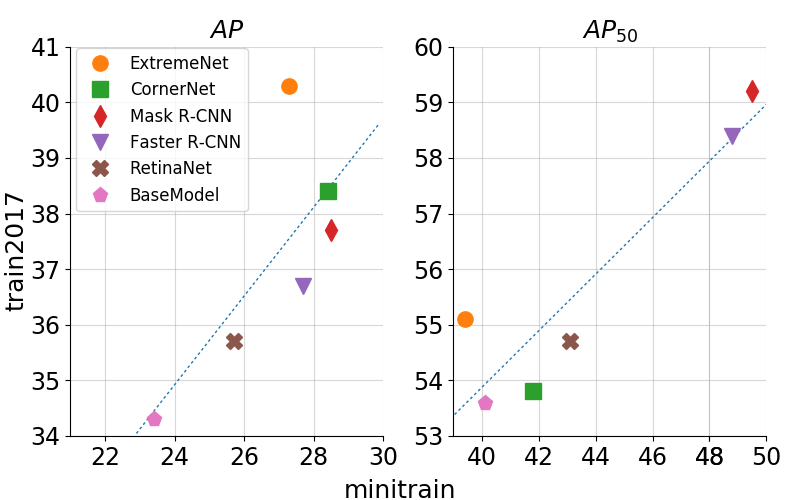

在Minitrain vs Train2017上訓(xùn)練的對象檢測器性能。模型在val2017上進(jìn)行評估:

下圖比較了train2017和minitrain上的物體檢測結(jié)果。該圖還顯示了train2017和minitrain結(jié)果之間的正相關(guān)。對于COCO評估指標(biāo)AP和AP50,皮爾遜相關(guān)系數(shù)分別為0.74和0.92。此圖基于上表。 BaseModel與具有ResNet-101主干的HoughNet模型相對應(yīng)。

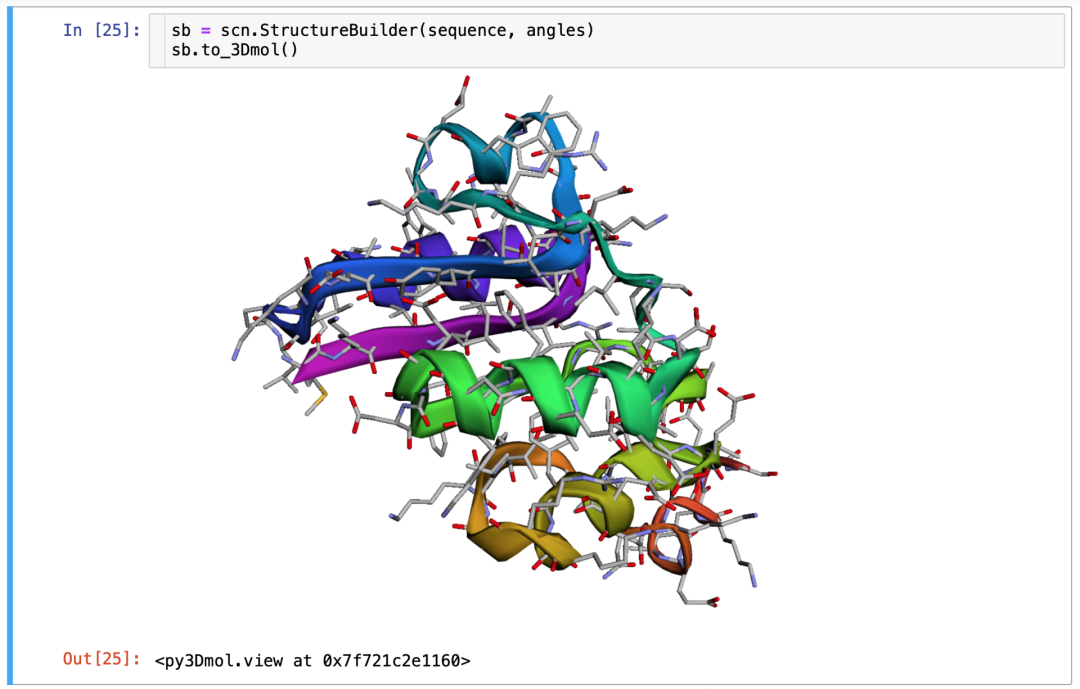

sidechainnet 用于機(jī)器學(xué)習(xí)的全原子蛋白質(zhì)結(jié)構(gòu)數(shù)據(jù)集

項(xiàng)目地址:

https://github.com/jonathanking/sidechainne

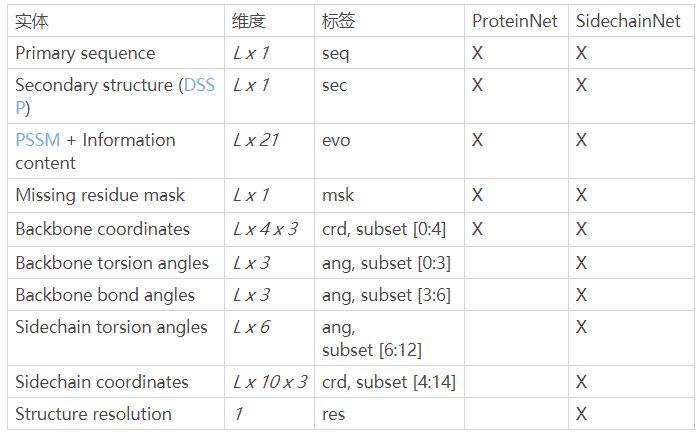

SidechainNet是一種蛋白質(zhì)結(jié)構(gòu)預(yù)測數(shù)據(jù)集,它直接擴(kuò)展了Mohammed AlQuraishi的ProteinNet1。

具體來說,SidechainNet添加了用于測量蛋白質(zhì)角度和坐標(biāo)的測量值,這些測量值描述了完整的,全原子的蛋白質(zhì)結(jié)構(gòu)(主鏈和側(cè)鏈,不包括氫),而不是單獨(dú)的蛋白質(zhì)骨架。

該項(xiàng)目提供以下內(nèi)容:

存儲為腌制Python字典的SidechainNet數(shù)據(jù)集。

在PyTorch中有效加載和批處理SidechainNet數(shù)據(jù)的方法。

根據(jù)模型預(yù)測生成蛋白質(zhì)結(jié)構(gòu)可視化(.pdb,3Dmol,.gltf)的方法。

SidechainNet數(shù)據(jù)概要:

回顧精品內(nèi)容

推薦系統(tǒng)

1、干貨 | 基于用戶的協(xié)同過濾推薦算法原理和實(shí)現(xiàn)

2、超詳細(xì)丨推薦系統(tǒng)架構(gòu)與算法流程詳解

機(jī)器學(xué)習(xí)

自然語言處理(NLP)

1、AI自動評審論文,CMU這個(gè)工具可行嗎?我們用它評審了下Transformer論文

2、Transformer強(qiáng)勢闖入CV界秒殺CNN,靠的到底是什么"基因"

計(jì)算機(jī)視覺(CV)

1、9個(gè)小技巧讓您的PyTorch模型訓(xùn)練裝上“渦輪增壓”...

GitHub開源項(xiàng)目:

1、火爆GitHub!3.6k Star,中文版可視化神器現(xiàn)身

2、兩次霸榜GitHub!這個(gè)神器不寫代碼也可以完成AI算法訓(xùn)練

3、登頂GitHub大熱項(xiàng)目 | 非監(jiān)督GAN算法U-GAT-IT大幅改進(jìn)圖像轉(zhuǎn)換

每周推薦:

1、本周優(yōu)秀開源項(xiàng)目分享:無腦套用格式、開源模板最高10萬贊

2、【干貨】本周AI領(lǐng)域優(yōu)秀開源項(xiàng)目和優(yōu)秀論文分享!

七月在線學(xué)員面經(jīng)分享:

1、先工程后算法:美國加州材料博后辭職到字節(jié)40萬offer