[ACM MM 2023]基于擴(kuò)散模型的風(fēng)格圖像和諧化

背景

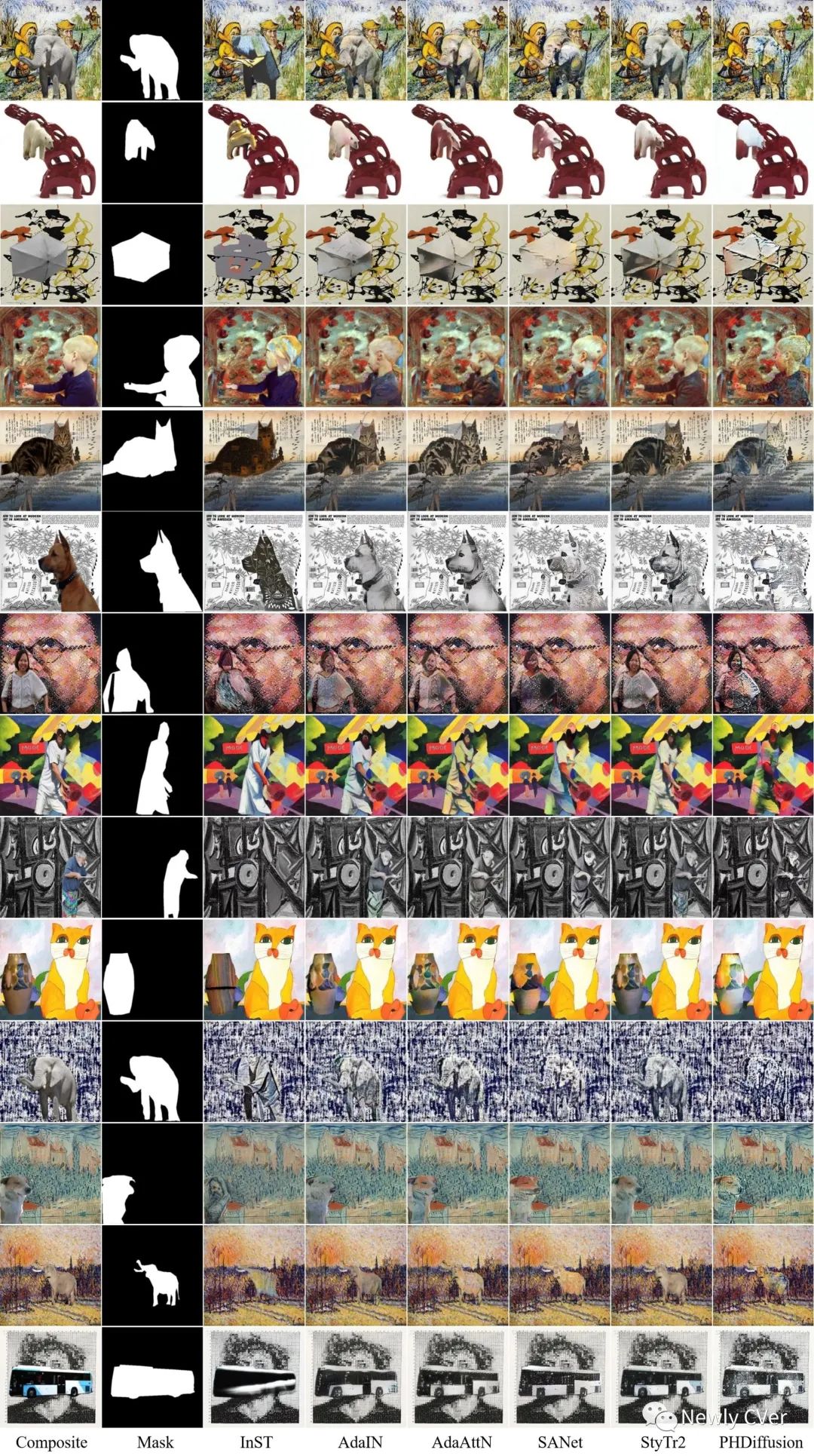

圖像合成(Image Composition)是指將前景從一張圖片上剪切下來,然后粘貼到另一張圖片上,生成一張合成圖片的技術(shù)。但通過這種方式獲得的合成圖片,其前景和背景會(huì)存在色彩、光照等統(tǒng)計(jì)信息不一致的問題,這導(dǎo)致整張圖片看起來不真實(shí)、不和諧。圖像和諧化(Image Harmonization)任務(wù)旨在調(diào)整合成圖片中的前景區(qū)域的外觀表現(xiàn),使其與背景一致,使合成圖片變得更加真實(shí)和諧。在實(shí)際應(yīng)用中,用戶也可能從照片上剪切下來一個(gè)前景物體,然后粘貼到一張油畫背景上,期望生成一張藝術(shù)風(fēng)格的合成圖。如下圖所示,

在通過剪切粘貼得到的合成圖片中,前景的色彩、紋理、筆觸等風(fēng)格信息與背景明顯不一致,導(dǎo)致整張圖看起來不真實(shí)。我們通過風(fēng)格圖像和諧化(Painterly Image Harmonization)來解決這類合成圖片不和諧的問題,目標(biāo)是將真實(shí)世界的物體融入到一幅藝術(shù)繪畫圖中,實(shí)現(xiàn)視覺上的和諧與統(tǒng)一。我們首次將擴(kuò)散模型引入風(fēng)格圖像和諧化,相比之前的方法在視覺效果上有顯著提升。論文發(fā)表在ACM MM 2023, 代碼和模型已開源:

論文:https://arxiv.org/pdf/2308.02228.pdf

代碼模型:https://github.com/bcmi/PHDiffusion-Painterly-Image-Harmonization

方法

針對(duì)這個(gè)任務(wù),現(xiàn)有的方法大致可以分為兩類:基于優(yōu)化的方法和前饋方法。基于優(yōu)化的方法通過最小化所設(shè)計(jì)的損失函數(shù)來優(yōu)化合成圖像,這使得它們非常耗時(shí)并不適用于實(shí)時(shí)應(yīng)用。而前饋方法主要依賴生成對(duì)抗網(wǎng)絡(luò)(GAN),訓(xùn)練好的模型可以直接生成和諧的圖像。然而,基于GAN的方法在復(fù)雜前景的控制上存在局限性,導(dǎo)致前景協(xié)調(diào)效果不理想,例如內(nèi)容和風(fēng)格細(xì)節(jié)的丟失。

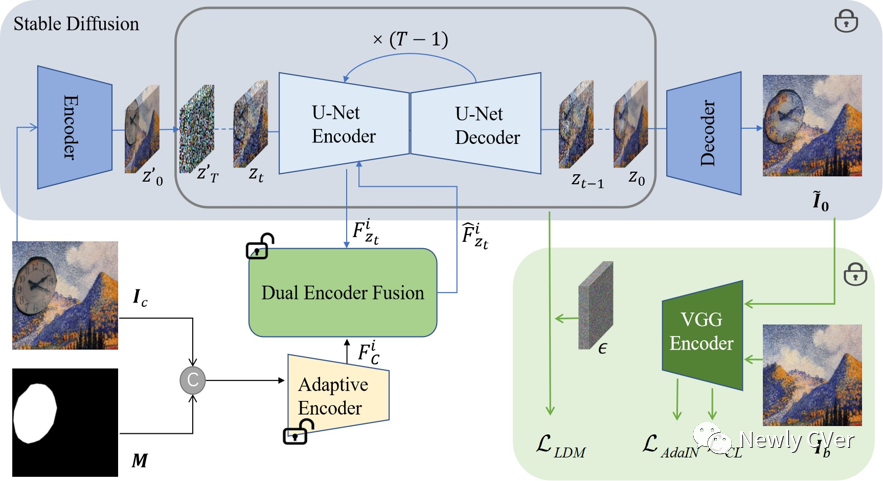

因此我們提出基于擴(kuò)散模型的風(fēng)格化圖像和諧網(wǎng)絡(luò)(PHDiffusion),模型名字傳承自我們實(shí)驗(yàn)室上一個(gè)工作PHDNet。我們的PHDiffusion在穩(wěn)定擴(kuò)散(Stable Diffusion)模型的基礎(chǔ)上利用了兩個(gè)額外的模塊,一個(gè)是輕量編碼器,一個(gè)是雙編碼器融合模塊。其中,輕量編碼器是受條件擴(kuò)散模型(T2I-Adapter)的啟發(fā),旨在從合成圖像中提取所需的條件信息,即背景風(fēng)格、圖像內(nèi)容。自適應(yīng)編碼器以合成圖像和前景掩碼的串聯(lián)作為輸入,產(chǎn)生添加到去噪編碼器中特征圖的殘差。基于自適應(yīng)編碼器和擴(kuò)散模型中的去噪編碼器,我們引入了一個(gè)雙編碼器融合(DEF)模塊來融合兩個(gè)編碼器的信息。具體而言,給定兩個(gè)編碼器提取的圖像特征,我們的雙編碼器融合模塊將背景風(fēng)格融入前景內(nèi)容中并生成風(fēng)格化的前景特征。然后,來自兩個(gè)編碼器的風(fēng)格化前景特征被組合在一起,在去噪步驟中提供多步引導(dǎo)。

為了利用預(yù)訓(xùn)練的穩(wěn)定擴(kuò)散模型中豐富的先驗(yàn)知識(shí)并減輕訓(xùn)練負(fù)擔(dān),我們凍結(jié)了穩(wěn)定擴(kuò)散模型的模型參數(shù),并僅在訓(xùn)練過程中更新自適應(yīng)編碼器和雙編碼器融合模塊。擴(kuò)散模型中使用的標(biāo)準(zhǔn)噪聲損失可以保持圖像內(nèi)容,但無法將背景風(fēng)格遷移到前景上。因此,我們進(jìn)一步引入了兩個(gè)額外的風(fēng)格損失,即AdaIN損失和對(duì)比風(fēng)格損失,以平衡前景對(duì)象的風(fēng)格和內(nèi)容。AdaIN損失將前景對(duì)象的多尺度統(tǒng)計(jì)數(shù)據(jù)(例如均值、方差)與背景繪畫進(jìn)行對(duì)齊,而對(duì)比風(fēng)格損失旨在將前景風(fēng)格推向背景風(fēng)格。此外,我們還引入了內(nèi)容損失來解決僅使用噪聲損失時(shí)內(nèi)容過于保留的問題。通過噪聲損失、風(fēng)格損失和內(nèi)容損失,我們的PHDiffusion能夠理解背景風(fēng)格并保持前景內(nèi)容。在測試中,我們的PHDiffusion可以直接用于生成協(xié)調(diào)的圖像,避免了額外的耗時(shí)推理優(yōu)化。

實(shí)驗(yàn)

為了驗(yàn)證我們的PHDiffusion的有效性,我們將其與最先進(jìn)的方法進(jìn)行比較,并在基準(zhǔn)數(shù)據(jù)集COCO和WikiArt上進(jìn)行實(shí)驗(yàn)。由于風(fēng)格圖像和諧化任務(wù)沒有靠譜的量化指標(biāo),主要還是依靠user study。實(shí)驗(yàn)結(jié)果表明,我們的PHDiffusion能夠?qū)崿F(xiàn)一定程度上令人愉悅的結(jié)果,而之前的方法則無法達(dá)到這樣的效果,尤其是在背景具有密集紋理或抽象風(fēng)格的情況下。我們方法PHDiffusion(最右邊一列)和之前方法的對(duì)比效果圖如下: