Transformer的中年危機

極市導讀

CV圈已經殺瘋了的MLP,各位大佬接連發(fā)文,transformer被接連質疑,transformer老哥也迎來了它的中年危機。 >>加入極市CV技術交流群,走在計算機視覺的最前沿

卷友們好,我是rumor。最近Transformer被各種「質疑」,上周CV圈已經殺瘋了,多個大佬接連發(fā)文,把早已過時的MLP又擺了出來:

-

5月4日,谷歌掛出《MLP-Mixer An all-MLP Architecture for Vision》 -

5月5日,清華圖形學實驗室掛出《Beyond Self-attention: External Attention using Two Linear Layers for Visual Tasks》 -

5月5日,清華軟院掛出《RepMLP: Re-parameterizing Convolutions into Fully-connected Layers for Image Recognition》 -

5月6日,牛津掛出《Do You Even Need Attention? A Stack of Feed-Forward Layers Does Surprisingly Well on ImageNet》

好家伙,題目一個比一個扎心。

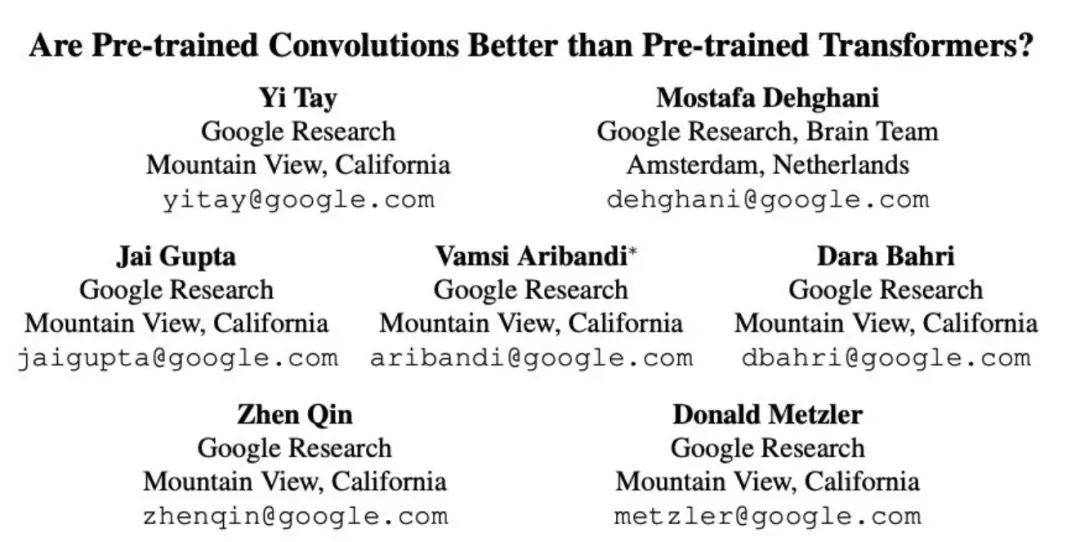

然而CV圈扎完了,娘家的NLPer也不甘示弱,就在昨天我刷Arxiv的時候,一篇谷歌的文章映入眼簾:

大佬們指出,雖然Transformer老哥的效果確實好,但這個效果到底是模型結構帶來的、還是預訓練帶來的呢? 畢竟之前也沒人這么暴力地訓過對不對。那既然沒人訓過,這不idea就來了嘛接下來我腦補了一下模型選擇的問題,經典的就那么幾個:

-

MLP:好!但谷歌18年的USE模型已經證明了MLP沒Transformer效果好,畢竟NLP還是需要序列信息的 -

LSTM:不錯!用這個把大模型訓出來,今年的kpi就算了,明年的可以沖刺一下 -

CNN:這個好!速度又快又輕便,根據經驗來說在簡單任務上表現也不差,穩(wěn)得一批

結果一訓真的是,瞬間ACL+1:

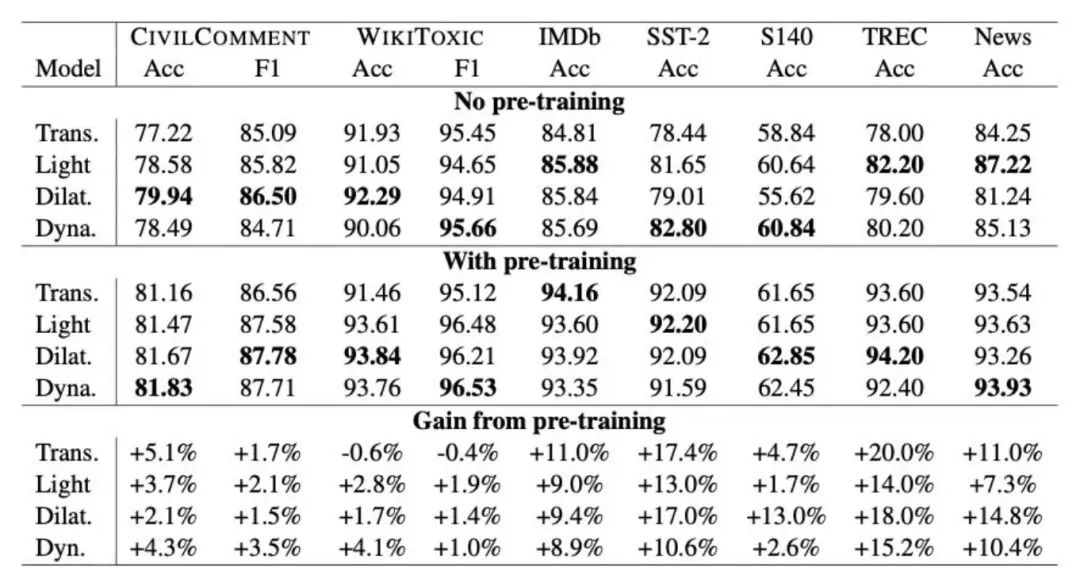

上圖中 Lightweight CNN、Dilated CNN、Dynamic CNN 分別是不同的變種,可以得出以下結論:

-

不管有沒有預訓練,CNN的一些變種在NLP分類任務上都有比肩Transformer的效果 -

不只是Transformer,預訓練對于CNN網絡也是有提升的,在1%-18%之間 -

Dilated CNN、Dynamic CNN 這兩個變種的表現更好 -

結構、預訓練對于最終表現都有影響,可能不預訓練的時候A>B,預訓練之后A<B

不過,表中數據展示的都是文本分類,雖然附加的一個生成式語義分析上表現也不錯,但大佬們也十分清楚CNN在其他更難的任務上表現有限。CNN在設計上沒考慮句子間的交互,只抽取了局部特征。比如在句子pair拼接的分類任務上(MultiNLI、SQuAd),就比Transformer甩掉了10-20個點。有趣的是作者在給CNN加了一層cross-attention之后效果就上去了,在MultiNLI把差距縮小到了1個點。同時他們也指出,在雙塔式的分類任務上CNN應該有更好的表現(就像USE模型用MLP也能達到不錯的效果)。所以,文章讀到這里,發(fā)現Transformer還是穩(wěn)坐NLP第一把交椅。這也是它的 ?? ?? 之處,無論別人怎么搞,都沒法在general層面打過它。前段時間谷歌還有篇文章分析了Transformer的各種變種,發(fā)現大部分都只是在個別任務有所提升(攤手)。但在做實際落地任務時,還是會有各種速度上的限制,這篇文章就是告訴我們在任務簡單、數據量充足、速度受限的情況下可以用CNN及變種來解決問題。TextCNN is all you need。最后再說幾個我疑惑的點,歡迎留言討論:

-

文章用的都是CNN變種,為什么沒嘗試最經典的CNN呢?會不會是表現太差了,不能支持結論 -

文章的預訓練模型是參考T5的結構,為什么不用更普遍的BERT結構?還提到T5是「current state-of-the-art」,那20年下的GPT3去哪兒了?難道是寫的時間太早?為什么現在才發(fā)?

這些問題都不得而知了,所以短期內我還是繼續(xù)無腦精調BERT吧,做個懶人。

如果覺得有用,就請分享到朋友圈吧!

公眾號后臺回復“廣東CVPR”獲取CSIG-廣東省CVPR 2021論文學術報告會回放

深度學習環(huán)境搭建:個人深度學習工作站配置指南|深度學習主機配置推薦

實操教程:用OpenCV的DNN模塊部署YOLOv5目標檢測|TensorRT的FP16模型轉換教程

算法技巧(trick):17種提高PyTorch“煉丹”速度方法|PyTorch Trick集錦|深度學習調參tricks總結

最新CV競賽:2021 高通人工智能應用創(chuàng)新大賽|CVPR 2021 | Short-video Face Parsing Challenge|3D人體目標檢測與行為分析競賽開賽,獎池7萬+,數據集達16671張!

# CV技術社群邀請函 #

備注:姓名-學校/公司-研究方向-城市(如:小極-北大-目標檢測-深圳)

即可申請加入極市目標檢測/圖像分割/工業(yè)檢測/人臉/醫(yī)學影像/3D/SLAM/自動駕駛/超分辨率/姿態(tài)估計/ReID/GAN/圖像增強/OCR/視頻理解等技術交流群

每月大咖直播分享、真實項目需求對接、求職內推、算法競賽、干貨資訊匯總、與 10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動交流~