多模態(tài)視頻分類系列:簡單綜述

大家好,我是DASOU;

最近在做多模態(tài)視頻分類,有一些感悟會通過文章分享給大家,今天先發(fā)一個簡單的綜述;

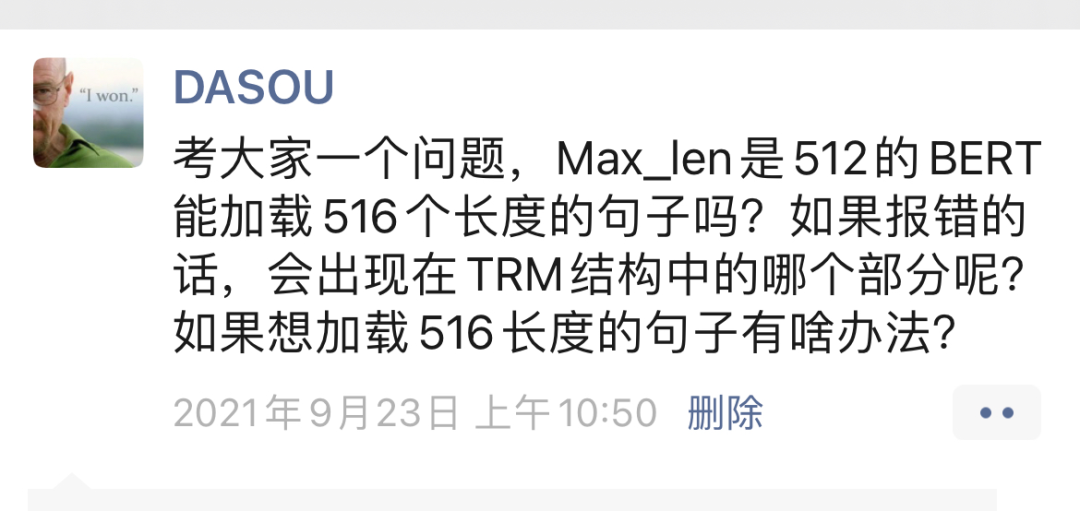

對我朋友圈的朋友可以加我微信【dasounlp】或者公眾號主頁右下角點擊【聯(lián)系我】,我隨時發(fā)一些我看過的論文或者感悟,比如下面這種:

然后我插一句哈,有些時候問我問題我沒回復(fù)不是我高冷~~

一般三種情況,1. 是真的沒時間,2. 信息太多我忘了回復(fù),現(xiàn)在每天問我問題的每天幾十個信息,有些時候看完沒回之后就忘了回復(fù)了,3.我覺得問題很簡單百度一下就知道;

我也是有工作的,而且賊忙,也比較菜,不是啥都會的,大家也見諒一下~~~~

正文開始:

先從單模態(tài)視頻分類說起,它分為三個方向去掌握:

雙流網(wǎng)絡(luò);一支走圖像,一支走光流,然后兩支結(jié)果做融合;

3D卷積,就是在2D卷積的基礎(chǔ)上加一個時間維度;

CNN-RNN系列,通過CNN獲取圖片特征,進(jìn)而使用RNN獲取圖片特征之間的時序特征;

上面談到的這三種方式,其實比較適合很短的視頻;

我自己的應(yīng)用場景其實是長視頻,十幾分鐘甚至幾十分鐘的視頻;視頻時間長了,抽取的幀就會相應(yīng)的變多,那么處理起來就會相當(dāng)?shù)穆闊?/p>

在工業(yè)界用到的長視頻分類的方法,據(jù)我所知,大體是兩個重點,一個重點是使用多模態(tài),最重要的是加上文本信息,有的也會加上音頻信息;

這點其實很好理解,比如一個【母嬰育兒】方向的視頻,抽取的幀最好包含母親或者嬰兒或者一些相關(guān)物品,才可能會被判定為【母嬰育兒】的領(lǐng)域;

但是文字可能就簡簡單單的幾個字就能把【母嬰育兒】這個領(lǐng)域的概率拉上去;

所以基于我自己的應(yīng)用場景,一定要明確一個概念,視頻信息只能作為一種補充信息,而不是主要信息來源;

而在推理的時候,我也只會用到哪些 hard examples 進(jìn)到多模態(tài)視頻分類這一支網(wǎng)絡(luò);

第二個重點也很類似,因為視頻信息只能作為補充,所以視頻這邊的網(wǎng)絡(luò)最大的作用就是能更好的融合視頻信息;

如果視頻長度長達(dá)幾十分鐘,資源有限,為了提高推理速度,抽取的幀數(shù)也不能太多,比如控制在50個,其實光流信息基本就沒啥了,RGBDiff這種基本也沒啥了,唯一剩下點的就是時間信息,可能還不多;

所以重點就要放在提取幀的圖像信息上,外加看能不能通過網(wǎng)絡(luò)再把時間信息補充進(jìn)來,有最好,沒有感覺就轉(zhuǎn)為了多模態(tài)圖片分類;

所以幀的融合方式就會變得很重要;

簡單來說,我這個文章的重點就是說,針對長視頻,幀數(shù)控制在不太大的情況下,常規(guī)的網(wǎng)絡(luò)基本不太實用,要把重點放在圖像特征的提取和幀的融合;

特征提取一般就是CNN預(yù)訓(xùn)練模型,幀的融合一般就是使用lstm或者NetVlad等;

這個文章算是多模態(tài)視頻分類的一個開篇,后續(xù)會把一些論文文章分享一下,transformer在圖像和視頻的應(yīng)用這一塊我也在慢慢看一些論文,后續(xù)有時間會試試效果。