點(diǎn)擊左上方藍(lán)字關(guān)注我們

一個專注于目標(biāo)檢測與深度學(xué)習(xí)知識分享的公眾號 姿態(tài)估計(jì)問題就是確定某一三維目標(biāo)物體的方位指向問題。姿態(tài)估計(jì)在 機(jī)器人視覺 、動作跟蹤和單照相機(jī)定標(biāo)等很多領(lǐng)域都有應(yīng)用。在不同領(lǐng)域用于姿態(tài)估計(jì)的 傳感器 一般是不同的。 轉(zhuǎn)載自 | 計(jì)算機(jī)視覺工坊

三維重建領(lǐng)域主要的數(shù)據(jù)格式有四種:

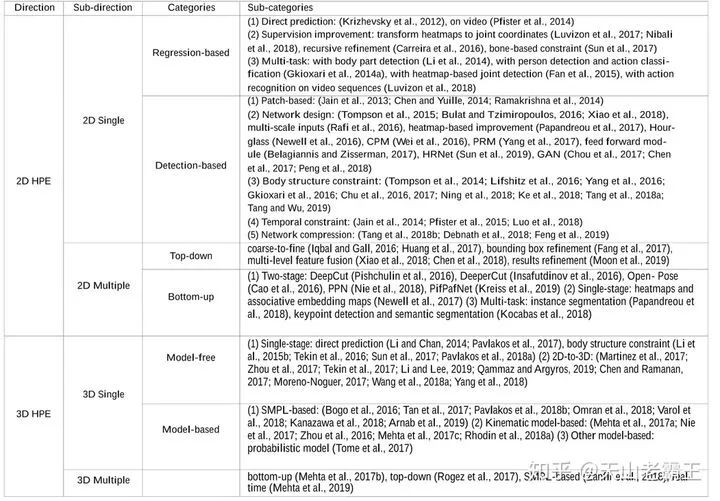

? 深度圖(depth map),2D圖片,每個像素記錄從視點(diǎn)到物體的距離,以灰度圖表示,越近越黑; ? 體素(voxel),體積像素概念,類似于2D之于像素定義; ? 點(diǎn)云(point cloud),每個點(diǎn)逗含有三維坐標(biāo),乃至色彩、反射強(qiáng)度信息; ? 網(wǎng)格(mesh),即多邊形網(wǎng)格,容易計(jì)算。 三維姿態(tài)估計(jì) :許多論文將人體姿態(tài)估計(jì)定義為從單視圖或多視圖的圖像、視頻序列中定位人體主要三維關(guān)節(jié)的問題。即從圖片或視頻中估計(jì)出關(guān)節(jié)點(diǎn)的三維坐標(biāo) (x, y, z)。根據(jù)不同的特征總結(jié)基于深度學(xué)習(xí)的HPE 方法的不同類別: 1.生成(基于人體模型,SMPL)和判別(無人體模型); 2.自上而下(從高級抽象到低級像素證據(jù),如HRNet)和自下而上(從低級像素證據(jù)到高級抽象,如OpenPose); 3.基于回歸(直接從輸入圖像映射到身體關(guān)節(jié)位置)和基于檢測(生成中間圖像patch或關(guān)節(jié)位置的heatmap); 4.單階段(端到端培訓(xùn))和多階段(分階段培訓(xùn))。

3D姿態(tài)估計(jì)引言:

與2DHPE相比,3DHPE更具有挑戰(zhàn)性,因?yàn)樗枰A(yù)測人體關(guān)節(jié)的深度信息。另外,3D HPE的訓(xùn)練數(shù)據(jù)不像2DHPE那樣容易獲得。大多數(shù)現(xiàn)有的數(shù)據(jù)集是在有限的可推廣性約束環(huán)境下獲得的。 3D姿態(tài)估計(jì)有深度模糊 的問題,多個三維姿態(tài)對應(yīng)相同的二維投影。且許多姿態(tài)可能是不合理的,例如不可能的關(guān)節(jié)角度或者非常瘦的身體。

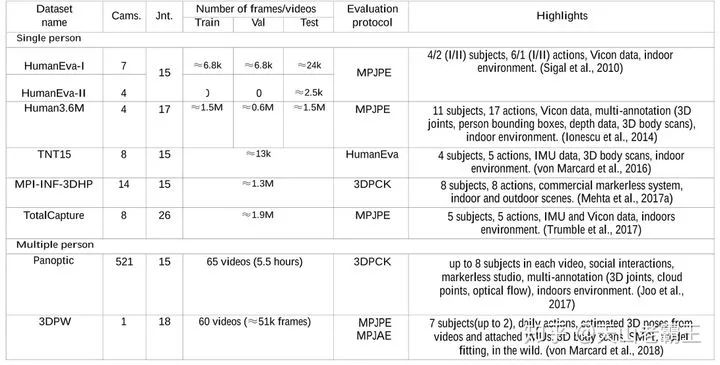

常見的3D姿態(tài)估計(jì)數(shù)據(jù)集:

視頻數(shù)據(jù)集如HumanEva和Human3.6M 標(biāo)注了3D關(guān)節(jié)的位置。故可以直接使用3D關(guān)鍵點(diǎn)數(shù)據(jù)進(jìn)行監(jiān)督學(xué)習(xí),直接從圖像中估計(jì)三維關(guān)節(jié)。 許多方法沒有解決相機(jī)問題,而是估計(jì)相對于根的深度,并使用基于骨骼平均長度的預(yù)定義全局尺度。 具有精確的ground truth 3D注釋的圖像是在受控的MoCap環(huán)境中捕獲的。僅根據(jù)這些圖像訓(xùn)練的模型不能很好地適用于現(xiàn)實(shí)世界。在這里不考慮此種方法。

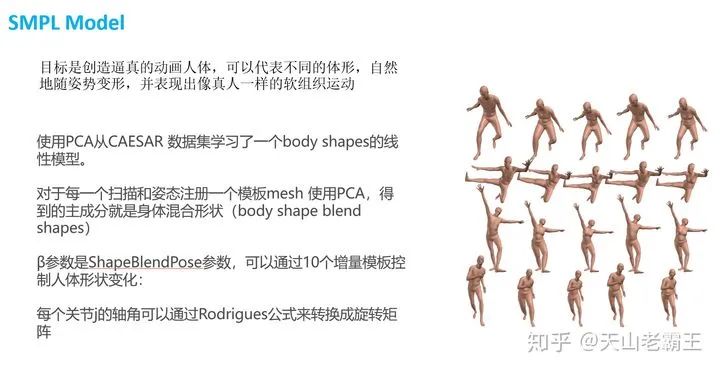

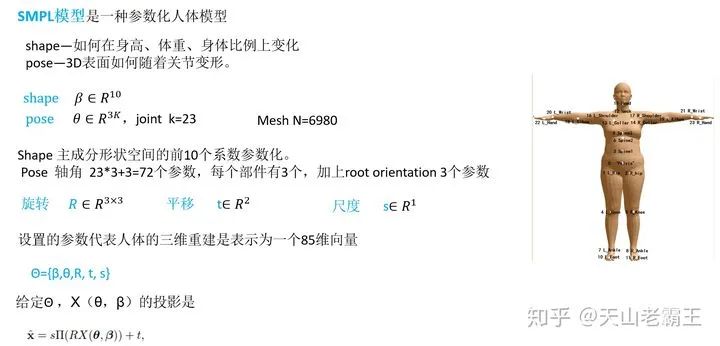

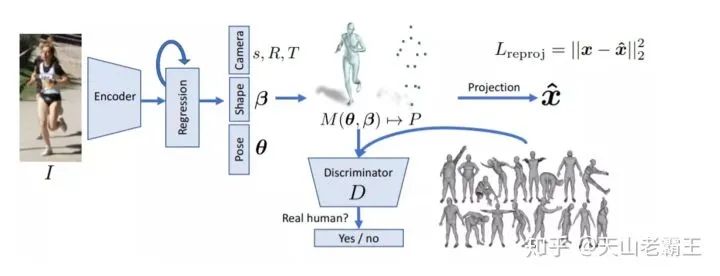

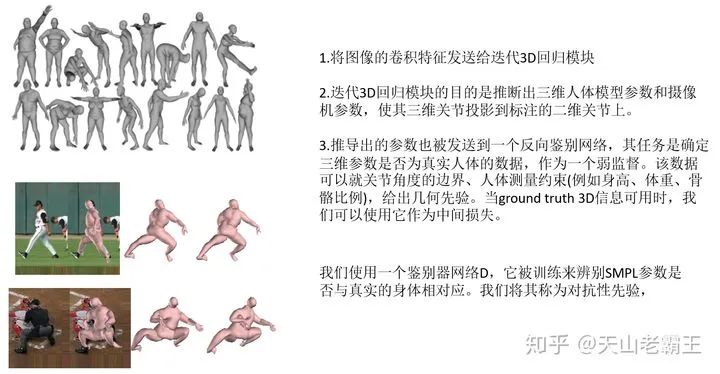

(regression)先獲取2D信息,然后再“提升”到3D姿態(tài)。 該方法對圖像提取特征,最終得到2D point(如HRNet、PifPaf等網(wǎng)絡(luò)),后將2D關(guān)鍵點(diǎn)序列輸入到后續(xù)網(wǎng)絡(luò)(強(qiáng)行FC、TCN、LSTM等)中,提升到3D關(guān)鍵點(diǎn)。該方法有相關(guān)實(shí)驗(yàn)結(jié)果顯示:用2D的ground truth關(guān)節(jié)點(diǎn)來生成3D的關(guān)節(jié)點(diǎn)錯誤率非常低,比目前最好的結(jié)果好了30%。而我們用從2D圖像得到的2D關(guān)節(jié)點(diǎn)來生成3D關(guān)節(jié)點(diǎn),這樣的錯誤率只比目前最好的結(jié)果稍微好一點(diǎn)。因此,該種方法還是主要依賴于目前的2D姿態(tài)估計(jì)技術(shù)。(model fitting)基于模型的人體姿態(tài)估計(jì)目前有兩種不同的方法。 基于優(yōu)化的方法以迭代的方式將參數(shù)體模型與二維觀測值進(jìn)行擬合,可以得到精確的圖像-模型比對,但往往對初始化比較緩慢和敏感。相比之下,基于回歸的方法,即使用深度網(wǎng)絡(luò)直接從像素估計(jì)模型參數(shù),往往提供合理的,但像素不準(zhǔn)確的結(jié)果,同時需要大量的監(jiān)督。基于優(yōu)化的方法已經(jīng)被很好地探索和理解。給定人體的參數(shù)模型,例如在SMPL,迭代擬合方法試圖估計(jì)身體姿態(tài)和形狀,最好地解釋二維觀察,最典型的如二維關(guān)節(jié)位置。由于我們明確地對模型與圖像特征的一致性進(jìn)行優(yōu)化,我們通常會得到很好的擬合,但優(yōu)化往往非常緩慢,而且對初始化的選擇相當(dāng)敏感。另一方面,最近的深度學(xué)習(xí)進(jìn)展已經(jīng)將焦點(diǎn)轉(zhuǎn)移到純粹基于回歸的方法上,即使用深度網(wǎng)絡(luò)直接從圖像中回歸模型參數(shù)。理論上,這是一個很有前途的方向,因?yàn)樯疃然貧w可以考慮所有的像素值,而不是僅僅依賴于二維位置的稀疏集。遺憾的是,這種一次預(yù)測可能會導(dǎo)致圖像-模型對齊不理想,同時需要大量的數(shù)據(jù)對網(wǎng)絡(luò)進(jìn)行適當(dāng)?shù)挠?xùn)練。 使用當(dāng)時流行的基于CNN的方法DeepCut來預(yù)測(自下而上)二維人體關(guān)節(jié)位置。然后,將發(fā)布的統(tǒng)計(jì)身體形狀模型SMPL(自頂向下)擬合到2D關(guān)節(jié)。通過最小化目標(biāo)函數(shù)來懲罰投影的3D模型關(guān)節(jié)與檢測到的2D關(guān)節(jié)之間的誤差。 基于回歸的方法 :最近的大多數(shù)工作,對于單個RGB圖像,使用深度網(wǎng)絡(luò)對模型參數(shù)進(jìn)行回歸。由于缺乏具有完整的三維形狀地面真實(shí)感的圖像,這些工作大多集中在替代監(jiān)督信號訓(xùn)練深層網(wǎng)絡(luò)。它們中的大多數(shù)都嚴(yán)重依賴于2D注釋,包括2D關(guān)鍵點(diǎn)、分割Mask。其思想是,給定一幅圖像,網(wǎng)絡(luò)必須推斷出3D網(wǎng)格參數(shù)和攝像機(jī),以便在投影后,3D關(guān)鍵點(diǎn)與標(biāo)注的2D關(guān)鍵點(diǎn)相匹配。為了處理模糊性,這些參數(shù)被發(fā)送到鑒別器網(wǎng)絡(luò),鑒別器網(wǎng)絡(luò)的任務(wù)是確定三維參數(shù)是否與真實(shí)人體相對應(yīng)。 雖然SMPL可以對靜態(tài)軟組織變形進(jìn)行姿態(tài)建模,但它對由于身體運(yùn)動和與地面的沖擊力而發(fā)生的動態(tài)變形并不工作。因而SMPL作者為了建模這些,引入了一組新的附加混合形狀,稱之為動態(tài)混合形狀。這些額外的位移與身體和四肢的速度和加速度有關(guān),而與姿勢無關(guān),該模型稱之為DMPL。

聯(lián)合優(yōu)化與回歸的方法:

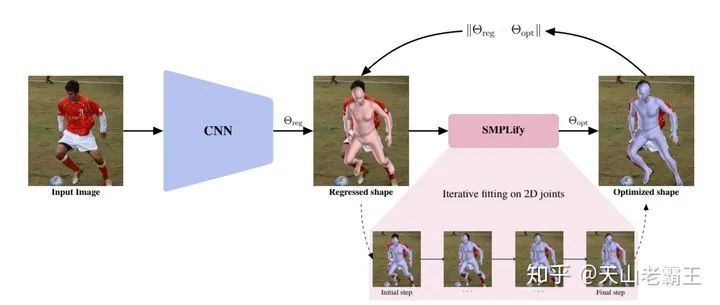

如SPIN(Learning to Reconstruct 3D Human Pose and Shape via Model-fitting in the Loop): SPIN通過基于回歸和基于迭代的優(yōu)化方法之間的緊密協(xié)作,為三維人體姿態(tài)和形狀估計(jì)訓(xùn)練了一個深度網(wǎng)絡(luò)。在培訓(xùn)期間,網(wǎng)絡(luò)預(yù)測SMPL參數(shù)模型,不使用ground truth 2D關(guān)鍵點(diǎn)來應(yīng)用弱重投影損失,而是建議使用回歸估計(jì)來初始化一個迭代優(yōu)化例程,使模型適合于2D關(guān)鍵點(diǎn)(SMPLify)。這個過程是在訓(xùn)練循環(huán)中完成的。 為了約束2D到3D估計(jì)中的固有模糊性,這些方法使用了各種先驗(yàn)。大多數(shù)方法對肢長或比例做出一些假設(shè)。 過多地依賴于2D關(guān)節(jié)檢測并且可能在估計(jì)3D姿勢時丟棄圖像信息。

表征方面:

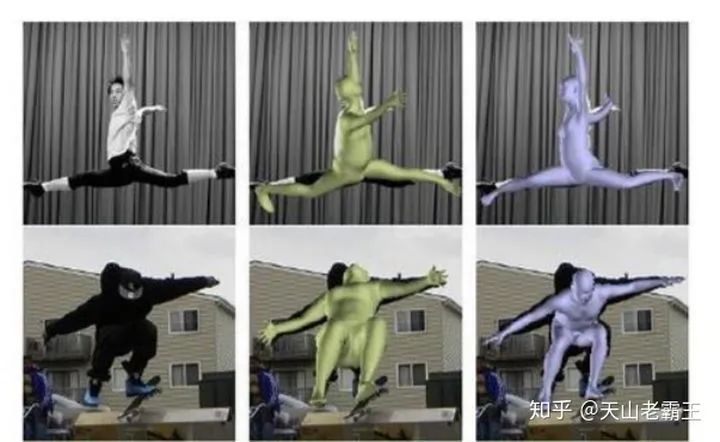

對于人體的三維形態(tài),目前看到有幾類不同的表征方式,包括回歸出參數(shù)化人體模型的參數(shù)(如SMPL 的 和 ),直接學(xué)習(xí)出人體的體素(Voxel)等以及學(xué)習(xí)texture-to-surface的correspondences(如UV map)。

SMPL介紹:

總結(jié):

目前的網(wǎng)絡(luò)已經(jīng)驗(yàn)證了多階段結(jié)構(gòu)、中間監(jiān)督、多尺度特征融合、多任務(wù)學(xué)習(xí)、體結(jié)構(gòu)約束等有效的網(wǎng)絡(luò)設(shè)計(jì)方法。網(wǎng)絡(luò)效率也是將算法應(yīng)用于實(shí)際應(yīng)用的一個非常重要的因素。多樣性數(shù)據(jù)可以提高網(wǎng)絡(luò)處理姿態(tài)不規(guī)則、肢體遮擋和人群擁擠等復(fù)雜場景的魯棒性。針對特定復(fù)雜場景的數(shù)據(jù)收集是一個選項(xiàng),還有其他方法可以擴(kuò)展現(xiàn)有數(shù)據(jù)集。在合成數(shù)據(jù)與真實(shí)數(shù)據(jù)存在領(lǐng)域差距的情況下,理論上合成技術(shù)可以產(chǎn)生無限的數(shù)據(jù)。跨數(shù)據(jù)集補(bǔ)充,特別是用二維數(shù)據(jù)集補(bǔ)充三維數(shù)據(jù)集,可以緩解訓(xùn)練數(shù)據(jù)多樣性不足的問題。

參考文獻(xiàn): 1.基于深度學(xué)習(xí)的三維重建算法綜述https://zhuanlan.zhihu.com/p/108198728

2.一張照片獲得3D人體信息,云從科技提出新型DenseBody框架

https://zhuanlan.zhihu.com/p/61454340

3.CVPR 2020 | VIBE: 基于視頻的人體3D形狀和姿態(tài)估計(jì)

https://zhuanlan.zhihu.com/p/133492544

4.3D人體姿態(tài)估計(jì)筆記

https://zhuanlan.zhihu.com/p/113024569

5.SMPL, SMAL, SMALR, SMALST--單圖像的人體+動物三維重建論文https://blog.csdn.net/Oblivior/article/details/101024958

雙一流大學(xué)研究生團(tuán)隊(duì)創(chuàng)建,專注于目標(biāo)檢測與深度學(xué)習(xí),希望可以將分享變成一種習(xí)慣! 整理不易,點(diǎn)贊 三連↓

和

和 ),直接學(xué)習(xí)出人體的體素(Voxel)等以及學(xué)習(xí)texture-to-surface的correspondences(如UV map)。

),直接學(xué)習(xí)出人體的體素(Voxel)等以及學(xué)習(xí)texture-to-surface的correspondences(如UV map)。