圖解 | 深度學(xué)習(xí):小白看得懂的BERT原理

來(lái)源:計(jì)算機(jī)視覺(jué)與機(jī)器學(xué)習(xí) 作者丨Jay Alammar

鏈接丨h(huán)ttps://jalammar.github.io/illustrated-bert/

本文約4600字,建議閱讀8分鐘

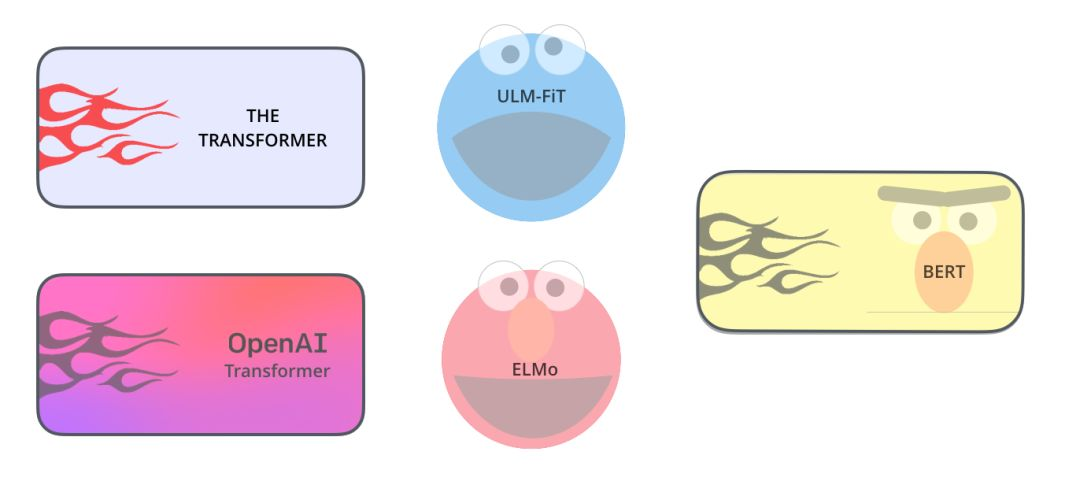

本文中,我們將研究BERT模型,理解它的工作原理,對(duì)于其他領(lǐng)域的同學(xué)也具有很大的參考價(jià)值。

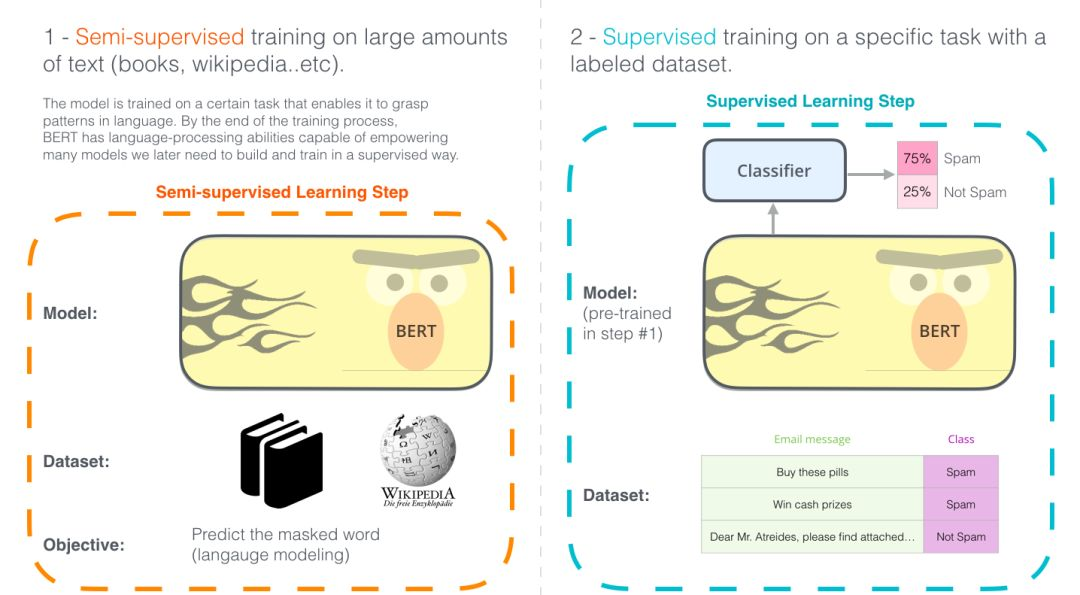

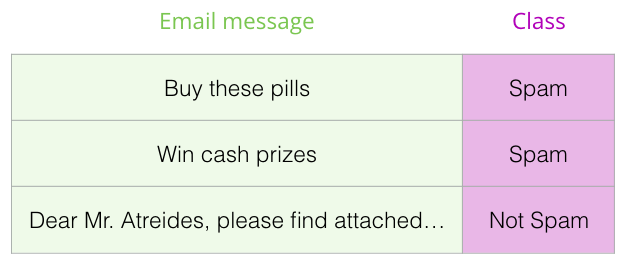

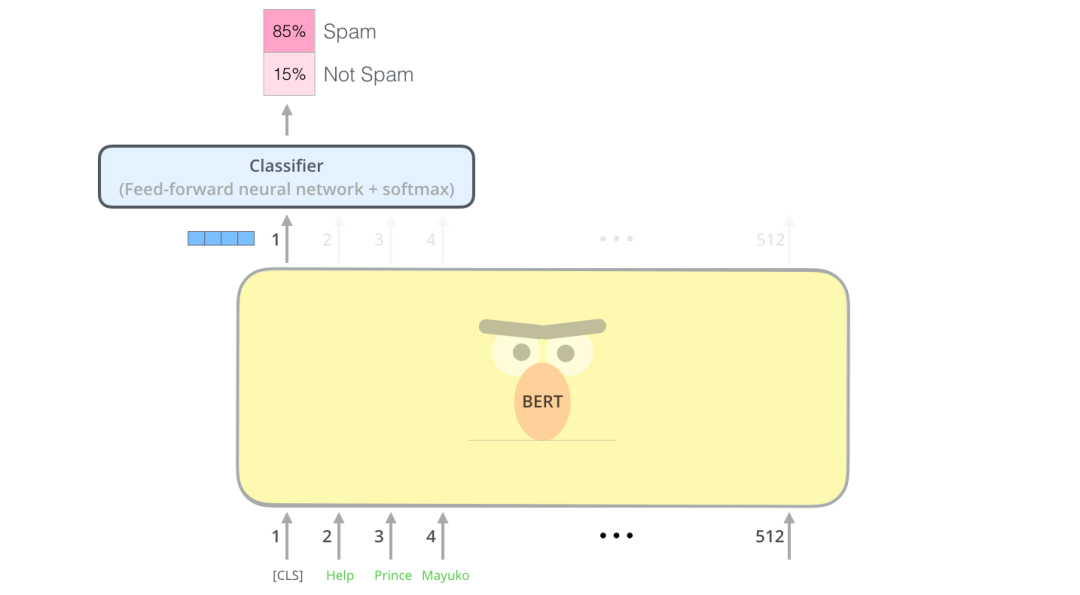

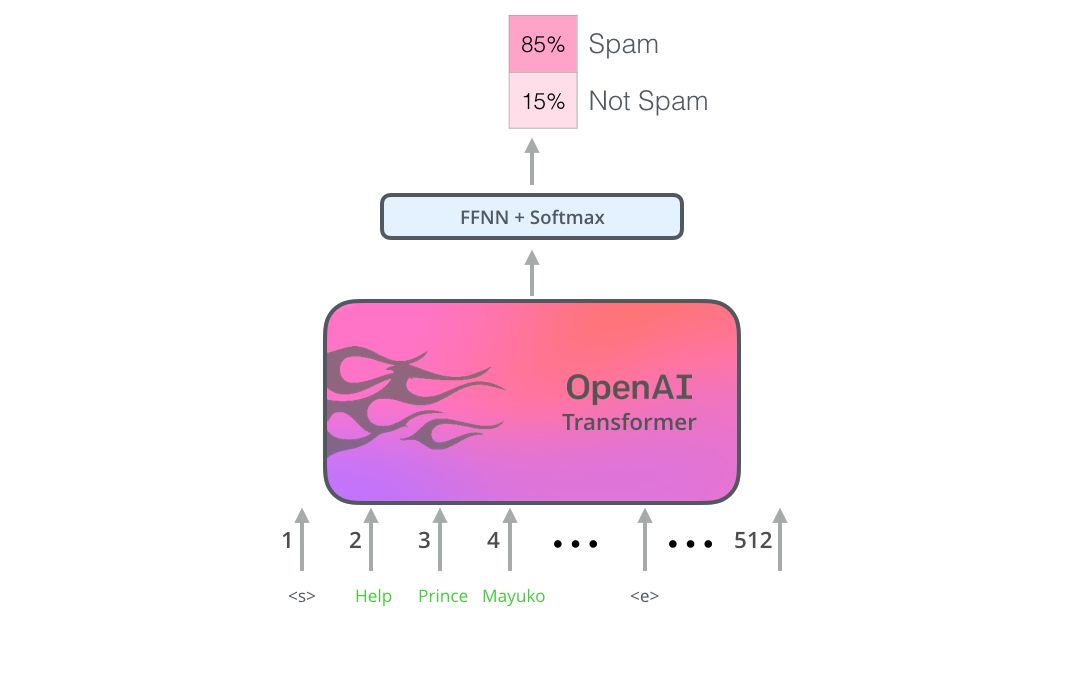

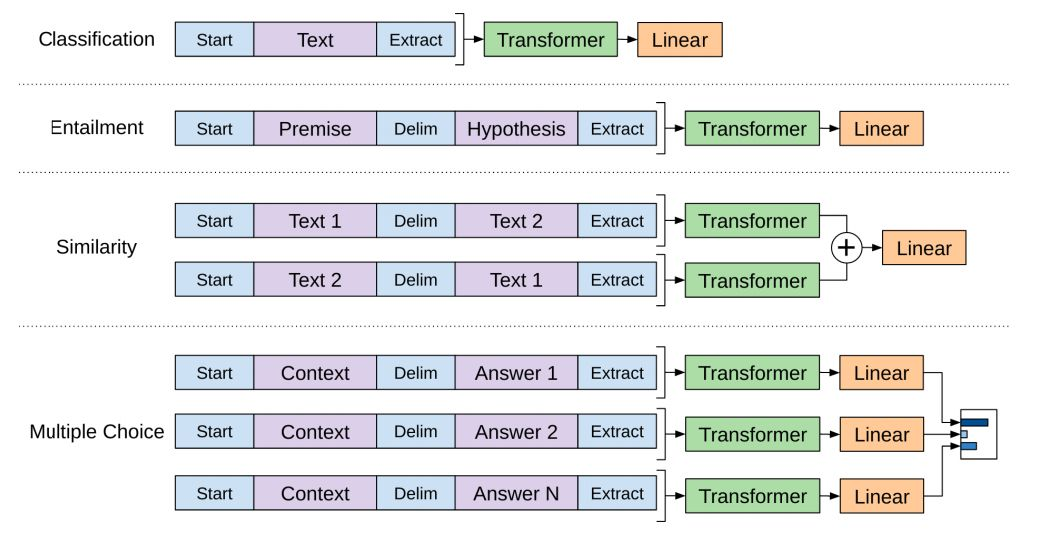

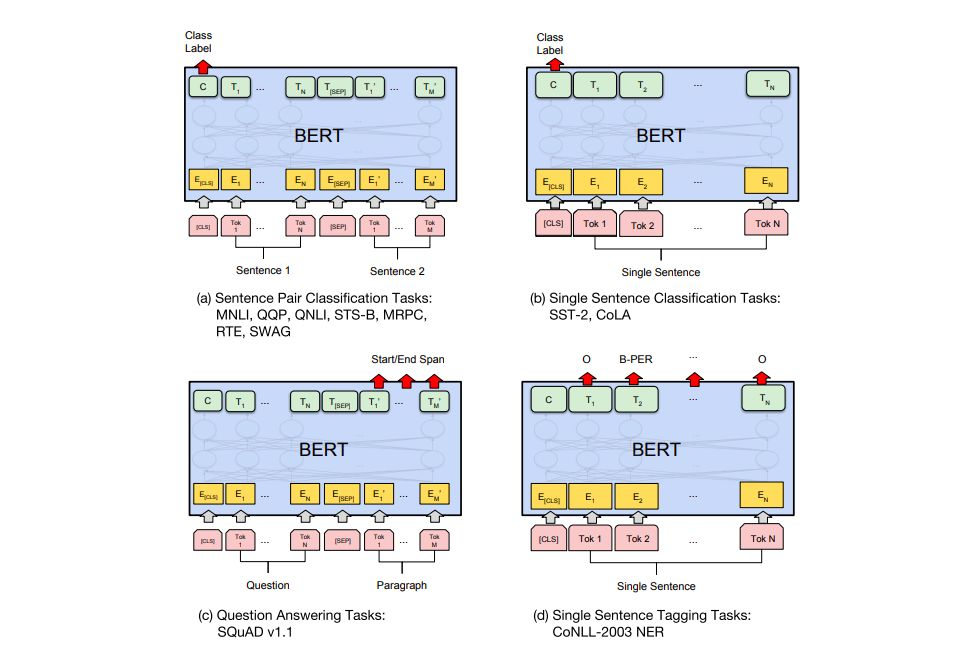

使用BERT最簡(jiǎn)單的方法就是做一個(gè)文本分類模型,這樣的模型結(jié)構(gòu)如下圖所示:

示例數(shù)據(jù)集:SST

事實(shí)查證

輸入:句子。輸出:“索賠”或“不索賠”

更雄心勃勃/未來(lái)主義的例子:

輸入:句子。輸出:“真”或“假”

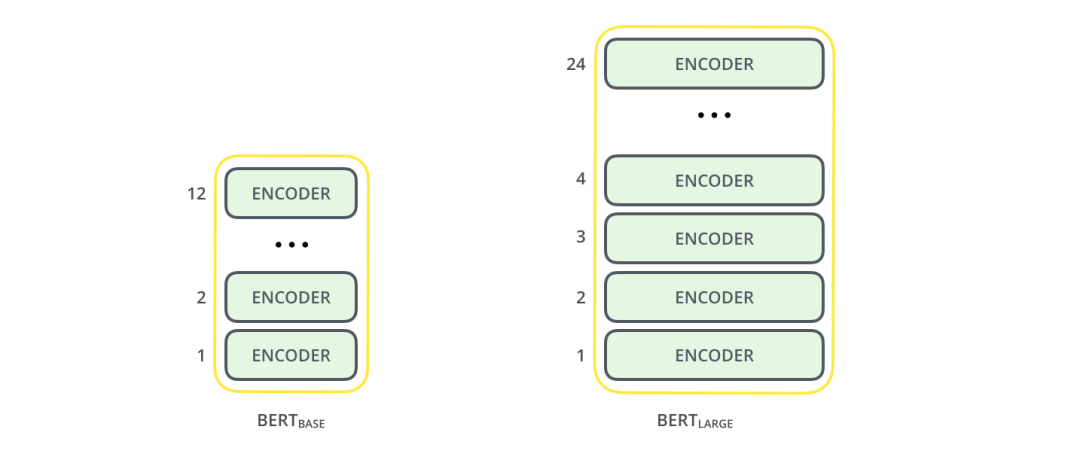

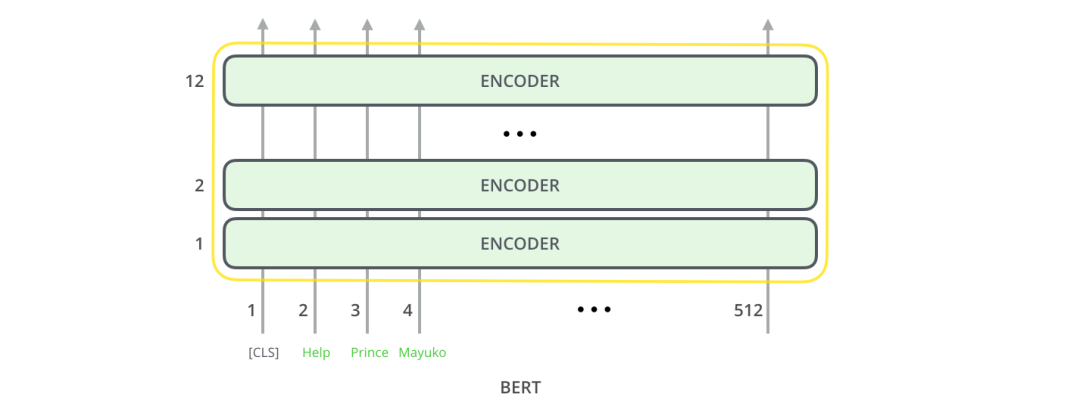

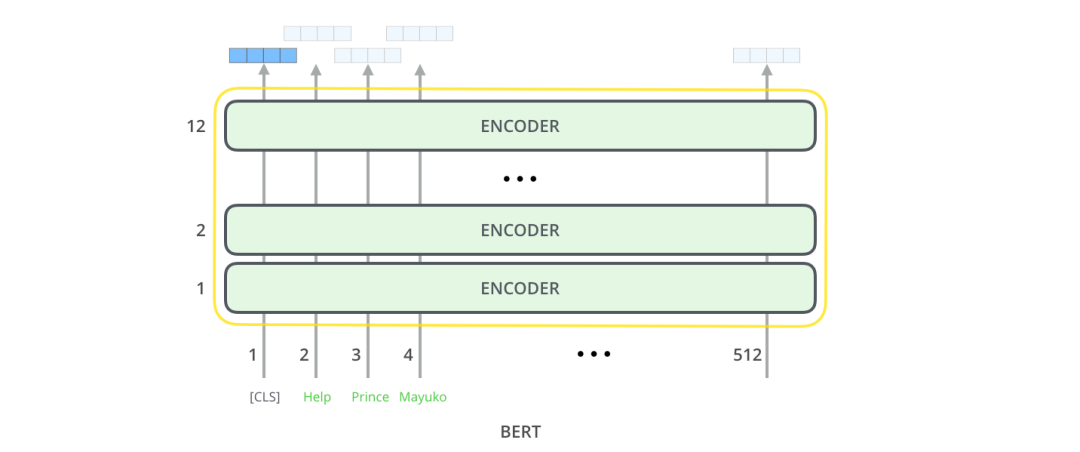

BERT BASE - 與OpenAI Transformer的尺寸相當(dāng),以便比較性能 BERT LARGE - 一個(gè)非常龐大的模型,它完成了本文介紹的最先進(jìn)的結(jié)果。

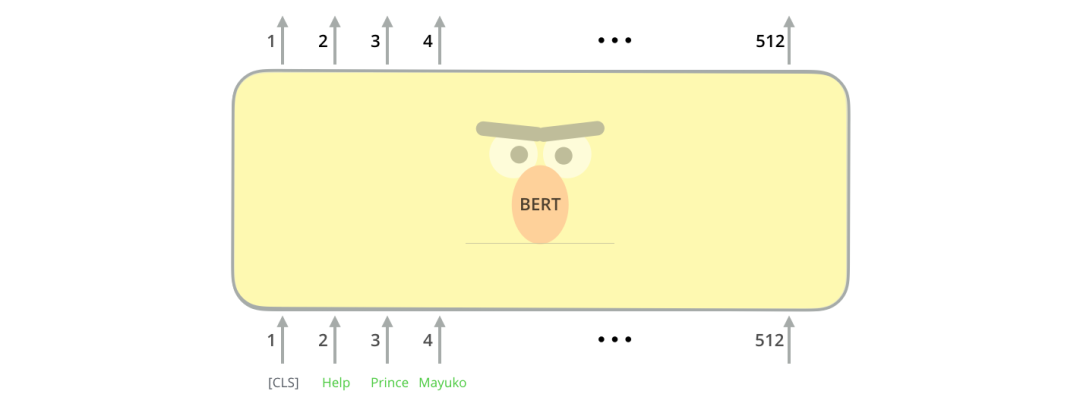

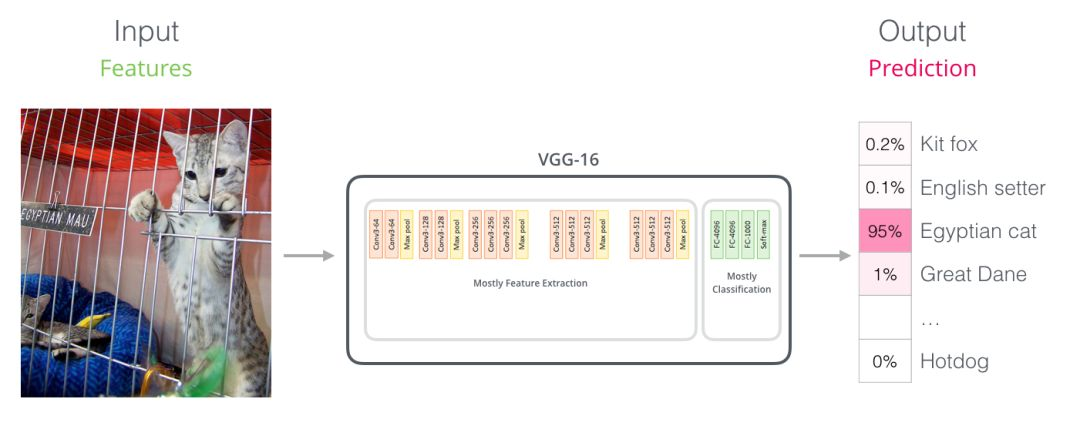

對(duì)于那些具有計(jì)算機(jī)視覺(jué)背景的人來(lái)說(shuō),這個(gè)矢量切換應(yīng)該讓人聯(lián)想到VGGNet等網(wǎng)絡(luò)的卷積部分與網(wǎng)絡(luò)末端的完全連接的分類部分之間發(fā)生的事情。你可以這樣理解,實(shí)質(zhì)上這樣理解也很方便。

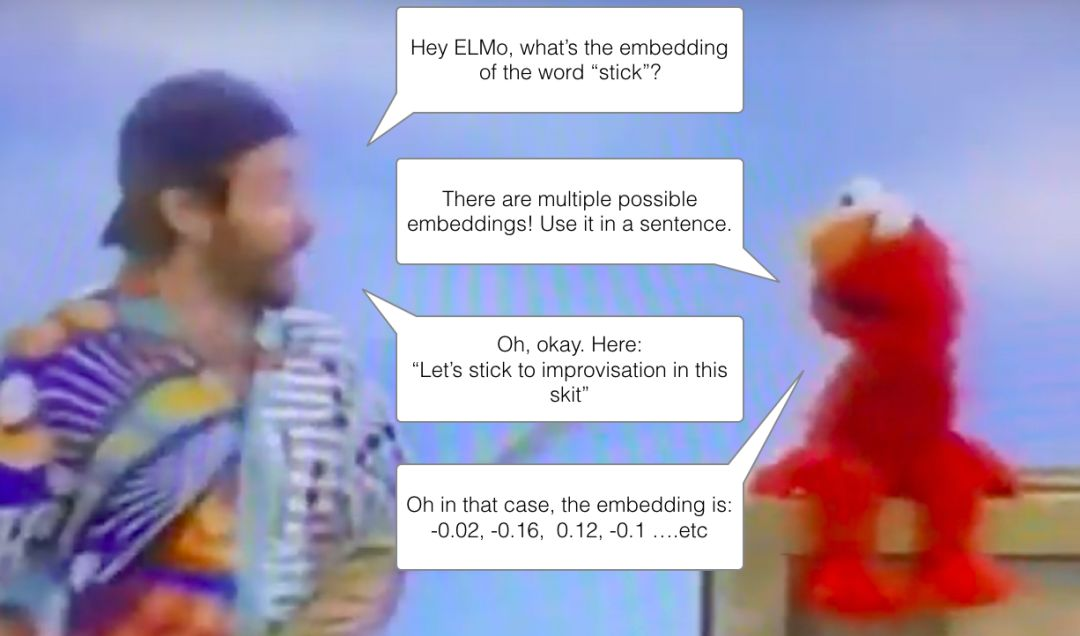

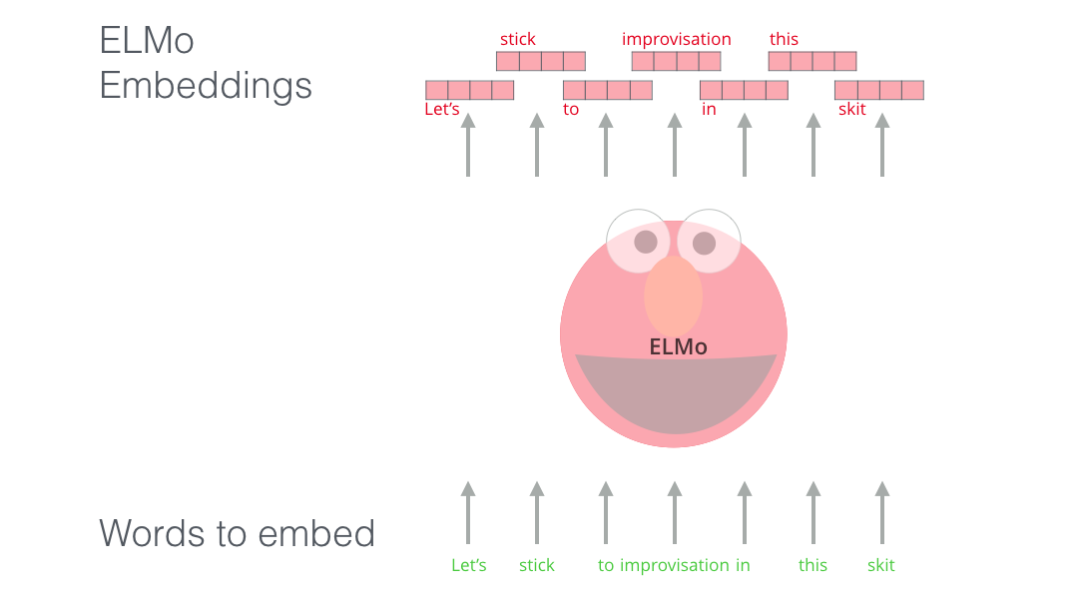

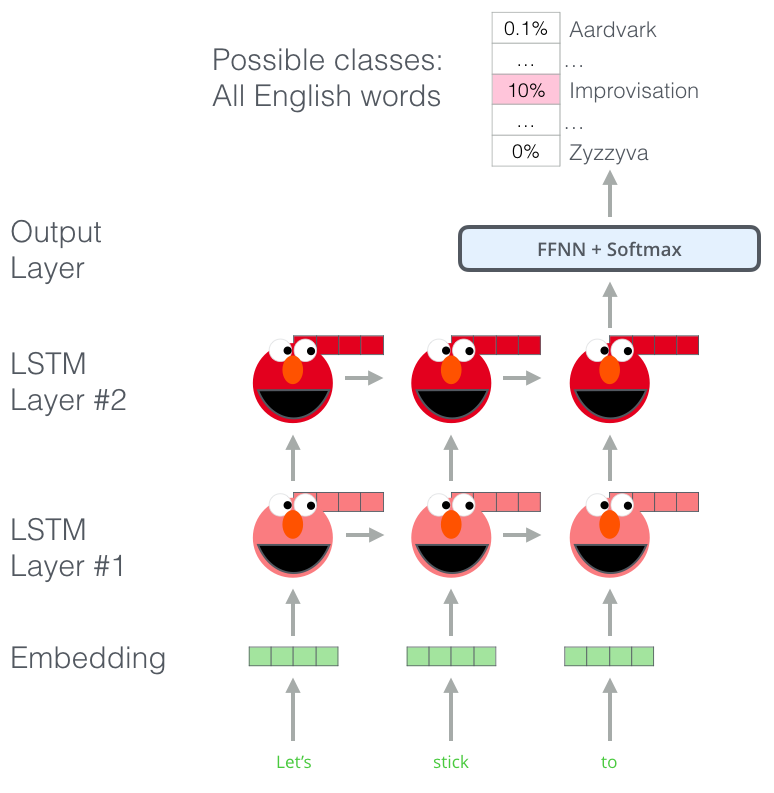

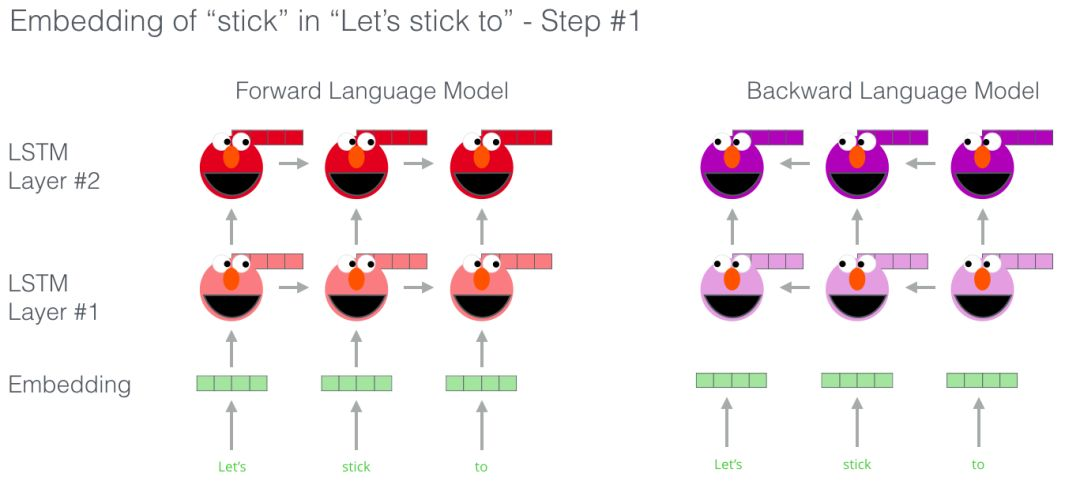

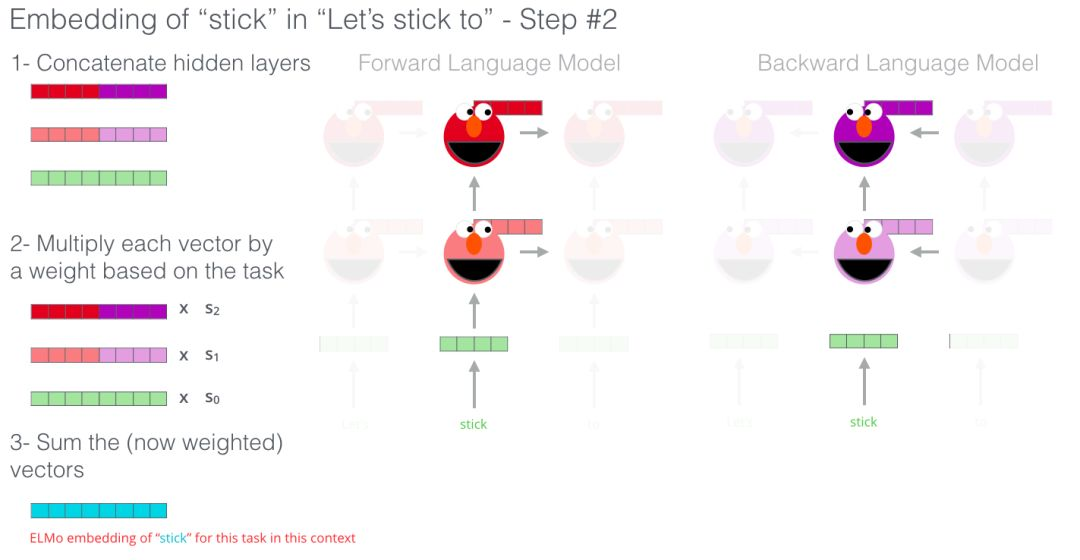

詞嵌入的新時(shí)代?

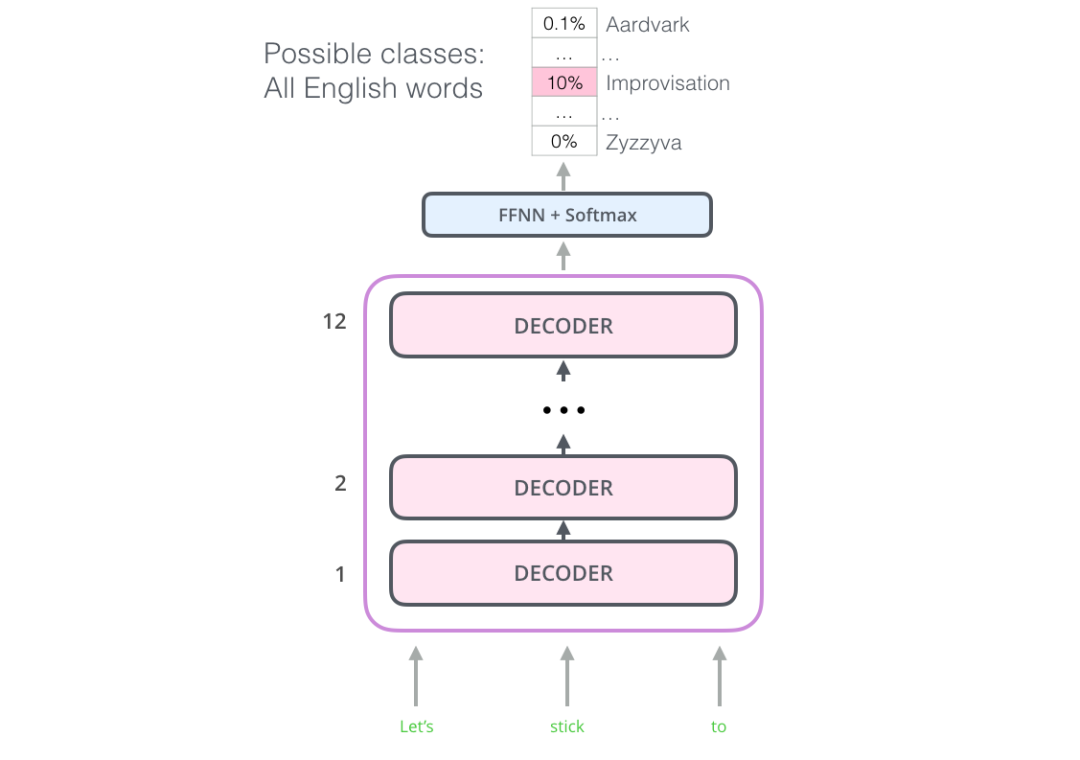

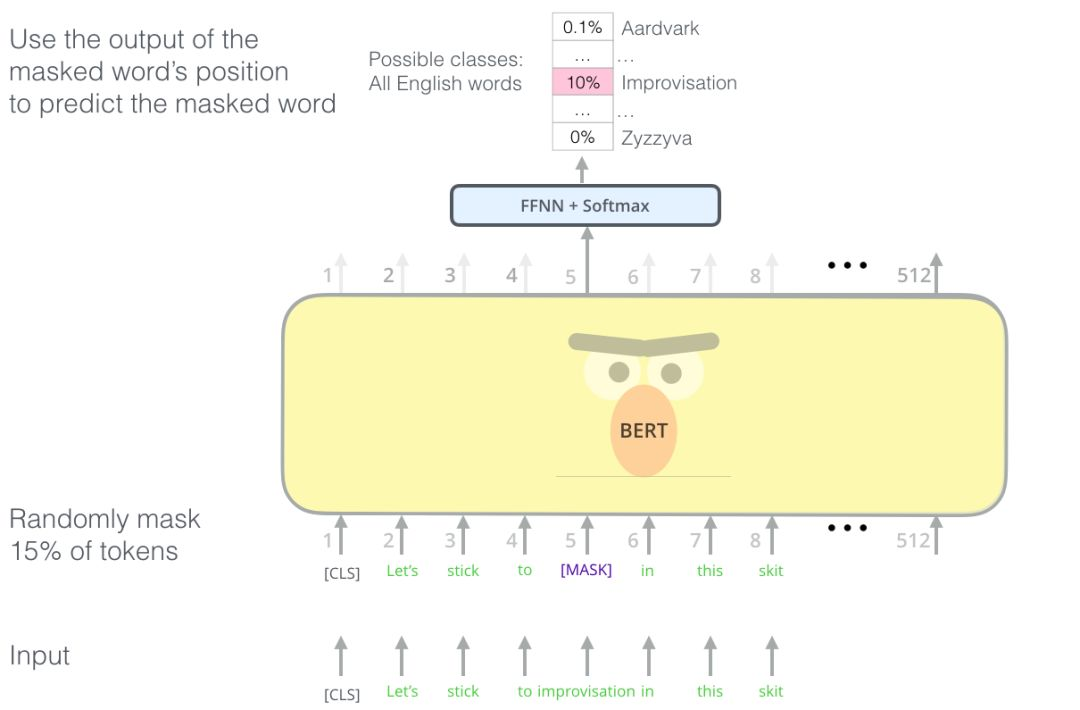

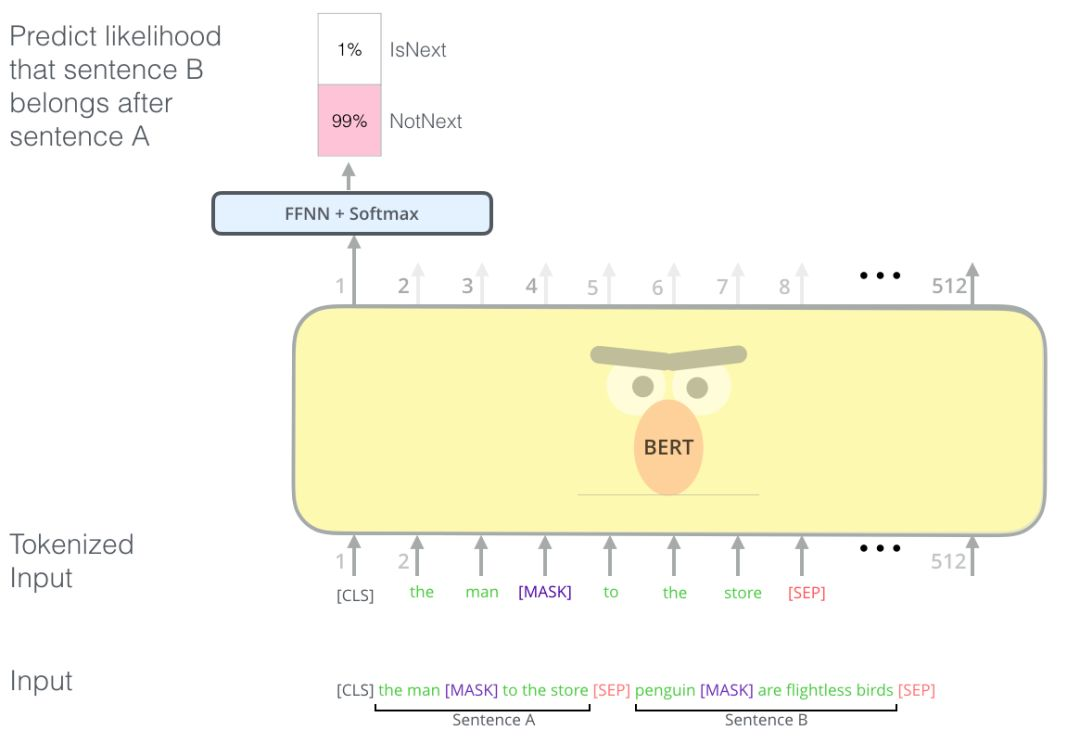

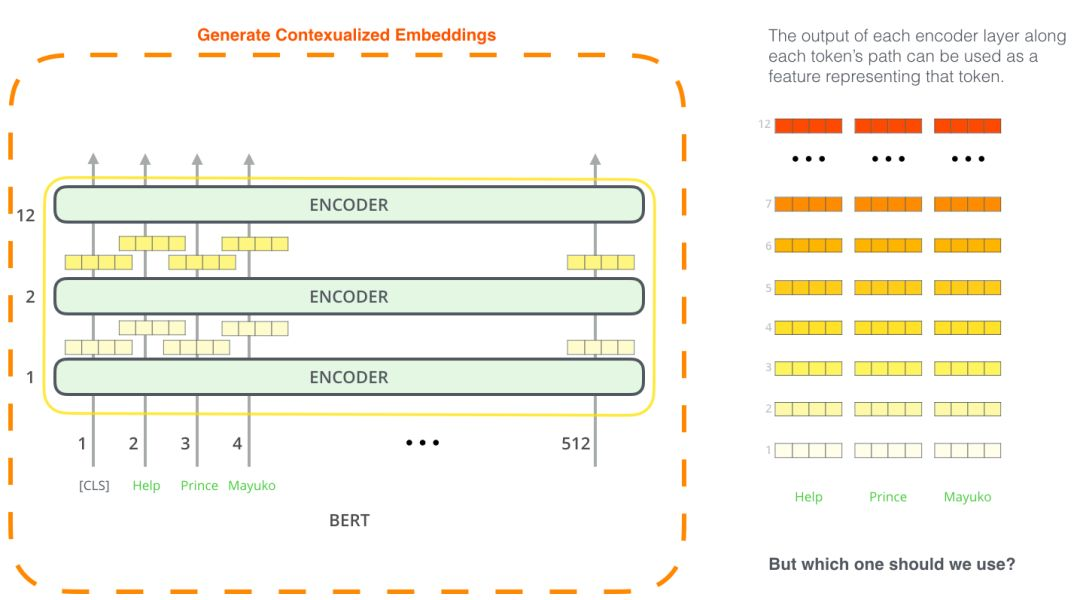

BERT說(shuō):“我要用 transformer 的 encoders”

短文本相似 文本分類 QA機(jī)器人 語(yǔ)義標(biāo)注

評(píng)論

圖片

表情