Soft-Masked BERT 一種新的中文糾錯(cuò)模型

向AI轉(zhuǎn)型的程序員都關(guān)注了這個(gè)號??????

人工智能大數(shù)據(jù)與深度學(xué)習(xí) 公眾號:datayx

今年,字節(jié)AI-Lab與復(fù)旦大學(xué)合作提出了一種中文文本糾錯(cuò)模型:Soft-Masked BERT[1].這項(xiàng)工作發(fā)表在了ACL 2020上,由于論文并沒有開源代碼,所以我將對這篇論文進(jìn)行解讀與復(fù)現(xiàn)。

問題提出:

中文文本糾錯(cuò)是一項(xiàng)挑戰(zhàn)性的任務(wù),因?yàn)槟P鸵氆@得令人滿意的解決方案,就必須具備人類水平的語言理解能力。比如:

eg1 Wrong:埃及有金子塔。Correct: 埃及有金字塔。

eg2 Wrong: 他的求勝欲很強(qiáng),為了越獄在挖洞。Correct: 他的求生欲很強(qiáng),為了越獄在挖洞。

eg3 Wrong: 他主動拉了姑娘的手, 心里很高心。Correct: 他主動拉了姑娘的手, 心里很高興。

在Soft-Masked BERT被提出之前,最好的方法是先通過在句子的每個(gè)位置建立基于BERT的語言表示模型,再從候選字符列表中選擇一個(gè)字符進(jìn)行修正。然而,BERT使用了mask的方式進(jìn)行預(yù)訓(xùn)練,沒有足夠的能力來檢測每個(gè)位置是否存在誤差(只有15%的錯(cuò)誤被找出),所以這種方法的精度不夠好。

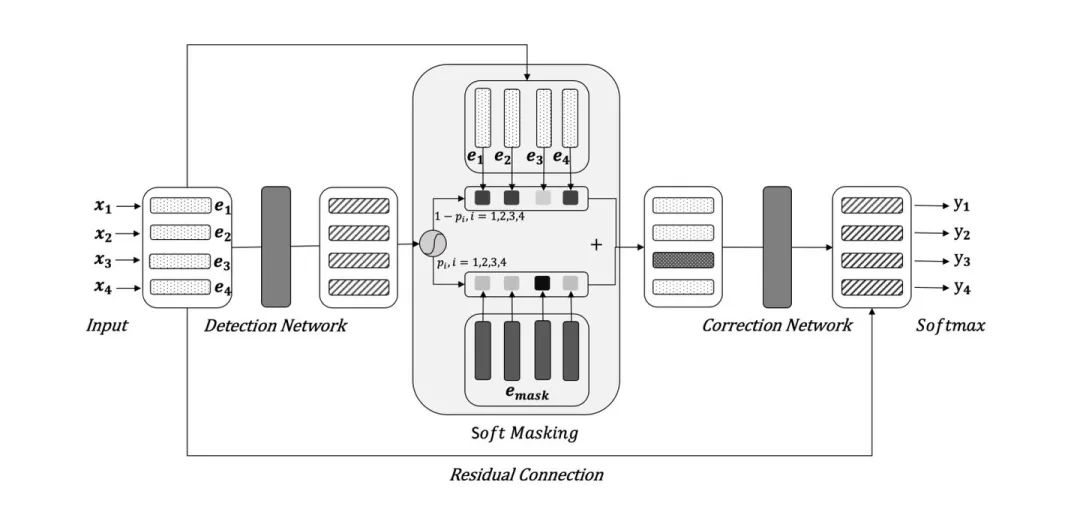

Soft-Masked BERT解決方案:

使用兩個(gè)網(wǎng)絡(luò)模型,一個(gè)用于錯(cuò)誤檢測;另一個(gè)基于BERT進(jìn)行糾錯(cuò)。

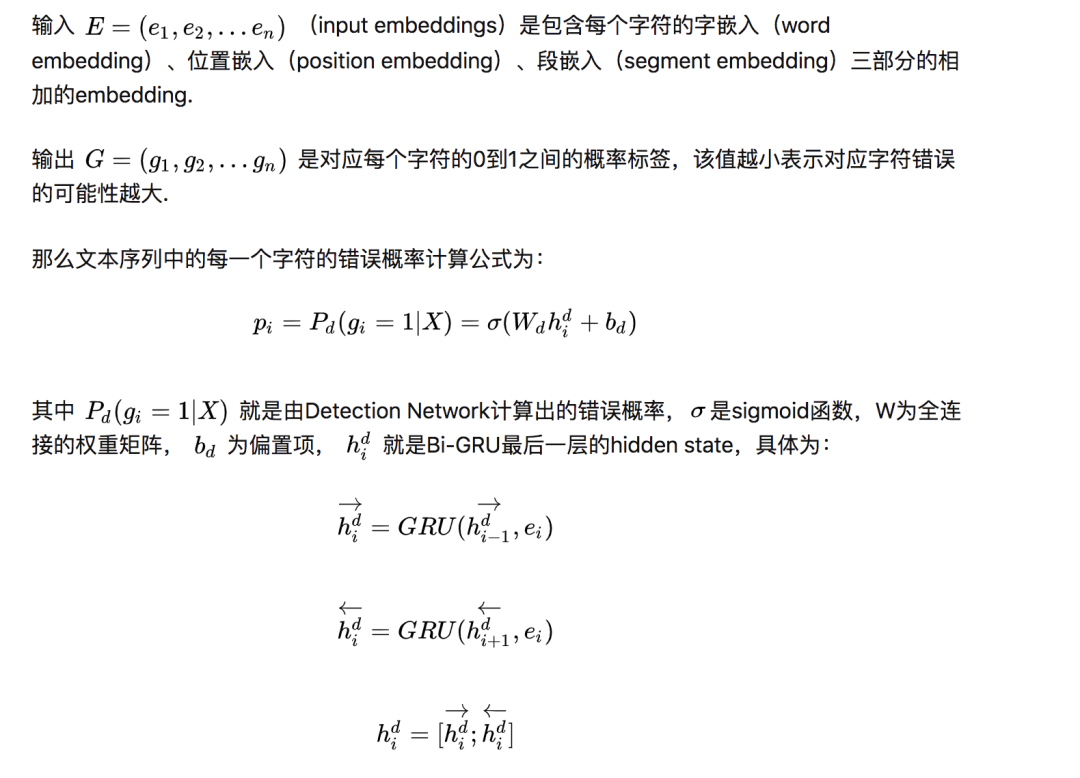

Detection Network

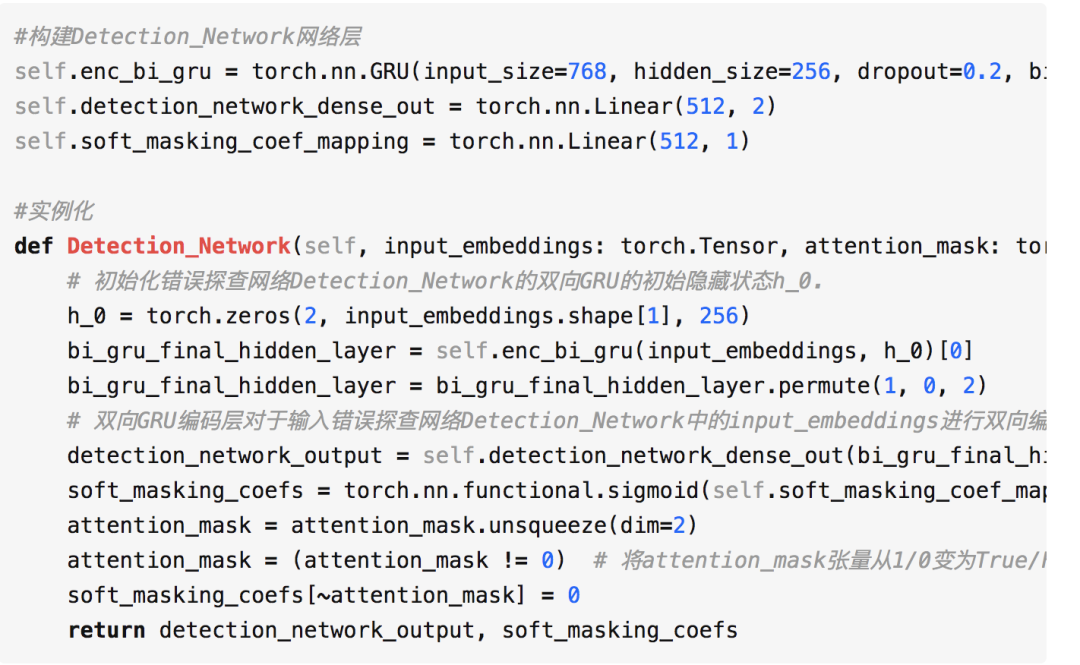

Detection Network通過雙向的GRU來實(shí)現(xiàn):

構(gòu)建Detection_Network中的網(wǎng)絡(luò)層與實(shí)例化代碼:

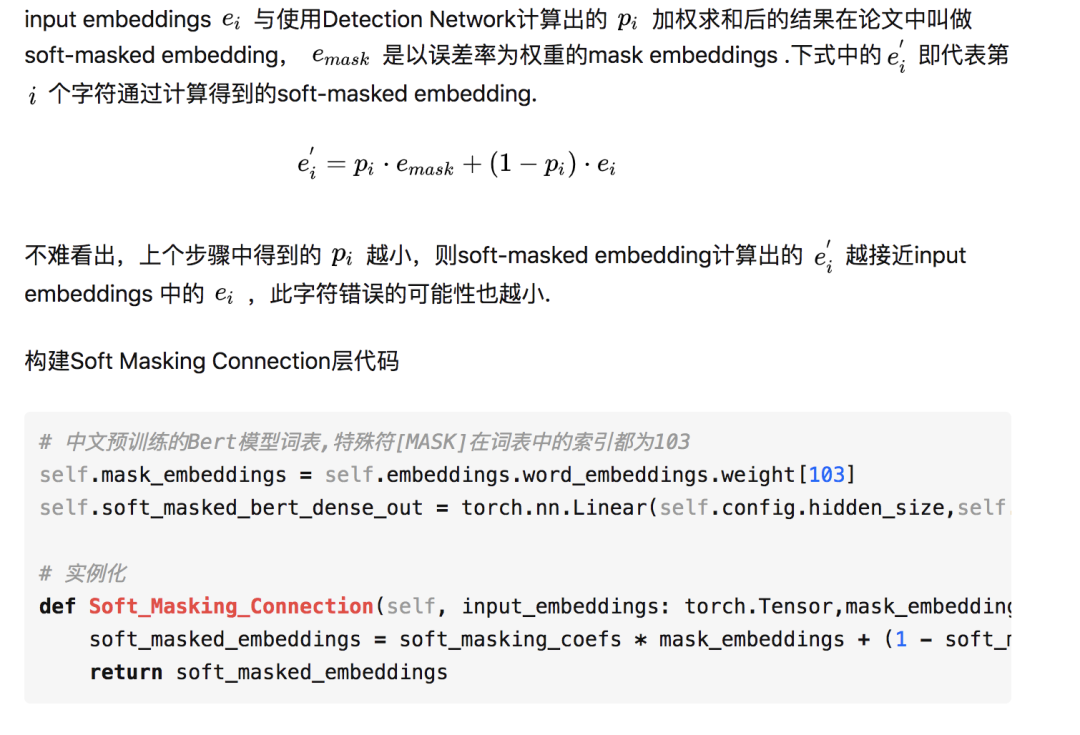

Soft Masking Connection

Correction Network

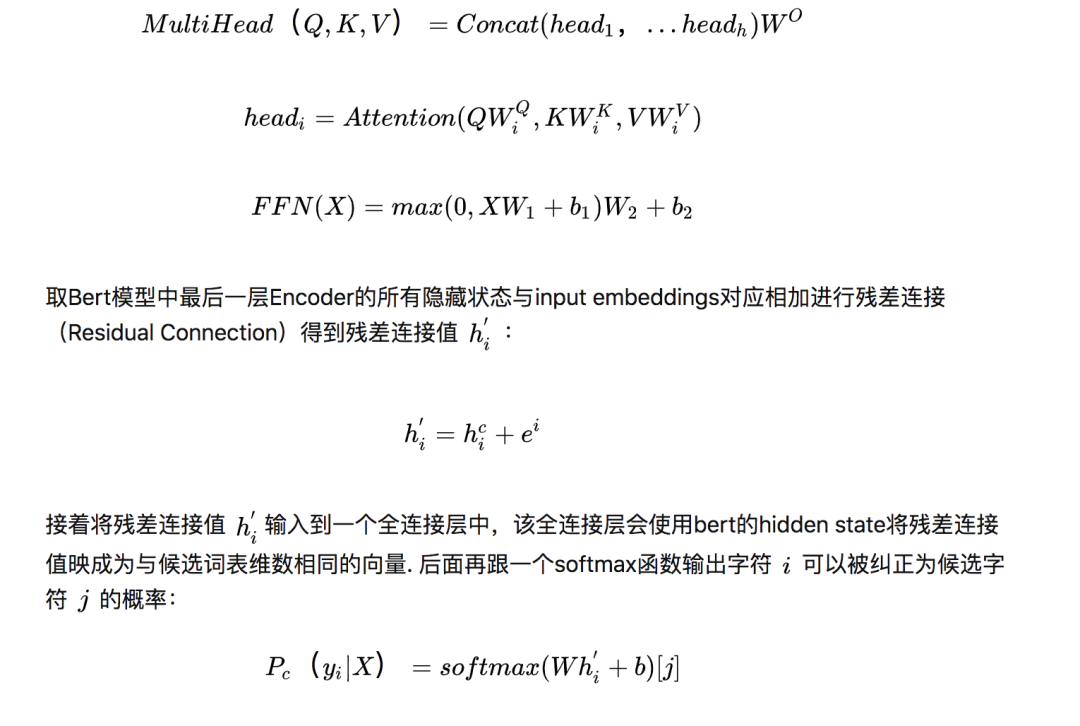

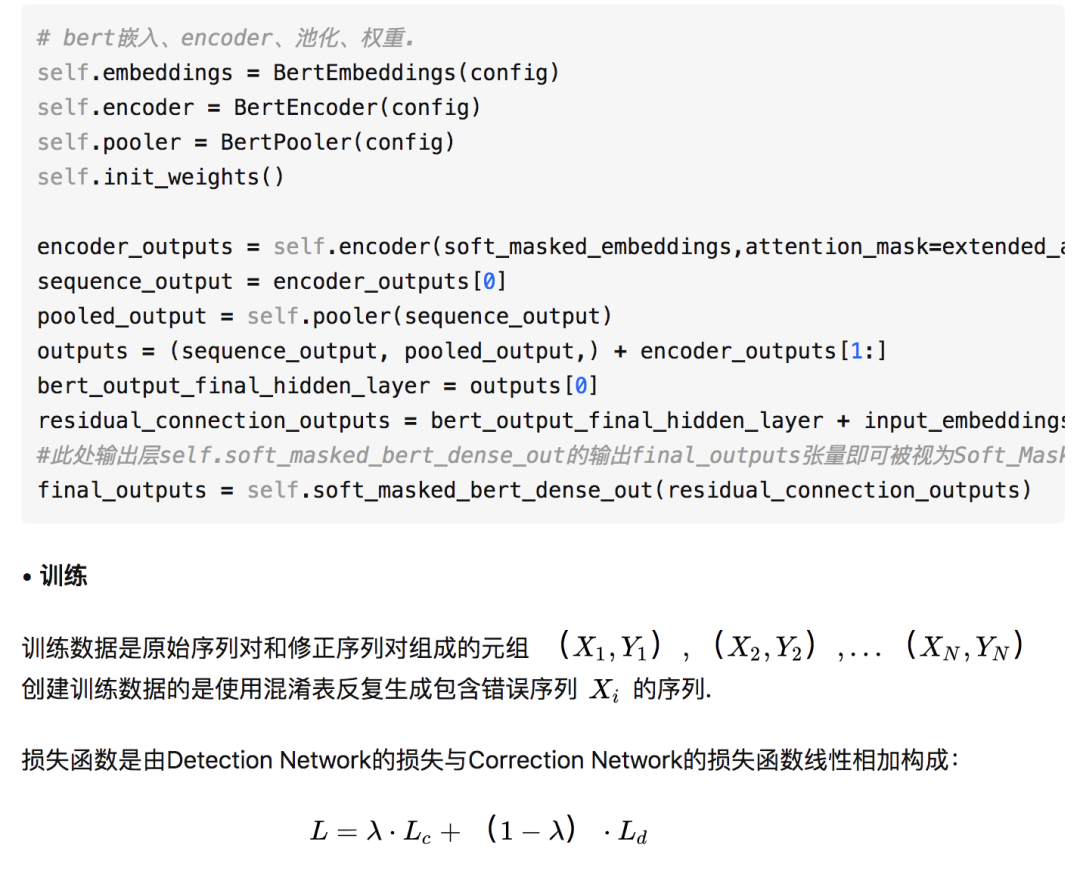

該層主要的結(jié)構(gòu)就是Bert模型,其中有12個(gè)Encoder層,以整個(gè)序列作為輸入。每個(gè)block包含一個(gè)多頭部的self-attention操作,然后接一個(gè)前饋網(wǎng)絡(luò):

實(shí)驗(yàn)結(jié)果

論文中使用的數(shù)據(jù)集有3個(gè):

Chinese Spelling Check Task(CSC)數(shù)據(jù)集:選擇了其中《對外漢語測試》的作文部分(SIGHAN);

News Title數(shù)據(jù)集:來自于今日頭條app中的文章的標(biāo)題部分;

5 million news titles數(shù)據(jù)集:從一些中文新聞app中爬取,該數(shù)據(jù)集只用來fine-tuning

其中公開數(shù)據(jù)集為Chinese Spelling Check Task數(shù)據(jù)集[2],包含1100個(gè)文本和461種錯(cuò)誤(字符級別).

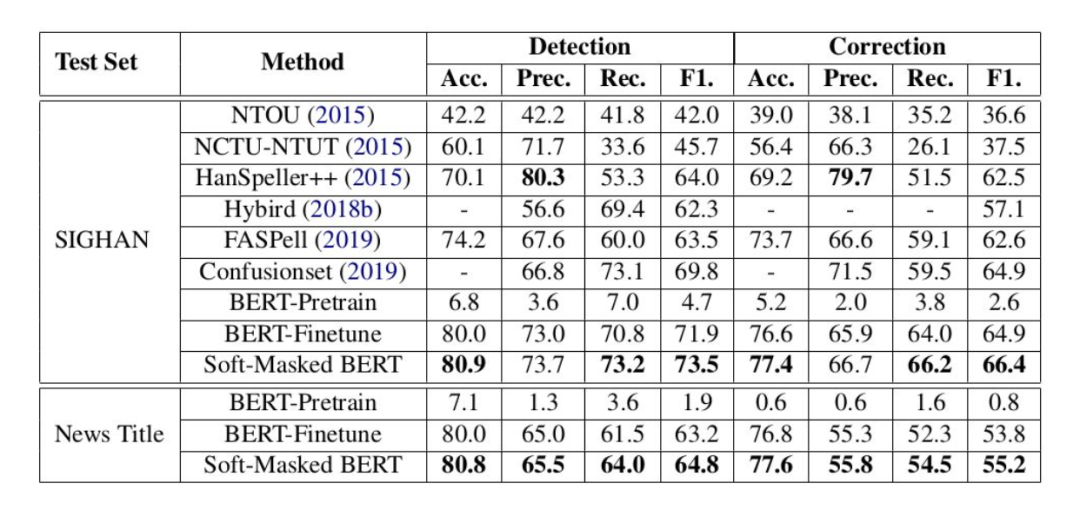

可以看出,在CSC數(shù)據(jù)集的測試中,Soft-Masked BERT模型的效果基本上都是比其他Baseline模型的效果要好。

而在Detection部分,HanSpeller++模型的精準(zhǔn)率要高于Soft-Masked BERT模型的精準(zhǔn)率,且Correction部分HanSpeller++模型的精準(zhǔn)率也高于Soft-Masked BERT模型的精準(zhǔn)率.

這是因?yàn)镠anSpeller++模型中有許多人工添加的規(guī)則與特征,這些人工添加的規(guī)則與特征能在Detection部分過濾錯(cuò)誤的識別,雖然這種人工規(guī)則與特征效果很好,但這種方式需要很多人工成本,而且泛化性也不好.

綜上,在SIGHAN數(shù)據(jù)集的測試集上,Soft-Masked BERT模型的效果是最優(yōu)的。

此外作者還用實(shí)驗(yàn)證明了:

fine-tuning的數(shù)據(jù)集(在5 million news titles數(shù)據(jù)集上)的規(guī)模越大,fine-tuning之后的模型在CSC任務(wù)中的效果也會越好;

消融對比研究,證明該提出的模型每一部分都是不可或缺的.

關(guān)于以上內(nèi)容:

完整代碼以及更詳細(xì)的注釋(一行代碼三行注釋)已上傳到github

代碼 獲取方式:

分享本文到朋友圈

關(guān)注微信公眾號 datayx 然后回復(fù) 糾錯(cuò) 即可獲取。

AI項(xiàng)目體驗(yàn)地址 https://loveai.tech

參考

^[1] https://arxiv.org/pdf/2005.07421.pdf

^http://ir.itc.ntnu.edu.tw/lre/sighan7csc.html

^https://github.com/shibing624/pycorrector

^https://zhuanlan.zhihu.com/p/164873441

閱讀過本文的人還看了以下文章:

TensorFlow 2.0深度學(xué)習(xí)案例實(shí)戰(zhàn)

基于40萬表格數(shù)據(jù)集TableBank,用MaskRCNN做表格檢測

《基于深度學(xué)習(xí)的自然語言處理》中/英PDF

Deep Learning 中文版初版-周志華團(tuán)隊(duì)

【全套視頻課】最全的目標(biāo)檢測算法系列講解,通俗易懂!

《美團(tuán)機(jī)器學(xué)習(xí)實(shí)踐》_美團(tuán)算法團(tuán)隊(duì).pdf

《深度學(xué)習(xí)入門:基于Python的理論與實(shí)現(xiàn)》高清中文PDF+源碼

python就業(yè)班學(xué)習(xí)視頻,從入門到實(shí)戰(zhàn)項(xiàng)目

2019最新《PyTorch自然語言處理》英、中文版PDF+源碼

《21個(gè)項(xiàng)目玩轉(zhuǎn)深度學(xué)習(xí):基于TensorFlow的實(shí)踐詳解》完整版PDF+附書代碼

《深度學(xué)習(xí)之pytorch》pdf+附書源碼

PyTorch深度學(xué)習(xí)快速實(shí)戰(zhàn)入門《pytorch-handbook》

【下載】豆瓣評分8.1,《機(jī)器學(xué)習(xí)實(shí)戰(zhàn):基于Scikit-Learn和TensorFlow》

《Python數(shù)據(jù)分析與挖掘?qū)崙?zhàn)》PDF+完整源碼

汽車行業(yè)完整知識圖譜項(xiàng)目實(shí)戰(zhàn)視頻(全23課)

李沐大神開源《動手學(xué)深度學(xué)習(xí)》,加州伯克利深度學(xué)習(xí)(2019春)教材

筆記、代碼清晰易懂!李航《統(tǒng)計(jì)學(xué)習(xí)方法》最新資源全套!

《神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)》最新2018版中英PDF+源碼

將機(jī)器學(xué)習(xí)模型部署為REST API

FashionAI服裝屬性標(biāo)簽圖像識別Top1-5方案分享

重要開源!CNN-RNN-CTC 實(shí)現(xiàn)手寫漢字識別

同樣是機(jī)器學(xué)習(xí)算法工程師,你的面試為什么過不了?

前海征信大數(shù)據(jù)算法:風(fēng)險(xiǎn)概率預(yù)測

【Keras】完整實(shí)現(xiàn)‘交通標(biāo)志’分類、‘票據(jù)’分類兩個(gè)項(xiàng)目,讓你掌握深度學(xué)習(xí)圖像分類

VGG16遷移學(xué)習(xí),實(shí)現(xiàn)醫(yī)學(xué)圖像識別分類工程項(xiàng)目

特征工程(二) :文本數(shù)據(jù)的展開、過濾和分塊

如何利用全新的決策樹集成級聯(lián)結(jié)構(gòu)gcForest做特征工程并打分?

Machine Learning Yearning 中文翻譯稿

斯坦福CS230官方指南:CNN、RNN及使用技巧速查(打印收藏)

python+flask搭建CNN在線識別手寫中文網(wǎng)站

中科院Kaggle全球文本匹配競賽華人第1名團(tuán)隊(duì)-深度學(xué)習(xí)與特征工程

不斷更新資源

深度學(xué)習(xí)、機(jī)器學(xué)習(xí)、數(shù)據(jù)分析、python

搜索公眾號添加: datayx

機(jī)大數(shù)據(jù)技術(shù)與機(jī)器學(xué)習(xí)工程

搜索公眾號添加: datanlp

長按圖片,識別二維碼