【論文推薦】張笑欽團隊 | 綜述:基于深度學(xué)習(xí)的視覺跟蹤方法進展

人眼可以比較輕松地在一段時間內(nèi)持續(xù)定位特定目標(biāo),而在計算機視覺領(lǐng)域,這一任務(wù)便是高級計算機任務(wù)之一——"目標(biāo)跟蹤"。但對計算機而言,在不同場景下實現(xiàn)目標(biāo)跟蹤任務(wù)是一件較為困難的事情,尤其在跟蹤目標(biāo)發(fā)生劇烈形變、被其他目標(biāo)遮擋或出現(xiàn)相似物體干擾等復(fù)雜情況下。因此,在計算機視覺領(lǐng)域,目標(biāo)跟蹤(特指單目標(biāo)跟蹤)是指:給出目標(biāo)在跟蹤視頻第一幀中的初始狀態(tài)(如位置,尺寸),自動估計目標(biāo)物體在后續(xù)幀中的狀態(tài)和移動軌跡。近年來,深度學(xué)習(xí)方法開始在目標(biāo)跟蹤領(lǐng)域嶄露頭角,并逐漸在性能上超越傳統(tǒng)方法。溫州大學(xué)人工智能與計算機學(xué)院院長張笑欽教授團隊綜述了基于深度學(xué)習(xí)的視覺跟蹤方法進展,相關(guān)成果已發(fā)表于IJAC,全文免費下載!

圖片來自Springer (點擊上圖下載全文)

什么是"單目標(biāo)跟蹤"?如下圖所示,三張圖片分別是同一視頻的第1、第40和第80幀。在第1幀給出一個跑步者的邊框之后,后續(xù)的第40幀、第80幀,邊框依然準(zhǔn)確對同一個跑步者進行框定。以上展示的其實就是目標(biāo)跟蹤(visual object tracking)的過程。也就是說,目標(biāo)跟蹤(特指單目標(biāo)跟蹤)是指:給出目標(biāo)在跟蹤視頻第一幀中的初始狀態(tài)(如位置,尺寸),自動估計目標(biāo)物體在后續(xù)幀中的狀態(tài)。

圖片來自網(wǎng)絡(luò)

圖片來自網(wǎng)絡(luò)

單目標(biāo)跟蹤(Single object tracking)是計算機視覺和視頻處理領(lǐng)域一項基本且關(guān)鍵的任務(wù),其在導(dǎo)航、機器人、交通控制和增強現(xiàn)實等行業(yè)中應(yīng)用十分廣泛。因此,不少研究者致力于解決單目標(biāo)跟蹤任務(wù)衍生的各種挑戰(zhàn),試圖開發(fā)出有效的跟蹤算法。然而,由于難以平衡跟蹤算法的準(zhǔn)確性和高效性,這項任務(wù)仍然十分具有挑戰(zhàn)性。此外,現(xiàn)有算法在復(fù)雜場景下(如背景雜波、運動模糊、視點變化、光照變化等)的魯棒性也是一個亟需研究的熱點問題。

單目標(biāo)跟蹤旨在從視頻的所有幀中定位一個特定目標(biāo)。為此,跟蹤算法通常是從目標(biāo)外觀模板(template of target appearance)和搜索框(search frame)中提取一定特征,然后對這些特征進行反復(fù)匹配來定位目標(biāo)。為了保留有效的目標(biāo)模板,在跟蹤過程中,目標(biāo)出現(xiàn)的初始幀所呈現(xiàn)的外觀將作為初始值(initialization),并不斷更新。而匹配框架(matching framework)則是在整個跟蹤過程中根據(jù)初始值等有效信息進行響應(yīng)。

因此,整個過程所提取的特征應(yīng)具有代表性,保證可準(zhǔn)確區(qū)分目標(biāo)和背景。傳統(tǒng)的跟蹤算法由于提取出來的特征不能全面反映目標(biāo)的特征,往往性能欠佳。據(jù)此,傳統(tǒng)跟蹤算法可從兩方面改進:一是尋找能夠更好反映目標(biāo)外觀(characteristics of the object)的特征(features),二是提出有效的匹配框架。例如,基于模板的(template-based)、基于子空間的(subspace-based)以及稀疏表示(sparse-representation)的方法會使用某些元素來表示目標(biāo),而不是直接使用裁剪的像素(cropped pixels)或圖像塊(image patches)來表示。諸如boosting、支持向量機(support vector machine)、隨機森林(random forest)、多示例學(xué)習(xí)(multiple instance learning)以及度量學(xué)習(xí)(metric learning)等框架也被用于提升跟蹤算法的匹配能力。

隨著深度學(xué)習(xí)機制(deep learning mechanisms)的發(fā)展,許多研究者著手開展計算機視覺、語音識別、自然語言處理等任務(wù)。在眾多突破的推動下,深度學(xué)習(xí)機制也被引入單目標(biāo)跟蹤任務(wù)中。同時,一些跟蹤數(shù)據(jù)集,如OTB-2013及VOT-2013相繼提出,用以測試與評價跟蹤算法的性能。

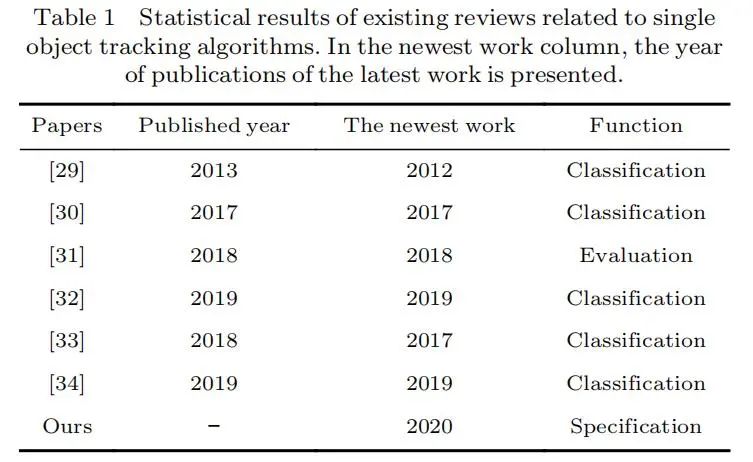

一些論文也回顧了基于深度學(xué)習(xí)的跟蹤算法的進展和挑戰(zhàn)。然而,數(shù)據(jù)統(tǒng)計結(jié)果顯示(見表1),這些論文都沒有綜述近期發(fā)表在頂級會議和期刊上的跟蹤方法。此外,現(xiàn)有的研究大多集中于根據(jù)深度跟蹤器的方法對其進行分類,或?qū)ζ湫阅苓M行評估。可以注意到,現(xiàn)有的綜述沒有詳細(xì)研究當(dāng)前深度跟蹤器的具體組成部分(details specific components)。

圖片來自文章

圖片來自文章

為促進基于深度學(xué)習(xí)的單目標(biāo)跟蹤算法的發(fā)展,本文總結(jié)了現(xiàn)有的基于深度學(xué)習(xí)的跟蹤算法的一般組成部分(general components),并介紹了深度神經(jīng)網(wǎng)絡(luò)的常用組成部分(popular components),以及提高深度神經(jīng)網(wǎng)絡(luò)的特征表征能力(representative ability of the features)。此外,本文通過收集和分析基準(zhǔn)數(shù)據(jù)集上的指標(biāo)來比較近期提出的深度跟蹤器(deep trackers)。通過這種方式,本文得出了一些重要的觀察結(jié)果。例如,通過比較,我們發(fā)現(xiàn)注意力機制(attention mechanisms)被廣泛用于在線更新方法(online-updating methods)和離線訓(xùn)練方法(offline-trained ones)的結(jié)合上。另一方面,由于深度跟蹤器中不同的組件有不同的特性,僅改進單個組件有時無法改進跟蹤過程。

本文其余部分組織如下:第二部分對有效深度學(xué)習(xí)方法的基本框架和新機制進行了列舉。第三部分介紹了深度跟蹤器的一般組件(general components)。第四部分詳細(xì)說明了常用的跟蹤數(shù)據(jù)集(popular tracking datasets),并進行了比較。本文還介紹了一些常用指標(biāo)(popular metrics),可在常用跟蹤數(shù)據(jù)集(popular tracking datasets)中評估跟蹤性能。第五部分基于這些指標(biāo),對近期發(fā)布的深度跟蹤器的性能進行了分析和比較。基于這些比較結(jié)果,第六部分給出了若干觀察結(jié)果。第七部分為本文結(jié)論。

Advances in Deep Learning Methods for Visual Tracking: Literature Review and Fundamentals

Xiao-Qin Zhang, Run-Hua Jiang, Chen-Xiang Fan, Tian-Yu Tong, Tao Wang, Peng-Cheng Huang

https://link.springer.com/article/10.1007/s11633-020-1274-8

http://www.ijac.net/en/article/doi/10.1007/s11633-020-1274-8

特別感謝論文作者:溫州大學(xué)張笑欽教授、蔣潤華同學(xué)、范晨翔同學(xué)、童天宇同學(xué)、王濤同學(xué)、黃鵬程同學(xué)對以上內(nèi)容的審閱和修改!

點擊"閱讀原文"下載全文