綜述 | 3D目標(biāo)檢測(cè):從數(shù)據(jù)集到2D和3D方法

點(diǎn)擊左上方藍(lán)字關(guān)注我們

轉(zhuǎn)載自 | 3D視覺(jué)工坊

1 前言

目標(biāo)檢測(cè)一直是計(jì)算機(jī)視覺(jué)領(lǐng)域中一大難題。近日,來(lái)自阿爾伯塔大學(xué)的研究者對(duì)目標(biāo)檢測(cè)領(lǐng)域的近期發(fā)展進(jìn)行了綜述,涵蓋常見(jiàn)數(shù)據(jù)格式和數(shù)據(jù)集、2D 目標(biāo)檢測(cè)方法和 3D 目標(biāo)檢測(cè)方法。

論文地址:https://arxiv.org/abs/2010.15614

目標(biāo)檢測(cè)任務(wù)的目標(biāo)是找到圖像中的所有感興趣區(qū)域,并確定這些區(qū)域的位置和類別。由于目標(biāo)具有許多不同的外觀、形狀和姿態(tài),再加上光線、遮擋和成像過(guò)程中其它因素的干擾,目標(biāo)檢測(cè)一直以來(lái)都是計(jì)算機(jī)視覺(jué)領(lǐng)域中一大挑戰(zhàn)性難題。

本文將概述性地總結(jié)一些當(dāng)前最佳的目標(biāo)檢測(cè)相關(guān)研究。第 2 節(jié)將簡(jiǎn)要介紹目標(biāo)檢測(cè)任務(wù)常用的數(shù)據(jù)格式,同時(shí)還會(huì)給出一些著名的數(shù)據(jù)集。

然后會(huì)概述一些預(yù)處理方法。第 3 節(jié)會(huì)介紹與 2D 目標(biāo)檢測(cè)相關(guān)的技術(shù),包括傳統(tǒng)方法和深度學(xué)習(xí)方法。最后第 4 節(jié)會(huì)概括性地討論 3D 目標(biāo)檢測(cè)這一主題。

2 數(shù)據(jù)格式

2.1 數(shù)據(jù)集

在計(jì)算機(jī)圖形學(xué)中,深度圖(Depth Map)是包含場(chǎng)景中目標(biāo)表面與視點(diǎn)之間距離信息的圖像或圖像通道。深度圖類似于灰度圖像,只不過(guò)深度圖中每個(gè)像素都是傳感器與目標(biāo)之間的實(shí)際距離。一般來(lái)說(shuō),RGB 圖像和深度圖是同時(shí)采集的,因此兩者的像素之間存在一一對(duì)應(yīng)關(guān)系。RGB-D 格式的數(shù)據(jù)集包括 Pascal VOC、COCO、ImageNet 等。

雷達(dá)數(shù)據(jù)對(duì)目標(biāo)檢測(cè)問(wèn)題也很有用。雷達(dá)數(shù)據(jù)的收集方式是:先向目標(biāo)表面發(fā)射聲波,然后使用反射信息來(lái)計(jì)算目標(biāo)的速度以及與目標(biāo)的距離。但是,僅靠雷達(dá)可無(wú)法收集到用于檢測(cè)和分類的信息,因此不同類型數(shù)據(jù)的融合是非常重要的。

點(diǎn)云數(shù)據(jù)是三維坐標(biāo)系中的一組向量。這些向量通常用 X、Y、Z 的三維坐標(biāo)表示,是一種常用的外表面形狀表示方式。不僅如此,除了由 (X,Y,Z) 表示的幾何位置信息之外,每個(gè)點(diǎn)云還可能包含 RGB 顏色像素、灰度值、深度和法線。大多數(shù)點(diǎn)云數(shù)據(jù)都由 3D 掃描設(shè)備生成,比如激光雷達(dá)(2D/3D)、立體相機(jī)和 TOF(飛行時(shí)間)相機(jī)。這些設(shè)備可自動(dòng)測(cè)量目標(biāo)表面上大量點(diǎn)的信息,然后以 .LAS 和 .LAZ 這兩種標(biāo)準(zhǔn)文件格式輸出點(diǎn)云。這些點(diǎn)云數(shù)據(jù)是由掃描設(shè)備采集的。在用于訓(xùn)練的數(shù)據(jù)集中,除了點(diǎn)云數(shù)據(jù),還有相應(yīng)的 RGB 圖像。這類數(shù)據(jù)集包括 KITTI [4]、nuScenes [5]、Waymo Open [6] 等。

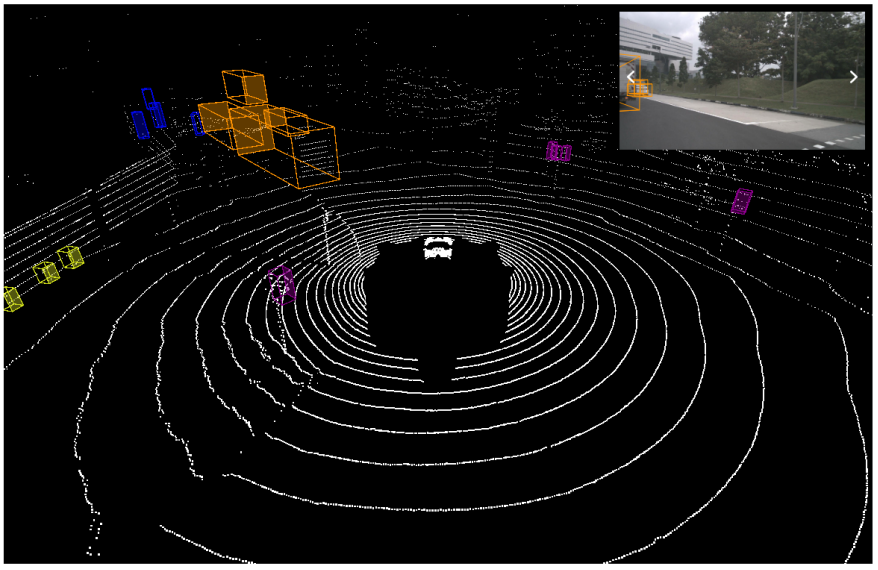

本文將使用 nuScenes 數(shù)據(jù)集來(lái)訓(xùn)練和評(píng)估模型。nuScenes 數(shù)據(jù)集來(lái)自 nuTonomy,是一個(gè)大規(guī)模自動(dòng)駕駛數(shù)據(jù)集,其中的數(shù)據(jù)進(jìn)行了 3D 目標(biāo)標(biāo)注。與其它很多數(shù)據(jù)集相比,nuScenes 數(shù)據(jù)集不僅規(guī)模更大,目標(biāo)標(biāo)注更多,而且還提供了整套傳感器套件,包括激光雷達(dá)、聲波雷達(dá)、GPS 和 IMU。圖 1 展示了 nuScenes 中一個(gè)激光雷達(dá)點(diǎn)云的示例。

圖 1:nuScenes 中的激光雷達(dá)點(diǎn)云示例。

2.2 預(yù)處理

盡管數(shù)據(jù)集中的圖像質(zhì)量很高,但在實(shí)際應(yīng)用中,天氣等因素都可能影響圖像的質(zhì)量,并因此降低檢測(cè)準(zhǔn)確率。近期提出的一些用于交通場(chǎng)景的去霧算法可以解決這類問(wèn)題。比如 [8] 提出了一種基于伽馬校正和引導(dǎo)濾波的去霧算法:先使用伽馬校正方法在去霧之前校正圖像,然后再在校正后圖像上執(zhí)行三種不同尺度的引導(dǎo)濾波過(guò)程,過(guò)濾后的圖像再使用 Retinex 模型修改,最后使用加權(quán)融合得到去霧的結(jié)果。通過(guò)此方法得到的去霧圖像具有更高的對(duì)比度和顏色一致性。Wang [9] 重點(diǎn)研究了如何解決霧濃度分布不均的問(wèn)題。根據(jù)波長(zhǎng)與霧濃度的關(guān)系,他們針對(duì)交通監(jiān)控圖像構(gòu)建了一個(gè)與波長(zhǎng)相關(guān)的物理成像模型。然后,再根據(jù)波長(zhǎng)與顏色的相關(guān)性,他們又基于最大模糊相關(guān)圖切割設(shè)計(jì)了一種透射率估計(jì)算法。

除了提升圖像質(zhì)量之外,人們也常使用相機(jī)校準(zhǔn)來(lái)確定圖像在 3D 空間中的位置。盡管相機(jī)校準(zhǔn)這一問(wèn)題已得到廣泛研究,但大多數(shù)校準(zhǔn)方法都會(huì)固定相機(jī)位置并使用某個(gè)已知的校準(zhǔn)模式。Basu [10] 提出了一種使用場(chǎng)景中的清晰邊緣自動(dòng)校準(zhǔn)相機(jī)的方法,該方法可移動(dòng)相機(jī)且無(wú)需事先定義一種模式。

除了上述問(wèn)題之外,某些數(shù)據(jù)集還存在嚴(yán)重的類別不平衡問(wèn)題,比如 nuScenes 數(shù)據(jù)集。[11] 提出了一種有效解決該問(wèn)題的方法,并在這個(gè)新數(shù)據(jù)集上取得了優(yōu)秀表現(xiàn)。他們首先使用數(shù)據(jù)增強(qiáng)策略,然后使用一些經(jīng)過(guò)改進(jìn)的 3D 特征提取網(wǎng)絡(luò),最后改進(jìn)訓(xùn)練流程和對(duì)損失的評(píng)估,進(jìn)而實(shí)現(xiàn)整體性能的提升。

3 2D目標(biāo)檢測(cè)

3.1 傳統(tǒng)方法

傳統(tǒng)的目標(biāo)檢測(cè)算法通常基于不同類型的特征描述子。方向梯度直方圖(HOG)[12] 就是其中一種著名的描述子,它統(tǒng)計(jì)在已定位的圖像部分中梯度方向的出現(xiàn)次數(shù)。HOG 特征結(jié)合 SVM 分類器的方法已在目標(biāo)檢測(cè)領(lǐng)域得到廣泛應(yīng)用,在行人檢測(cè)方面尤其成功。

特征檢測(cè)在傳統(tǒng)方法中尤其重要。近些年,出現(xiàn)了很多特征提取方面的有趣研究。

霍夫變換(Hough transform)是圖像處理過(guò)程中一種識(shí)別圖像中幾何形狀的基本方法。舉個(gè)例子,針對(duì)人臉跟蹤問(wèn)題,[13] 使用了一種基于梯度的霍夫變換來(lái)定位眼睛虹膜的位置。但是,對(duì)于非單視點(diǎn)(SVP)標(biāo)準(zhǔn)的圖像,這樣的變換無(wú)法直接用于特征識(shí)別。[14] 提出了一種解決該問(wèn)題的數(shù)學(xué)模型。

雷登變換(Radon Transform)[15] 在醫(yī)學(xué)影像處理方面應(yīng)用廣泛,它也可用于識(shí)別任務(wù)。[16] 使用雷登變換來(lái)進(jìn)行視覺(jué)手勢(shì)識(shí)別,得到了很不錯(cuò)的識(shí)別率。

Yin [17] 提出了一種跟蹤鼻子形狀的方法,以前的研究通常會(huì)忽略這個(gè)特征。這一研究使用面積增長(zhǎng)方法來(lái)確定鼻子所在的區(qū)域,而鼻尖和鼻翼的形狀則是通過(guò)預(yù)定義模板分別提取。最后,再使用提取出的特征指示人臉跟蹤的效果。

一旦檢測(cè)到相關(guān)特征,就使用 Kanade–Lucas–Tomasi(KLT)等特征跟蹤器跟蹤下一幀中的特征。2005 年時(shí),有作者 [18] 提出了一種方法,即使用高斯拉普拉斯算子(Laplace of Gaussian)和高斯加權(quán)函數(shù)來(lái)提升會(huì)受噪聲影響的 KLT 跟蹤性能。該加權(quán)函數(shù)耦合了邊緣特征,從而得到了一種用于選取最優(yōu)加權(quán)函數(shù)的確定性公式。這種方法僅會(huì)增加少量計(jì)算時(shí)間,但卻為跟蹤性能帶來(lái)極大提升。

有時(shí)候,除了特征提取,還會(huì)涉及到圖像分割。[19] 描述了一種方法,即使用梯度向量流 - 蛇(GVF snake)模型來(lái)提取相關(guān)輪廓。通過(guò)加入邊緣檢測(cè)和使用氣道 CT 切片先驗(yàn)知識(shí)的蛇位移(snake shifting)技術(shù),作者對(duì)原始 GVF - 蛇方法進(jìn)行了改進(jìn),得到了更好的結(jié)果。這一技術(shù)可能也很有用。

另一個(gè)問(wèn)題則來(lái)自相機(jī)移動(dòng),隨著收集數(shù)據(jù)的設(shè)備類型的增多,來(lái)自移動(dòng)相機(jī)的數(shù)據(jù)也越來(lái)越多。至于背景消除問(wèn)題,很多方法在靜止相機(jī)采集的數(shù)據(jù)上表現(xiàn)優(yōu)良,比如在事先知道每幀中前景和背景有較大距離的前提下,聚類可以在一次迭代中完成,而且僅需兩個(gè)聚類,[20] 能在背景消除任務(wù)上取得較高的準(zhǔn)確率。但是,如果相機(jī)在移動(dòng),難度就會(huì)大得多。[21] 首先使用了魯棒型主成分分析(RPCA)來(lái)提取背景運(yùn)動(dòng),其假設(shè)背景場(chǎng)景可以描述為一種低秩矩陣,然后將幀分割為子像素以提升將光流轉(zhuǎn)換為運(yùn)動(dòng)的幅度和角度的準(zhǔn)確率,由此改善結(jié)果。

3.2 深度學(xué)習(xí)方法

目標(biāo)識(shí)別是指與識(shí)別圖像或視頻中目標(biāo)相關(guān)的任務(wù),旨在找到圖像中所有相關(guān)目標(biāo)并確定其 2D 位置。

現(xiàn)今,目標(biāo)檢測(cè)領(lǐng)域的深度學(xué)習(xí)方法主要分為兩大類:兩階段式目標(biāo)檢測(cè)算法和單階段式目標(biāo)檢測(cè)算法。前者是先由算法生成一系列候選邊界框作為樣本,然后再通過(guò)卷積神經(jīng)網(wǎng)絡(luò)分類這些樣本。后者則是直接將目標(biāo)邊界定位問(wèn)題轉(zhuǎn)換成回歸問(wèn)題,其中不涉及生成候選邊界框。兩種方法的區(qū)別也導(dǎo)致其性能也不同。前者在檢測(cè)準(zhǔn)確率和定位準(zhǔn)確率方面更優(yōu),而后者勝在算法速度。

此外,通用框架也主要有兩種。

第一種是兩階段框架。這類框架首先生成候選區(qū)域(region proposal),然后將其分類成不同的目標(biāo)類別,所以這也被稱為「基于區(qū)域的方法」。這類模型主要包括 R-CNN [22]、Fast R-CNN [23]、Faster R-CNN [24]、基于區(qū)域的全卷積網(wǎng)絡(luò)(R-FCN)等。

在單階段框架中,模型將目標(biāo)檢測(cè)任務(wù)視為一個(gè)統(tǒng)一的端到端回歸問(wèn)題。在這類框架中,圖像會(huì)被縮放到同一尺寸,并以網(wǎng)格形式均等劃分。如果目標(biāo)的中心位于某個(gè)網(wǎng)格單元中,該網(wǎng)格就負(fù)責(zé)預(yù)測(cè)目標(biāo)。通過(guò)這種方式,模型僅需處理圖像一次就能得到位置和分類結(jié)果。單階段框架主要包括 MultiBox [26]、YOLO [27]、單次多框檢測(cè)器(SSD)[28]。相比于第一類框架,這種框架通常結(jié)構(gòu)更簡(jiǎn)單,檢測(cè)速度也更快。

4 3D目標(biāo)檢測(cè)

這一節(jié)將簡(jiǎn)要討論與 3D 目標(biāo)檢測(cè)相關(guān)的工作,這里基于不同的數(shù)據(jù)信息將這些研究工作分為了三大類別。

4.1 使用 RGB 圖像的目標(biāo)檢測(cè)

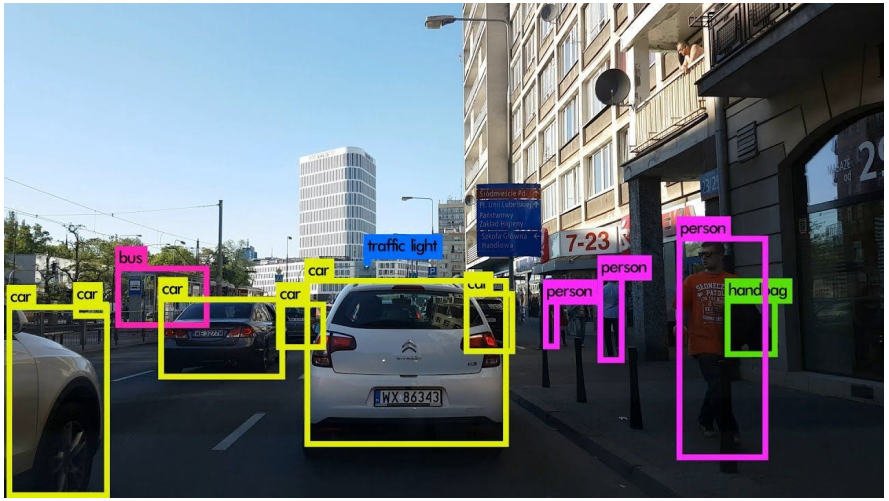

RGB 圖像包含充足的語(yǔ)義信息,因此非常適合目標(biāo)檢測(cè)。圖 2 展示了一個(gè)使用 2D 圖像檢測(cè)目標(biāo)的示例。3D-GCK [29] 等方法僅使用單目 RGB 圖像就能實(shí)現(xiàn)實(shí)時(shí)的汽車檢測(cè):它首先預(yù)測(cè) 2D 邊界框,然后使用神經(jīng)網(wǎng)絡(luò)來(lái)估計(jì)缺失的深度信息,將 2D 邊界框提升到 3D 空間。

圖 2:使用 2D 圖像的目標(biāo)檢測(cè)示例。

近期一項(xiàng)研究 [30] 使用了 RGB-D 傳感器,但只使用了灰度信息來(lái)識(shí)別無(wú)紋理的目標(biāo)。它首先將傳感器獲得的 RGB 圖像轉(zhuǎn)換成灰度圖像,然后再分割背景和前景。在移除噪聲后,再使用 5 個(gè)分類模型執(zhí)行特征提取,最終預(yù)測(cè)出目標(biāo)的類別。

4.2 使用點(diǎn)云的目標(biāo)檢測(cè)

僅使用點(diǎn)云數(shù)據(jù)的分類網(wǎng)絡(luò)主要有兩種。第一種是直接使用三維點(diǎn)云數(shù)據(jù)。這類方法沒(méi)有信息丟失的問(wèn)題,但是由于 3D 數(shù)據(jù)非常復(fù)雜,所以往往計(jì)算成本較高。第二種方法則是將點(diǎn)云處理成二維數(shù)據(jù),這可以降低計(jì)算量,但不可避免地會(huì)丟失原始數(shù)據(jù)的一些特征。圖 3 給出了一個(gè)使用 3D 激光雷達(dá)點(diǎn)云數(shù)據(jù)執(zhí)行檢測(cè)的例子。

圖 3:通過(guò) YOLO 使用 3D 點(diǎn)云的目標(biāo)檢測(cè)示例。

圖 3:通過(guò) YOLO 使用 3D 點(diǎn)云的目標(biāo)檢測(cè)示例。

將點(diǎn)云處理成二維數(shù)據(jù)的方法有很多。Jansen [31] 提出從多個(gè) 2D 角度表示 3D 點(diǎn)云。在其數(shù)據(jù)預(yù)處理階段,通過(guò)取點(diǎn)云圖像的中心作為原點(diǎn),并通過(guò)旋轉(zhuǎn)固定的弧度角來(lái)截取 64 張不同角度的點(diǎn)云圖像。這種方法能在一定程度上減少信息損失,因?yàn)槠渲屑尤肓祟~外的旋轉(zhuǎn),并在分類階段使用了許多實(shí)例。[32] 等研究則是將點(diǎn)云投射到一個(gè)圓柱面上,以盡可能多地保留信息。

BirdNet+ [33] 是基于目標(biāo)檢測(cè)框架 BirdNet [34] 的改進(jìn)版。BirdNet+ 為基于激光雷達(dá)數(shù)據(jù)的 3D 目標(biāo)檢測(cè)提供了一種端到端的解決方案。它用到了鳥(niǎo)瞰視角表征,這是從激光雷達(dá)點(diǎn)云轉(zhuǎn)換而來(lái)的帶有三個(gè)通道的 2D 結(jié)構(gòu),依賴于一個(gè)兩階段架構(gòu)來(lái)獲取面向 3D 的邊界框。

近期,[35] 提出了一種計(jì)算高效的端到端式魯棒型點(diǎn)云對(duì)齊和目標(biāo)識(shí)別方法,該方法使用了無(wú)監(jiān)督深度學(xué)習(xí),并被命名為深度點(diǎn)云映射網(wǎng)絡(luò)(DPC-MN)。該模型的訓(xùn)練無(wú)需標(biāo)簽,而且能高效地實(shí)現(xiàn)從 3D 點(diǎn)云表征到 2D 視角的映射函數(shù)。

4.3 結(jié)合 RGB 圖像與點(diǎn)云的目標(biāo)檢測(cè)

Frustum PointNets [36] 同時(shí)使用 RGB 圖像和激光雷達(dá)點(diǎn)云數(shù)據(jù)來(lái)執(zhí)行 3D 目標(biāo)檢測(cè)。該算法使用成熟的 2D 目標(biāo)檢測(cè)器來(lái)縮小搜索空間。它是通過(guò)從圖像檢測(cè)器得到的 2D 邊界框來(lái)提取 3D 邊界視錐,然后再在經(jīng)過(guò) 3D 視錐修整過(guò)的 3D 空間中執(zhí)行 3D 目標(biāo)實(shí)例分割。

MV3D [37] 也同時(shí)使用 RGB 圖像和激光雷達(dá)點(diǎn)云數(shù)據(jù)作為輸入,它是將 3D 點(diǎn)云投影成鳥(niǎo)瞰圖和正視圖。鳥(niǎo)瞰圖表征是通過(guò)高度、強(qiáng)度和密度編碼的,而正視圖則是將點(diǎn)云投影到一個(gè)圓柱面上生成的。鳥(niǎo)瞰圖可用于生成 3D 先驗(yàn)邊界框,然后將該 3D 先驗(yàn)邊界框投影到前視圖和圖像上,這三個(gè)輸入生成一個(gè)特征圖。該方法采用 ROI 池化來(lái)將三個(gè)特征圖整合到同一個(gè)維度。整合后的數(shù)據(jù)再在網(wǎng)絡(luò)上進(jìn)行融合,然后輸出分類結(jié)果和邊界框。

圖 4:使用 MV3D 的目標(biāo)檢測(cè)示例。

END

整理不易,點(diǎn)贊三連↓