實(shí)操教程|用不需要手工標(biāo)注分割的訓(xùn)練數(shù)據(jù)來進(jìn)行圖像分割

極市導(dǎo)讀

本文介紹了一個(gè)僅需要標(biāo)注包圍框就可以進(jìn)行圖像分割的訓(xùn)練。 >>加入極市CV技術(shù)交流群,走在計(jì)算機(jī)視覺的最前沿

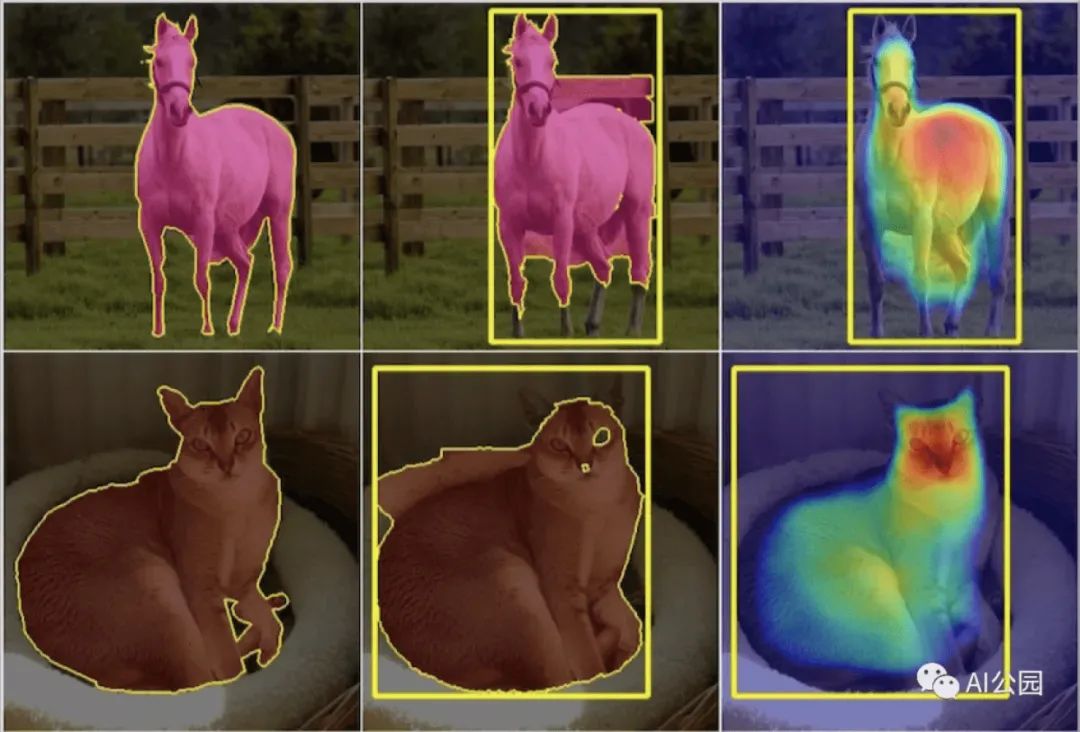

語義分割是將數(shù)字圖像中的每一個(gè)像素自動(dòng)標(biāo)注為多個(gè)類別(人、貓、飛機(jī)、表等)中的一個(gè),應(yīng)用于基于內(nèi)容的圖像檢索、醫(yī)學(xué)圖像和目標(biāo)識(shí)別等。

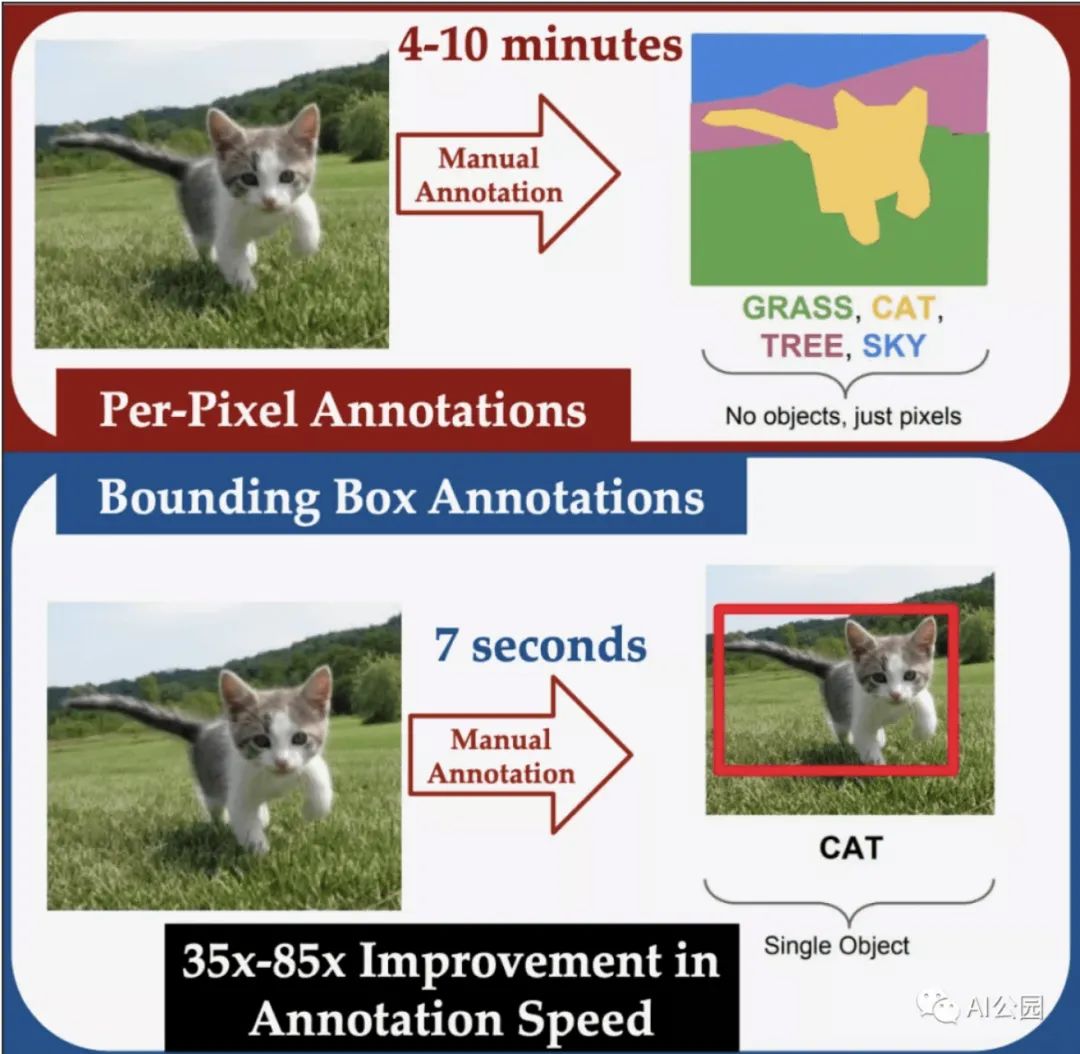

基于機(jī)器學(xué)習(xí)的語義分割系統(tǒng)通常是在目標(biāo)邊界已經(jīng)精心手工標(biāo)注過的圖像上訓(xùn)練,這是一個(gè)耗時(shí)的操作。另一方面,目標(biāo)檢測系統(tǒng)可以對(duì)圖像進(jìn)行訓(xùn)練,在這些圖像中,目標(biāo)被稱為邊界框的矩形框框起來。對(duì)于人類標(biāo)注者來說,手動(dòng)分割一幅圖像平均花費(fèi)的時(shí)間是標(biāo)記邊界框的35倍。在ECCV上發(fā)表的一篇論文中,我們描述了一個(gè)新的系統(tǒng),我們稱之為Box2Seg,它只使用邊界框訓(xùn)練數(shù)據(jù)來學(xué)習(xí)分割圖像,這是弱監(jiān)督學(xué)習(xí)的一個(gè)例子。在實(shí)驗(yàn)中,我們的系統(tǒng)在一個(gè)(mIoU)的度量上比以前的弱監(jiān)督系統(tǒng)提高了2%,該度量度量了系統(tǒng)分割圖像和手動(dòng)分割圖像之間的一致性。我們的系統(tǒng)的性能也可以與對(duì)一般圖像數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,然后對(duì)完全分割的數(shù)據(jù)進(jìn)行訓(xùn)練相比。此外,當(dāng)我們使用弱監(jiān)督方法訓(xùn)練系統(tǒng),然后對(duì)完全分割的數(shù)據(jù)進(jìn)行微調(diào)時(shí),它比對(duì)一般圖像數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練的系統(tǒng)性能提高了16%。這表明,即使分割訓(xùn)練數(shù)據(jù)可用,使用我們的弱監(jiān)督方法進(jìn)行預(yù)處理訓(xùn)練仍然有優(yōu)勢。

有噪聲的標(biāo)簽

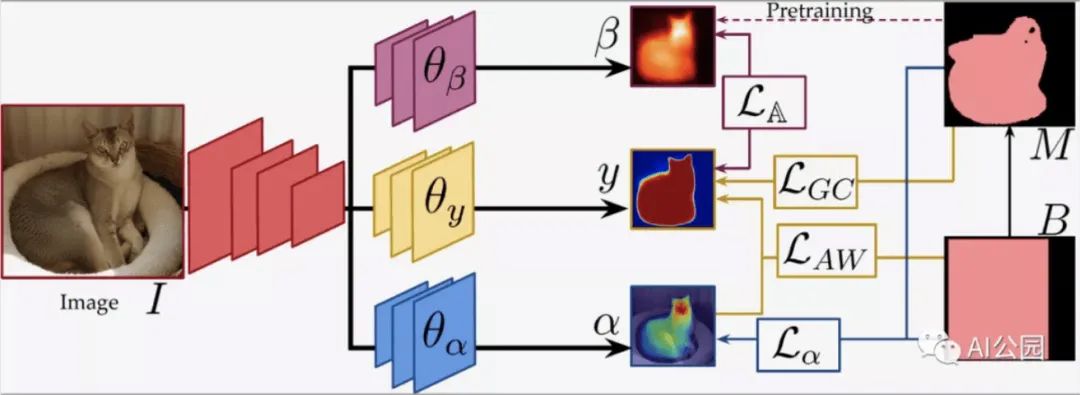

我們的方法是將邊界框視為噪聲標(biāo)簽。我們把框里的每個(gè)像素當(dāng)作我們要尋找的邊界的對(duì)象的一部分,然而,其中一些像素被錯(cuò)誤地標(biāo)記了。框外的所有像素都被正確標(biāo)記為背景像素。在訓(xùn)練過程中,我們系統(tǒng)的輸入通過三個(gè)卷積神經(jīng)網(wǎng)絡(luò):一個(gè)目標(biāo)分割網(wǎng)絡(luò)和兩個(gè)輔助網(wǎng)絡(luò)。在運(yùn)行過程中,我們丟棄了輔助網(wǎng)絡(luò),這樣它們就不會(huì)增加已部署系統(tǒng)的復(fù)雜性。

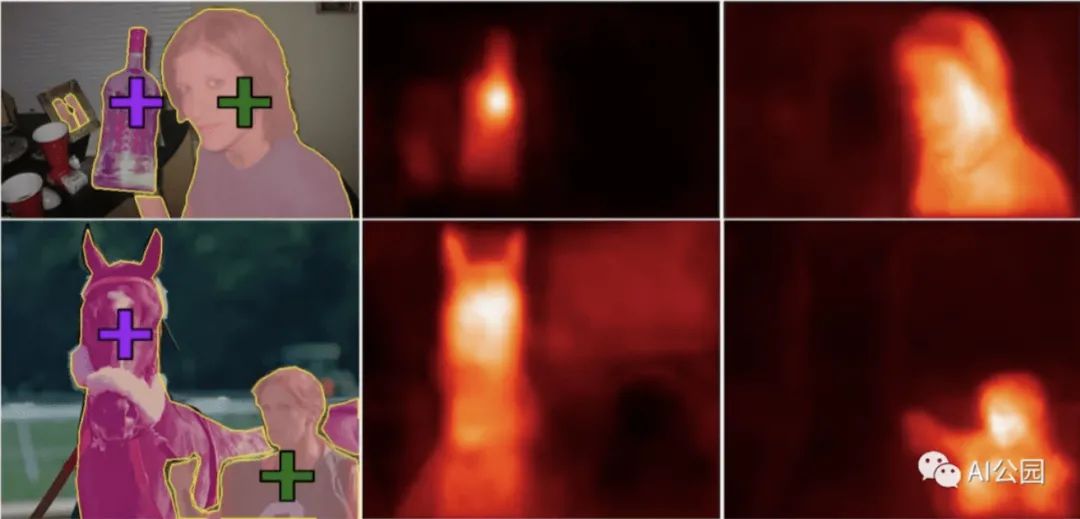

其中一個(gè)輔助網(wǎng)絡(luò)對(duì)圖像中的像素進(jìn)行兩兩比較,試圖學(xué)習(xí)區(qū)分背景和前景的一般方法。直觀地說,它是在邊界框內(nèi)尋找與框外正確標(biāo)記的背景像素相似的像素,并在框內(nèi)尋找彼此不同的像素簇。我們稱這個(gè)網(wǎng)絡(luò)為“嵌入”網(wǎng)絡(luò),因?yàn)樗梢詫W(xué)習(xí)像素的向量表示,即嵌入,這些像素只捕捉那些對(duì)區(qū)分背景和前景有用的屬性。我們使用一種叫做GrabCut的標(biāo)準(zhǔn)分割算法提供的相對(duì)粗糙的分割來預(yù)先訓(xùn)練嵌入網(wǎng)絡(luò)。在訓(xùn)練過程中,嵌入網(wǎng)絡(luò)的輸出為目標(biāo)分割網(wǎng)絡(luò)提供監(jiān)督信號(hào),也就是說,我們用來評(píng)價(jià)嵌入網(wǎng)絡(luò)性能的標(biāo)準(zhǔn)之一是其輸出與嵌入網(wǎng)絡(luò)的輸出是否一致。

另一個(gè)輔助網(wǎng)絡(luò)是特定標(biāo)簽注意力網(wǎng)絡(luò)。它學(xué)會(huì)識(shí)別具有相同標(biāo)簽的邊框內(nèi)像素之間頻繁出現(xiàn)的視覺屬性。可以將其視為一個(gè)目標(biāo)檢測器,其輸出不是一個(gè)目標(biāo)標(biāo)簽,而是一個(gè)突出顯示特定對(duì)象類的像素簇特征的圖像映射。

在使用標(biāo)準(zhǔn)基準(zhǔn)數(shù)據(jù)集的實(shí)驗(yàn)中,我們發(fā)現(xiàn),僅使用邊界框訓(xùn)練數(shù)據(jù),Box2Seg比使用完全分割訓(xùn)練數(shù)據(jù)訓(xùn)練的其他12個(gè)系統(tǒng)表現(xiàn)得更好。當(dāng)使用Box2Seg訓(xùn)練的網(wǎng)絡(luò)在完全分段的數(shù)據(jù)上進(jìn)行微調(diào)時(shí),性能改進(jìn)甚至更顯著。這表明,當(dāng)沒有完全分割的訓(xùn)練數(shù)據(jù)時(shí),甚至在完全分割的訓(xùn)練數(shù)據(jù)可用時(shí),對(duì)象分割的弱監(jiān)督訓(xùn)練可能是有用的。

—END—

英文原文:https://www.amazon.science/blog/learning-to-segment-images-without-manually-segmented-training-data

如果覺得有用,就請(qǐng)分享到朋友圈吧!

公眾號(hào)后臺(tái)回復(fù)“長尾”獲取長尾特征學(xué)習(xí)資源~

# CV技術(shù)社群邀請(qǐng)函 #

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測-深圳)

即可申請(qǐng)加入極市目標(biāo)檢測/圖像分割/工業(yè)檢測/人臉/醫(yī)學(xué)影像/3D/SLAM/自動(dòng)駕駛/超分辨率/姿態(tài)估計(jì)/ReID/GAN/圖像增強(qiáng)/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實(shí)項(xiàng)目需求對(duì)接、求職內(nèi)推、算法競賽、干貨資訊匯總、與 10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動(dòng)交流~