ICML 2021 (Long Oral) | 深入研究不平衡回歸問題

極市導(dǎo)讀

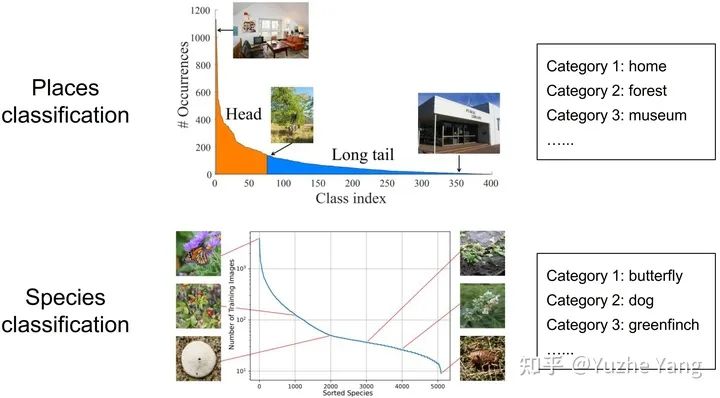

本文介紹了一篇被ICML2021接收的工作:Long oral presentation:Delving into Deep Imbalanced Regression。該工作推廣了傳統(tǒng)不平衡分類問題的范式,將數(shù)據(jù)不平衡問題從離散值域推廣到連續(xù)域。>>加入極市CV技術(shù)交流群,走在計算機(jī)視覺的最前沿

-

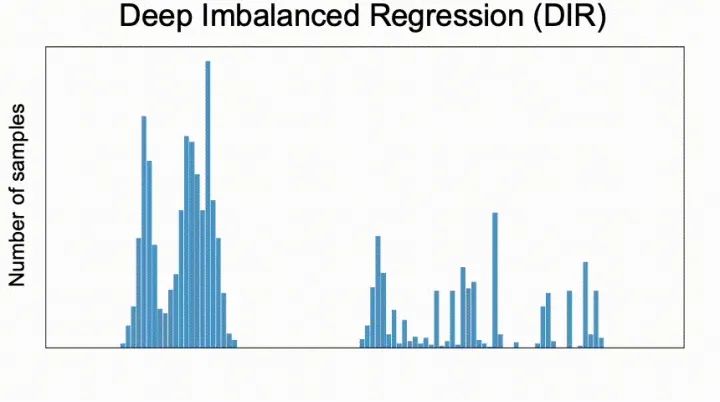

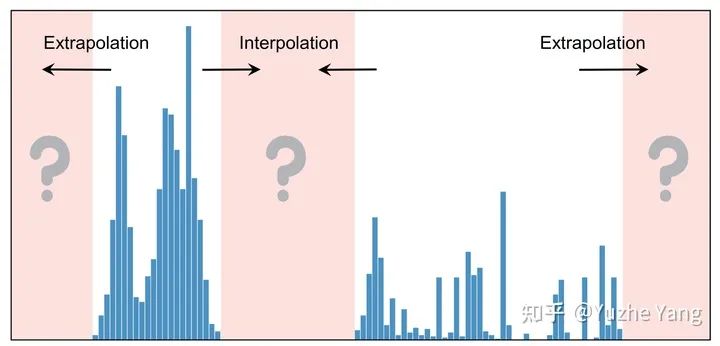

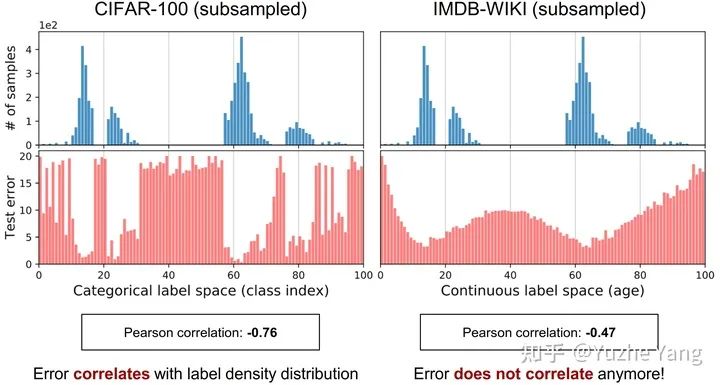

我們提出了一個新的任務(wù),稱為深度不平衡回歸(Deep Imbalanced Regression,簡寫為DIR)。DIR任務(wù)定義為從具有連續(xù)目標(biāo)的不平衡數(shù)據(jù)中學(xué)習(xí),并能泛化到整個目標(biāo)范圍; -

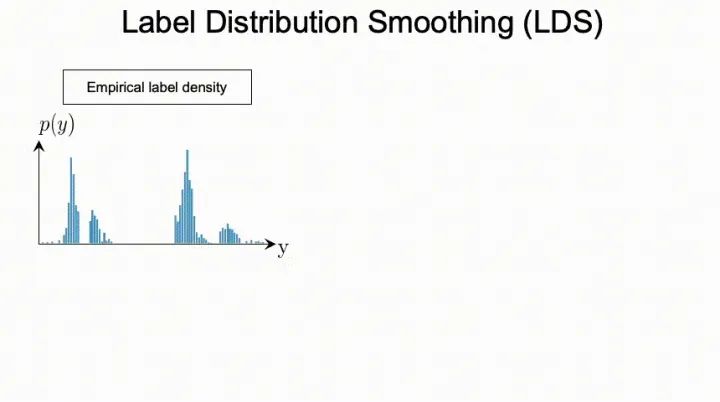

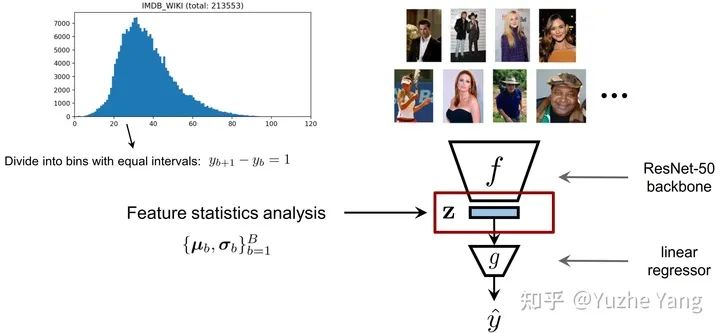

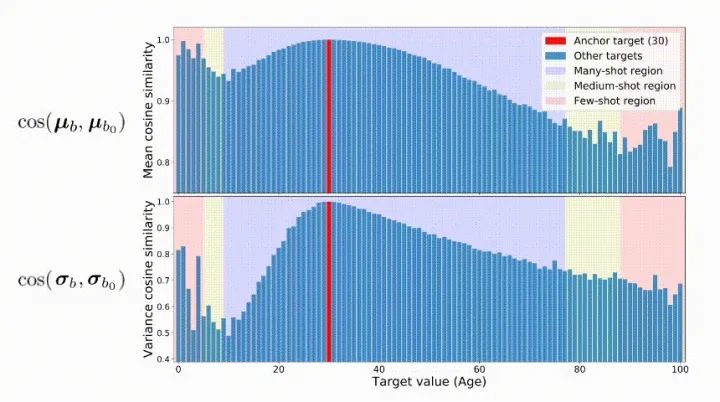

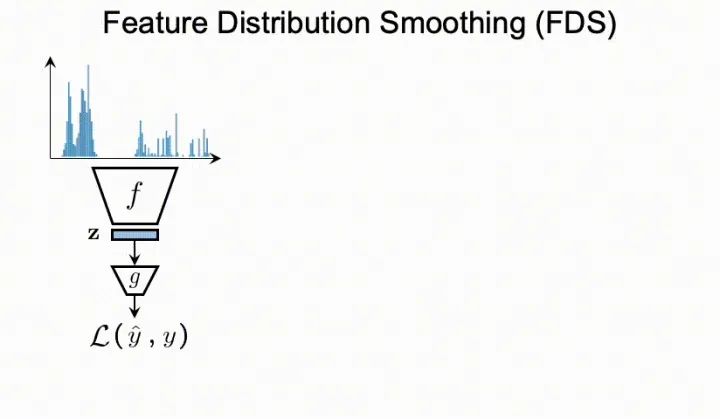

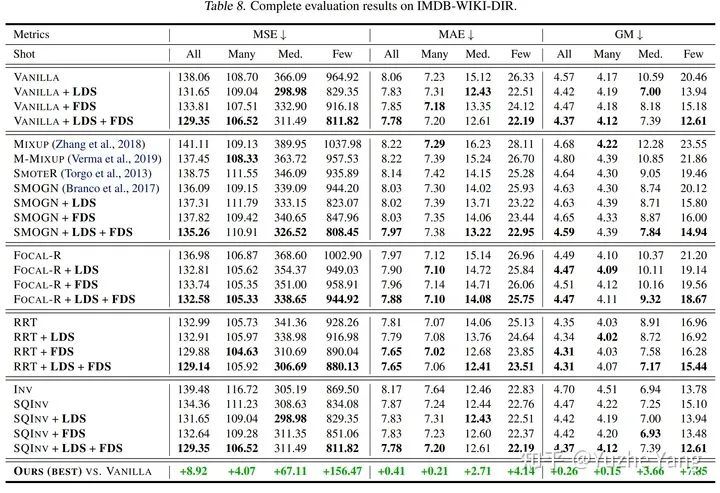

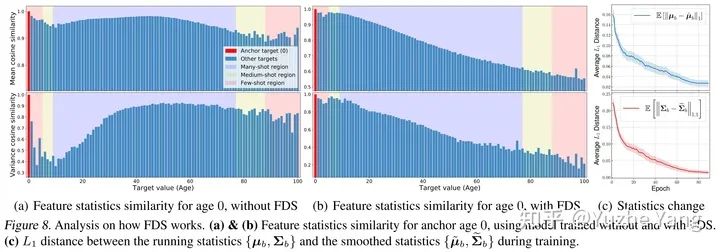

我們同時提出了針對不平衡回歸的新的方法,標(biāo)簽分布平滑(label distribution smoothing, LDS)和特征分布平滑(feature distribution smoothing, FDS),以解決具有連續(xù)目標(biāo)的不平衡數(shù)據(jù)的學(xué)習(xí)問題; -

最后我們建立了五個新的DIR數(shù)據(jù)集,涵蓋了computer vision,NLP,和healthcare上的不平衡回歸任務(wù),來方便未來在不平衡數(shù)據(jù)上的研究。

1. 研究背景與動機(jī)

2. 不平衡回歸的難點與挑戰(zhàn)

3. 標(biāo)簽分布平滑(LDS)

4. 特征分布平滑(FDS)

5. 基準(zhǔn)DIR數(shù)據(jù)集及實驗分析

-

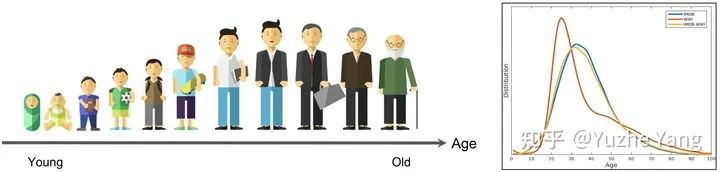

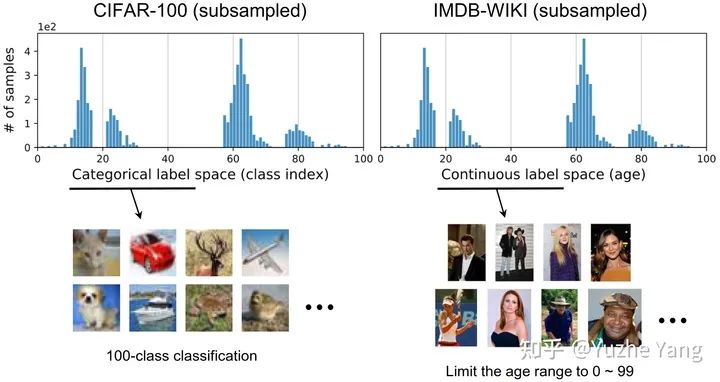

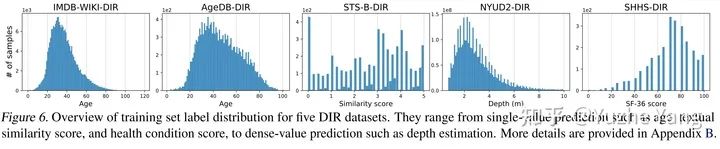

IMDB-WIKI-DIR(vision, age): 從包含人面部的圖像來推斷估計相應(yīng)的年齡。基于IMDB-WIKI[9]數(shù)據(jù)集,我們手動構(gòu)建了驗證集和測試集,使其保持了分布的平衡。 -

AgeDB-DIR(vision, age): 同樣是根據(jù)單個輸入圖像進(jìn)行年齡估算,基于AgeDB[11]數(shù)據(jù)集。注意到與IMDB-WIKI-DIR相比,即使兩個數(shù)據(jù)集是完全相同的task,他們的標(biāo)簽分布的不平衡也不相同。 -

NYUD2-DIR(vision, depth): 除了single value的prediction, 我們還基于NYU2數(shù)據(jù)集[12]構(gòu)建了進(jìn)行depth estimation的DIR任務(wù),是一個dense value prediction的任務(wù)。我們構(gòu)建了NYUD2-DIR數(shù)據(jù)集來進(jìn)行不平衡回歸的評估。 -

STS-B-DIR(NLP, text similarity score): 我們還在NLP領(lǐng)域中構(gòu)建了一個叫STS-B-DIR的DIR benchmark,基于STS-B數(shù)據(jù)集[13]。他的任務(wù)是推斷兩個輸入句子之間的語義文本的相似度得分。這個相似度分?jǐn)?shù)是連續(xù)的,范圍是0到5,并且分布不平衡。 -

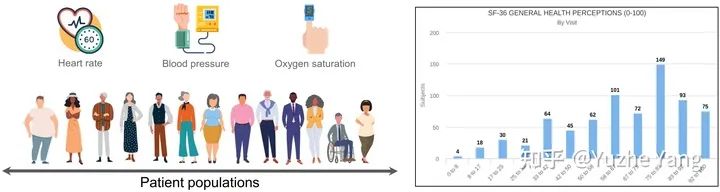

SHHS-DIR(Healthcare, health condition score): 最后,我們在healthcare領(lǐng)域也構(gòu)建了一個DIR的benchmark,叫做 SHHS-DIR,基于SHHS數(shù)據(jù)集[14]。這項任務(wù)是推斷一個人的總體健康評分,該評分在0到100之間連續(xù)分布,評分越高則健康狀況越好。網(wǎng)絡(luò)的輸入是每個患者在一整晚睡眠過程中的高維PSG信號,包括ECG心電信號,EEG腦電信號,以及他的呼吸信號。很明顯可以看到,總體健康分?jǐn)?shù)的分布也是極度不平衡的,并存在一定的target value是沒有數(shù)據(jù)的。

6. 結(jié)語

參考

本文亮點總結(jié)

如果覺得有用,就請分享到朋友圈吧!

公眾號后臺回復(fù)“pytorch”獲取Pytorch 官方書籍英文版電子版~

# CV技術(shù)社群邀請函 #

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測-深圳)

即可申請加入極市目標(biāo)檢測/圖像分割/工業(yè)檢測/人臉/醫(yī)學(xué)影像/3D/SLAM/自動駕駛/超分辨率/姿態(tài)估計/ReID/GAN/圖像增強(qiáng)/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實項目需求對接、求職內(nèi)推、算法競賽、干貨資訊匯總、與 10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動交流~

評論

圖片

表情