ICML2021 | 深入研究不平衡回歸問(wèn)題

來(lái)源:知乎—Yuzhe Yang、深度學(xué)習(xí)與圖網(wǎng)絡(luò) https://zhuanlan.zhihu.com/p/369627086 本文約8500字,建議閱讀15分鐘 本文大體梳理一下數(shù)據(jù)不平衡這個(gè)問(wèn)題在分類以及回歸上的一部分研究現(xiàn)狀。

我們提出了一個(gè)新的任務(wù),稱為深度不平衡回歸(Deep Imbalanced Regression,簡(jiǎn)寫(xiě)為DIR)。DIR任務(wù)定義為從具有連續(xù)目標(biāo)的不平衡數(shù)據(jù)中學(xué)習(xí),并能泛化到整個(gè)目標(biāo)范圍; 我們同時(shí)提出了針對(duì)不平衡回歸的新的方法,標(biāo)簽分布平滑(label distribution smoothing, LDS)和特征分布平滑(feature distribution smoothing, FDS),以解決具有連續(xù)目標(biāo)的不平衡數(shù)據(jù)的學(xué)習(xí)問(wèn)題; 最后我們建立了五個(gè)新的DIR數(shù)據(jù)集,涵蓋了computer vision,NLP,和healthcare上的不平衡回歸任務(wù),來(lái)方便未來(lái)在不平衡數(shù)據(jù)上的研究。

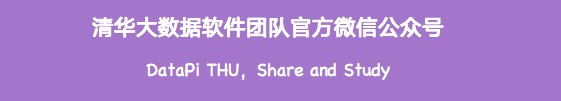

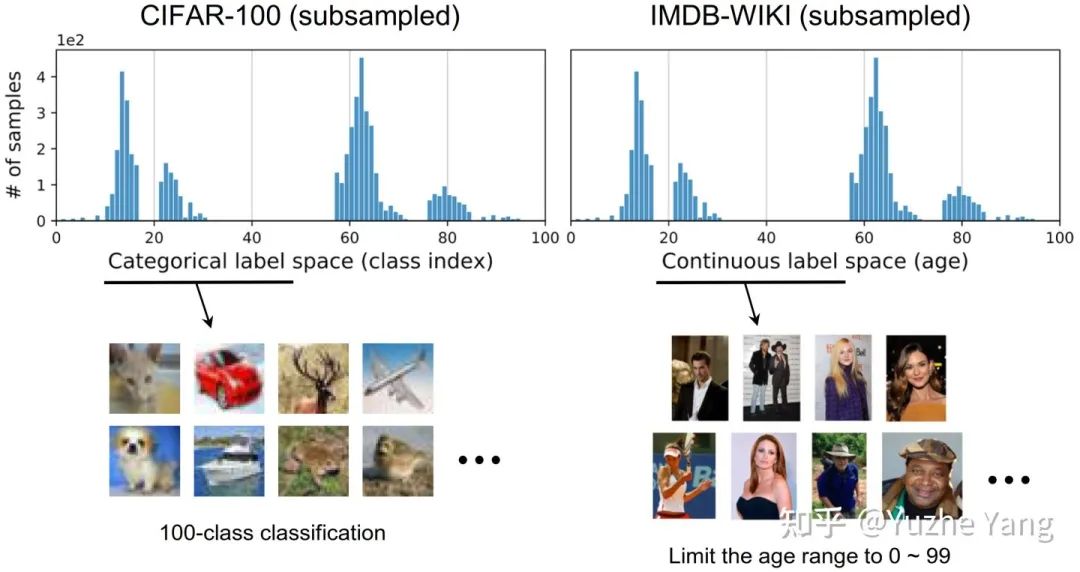

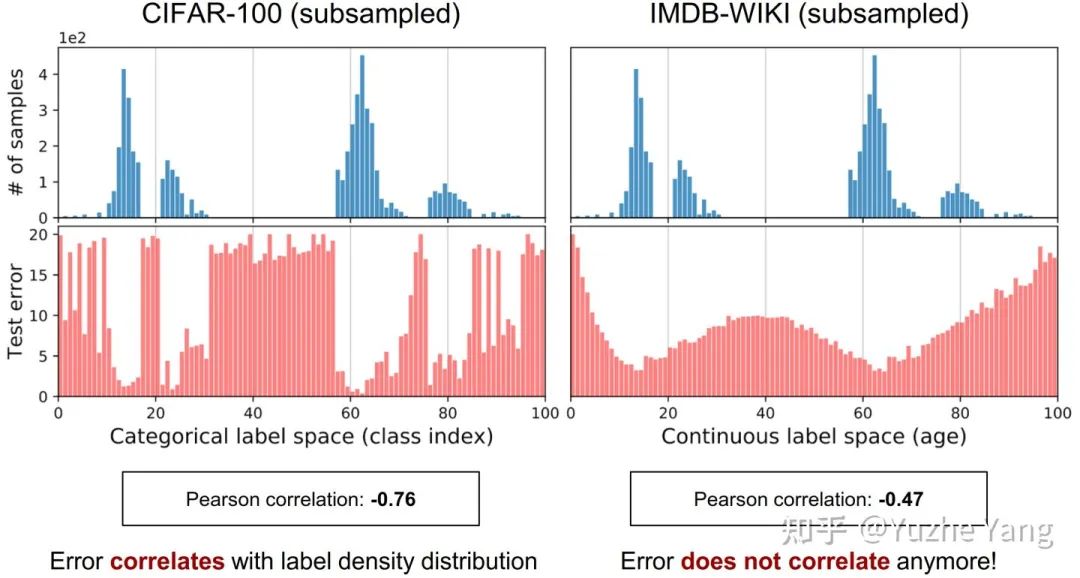

現(xiàn)有的不平衡學(xué)習(xí)方案主要考慮的數(shù)據(jù)類型是具有categorical index的目標(biāo)值,也即目標(biāo)值是不同的類別,如地點(diǎn)分類、物種分類。其目標(biāo)值屬于不同類別,且不同類之間有一個(gè)硬性的邊界,不同類別之間沒(méi)有重疊。

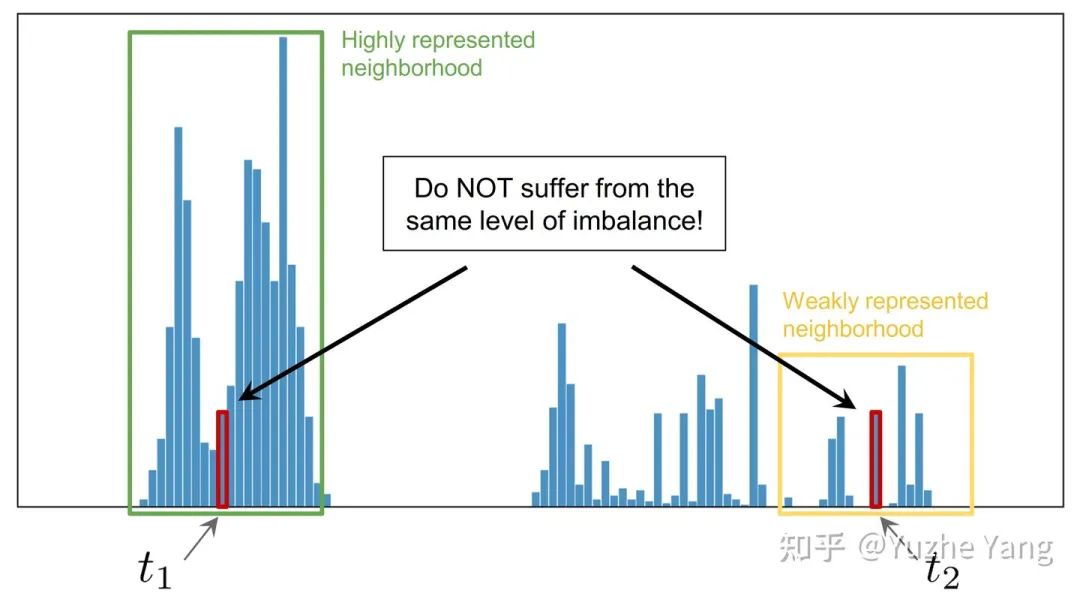

連續(xù)標(biāo)簽在不同目標(biāo)值之間的距離是具有意義的,此距離會(huì)進(jìn)一步指導(dǎo)我們?cè)撊绾卫斫膺@個(gè)連續(xù)區(qū)間上的數(shù)據(jù)不平衡的程度。圖中t1和t2在訓(xùn)練數(shù)據(jù)中具有同樣的數(shù)量,而因t1位于一個(gè)具有高密度數(shù)據(jù)的鄰域中,t2位于一個(gè)低密度數(shù)據(jù)的鄰域中,那么t1和t2并不具有相同程度的數(shù)據(jù)不平衡。

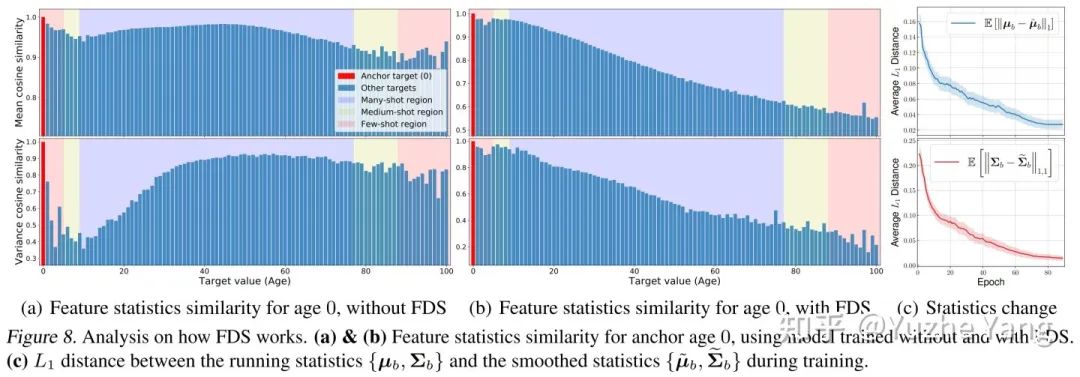

總結(jié)上述的問(wèn)題,我們可以看到DIR相比與傳統(tǒng)的不平衡分類具有全新的難點(diǎn)與挑戰(zhàn)。那么,我們應(yīng)該如何進(jìn)行深度不平衡回歸呢?在接下來(lái)的兩節(jié),我們分別提出了兩個(gè)簡(jiǎn)單且有效的方法,標(biāo)簽分布平滑(label distribution smoothing,LDS)和特征分布平滑(feature distribution smoothing,F(xiàn)DS),分別通過(guò)利用在標(biāo)簽空間和特征空間中臨近目標(biāo)之間的相似性,來(lái)提升模型在DIR任務(wù)上的表現(xiàn)。

那么有了用LDS估計(jì)出的有效標(biāo)簽密度,之前用來(lái)解決類別不平衡問(wèn)題的方法,便可以直接應(yīng)用于DIR。比如說(shuō),一種直接的可以adapted 的方法是利用重加權(quán)方法,具體來(lái)說(shuō)就是,我們通過(guò)將損失函數(shù)乘以每個(gè)目標(biāo)值的LDS估計(jì)標(biāo)簽密度的倒數(shù)來(lái)對(duì)其進(jìn)行加權(quán)。之后在實(shí)驗(yàn)部分我們也會(huì)展示,利用LDS可以一致提升很多方法。

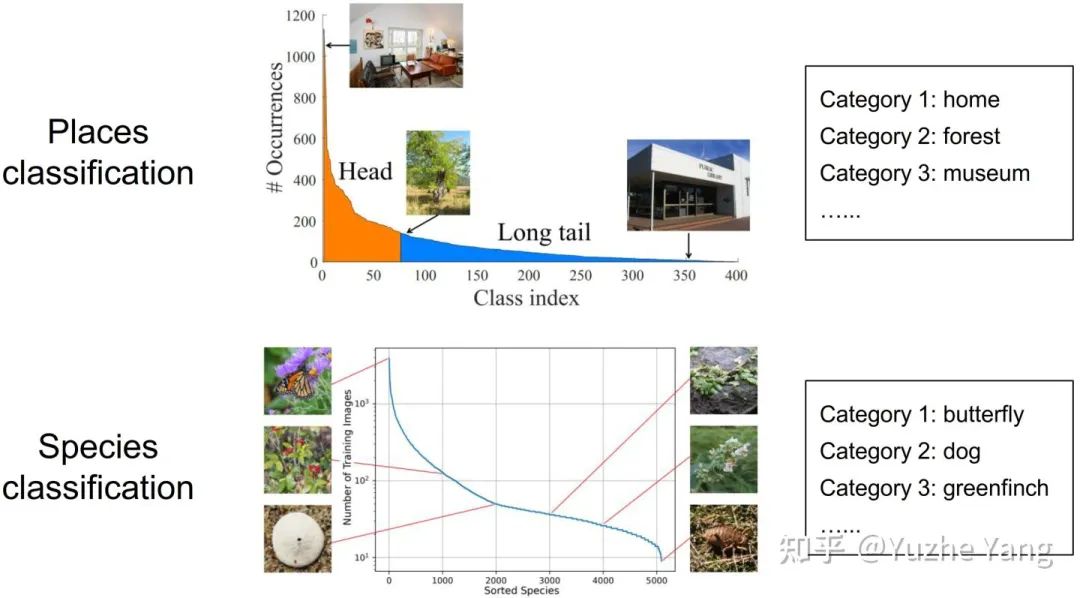

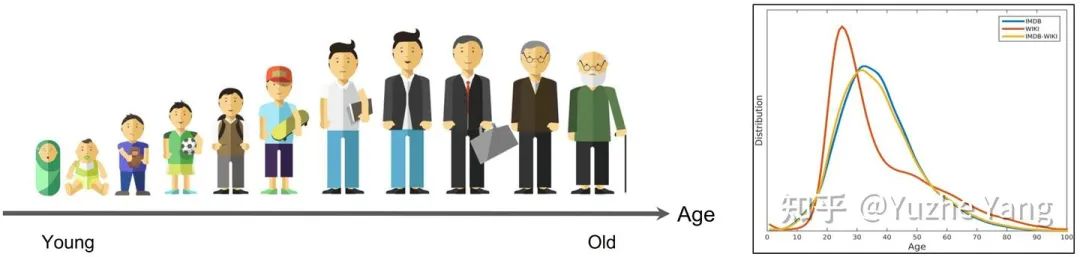

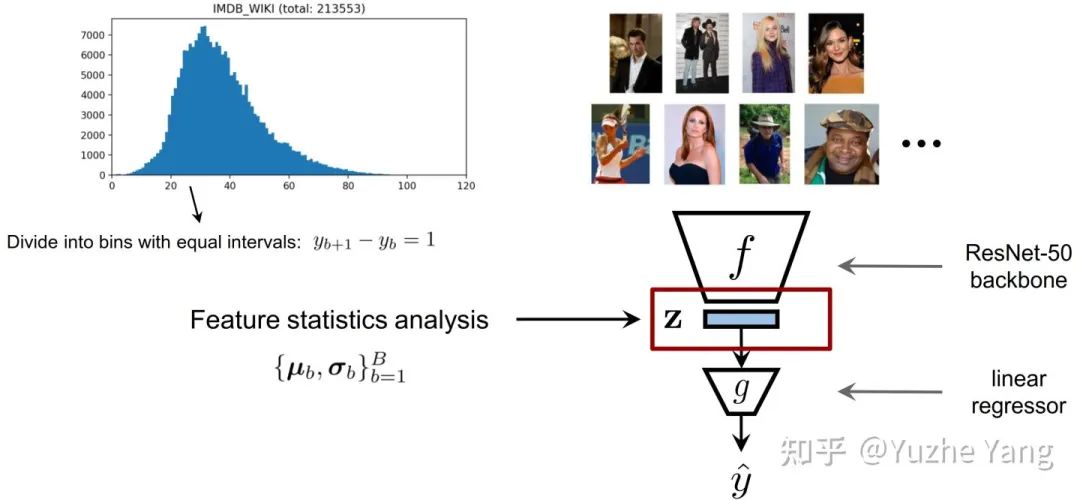

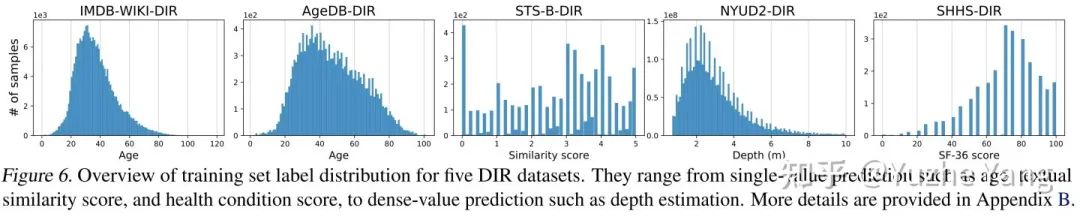

IMDB-WIKI-DIR(vision, age):從包含人面部的圖像來(lái)推斷估計(jì)相應(yīng)的年齡。基于IMDB-WIKI[9]數(shù)據(jù)集,我們手動(dòng)構(gòu)建了驗(yàn)證集和測(cè)試集,使其保持了分布的平衡。 AgeDB-DIR(vision, age):同樣是根據(jù)單個(gè)輸入圖像進(jìn)行年齡估算,基于AgeDB[11]數(shù)據(jù)集。注意到與IMDB-WIKI-DIR相比,即使兩個(gè)數(shù)據(jù)集是完全相同的task,他們的標(biāo)簽分布的不平衡也不相同。 NYUD2-DIR(vision, depth):除了single value的prediction, 我們還基于NYU2數(shù)據(jù)集[12]構(gòu)建了進(jìn)行depth estimation的DIR任務(wù),是一個(gè)dense value prediction的任務(wù)。我們構(gòu)建了NYUD2-DIR數(shù)據(jù)集來(lái)進(jìn)行不平衡回歸的評(píng)估。 STS-B-DIR(NLP, text similarity score):我們還在NLP領(lǐng)域中構(gòu)建了一個(gè)叫STS-B-DIR的DIR benchmark,基于STS-B數(shù)據(jù)集[13]。他的任務(wù)是推斷兩個(gè)輸入句子之間的語(yǔ)義文本的相似度得分。這個(gè)相似度分?jǐn)?shù)是連續(xù)的,范圍是0到5,并且分布不平衡。 SHHS-DIR(Healthcare, health condition score):最后,我們?cè)趆ealthcare領(lǐng)域也構(gòu)建了一個(gè)DIR的benchmark,叫做 SHHS-DIR,基于SHHS數(shù)據(jù)集[14]。這項(xiàng)任務(wù)是推斷一個(gè)人的總體健康評(píng)分,該評(píng)分在0到100之間連續(xù)分布,評(píng)分越高則健康狀況越好。網(wǎng)絡(luò)的輸入是每個(gè)患者在一整晚睡眠過(guò)程中的高維PSG信號(hào),包括ECG心電信號(hào),EEG腦電信號(hào),以及他的呼吸信號(hào)。很明顯可以看到,總體健康分?jǐn)?shù)的分布也是極度不平衡的,并存在一定的target value是沒(méi)有數(shù)據(jù)的。

在評(píng)估過(guò)程中,我們?cè)谄胶獾臏y(cè)試集上評(píng)估每種方法的性能。我們進(jìn)一步將目標(biāo)空間劃分為幾個(gè)不相交的子集:稱為many-shot,medium-shot,few-shot,還有zero-shot region,來(lái)反映訓(xùn)練數(shù)據(jù)中樣本數(shù)量的不同。比如,many-shot代表對(duì)于這個(gè)固定的區(qū)間,有超過(guò)100個(gè)training data sample。對(duì)于baseline方法,由于文獻(xiàn)中只有很少的不平衡回歸的方法,除了之前的使用合成樣本進(jìn)行不平衡回歸的工作[15][16]外,我們也提出了一系列不平衡回歸的baseline,包含了不同種類的學(xué)習(xí)方法(例如Focal loss[17]的regression版本Focal-R),具體詳見(jiàn)我們的文章。

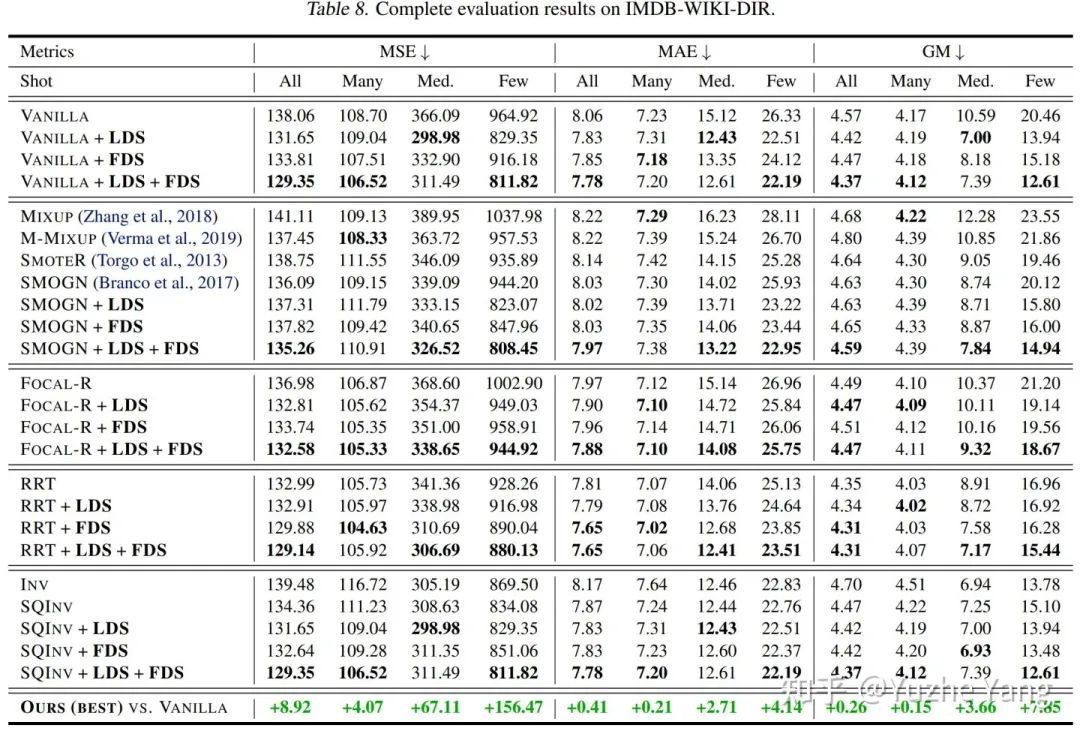

實(shí)驗(yàn):由于實(shí)驗(yàn)較多,這里僅展示在IMDB-WIKI-DIR上的部分結(jié)果,所有的結(jié)果請(qǐng)?jiān)斠?jiàn)論文。如下圖所示,我們首先根據(jù)使用的基本策略的不同,將不同的方法分為4個(gè)部分,在每個(gè)部分里,我們進(jìn)一步將LDS,F(xiàn)DS以及LDS和FDS的組合應(yīng)用于基線方法。最后,我們報(bào)告了LDS + FDS相對(duì)于Vanilla模型的performance提升。如表所示,無(wú)論使用哪一類訓(xùn)練方法,LDS和FDS均具有非常出色的表現(xiàn),特別是在few-shot region上能達(dá)到相對(duì)誤差近40%的提升。

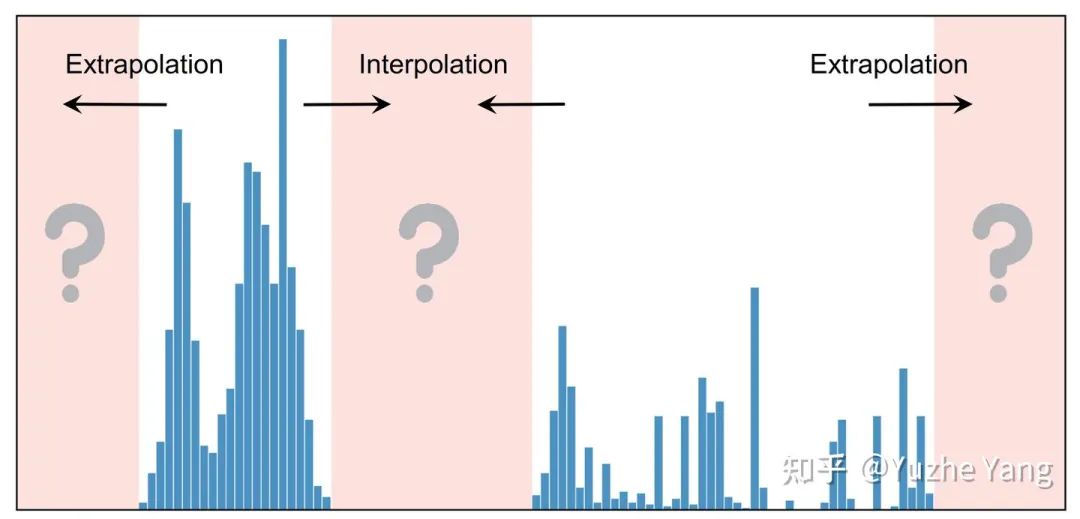

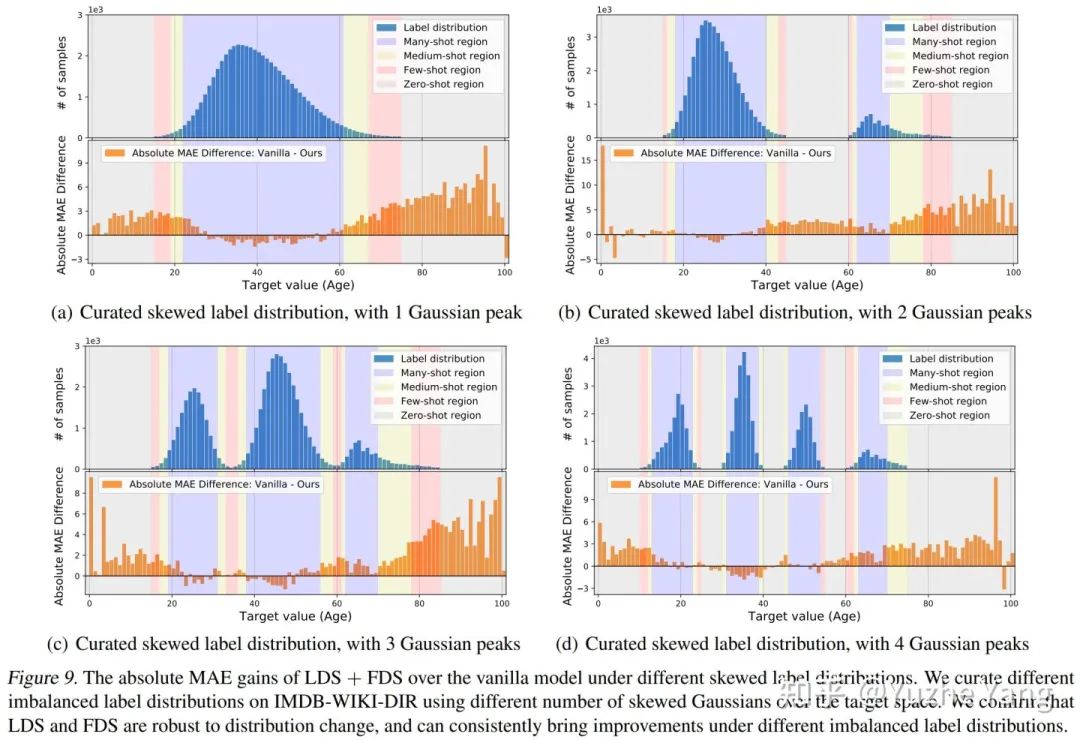

實(shí)驗(yàn)分析之 Extrapolation & Interpolation:最后,在實(shí)際的DIR任務(wù)中,某些目標(biāo)值可能根本沒(méi)有數(shù)據(jù)(例如之前看到的SHHS-DIR和STS-B-DIR上的標(biāo)簽分布)。這激發(fā)了對(duì) target extrapolation 和 interpolation 的需求。如下圖所示,我們從IMDB-WIKI-DIR的訓(xùn)練集中建立了不同的子集,涵蓋了不同peak的標(biāo)簽分布,并且這些訓(xùn)練子集在某些區(qū)域中是沒(méi)有訓(xùn)練數(shù)據(jù)的,但是我們對(duì)訓(xùn)練的模型會(huì)在原始的測(cè)試集進(jìn)行評(píng)估,來(lái)分析zero-shot的generalization。下圖我們可視化了我們的方法相對(duì)于原始模型,在所有target value上的絕對(duì)的MAE的提升(子圖上半部分藍(lán)色是訓(xùn)練的標(biāo)簽分布,下半部分橙色是相對(duì)誤差的增益)。如前所述,我們的方法可以對(duì)所有區(qū)間得到顯著的性能提升,特別是對(duì)于zero-shot范圍,能夠更好的進(jìn)行Extrapolation & Interpolation。

項(xiàng)目主頁(yè)

http://dir.csail.mit.edu/

論文

https://arxiv.org/abs/2102.09554

代碼

https://github.com/YyzHarry/imbalanced-regression

參考

1. Chawla, N. V., et al. SMOTE: Synthetic minority over-sampling technique. JAIR, 2002.

2. Deep Imbalanced Learning for Face Recognition and Attribute Prediction. TPAMI, 2019.

3. Learning imbalanced datasets with label-distribution-aware margin loss. NeurIPS, 2019.

4. Liu, Z., et al. Large-scale long-tailed recognition in an open world. CVPR 2019.

5. Meta-Weight-Net: Learning an Explicit Mapping For Sample Weighting. NeurIPS, 2019.

6. Decoupling representation and classifier for long-tailed recognition. ICLR, 2020.

7. Learning from imbalanced data: open challenges and future directions. 2016.

8. Krizhevsky, A., Hinton, G., et al. Learning multiple layers of features from tiny images. 2009.

9. abRothe, R., et al. Deep expectation of real and apparent age from a single image without facial landmarks. IJCV, 2018.

10. Sun, B., Feng, J., and Saenko, K. Return of frustratingly easy domain adaptation. AAAI, 2016.

11. Agedb: The first manually collected, in-the-wild age database. CVPR Workshop, 2017.

12. Indoor segmentation and support inference from rgbd images. ECCV, 2012.

13. Semeval-2017 task 1: Semantic textual similarity multilingual and crosslingual focused evaluation. International Workshop on Semantic Evaluation, 2017.

14. The sleep heart health study: design, rationale, and methods. Sleep, 20(12):1077–1085, 1997.

15. Branco, P., Torgo, L., and Ribeiro, R. P. Smogn: a preprocessing approach for imbalanced regression. 2017.

16. Torgo, L., Ribeiro, R. P., Pfahringer, B., and Branco, P. Smote for regression. In Portuguese conference on artificial intelligence, 2013.

17. Tsung-Yi Lin, Priya Goyal, Ross Girshick, Kaiming He, and Piotr Dollár. Focal loss for dense object detection. ICCV, 2017.

編輯:王菁

校對(duì):龔力