ACCV2020國(guó)際細(xì)粒度網(wǎng)絡(luò)圖像識(shí)別冠軍方案解讀、經(jīng)驗(yàn)總結(jié)

極市導(dǎo)讀

?由極市平臺(tái)作為官方指定賽事平臺(tái)的ACCV2020國(guó)際細(xì)粒度網(wǎng)絡(luò)圖像識(shí)別大賽已順利結(jié)束。本文是本次大賽的冠軍團(tuán)隊(duì)對(duì)他們解決方案的解讀,包含數(shù)據(jù)清洗、backbones、BBN、混合精度訓(xùn)練、Tricks、模型融合等經(jīng)驗(yàn)。>>加入極市CV技術(shù)交流群,走在計(jì)算機(jī)視覺的最前沿

0. 團(tuán)隊(duì)介紹

團(tuán)隊(duì)來(lái)自NetEase Games AI Lab,成員分別為韋嘉,習(xí)思,徐文元,張偉東,排名不分先后。

|  |

|---|---|

| 韋嘉,NetEase Games AI Lab研究員 | 習(xí)思,NetEase Games AI Lab研究員 |

2. 數(shù)據(jù)集的挑戰(zhàn)

1.1. ?數(shù)據(jù)集概要

數(shù)據(jù)集是從網(wǎng)絡(luò)上收集的圖片數(shù)據(jù),jpg格式。

訓(xùn)練數(shù)據(jù)集:5000類共557169張圖片,含標(biāo)注信息(內(nèi)含標(biāo)簽噪聲)。數(shù)據(jù)集中包含的類別包括動(dòng)物和植物。

測(cè)試數(shù)據(jù)集:5000類共100000張圖片,不含標(biāo)注信息。

1.2. ?數(shù)據(jù)噪聲

臟數(shù)據(jù)

我們發(fā)現(xiàn)有很多臟樣本是無(wú)法學(xué)習(xí)的,并且有些類別并不屬于動(dòng)植物。

二義性圖片

我們注意到在同一張圖片上有不同的標(biāo)簽,例如,這兩張圖片在標(biāo)簽不同的情況下是完全相同的圖片。

長(zhǎng)尾分布

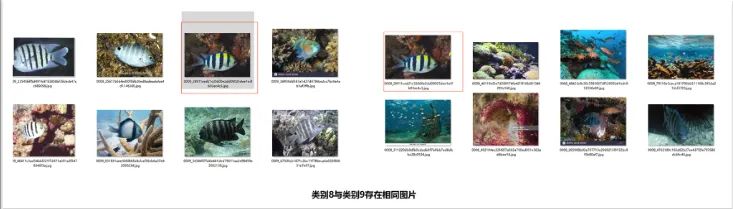

混亂類別

發(fā)現(xiàn)訓(xùn)練集中約5%的類別樣本過于混亂,似乎是其他類別樣本的混合

2. 解決方案

2.1 數(shù)據(jù)清洗

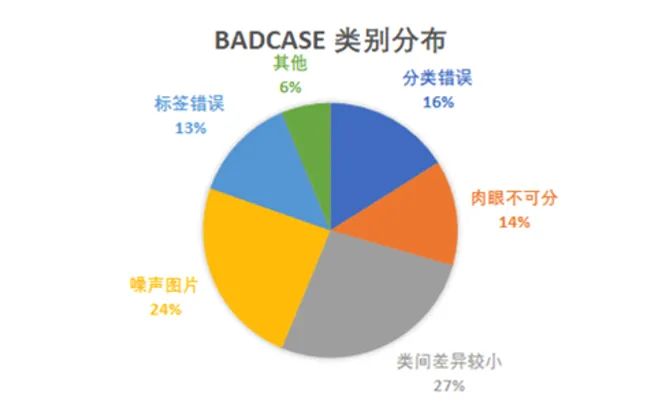

最先做的事情是清洗數(shù)據(jù)集。為了分析數(shù)據(jù)集,我們首先將訓(xùn)練數(shù)據(jù)集劃分為訓(xùn)練集和驗(yàn)證集,使用訓(xùn)練集訓(xùn)練模型并統(tǒng)計(jì)驗(yàn)證集badcase分布,具體分布如下圖。可以看出,在所有badcase中,噪聲圖片和錯(cuò)誤標(biāo)簽占比最多分別是24%和13%。噪聲至少占了badcase的37%左右,給訓(xùn)練增加了一定的難度,模型很大概率被不準(zhǔn)確的標(biāo)簽誤導(dǎo),因此該比賽清洗數(shù)據(jù)能提升較大的精度。

為了應(yīng)對(duì)這種情況,我們針對(duì)噪聲圖片和標(biāo)簽錯(cuò)誤嘗試了不同方法來(lái)清洗數(shù)據(jù)集。

首先為了清洗部分明顯的臟樣本,使用模型聚類來(lái)聚類并刪除共性大的臟樣本,例如地圖圖片,文章圖片,圖表等。

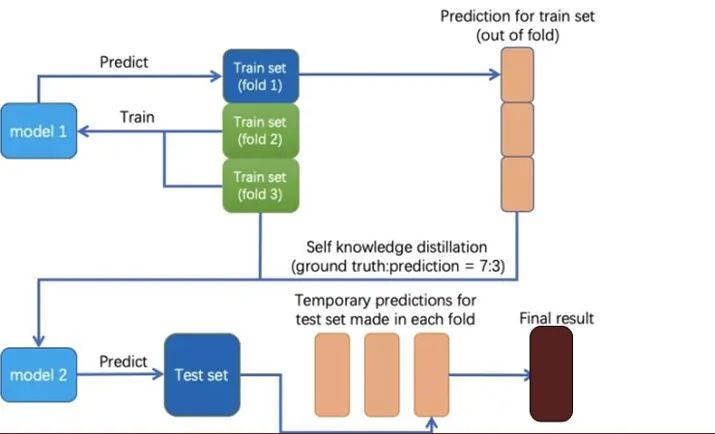

其次,我們使用自蒸餾的方法處理噪聲數(shù)據(jù)。根據(jù)分析發(fā)現(xiàn)數(shù)據(jù)集中存在大量的錯(cuò)誤標(biāo)簽和二義性樣本,為了降低模型的訓(xùn)練難度,我們將所有訓(xùn)練集圖片均分為五份,使用4份作為訓(xùn)練集并預(yù)測(cè)剩下數(shù)據(jù),完成五折模型訓(xùn)練,之后預(yù)測(cè)的每一折驗(yàn)證集組成所有數(shù)據(jù)集的out-of-fold結(jié)果文件,之后將out-of-fold結(jié)果與數(shù)據(jù)集的ground truth label按一定比例混合,組成了新的訓(xùn)練集標(biāo)簽,換句話說,我們給每一個(gè)大概率是噪聲樣本的圖片賦予了軟化后的標(biāo)簽,從而降低了模型訓(xùn)練難度。

最后,我們?cè)俑鶕?jù)新的訓(xùn)練集標(biāo)簽,進(jìn)一步清洗置信度過低的樣本,與此同時(shí),我們兼顧了類別平衡,降低少樣本類別被誤清除的概率,不至于部分類別圖片過少,加劇長(zhǎng)尾分布程度,增加模型訓(xùn)練難度。

我們也嘗試了其他的去噪方式,比如AUM Ranking等,通過訓(xùn)練模型給每一個(gè)樣本根據(jù)AUM指標(biāo)進(jìn)行排序。我們根據(jù)AUM刪除了部分圖片訓(xùn)練模型,從而導(dǎo)致精度明顯下降。AUM Ranking還是存在一些坑,我們最后放棄了該方法。

2.2 backbones

Backbones對(duì)模型的表現(xiàn)至關(guān)重要。我們使用efficientnet, resnet-based的模型和bbn作為backbones。我們可以看到下圖中這兩種類別之間的唯一區(qū)別是頭部紋理,帶注意力機(jī)制的backbones能夠聚焦于關(guān)鍵細(xì)節(jié),帶來(lái)更好的表現(xiàn)。

2.3 BBN

在數(shù)據(jù)分析中發(fā)現(xiàn)本次比賽中訓(xùn)練集是典型的長(zhǎng)尾分布。長(zhǎng)尾分布屬于極端的類別不平衡現(xiàn)象,這一現(xiàn)象會(huì)削弱一般分類的模型的分類能力。通常來(lái)說為了解決這一問題會(huì)使用類別再平衡方法,如從數(shù)據(jù)層面進(jìn)行再采樣,或者從損失函數(shù)角度進(jìn)行加權(quán)。

首先被嘗試的是在數(shù)據(jù)層面進(jìn)行樣本強(qiáng)制重采樣,在某些類別中少量的樣本被不斷重復(fù),但并沒有對(duì)訓(xùn)練起到太多積極作用。其次是使用focal loss和class balance loss這類加權(quán)損失函數(shù),但模型精度仍有0.2%~0.3%的下降。

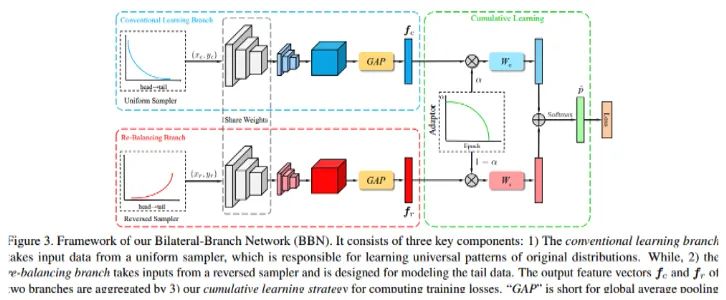

通過調(diào)研我們選擇了BBN結(jié)構(gòu),我們最好的單個(gè)模型也是由BBN訓(xùn)練的。BBN 模型由兩個(gè)分支構(gòu)成,即常規(guī)學(xué)習(xí)分支(Conventional Learning Branch)和再平衡分支(Re-Balancing Branch)。總體而言,BBN 的每個(gè)分支各自執(zhí)行其表征學(xué)習(xí)和分類器學(xué)習(xí)任務(wù)。顧名思義,常規(guī)學(xué)習(xí)分支為原始數(shù)據(jù)分布配備了典型的均勻采樣器(Uniform Sampler),可用于為識(shí)別任務(wù)學(xué)習(xí)通用的表征;再平衡分支則耦合了一個(gè)逆向的采樣器(Reversed Sampler),其目標(biāo)是建模尾部數(shù)據(jù)。接著,再通過累積學(xué)習(xí)(Cumulative Learning)將這些雙邊分支的預(yù)測(cè)輸出聚合起來(lái)。通過使用bbn訓(xùn)練resnet50,可以將Top 1準(zhǔn)確性提高10%以上。此外我們還使用bbn訓(xùn)練了其他的backbones,如resenxt,se-resnext,efficientnet等。

2.5 混合精度訓(xùn)練

上一小節(jié)中提到BBN能夠極大的提高模型精度,但事實(shí)上該模型的訓(xùn)練時(shí)間較長(zhǎng),gpu資源占用也比較多。以se-resnext50位主干的BBN在8張V100上不能以256的batchsize運(yùn)行。而batchsize的大小又直接影響了訓(xùn)練效果與耗時(shí)。

為了解決這一問題我們使用了pytorch的拓展插件apex,它能夠在只添加少量代碼的情況下使用自動(dòng)混合精度的技術(shù)來(lái)提高模型的資源占用和訓(xùn)練速度,提高生產(chǎn)力。在實(shí)際訓(xùn)練中我們使用的是O1模式,gpu資源占用能夠減少一半以上。為我們訓(xùn)練高分辨率的深層模型提供了可能。

2.6?Bag-of-Tricks

在模型訓(xùn)練的過程中也使用了很多tricks,并配置了大量算力資源。對(duì)于少樣本類別做了數(shù)據(jù)增廣和重采樣,并嘗試使用focal loss但表現(xiàn)不佳。同時(shí)在預(yù)測(cè)過程中使用ten-crop、multiscale及flip等TTA策略,模型精度有一定提高。與此同時(shí)增強(qiáng)模型泛化能力的Mixup和labelsmoothing也能提高模型性能。

以bbn-resnet50為例,baseline準(zhǔn)確度為55.7%。清理數(shù)據(jù)集后,精度可以提高2.6%,Mixup和label smoothing后,精度可以提高1.5%,使用三次KD后,精度可以提高1.1%。我們還使用許多其他技巧。這里不再贅述。

2.7?模型融合

在比賽中已經(jīng)訓(xùn)練了超過40個(gè)模型,不同的backbones,不同的分辨率,不同的訓(xùn)練策略。

最終最好的單一模型準(zhǔn)確性為68.9%。但是即使如此,融合三個(gè)精度較低(60%左右)但相關(guān)性低的模型(分辨率、loss、backbones等)仍改善性能。最后我們調(diào)整了模型權(quán)重,以增強(qiáng)更強(qiáng)大的模型,準(zhǔn)確率可以提高0.2%左右。

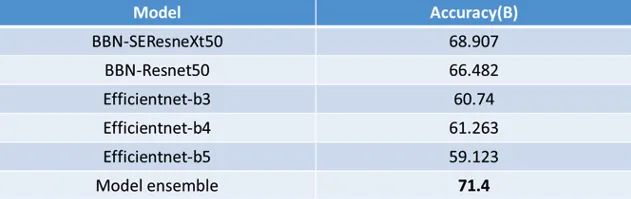

表中列出了我們5個(gè)模型的所有結(jié)果。最終,我們?cè)谂判邪馚中獲得71.4%的準(zhǔn)確度。

3 總結(jié)

3.1 我們做了什么

1) ACCV_WebFG5000數(shù)據(jù)集:5K類,具有大量噪聲的550K訓(xùn)練圖像;

2) 最終模型在B榜準(zhǔn)確性為71.4%,在挑戰(zhàn)賽中排名第一。

3.2 我們從競(jìng)賽中學(xué)到了什么

1) 適用于小型數(shù)據(jù)集的技巧可能不適用于大型數(shù)據(jù)集,需要不斷快速試錯(cuò)。

2) 數(shù)據(jù)集中具有多種類型的噪聲,在使用常規(guī)去噪方法的同時(shí),創(chuàng)新性的引入了類別均衡的去噪方法,提升模型去噪能力。

3) 在模型融合過程中相關(guān)度低的模型往往能夠取得更好的效果,高相關(guān)度模型融合可能會(huì)起到反向效果。

4)在計(jì)算資源有限的情況下,比起使用小模型,大模型的半精度訓(xùn)練不失為一個(gè)更好的選擇。

3.3 我們沒做什么

1)Backbone,在公開數(shù)據(jù)集上resnest精度高于resnext和efficientnet,但時(shí)間關(guān)系沒有進(jìn)行嘗試。

2)Ensemble,在模型融合階段目前采用的是voting,stacking等基于學(xué)習(xí)的方式由于步驟繁瑣,沒有進(jìn)行嘗試。

3)Unsupervised learning,使用moco或mocov2等無(wú)監(jiān)督方法獲得更為強(qiáng)大的特征提取能力。

報(bào)告下載

在?極市平臺(tái)?公眾號(hào)后臺(tái)回復(fù)“ACCV”,即可下載冠軍團(tuán)隊(duì)于ACCV2020 Workshop報(bào)告PPT。

參考文獻(xiàn)

【1】 Zhou, Boyan, et al. "BBN: Bilateral-Branch Network with Cumulative Learning for Long-Tailed Visual Recognition." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020.

【2】 Pleiss, Geoff, et al. "Identifying Mislabeled Data using the Area Under the Margin Ranking." arXiv preprint arXiv:2001.10528

【3】 He, Kaiming, et al. "Deep residual learning for image recognition." Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

【4】 Lin, Tsung-Yi, et al. "Focal loss for dense object detection." Proceedings of the IEEE international conference on computer vision. 2017.

【5】 Tan, Mingxing, and Quoc V. Le. "Efficientnet: Rethinking model scaling for convolutional neural networks." arXiv preprint arXiv:1905.11946 (2019).

【6】 He, Kaiming, et al. "Deep residual learning for image recognition." Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

【7】 Xie, Saining, et al. "Aggregated residual transformations for deep neural networks." Proceedings of the IEEE conference on computer vision and pattern recognition. 2017.

【8】 Hu, Jie, Li Shen, and Gang Sun. "Squeeze-and-excitation networks." Proceedings of the IEEE conference on computer vision and pattern recognition. 2018.

【9】 Zhang, Hongyi, et al. "mixup: Beyond empirical risk minimization." arXiv preprint arXiv:1710.09412 (2017).

【10】 Yun, Sangdoo, et al. "Cutmix: Regularization strategy to train strong classifiers with localizable features." Proceedings of the IEEE International Conference on Computer Vision. 2019.

【11】 He, Kaiming, et al. "Momentum contrast for unsupervised visual representation learning." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020.

【12】 Chen, Xinlei, et al. "Improved baselines with momentum contrastive learning." arXiv preprint arXiv:2003.04297 (2020).

推薦閱讀

目標(biāo)檢測(cè)類算法比賽的經(jīng)驗(yàn)總結(jié)

CVChain:一條用視覺競(jìng)賽和項(xiàng)目經(jīng)驗(yàn)打磨出的計(jì)算機(jī)視覺完整工具鏈

目標(biāo)檢測(cè)比賽中的tricks集錦