2022年最有開創(chuàng)性的10篇AI論文總結(jié)

本文我們總結(jié)了在2022年發(fā)表的最具開創(chuàng)性的10篇論文。

2022年隨著聊天GPT和Mid - journey和Dall-E等圖像生成器的流行,我們看到了整個人工智能領(lǐng)域的重大進展。在人工智能和計算機科學(xué)的時代,這是令人振奮的一年。

1、Alpha Tensor: Discovering faster matrix multiplication algorithms with reinforcement learning

Fawzi, A., Balog, M., Huang, A. et al. Discovering faster matrix multiplication algorithms with reinforcement learning. Nature 610, 47–53 (2022).

DeepMind 的研究人員開發(fā)了一種稱為 AlphaTensor 的深度強化學(xué)習(xí)方法,用于發(fā)現(xiàn)高效且準(zhǔn)確的矩陣乘法算法。矩陣乘法是一種廣泛用于各種系統(tǒng)的基礎(chǔ)計算,包括神經(jīng)網(wǎng)絡(luò)和科學(xué)計算例程。AlphaTensor 能夠發(fā)現(xiàn)在許多情況下優(yōu)于當(dāng)前最先進技術(shù)的算法,包括在使用有限域的 4x4 矩陣乘法方面取得的突破性成就。AlphaTensor 的靈活性還通過其發(fā)現(xiàn)結(jié)構(gòu)化矩陣乘法算法和針對特定硬件優(yōu)化矩陣乘法的能力得到證明。AlphaTensor 的潛在應(yīng)用從矩陣乘法擴展到其他基本計算任務(wù),展示了使用人工智能 (AI) 指導(dǎo)算法發(fā)現(xiàn)的潛力。該研究還表明,人工智能可用于解決數(shù)學(xué)和跨科學(xué)領(lǐng)域的重要挑戰(zhàn)。

AlphaTesor 的里程碑標(biāo)志著計算效率的重要性。隨著人工智能 (AI) 和數(shù)據(jù)中心的使用增加,考慮對環(huán)境的影響并確保以可持續(xù)和負(fù)責(zé)任的方式開發(fā)和使用人工智能非常重要。隨著世界越來越多地轉(zhuǎn)向碳中和社會,我們需要減少人工智能系統(tǒng)的能源消耗和碳排放。

2、Stable Diffusion: High-resolution image synthesis with latent diffusion models

Rombach, R., Blattmann, A., Lorenz, D., Esser, P., & Ommer, B. (2022). High-resolution image synthesis with latent diffusion models. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 10684–10695).

MidJourney, Dall-E和Imagen等模型所創(chuàng)造的精美的圖片都有一個重要的共同點,它們都依賴于擴散模型。研究人員開發(fā)了一種新的圖像合成方法,稱為 latent diffusion models(ldm),可以在一系列任務(wù)中獲得最先進的結(jié)果。

ldm使用去噪自編碼器和擴散模型將形成圖像的過程分解為一系列步驟,這允許在不需要重新訓(xùn)練的情況下控制圖像生成過程。傳統(tǒng)的擴散模型因為需要連續(xù)的評估,所以需要大量的計算資源和昂貴的使用,為了解決個問題研究人員在強大的預(yù)訓(xùn)練自編碼器的潛在空間中應(yīng)用了擴散模型。這使得他們在復(fù)雜性降低和細(xì)節(jié)保存之間達到了一個近乎最佳的點,極大地提高了視覺保真度。通過在模型架構(gòu)中引入交叉注意層,ldm可以用于一般的條件輸入,如文本或包圍框,并可以以卷積方式生成高分辨率圖像。ldm在圖像修補和類條件圖像合成方面取得了最新的成績,在文本到圖像合成、無條件圖像生成和超分辨率等任務(wù)上具有很強的競爭力,同時與傳統(tǒng)的基于像素的擴散模型相比,顯著降低了計算需求。

3、LaMDA: Language Models for Dialog Applications

Thoppilan, R., De Freitas, D., Hall, J., Shazeer, N., Kulshreshtha, A., Cheng, H. T., … & Le, Q. (2022). Lamda: Language models for dialog applications. arXiv preprint arXiv:2201.08239.

ChatGPT在互聯(lián)網(wǎng)上掀起了一場風(fēng)暴。這是一個聊天機器人,它模仿一對一的對話來回答問題,從能夠解決極端問題,或者從哲學(xué)角度回答關(guān)于生命意義。因為他的內(nèi)部工作機制的細(xì)節(jié)還沒有公布,所以我不會把ChatGPT包括在這個列表中。但是OpenAI的研究人員已經(jīng)開發(fā)了一個專門用于對話的新神經(jīng)語言模型,有多達1370億個參數(shù),被稱作LaMDA(對話應(yīng)用語言模型)。LaMDA使用1.56萬億詞的公共對話數(shù)據(jù)和網(wǎng)絡(luò)文本進行預(yù)訓(xùn)練,使其成為迄今為止最大的語言模型之一。雖然簡單地擴展語言模型可以提高其性能,但在提高安全性和事實基礎(chǔ)方面效果較差。為了解決這些挑戰(zhàn),研究人員使用帶注釋的數(shù)據(jù)對LaMDA進行了微調(diào),并使其能夠參考外部知識來源。

開發(fā)對話語言模型的主要挑戰(zhàn)之一是確保它們的回答符合人類價值觀,例如防止有害的建議和不公平的偏見。為了解決這個問題,研究人員使用了一個經(jīng)過少量注釋數(shù)據(jù)微調(diào)的LaMDA分類器來過濾候選響應(yīng)。這種方法顯示出了提高模型安全性的希望。

另一個挑戰(zhàn)是使模型能夠參考外部知識來源,如信息檢索系統(tǒng)或簡單的計算器,來生成基于已知事實而不僅僅是聽起來似是而非的的響應(yīng),研究人員發(fā)現(xiàn)他們的方法使LaMDA能夠通查詢外部知識來源產(chǎn)生更多基于事實的回應(yīng)。

除了這些技術(shù)成就,研究人員還探索了LaMDA在教育和內(nèi)容推薦領(lǐng)域的使用,分析了它在這些領(lǐng)域的幫助和角色一致性。總的來說,LaMDA的發(fā)展代表了自然語言處理領(lǐng)域的重大進步,并有潛力改進廣泛的基于對話的應(yīng)用程序。

4、A ConvNet for the 2020s

Liu, Z., Mao, H., Wu, C. Y., Feichtenhofer, C., Darrell, T., & Xie, S. (2022). A convnet for the 2020s. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 11976–11986).

在過去的十年里,隨著ViTs的引入,視覺識別領(lǐng)域發(fā)生了重大變化。雖然普通vit在一般計算機視覺任務(wù)(如對象檢測和語義分割)方面取得了一些成功,但真正在這些領(lǐng)域產(chǎn)生影響的是分層 Transformer,例如 Swin Transformers。但是這些混合方法的有效性通常歸因于 Transformer 的優(yōu)越性,而不是卷積固有的歸納偏差。

在最近的一項研究中,研究人員著手測試純 ConvNet 所能達到的極限。他們逐漸對標(biāo)準(zhǔn) ResNet 進行“現(xiàn)代化”以靠近Transformer,并發(fā)現(xiàn)了導(dǎo)致兩者性能差異的幾個關(guān)鍵組件。這種探索的結(jié)果是稱為 ConvNeXts 的純 ConvNet 模型系列。ConvNeXts 完全由標(biāo)準(zhǔn)的 ConvNet 模塊構(gòu)建而成,能夠在準(zhǔn)確性和可擴展性方面與 Transformers 相媲美,并且保持了標(biāo)準(zhǔn) ConvNet 的簡單性和效率。

5、OpenAI Whisper: Robust Speech Recognition via Large-Scale Weak Supervision

Radford, A., Kim, J. W., Xu, T., Brockman, G., McLeavey, C., & Sutskever, I. (2022). Robust speech recognition via large-scale weak supervision. arXiv preprint arXiv:2212.04356.

Whisper 是 OpenAI 的開源的用于轉(zhuǎn)錄的AI 模型。它是一種基于 Transformer 架構(gòu)的大規(guī)模音頻模型,使用從網(wǎng)絡(luò)收集的超過 600,000 小時的多語言和多任務(wù)監(jiān)督數(shù)據(jù)進行了訓(xùn)練。模型能夠以30秒為單位處理音頻記錄,并使用編碼器部分對音頻進行編碼,然后由解碼器使用該部分來預(yù)測正在說的標(biāo)記或單個單詞。解碼器使用這一編碼信息,以及預(yù)測的前一個單詞,來猜測下一個最有意義的單詞。

Whisper 的主要優(yōu)勢之一是它的穩(wěn)健性,它使用了各種數(shù)據(jù)集進行訓(xùn)練,包括剪輯、TED 演講、播客和訪談。雖然其中一些數(shù)據(jù)是使用機器學(xué)習(xí)模型轉(zhuǎn)錄的(這可能會引入錯誤),但也有助于模型更好地處理實際的場景。雖然 Whisper 可能不是針對特定任務(wù)的最強大模型,但可以使用其他數(shù)據(jù)對其進行微調(diào),以提高其在特定任務(wù)上的性能。事實證明,微調(diào)像 Whisper 這樣的預(yù)訓(xùn)練模型比在特定任務(wù)上從頭開始訓(xùn)練模型產(chǎn)生更好的結(jié)果。

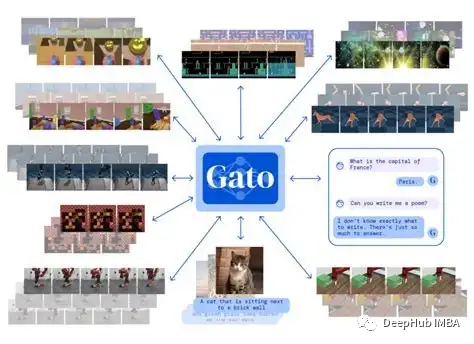

6、Gato DeepMind: General AI

Reed, S. et al. (2022). A Generalist Agent. DeepMind

DeepMind開發(fā)了一種名為Gato的的多模態(tài)模型,它利用基于 Transformer 的架構(gòu)來執(zhí)行各種任務(wù)。Gato能夠處理廣泛的輸入,包括文本、圖像和機械臂的扭矩數(shù)據(jù),并產(chǎn)生一系列輸出,包括可理解的文本、扭矩功率和按鈕按下。這意味著Gato可以用于執(zhí)行廣泛的任務(wù),包括語言翻譯和圖像字幕,甚至可以玩雅達利游戲,它可以執(zhí)行604種不同的任務(wù)。Gato的主要優(yōu)勢之一是它的多功能性。Gato不需要為不同的任務(wù)訓(xùn)練和集成多個專門的模型,而是可以用一組權(quán)重和一個相對簡單的架構(gòu)處理所有這些任務(wù)。這使得它比以前的方法更高效、更經(jīng)濟,因為以前的方法通常需要開發(fā)多個專門的模型。

Gato的發(fā)展代表著通用人工智能發(fā)展邁出了重要一步。它特別強調(diào)了多模態(tài)方法的潛力,包括集成多種類型的數(shù)據(jù),以提高學(xué)習(xí)和性能。像Gato這樣的模型在提取見解和解決復(fù)雜問題方面將變得越來越重要。但是Gato還是有其局限性。因為它不是一種純粹的多任務(wù)模型方法,與單任務(wù)模型相比,它的性能有限。

7、Bootstrapped Meta-Learning

Flennerhag, S., Schroecker, Y., Zahavy, T., van Hasselt, H., Silver, D., & Singh, S. (2021). Bootstrapped meta-learning. arXiv preprint arXiv:2109.04504.

在這篇論文中,研究人員提出了一種新的算法,允許人工智能系統(tǒng)通過稱為元學(xué)習(xí)的過程學(xué)習(xí)如何更有效地學(xué)習(xí)。這個過程包括克服一個稱為元優(yōu)化的困難優(yōu)化問題。這種被稱為自舉的新算法通過允許人工智能系統(tǒng)自我學(xué)習(xí)來解決這個問題。該算法首先為AI系統(tǒng)創(chuàng)建一個目標(biāo),然后通過最小化系統(tǒng)與目標(biāo)之間的距離來優(yōu)化系統(tǒng)。

研究人員專注于在元學(xué)習(xí)中使用梯度,并建立確保性能提高的條件。他們還發(fā)現(xiàn)所選擇的度量可以控制元優(yōu)化,并且自舉機制可以有效擴展元學(xué)習(xí)范圍,而不需要通過所有更新進行反向傳播。這種算法能夠在雅達利ALE基準(zhǔn)上實現(xiàn)新的最先進的無模型代理。他們還證明了該算法可以在多任務(wù)元學(xué)習(xí)中提高性能和效率。

研究人員探索了如何在元學(xué)習(xí)中開辟新的可能性,并發(fā)現(xiàn)無需通過更新規(guī)則進行反向傳播就可以在epsilon-greedy Q-learning agent中進行元學(xué)習(xí)的高效探索。這種新算法有可能通過元學(xué)習(xí)顯著提高人工智能系統(tǒng)的效率。

8、Tabular Data: Deep Learning is Not All You Need

Shwartz-Ziv, R., & Armon, A. (2022). Tabular data: Deep learning is not all you need. Information Fusion, 81, 84–90.

這篇論文比較了樹集成模型XGBoost與幾種深度學(xué)習(xí)模型在不同表格數(shù)據(jù)集上的分類和回歸任務(wù)性能。結(jié)果表明,XGBoost的表現(xiàn)始終優(yōu)于深度學(xué)習(xí)模型,包括之前聲稱深度模型性能優(yōu)越的論文中使用的那些模型。該研究發(fā)現(xiàn)XGBoost需要的調(diào)優(yōu)比深度學(xué)習(xí)模型要少得多。XGBoost和深度學(xué)習(xí)模型的集成在數(shù)據(jù)集上的表現(xiàn)比單獨XGBoost更好。這些發(fā)現(xiàn)表明,XGBoost仍應(yīng)被視為數(shù)據(jù)科學(xué)項目中表格數(shù)據(jù)的首選。并強調(diào)人工智能并不局限于深度學(xué)習(xí),而是有不同的解決方案。

9、Imagen Video: High Definition Video Generation with Diffusion Models

Ho, J., Chan, W., Saharia, C., Whang, J., Gao, R., Gritsenko, A., … & Salimans, T. (2022). Imagen video: High definition video generation with diffusion models. arXiv preprint arXiv:2210.02303.

一種名為 Imagen Video 的新型文本條件視頻生成系統(tǒng)使用基礎(chǔ)視頻生成模型和一系列交錯的空間和時間視頻超分辨率模型,可以根據(jù)給定的文本提示生成高清視頻。該系統(tǒng)可擴展為文本到高清視頻模型,它利用各種分辨率的全卷積時間和空間超分辨率模型以及擴散模型的 v 參數(shù)化。研究人員還將漸進式蒸餾應(yīng)用于視頻模型,可以在不使用分類器的情況下進行快速和高質(zhì)量的采樣。Imagen Video 不僅可以生成高保真度的視頻,還具有高度的可控性和世界知識,包括生成各種藝術(shù)風(fēng)格和 3D 對象理解的多樣化視頻和文本動畫的能力。

10、 A Path Towards Autonomous Machine Intelligence Version 0.9.2

LeCun, Y. (2022). A path towards autonomous machine intelligence version 0.9. 2, 2022–06–27. Open Review, 62.

研究人員提出了一種用于創(chuàng)建智能機器的新架構(gòu)和訓(xùn)練范式。該論文概述了構(gòu)建自主智能代理的潛在解決方案,這些代理可以以類似于人類和動物的方式學(xué)習(xí)和推理。所提出的架構(gòu)包括一個可配置的預(yù)測世界模型和由內(nèi)在動機驅(qū)動的動作行為,利用經(jīng)過自我監(jiān)督學(xué)習(xí)訓(xùn)練的分層聯(lián)合嵌入。目標(biāo)是使機器能夠在多個抽象層次上學(xué)習(xí)感知和行動計劃的表示,使它們能夠在多個時間范圍內(nèi)進行推理、預(yù)測和計劃。

編輯:王菁

校對:林亦霖