2021年,機(jī)器學(xué)習(xí)研究風(fēng)向要變了?

↑↑↑點(diǎn)擊上方藍(lán)字,回復(fù)資料,10個(gè)G的驚喜

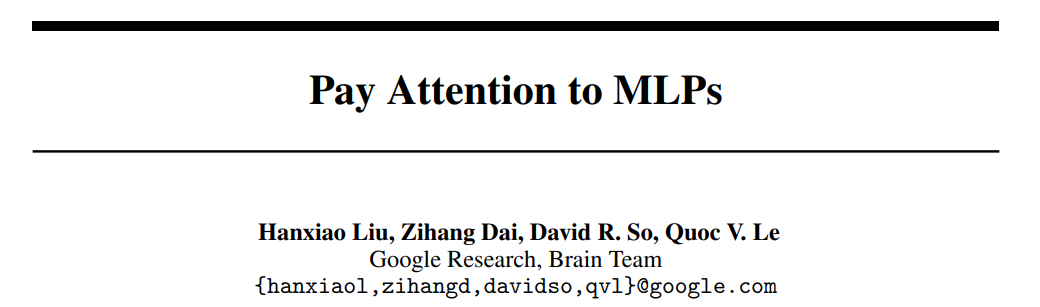

在機(jī)器學(xué)習(xí)領(lǐng)域里有一句俗話:「Attention is all you need」,通過注意力機(jī)制,谷歌提出的 Transformer 模型引領(lǐng)了 NLP 領(lǐng)域的大幅度進(jìn)化,進(jìn)而影響了 CV 領(lǐng)域,甚至連論文標(biāo)題本身也變成了一個(gè)梗,被其后的研究者們不斷重新演繹。

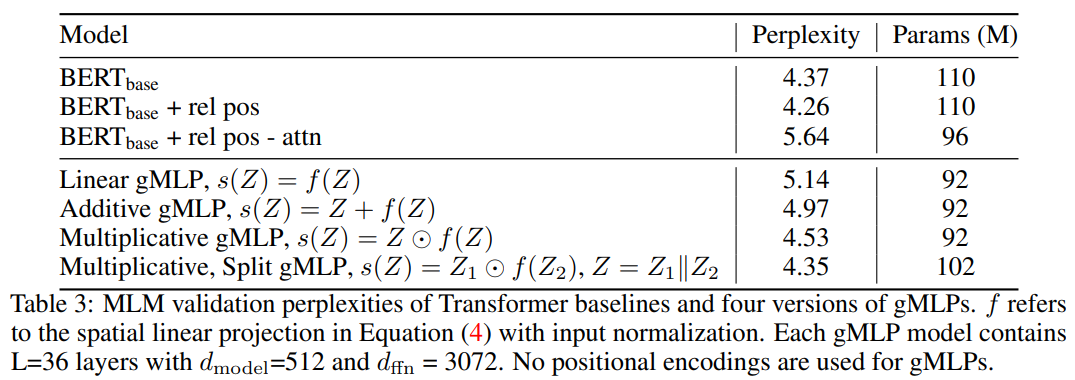

具有 Transformer 架構(gòu)和可學(xué)得絕對(duì)位置嵌入的 BERT;

具有 Transformer 架構(gòu)和 T5-style 可學(xué)得相對(duì)位置偏差的 BERT;

同上,但在 softmax 內(nèi)部移除了所有與內(nèi)容有關(guān)的項(xiàng),并僅保留相對(duì)位置偏差。

也可以加一下老胡的微信 圍觀朋友圈~~~

推薦閱讀

(點(diǎn)擊標(biāo)題可跳轉(zhuǎn)閱讀)

老鐵,三連支持一下,好嗎?↓↓↓

評(píng)論

圖片

表情