2021機器學(xué)習(xí)研究風(fēng)向是啥?MLP→CNN→Transformer→MLP!

點擊下方卡片,關(guān)注“新機器視覺”公眾號

視覺/圖像重磅干貨,第一時間送達

來源:機器之心

就在2月份,Transformer還橫掃CV和NLP各種task。但到了5月份,似乎一切變了。近來,谷歌、清華、Facebook相繼發(fā)表了關(guān)于多層感知機(MLP)的工作,MLP→CNN→Transformer→MLP似乎已經(jīng)成為一種大勢所趨。我們來看下最新的幾篇代表性論文。

12月:“圖像識別也是Transformer最強(ViT)”

2月:“Transformer is All you Need”

3月:“Attention is not All you Need”

5月:“在MLP上的ViT并(MLPmixer)”

5月:“Convolution比Transformer強”

5月:“在MLP上加個門,跨越Transformer (Pay Attention to MLPs)”

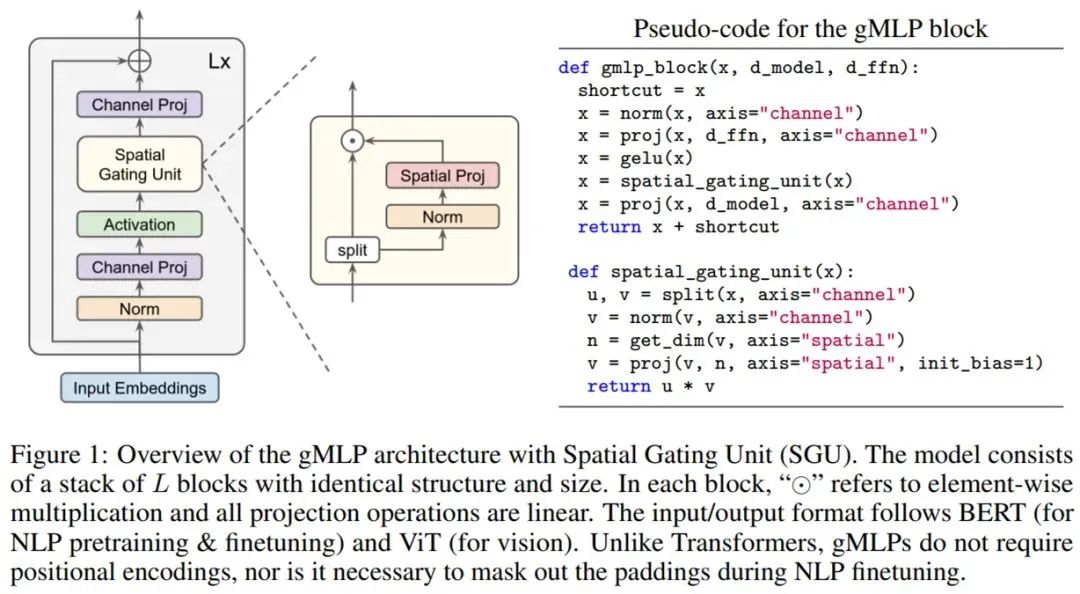

谷歌大腦首席科學(xué)家、AutoML鼻祖Quoc Le研究團隊將gMLP用于圖像分類任務(wù),并在ImageNet數(shù)據(jù)集上取得了非常不錯的結(jié)果。在類似的訓(xùn)練設(shè)置下,gMLP實現(xiàn)了與DeiT(一種改進了正則化的ViT模型)相當(dāng)?shù)男阅堋2粌H如此,在參數(shù)減少66%的情況下,gMLP的準確率比MLP-Mixer高出3%。這一系列的實驗結(jié)果對ViT模型中自注意力層的必要性提出了質(zhì)疑。

他們還將gMLP應(yīng)用于BERT的掩碼語言建模(MLM)任務(wù),發(fā)現(xiàn)gMLP在預(yù)訓(xùn)練階段最小化困惑度的效果與Transformer一樣好。該研究的實驗表明,困惑度僅與模型的容量有關(guān),對注意力的存在并不敏感。隨著容量的增加,研究者觀察到,gMLP的預(yù)訓(xùn)練和微調(diào)表現(xiàn)的提升與Transformer一樣快。

gMLP的有效性,視覺任務(wù)上自注意力和NLP中注意力機制的case-dependent不再具有優(yōu)勢,所有這些都令研究者對多個領(lǐng)域中注意力的必要性提出了質(zhì)疑。

總的來說,該研究的實驗結(jié)果表明,自注意力并不是擴展ML模型的必要因素。隨著數(shù)據(jù)和算力的增加,gMLP等具有簡單空間交互機制的模型具備媲美Transformer的強大性能,并且可以移除自注意力或大幅減弱它的作用。

整個模型具有空間門控單元(Spatial Gating Unit, SGU)的gMLP架構(gòu)示意圖如下所示,該模型由堆疊的 L塊(具有相同的結(jié)構(gòu)和大小)組成。

谷歌原ViT團隊提出了一種不使用卷積或自注意力的MLP-Mixer架構(gòu),并且在設(shè)計上非常簡單,在 ImageNet 數(shù)據(jù)集上也實現(xiàn)了媲美CNN和ViT的性能。

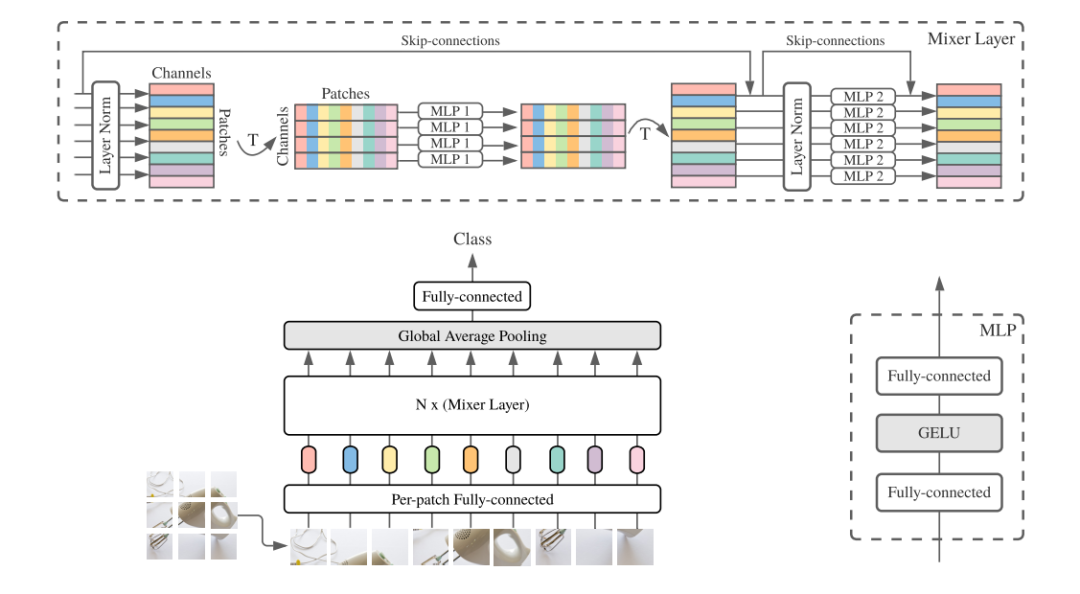

卷積神經(jīng)網(wǎng)絡(luò)(CNNs)是計算機視覺的主流模型,近年來,基于注意力的網(wǎng)絡(luò),如vision transformer也得到了廣泛的應(yīng)用。2021年3月4日,谷歌人工智能研究院Ilya Tolstikhin, Neil Houlsby等人研究員提出一種基于多層感知機結(jié)構(gòu)的MLP-Mixer并在頂會“Computer Vision and Pattern Recognition(CVPR)”上發(fā)表一篇題為“MLP-Mixer: An all-MLP Architecture for Vision”的文章。MLP-Mixer包含兩種類型的MLP層:一種是獨立應(yīng)用于圖像patches的MLP(即“混合”每個位置特征),另一種是跨patches應(yīng)用的MLP(即“混合”空間信息)。當(dāng)在大數(shù)據(jù)集上訓(xùn)練時,或使用正則化訓(xùn)練方案時,MLP-Mixer在圖像分類基準上獲得有競爭力的分數(shù),并且預(yù)訓(xùn)練和推理成本與最先進的模型相當(dāng)。作者希望這些結(jié)果能激發(fā)出更深入的研究,超越成熟的CNN和transformer領(lǐng)域。

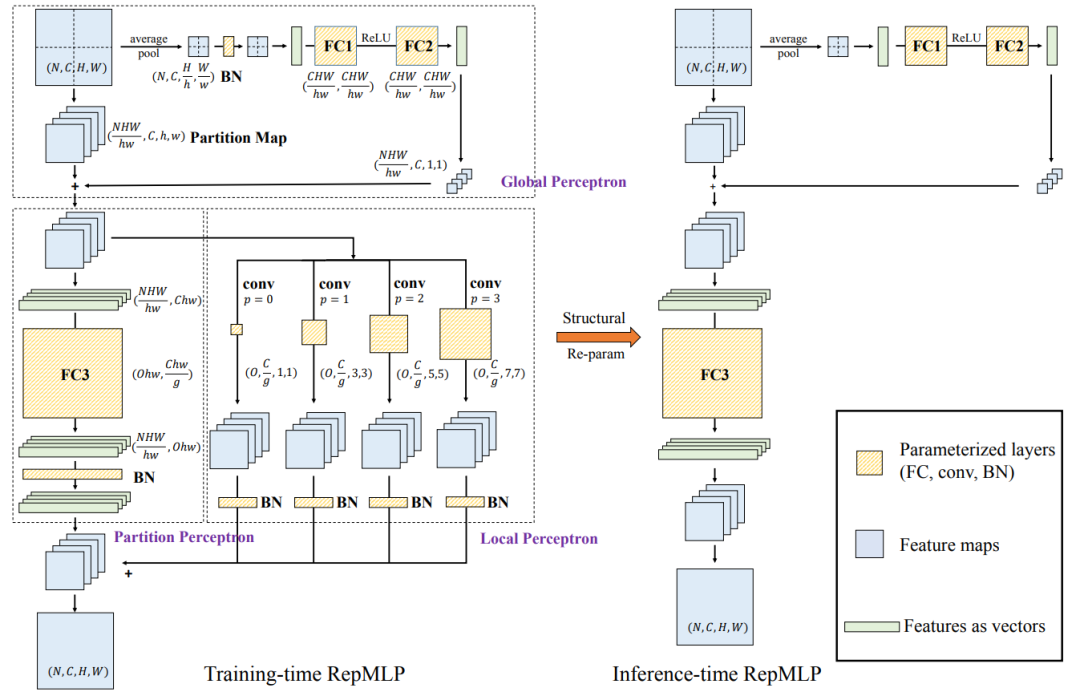

MLP-Mixer的網(wǎng)絡(luò)結(jié)構(gòu)圖

作者提出一種基于多層感知機結(jié)構(gòu)的MLP-Mixer,這是一種不使用注意力機制和卷積的網(wǎng)絡(luò)。MLP-Mixer的體系結(jié)構(gòu)完全基于多層感知機,將圖像的空間位置或特征通道上進行重復(fù)應(yīng)用。MLP-Mixer僅依賴于基礎(chǔ)矩陣乘操作、數(shù)據(jù)排布變換(比如reshape、transposition)以及非線性層。

上圖給出了MLP-Mixer的網(wǎng)絡(luò)結(jié)構(gòu)圖。首先跟Vision Transformer的patch image過程一樣,將輸入尺寸為H×W×C的圖像變?yōu)镹×D的向量,其中P×P為圖像塊的大小,N=HW÷P2,N是圖像塊的數(shù)量,D是將圖像塊reshape為固定長度的大小,為了避免由于圖像塊設(shè)置大小不同,造成模型無法固定訓(xùn)練的問題。然后由多個Mixer layer組成,其中Mixer layer使用兩種類型的MLP層:信道混合MLP和空間混合MLP。信道混合MLP允許不同信道之間的通信;它們獨立地對每個空間位置進行操作。空間混合MLP允許不同空間位置之間的通信;它們獨立地對每個通道上進行操作。在Mixer layer里面也應(yīng)用到跳躍連接。最后通過LayerNorm和全連接層進行輸出。

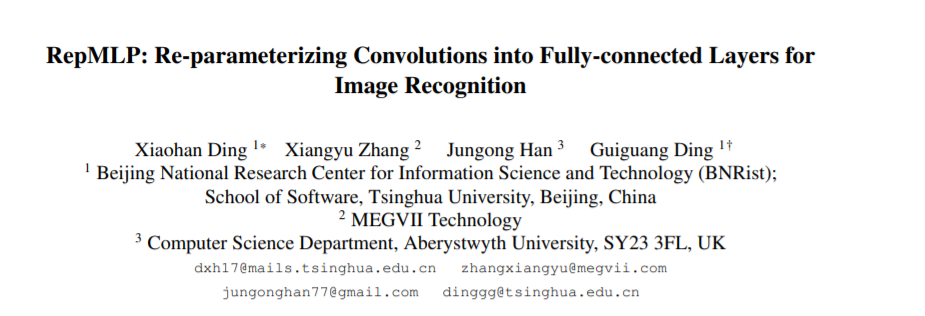

本文的工作主要將MLP作為卷積網(wǎng)絡(luò)的一種通用組件實現(xiàn)多種任務(wù)性能提升(例如,將ResNet50中的3x3卷積替換成只有一半通道數(shù)量的RepMLP,可以實現(xiàn)同等精度下超過一半速度提升),不追求拋棄卷積的純MLP(本文只試驗了CIFAR上的純MLP,只取得了接近卷積網(wǎng)絡(luò)的效果);恰恰相反,本文利用了卷積去強化FC,使其具備局部性,因而更適用于視覺任務(wù)。

本文的方法可以在ImageNet、語義分割、人臉識別等數(shù)據(jù)集和相應(yīng)任務(wù)上實現(xiàn)漲點,這些任務(wù)輸入分辨率各不相同,有的具有平移不變性而有的不具備(本文認為FC和卷積主要的區(qū)別就在于是否平移不變);而谷歌的論文只做了幾個固定分辨率輸入的圖像分類實驗。

本文提出了一種多層感知機(MLP)模式的圖像識別神經(jīng)網(wǎng)絡(luò)構(gòu)造塊RepMLP,它由一系列全連接層(FC)組成。

圖注:RepMLP的架構(gòu)圖

與卷積層相比,F(xiàn)C層效率更高,更適合于建模長程(long-range)依賴關(guān)系和位置模式,但不適合捕獲局部結(jié)構(gòu),因此通常不太適合用于圖像識別。而本文提出了一種結(jié)構(gòu)重新參數(shù)化技術(shù),可以將局部先驗加入到全連接層(FC)中,使其具有強大的圖像識別能力。

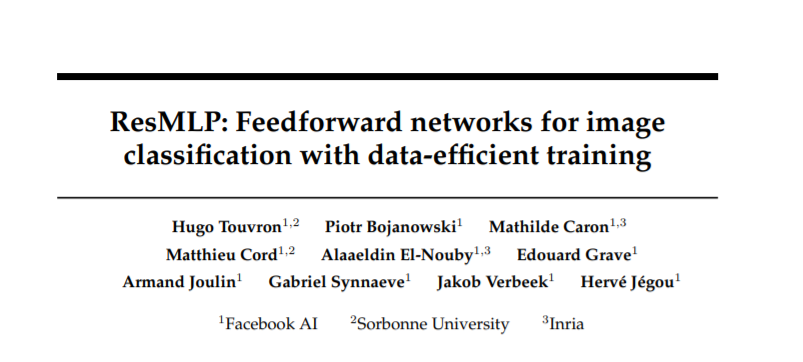

Facebook也于近日提出了一種用于圖像分類的純MLP架構(gòu),該架構(gòu)受 ViT 的啟發(fā),但更加簡單:不采用任何形式的注意力機制,僅僅包含線性層與GELU非線性激活函數(shù)。

https://www.zhuanzhi.ai/paper/906513635482cdda897acaf1860abef4

本文第一作者就是DeiT 一作Hugo Touvron博士。他曾經(jīng)針對視覺Transformer模型ViT需要大量數(shù)據(jù)集訓(xùn)練的難題提出了DeiT模型,通過一組優(yōu)秀的超參數(shù)和蒸餾操作實現(xiàn)了僅僅使用ImageNet數(shù)據(jù)集就能達到很強的性能,詳見下面鏈接。現(xiàn)在他又按照這個思路寫了一篇,針對視覺MLP模型MLP-Mixer需要大量數(shù)據(jù)集訓(xùn)練的難題提出了ResMLP模型,通過殘差結(jié)構(gòu)和蒸餾操作實現(xiàn)了僅僅使用ImageNet數(shù)據(jù)集就能達到很強的性能。

參考鏈接:

https://mp.weixin.qq.com/s/6mUdc2N1jAlh0pW8QIknoA

—版權(quán)聲明—

僅用于學(xué)術(shù)分享,版權(quán)屬于原作者。

若有侵權(quán),請聯(lián)系微信號:yiyang-sy 刪除或修改!