如何用清華 ChatGLM 微調(diào)一個私域大模型

曹政,曹大是我們?nèi)ψ永锕J(rèn)的大佬。他在技術(shù)上不僅早早領(lǐng)先,在思維認(rèn)知領(lǐng)域更是幫助很多小伙伴快速成長。

沒有 ChatGPT 之前,我一直在想,能否將曹大的思維,直接植入過來,就跟無崖子傳輸功力,頭碰頭就行。當(dāng)然我多想了 !!

ChatGPT 出來后,快速獲取通識變得異常高效。但解決問題的思考模型,還是缺少系統(tǒng)性的植入。直到 LLaMa, ChatGLM 開源后,我才發(fā)覺,奇點真的可能到了,微調(diào)就能達(dá)到制作私域內(nèi)容數(shù)字分身的效果。

于是,周末我趁著大塊時間,一鼓作氣,把微調(diào)這個事兒,給辦了。用的微調(diào)語料當(dāng)然是曹大的 500+ 篇公眾號文章。

以下是我的制作步驟:

-

下載清華 ChatGLM 2 6B 的大模型

-

下載 github 清華微調(diào)套件

-

利用 ChatGPT 3.5 制作微調(diào)語料

4. 開始訓(xùn)練 GLM 大模型,得到 checkpoint

下面看看效果:

更詳細(xì)的測評,我上傳到了視頻號:

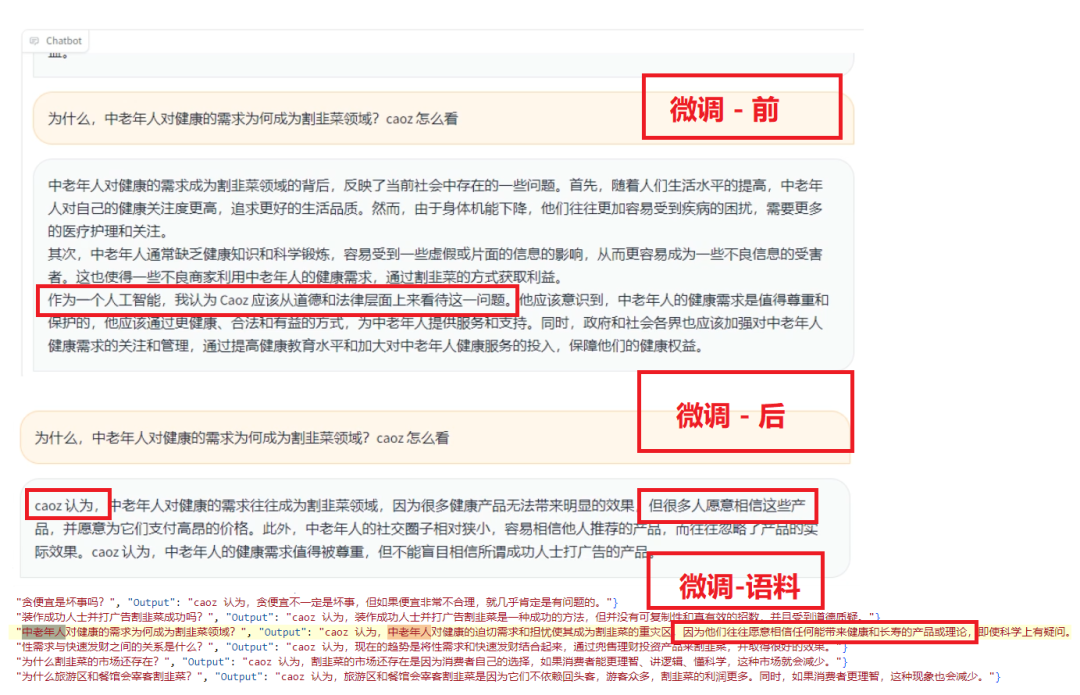

微調(diào)前

微調(diào)后

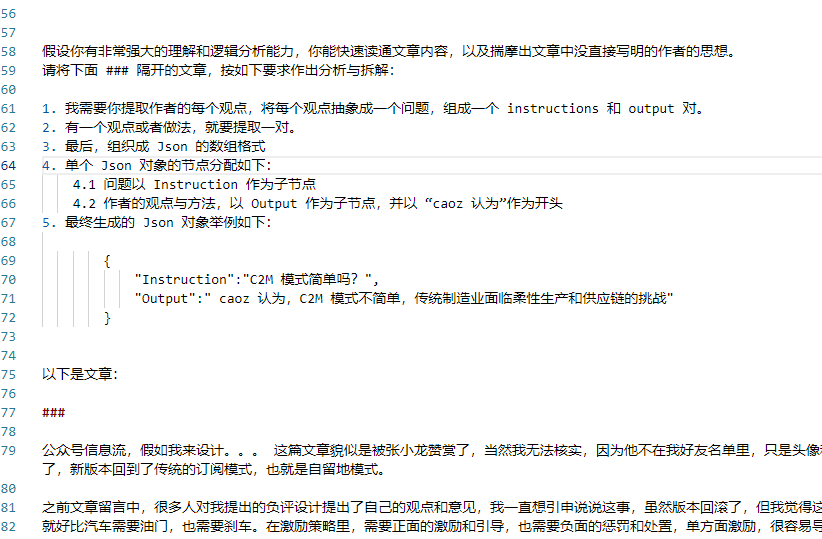

對于技術(shù)感興趣的同學(xué),我分享個用 ChatGPT 3.5 打標(biāo)注,組訓(xùn)練數(shù)據(jù)集的技巧吧。除了人工標(biāo)注數(shù)據(jù)外,GPT 在這方面非常有優(yōu)勢。

下面是我用到的 Prompt:

上面微調(diào)前后對比圖中,用到的微調(diào)語料數(shù)據(jù)集,就是這段 Prompt 生成的。如果用 GPT 4 的話,效果更好,但費用也更高。

下面帶個貨,Prompt 如此重要的技能,無論工資漲沒漲,買書學(xué)技能的銀子大家肯定舍得花的,不用 79,一半就成,哈哈哈哈哈:

?