「深度學(xué)習(xí)注意力機制 」TKDE 2022研究綜述

??新智元報道??

??新智元報道??

來源:專知

【新智元導(dǎo)讀】注意力機制(Attention Mechanism)是深度學(xué)習(xí)中常用的模塊,作為一種資源分配方案,將有限的計算資源用來處理更重要的信息,是解決信息超載問題的主要手段。下面這篇是來自Erasmus University的Gianni Brauwers和Flavius Frasincar在TKDE上發(fā)表的《深度學(xué)習(xí)注意力機制》綜述論文。

注意力是一種重要的機制,可用于跨許多不同領(lǐng)域和任務(wù)的各種深度學(xué)習(xí)模型。這項綜述提供了一個關(guān)于深度學(xué)習(xí)注意力機制的重要概述。

各種注意力機制通過一個由注意力模型,統(tǒng)一符號,和一個全面的分類注意力機制組成的框架來進行解釋。

在此基礎(chǔ)上,本文綜述了注意力模型評價的各種方法,并討論了基于該框架的注意力模型結(jié)構(gòu)表征方法。最后,對注意力模型領(lǐng)域的未來工作進行了展望。

論文鏈接:https://ieeexplore.ieee.org/document/9609539/

引言

模擬人類注意力的想法最早出現(xiàn)在計算機視覺領(lǐng)域,試圖通過引入一個只關(guān)注圖像特定區(qū)域而不是整個圖像的模型來降低圖像處理的計算復(fù)雜度,同時提高性能。

然而,我們今天所知道的注意力機制的真正起點通常是源于自然語言處理領(lǐng)域。Bahdanau等人的在機器翻譯模型中實現(xiàn)了注意力,以解決循環(huán)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)中的某些問題。

在Bahdanau等人的強調(diào)了注意力的優(yōu)點后,注意力技術(shù)得到了改進,并迅速流行于各種任務(wù),如文本分類、圖像字幕、情感分析,以及語音識別。

注意力已經(jīng)成為深度學(xué)習(xí)中的一種流行技術(shù),原因有幾個。首先,整合了注意力機制的模型在上述所有任務(wù)和許多其他任務(wù)中都獲得了最先進的結(jié)果。

大多數(shù)注意力機制可以與基本模型聯(lián)合訓(xùn)練,如使用規(guī)則反向傳播的循環(huán)神經(jīng)網(wǎng)絡(luò)或卷積神經(jīng)網(wǎng)絡(luò)。注意力向神經(jīng)網(wǎng)絡(luò)模型引入了一種特定類型的解釋,這種解釋通常被認為非常復(fù)雜。

Transformer模型的引入進一步證明了注意力的有效性,進一步提高了注意力機制的受歡迎程度。注意力最初是作為循環(huán)神經(jīng)網(wǎng)絡(luò)的擴展而引入的。然而,在中提出的Transformer模型是注意力研究的一個重大發(fā)展,因為它證明了注意力機制足以建立一個最先進的模型。

這意味著可以避免一些缺點,比如遞歸神經(jīng)網(wǎng)絡(luò)特別難以并行化的事實。就像引入最初的注意力機制一樣,Transformer模型是為機器翻譯創(chuàng)建的,但很快就被用于其他任務(wù),如圖像處理、視頻處理和推薦系統(tǒng)。

本綜述的目的是解釋注意力的一般形式,并提供一個在深度學(xué)習(xí)注意力技術(shù)的全面概述。本綜述與之前的研究主要區(qū)別在于,其他的綜述一般都關(guān)注某個領(lǐng)域內(nèi)的注意力模型。然而,這項綜述提供了一個跨領(lǐng)域的注意力技術(shù)概述。

我們將以一種通用的方式討論注意力技術(shù),使它們能夠被理解并應(yīng)用于各種領(lǐng)域。我們發(fā)現(xiàn)以往研究中提出的分類方法缺乏恰當區(qū)分各種注意力機制所需的深度和結(jié)構(gòu)。某些重要的注意力技巧在以前的綜述中還沒有得到適當?shù)挠懻摚渌岢龅淖⒁饬C制似乎缺乏技術(shù)細節(jié)或直觀的解釋。

因此,在本文中,我們通過使用統(tǒng)一符號的單一框架,結(jié)合技術(shù)和直觀的解釋,提出了重要的注意力技術(shù),并對注意力機制進行了全面的分類。

通用注意力模型

本節(jié)介紹一種注意力一般性與相應(yīng)的符號。本節(jié)中介紹的框架將在本文的其余部分中使用。

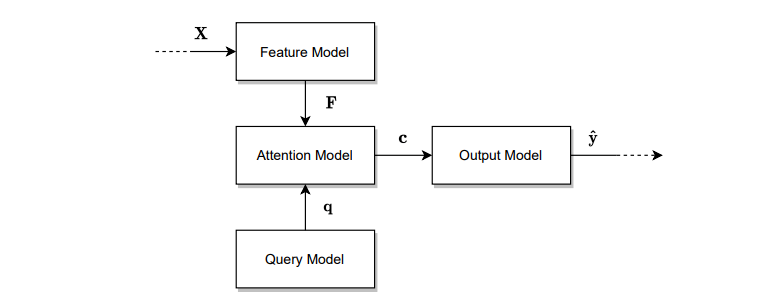

為了實現(xiàn)一個通用的注意力模型,首先需要描述一個可以使用注意力的模型的一般特征。首先,我們將完整的模型稱為任務(wù)模型。這個模型只接受一個輸入,執(zhí)行指定的任務(wù),并產(chǎn)生所需的輸出。

例如,任務(wù)模型可以是一種語言模型,它將一段文本作為輸入,并將內(nèi)容摘要、情緒分類或逐字翻譯成另一種語言的文本作為輸出。或者,任務(wù)模型可以獲取圖像,并為該圖像生成標題或分割。任務(wù)模型由四個子模型組成: 特征模型、查詢模型、注意力模型和輸出模型。

注意力分類法

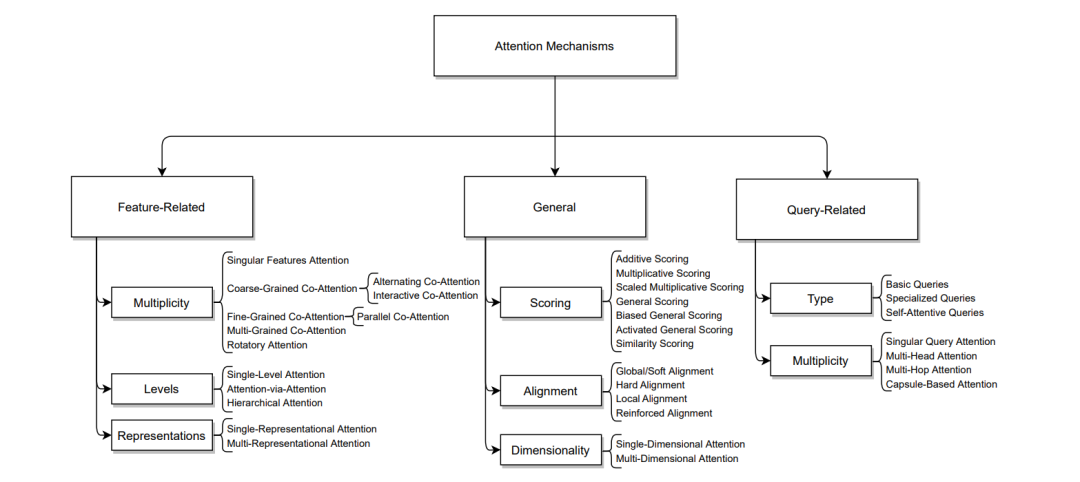

有許多不同類型的注意力機制和擴展,一個模型可以使用這些注意技術(shù)的不同組合。因此,我們提出了一種分類法,可以用來對不同類型的注意機制進行分類。

基于是否關(guān)注技術(shù)是設(shè)計來處理特定類型的特征向量(相關(guān)特性),特定類型的模型查詢(查詢相關(guān))或者它僅僅是一個通用的機制,分成三大類。這些類別及其子類別的進一步解釋將在下面的小節(jié)中提供。

特征相關(guān)注意力機制

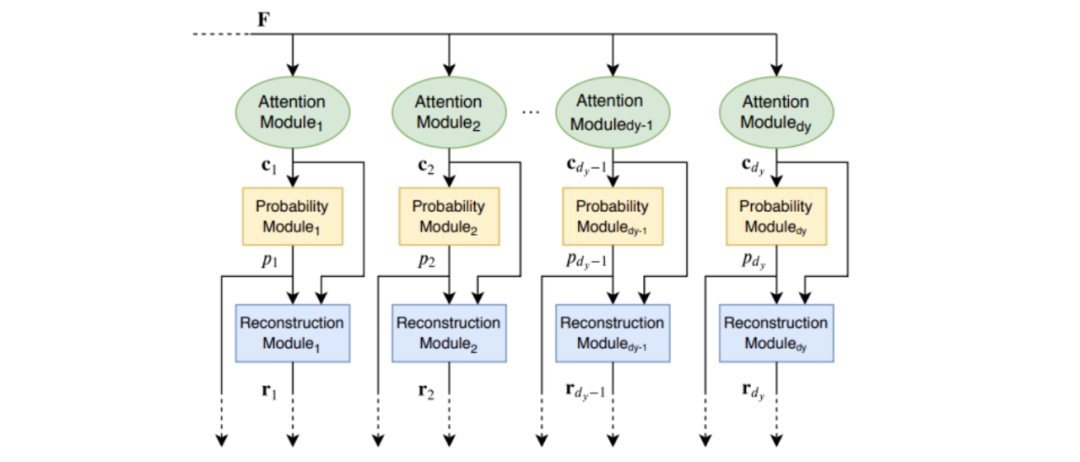

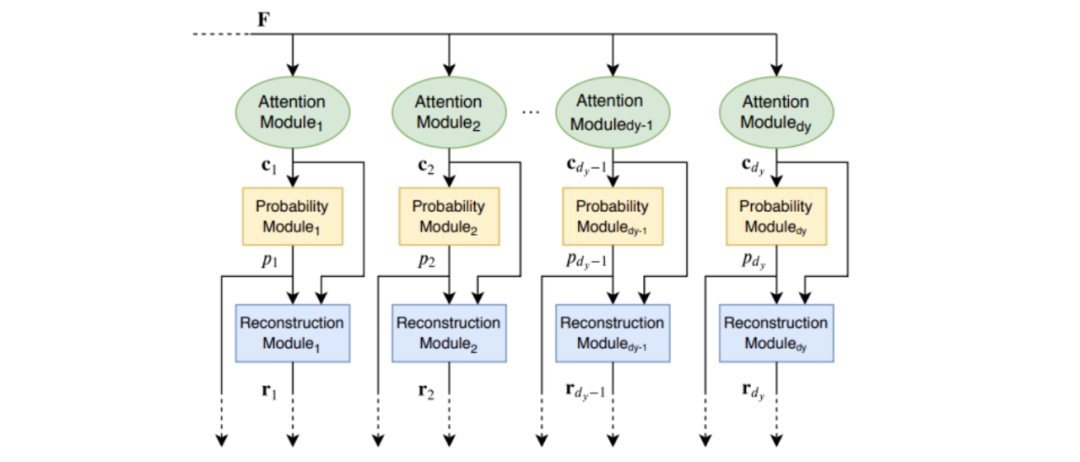

基于特定的一組輸入數(shù)據(jù),特征模型提取特征向量,從而使注意力模型能夠關(guān)注這些不同的向量。這些特征可能具有特定的結(jié)構(gòu),需要特殊的注意力機制來處理它們。可以對這些機制進行分類,以處理以下特征特征之一: 特征的多樣性、特征的級別或特征的表示。

通用注意力機制

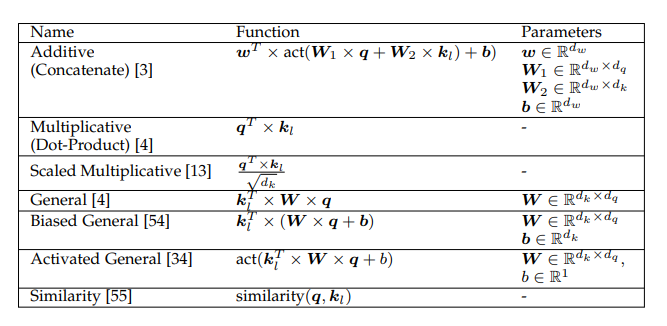

這個主要的類別包括了可以應(yīng)用于任何類型的注意力模型的注意力機制。該組件的結(jié)構(gòu)可以分解為以下幾個子方面:注意力評分函數(shù)、注意力對齊和注意力維度。

查詢相關(guān)的注意力機制

查詢是任何注意力模型的重要組成部分,因為它們直接決定從特征向量中提取哪些信息。這些查詢基于任務(wù)模型的期望輸出,可以解釋為文字問題。有些查詢具有特定的特征,需要特定類型的機制來處理它們。

因此,這一類封裝了處理特定類型查詢特征的注意力機制。這一類中的機制處理以下兩個查詢特征之一:查詢的類型或查詢的多樣性。

注意力模型評價

在本節(jié)中,我們介紹了各種類型的注意力模型的評估。

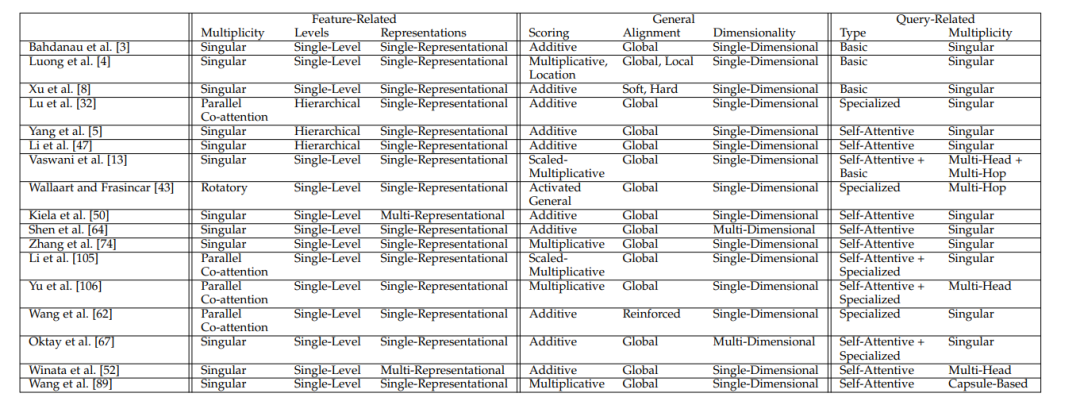

首先,我們可以使用分類法來評估注意力模型的結(jié)構(gòu)。對于這樣的分析,我們考慮注意力機制類別作為模型的正交維數(shù)。可以通過確定模型對每個類別使用的機制來分析模型的結(jié)構(gòu)。

其次,我們討論了評價注意力模型表現(xiàn)的各種技術(shù)。其中,注意力模型的性能可以通過外部或內(nèi)部性能測量來評估。

結(jié)論

本研究綜述了近年來關(guān)于深度學(xué)習(xí)中的注意力模型的研究進展。注意力機制已經(jīng)成為深度學(xué)習(xí)模型的一個顯著發(fā)展,因為它們已經(jīng)表明可以顯著提高模型性能,在幾個研究領(lǐng)域的各種任務(wù)中產(chǎn)生了最先進的結(jié)果。

我們提出了一個全面的分類,可以用來分類和解釋不同數(shù)量的注意力機制提出的文獻。分類法的組織基于任務(wù)模型的結(jié)構(gòu),該任務(wù)模型由一個特征模型、一個注意力模型、一個查詢模型和一個輸出模型組成。此外,還使用基于查詢、鍵和值的框架討論了注意力機制。

最后,我們展示了如何使用外在和內(nèi)在的測量方法來評估注意力模型的表現(xiàn),以及如何使用分類方法來分析注意力模型的結(jié)構(gòu)。

參考資料:

[1] H. Larochelle and G. E. Hinton, “Learning to combine foveal glimpses with a third-order Boltzmann machine,” in 24th Annual Conference in Neural Information Processing Systems (NIPS 2010). Curran Associates, Inc., 2010, pp. 1243–1251.?

[2] V. Mnih, N. Heess, A. Graves, and k. kavukcuoglu, “Recurrent models of visual attention,” in 27th Annual Conference on Neural Information Processing Systems (NIPS 2014). Curran Associates, Inc., 2014, pp. 2204–2212.