【深度學(xué)習(xí)】知識(shí)蒸餾最新2022研究綜述

↓↓↓點(diǎn)擊關(guān)注,回復(fù)資料,10個(gè)G的驚喜

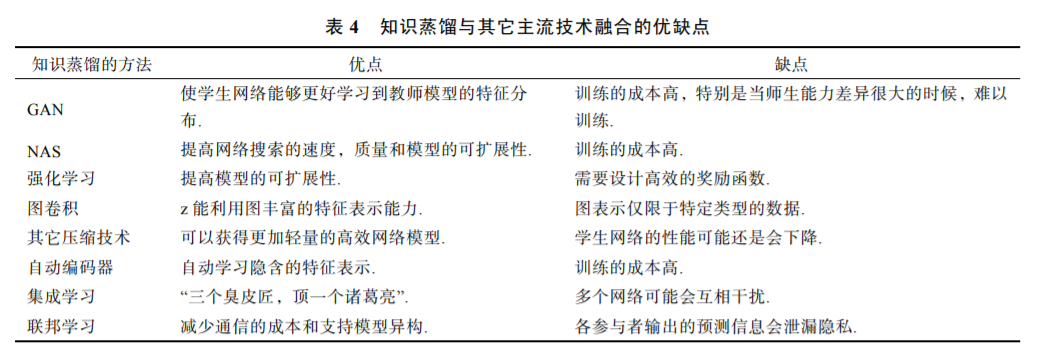

高性能的深度學(xué)習(xí)網(wǎng)絡(luò)通常是計(jì)算型和參數(shù)密集型的,難以應(yīng)用于資源受限的邊緣設(shè)備. 為了能夠在低 資源設(shè)備上運(yùn)行深度學(xué)習(xí)模型,需要研發(fā)高效的小規(guī)模網(wǎng)絡(luò). 知識(shí)蒸餾是獲取高效小規(guī)模網(wǎng)絡(luò)的一種新興方法, 其主要思想是將學(xué)習(xí)能力強(qiáng)的復(fù)雜教師模型中的“知識(shí)”遷移到簡單的學(xué)生模型中. 同時(shí),它通過神經(jīng)網(wǎng)絡(luò)的互 學(xué)習(xí)、自學(xué)習(xí)等優(yōu)化策略和無標(biāo)簽、跨模態(tài)等數(shù)據(jù)資源對(duì)模型的性能增強(qiáng)也具有顯著的效果. 基于在模型壓縮和 模型增強(qiáng)上的優(yōu)越特性,知識(shí)蒸餾已成為深度學(xué)習(xí)領(lǐng)域的一個(gè)研究熱點(diǎn)和重點(diǎn).?本文從基礎(chǔ)知識(shí),理論方法和應(yīng)用 等方面對(duì)近些年知識(shí)蒸餾的研究展開全面的調(diào)查,具體包含以下內(nèi)容:(1)回顧了知識(shí)蒸餾的背景知識(shí),包括它的 由來和核心思想;(2)解釋知識(shí)蒸餾的作用機(jī)制;(3)歸納知識(shí)蒸餾中知識(shí)的不同形式,分為輸出特征知識(shí)、中間特 征知識(shí)、關(guān)系特征知識(shí)和結(jié)構(gòu)特征知識(shí);(4)詳細(xì)分析和對(duì)比了知識(shí)蒸餾的各種關(guān)鍵方法,包括知識(shí)合并、多教師 學(xué)習(xí)、教師助理、跨模態(tài)蒸餾、相互蒸餾、終身蒸餾以及自蒸餾;(5)介紹知識(shí)蒸餾與其它技術(shù)融合的相關(guān)方法, 包括生成對(duì)抗網(wǎng)絡(luò)、神經(jīng)架構(gòu)搜索、強(qiáng)化學(xué)習(xí)、圖卷積、其它壓縮技術(shù)、自動(dòng)編碼器、集成學(xué)習(xí)以及聯(lián)邦學(xué)習(xí);(6)對(duì)知識(shí)蒸餾在多個(gè)不同領(lǐng)域下的應(yīng)用場景進(jìn)行了詳細(xì)的闡述;(7)討論了知識(shí)蒸餾存在的挑戰(zhàn)和未來的研究方向.

https://cjc.ict.ac.cn/online/onlinepaper/HZH315.pdf

1. 引言

深度學(xué)習(xí)由于對(duì)目標(biāo)多樣性變化具有很好的魯 棒性,近年來得到廣泛的關(guān)注并取得快速的發(fā)展. 然而性能越好的深度學(xué)習(xí)模型往往需要越多的資 源,使其在物聯(lián)網(wǎng)、移動(dòng)互聯(lián)網(wǎng)等低資源設(shè)備的應(yīng) 用上受到限制. 因此研究人員開始對(duì)高效的(Efficient)深度學(xué)習(xí)模型展開研究,其目的是使具有高性能 的模型能夠滿足低資源設(shè)備的低功耗和實(shí)時(shí)性等要 求,同時(shí)盡可能地不降低模型的性能. 當(dāng)前,主要 有 5 種方法可以獲得高效的深度學(xué)習(xí)模型:直接手 工設(shè)計(jì)輕量級(jí)網(wǎng)絡(luò)模型、剪枝、量化、基于神經(jīng)架 構(gòu)搜索(Neural Architecture Search,NAS)[1]的網(wǎng)絡(luò)自 動(dòng)化設(shè)計(jì)以及知識(shí)蒸餾(Knowledge Distillation,KD)[2]. 其中,知識(shí)蒸餾作為一種新興的模型壓縮方 法,目前已成為深度學(xué)習(xí)領(lǐng)域的一個(gè)研究熱點(diǎn)和重 點(diǎn). 國內(nèi)外許多大學(xué)和研究機(jī)構(gòu)已經(jīng)對(duì)知識(shí)蒸餾展 開了深入研究,并且每年在機(jī)器學(xué)習(xí)和數(shù)據(jù)挖掘的 國際頂級(jí)會(huì)議和知名期刊中都有關(guān)于知識(shí)蒸餾的文 章發(fā)表.??

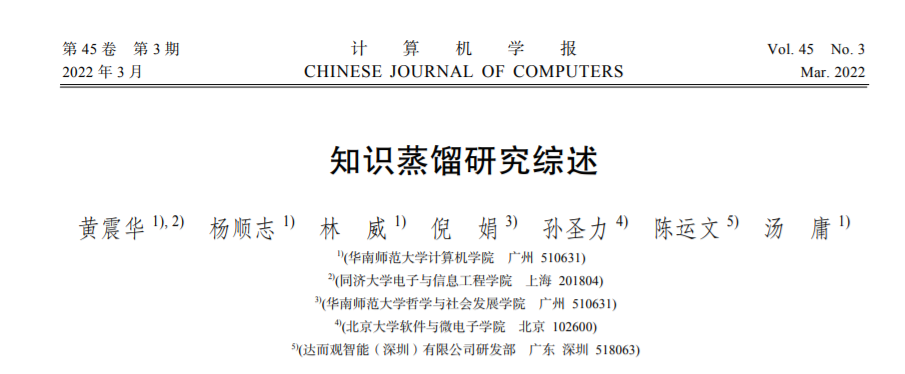

知識(shí)蒸餾是一種教師-學(xué)生(Teacher-Student)訓(xùn) 練結(jié)構(gòu),通常是已訓(xùn)練好的教師模型提供知識(shí),學(xué) 生模型通過蒸餾訓(xùn)練來獲取教師的知識(shí).?它可以以 輕微的性能損失為代價(jià)將復(fù)雜教師模型的知識(shí)遷移 到簡單的學(xué)生模型中. 在后續(xù)的研究中,學(xué)術(shù)界和 工業(yè)界擴(kuò)展了知識(shí)蒸餾的應(yīng)用范疇,提出了利用知 識(shí)蒸餾來實(shí)現(xiàn)模型性能的增強(qiáng). 基于此,本文根據(jù) 應(yīng)用場景劃分出基于知識(shí)蒸餾的模型壓縮和模型增 強(qiáng)這兩個(gè)技術(shù)方向,即獲得的網(wǎng)絡(luò)模型是否為了應(yīng) 用于資源受限的設(shè)備. 圖 1 給出了這兩種技術(shù)對(duì)比 的一個(gè)例子,其中的教師模型都是提前訓(xùn)練好的復(fù) 雜網(wǎng)絡(luò). 模型壓縮和模型增強(qiáng)都是將教師模型的知 識(shí)遷移到學(xué)生模型中. 所不同的是,模型壓縮是教 師網(wǎng)絡(luò)在相同的帶標(biāo)簽的數(shù)據(jù)集上指導(dǎo)學(xué)生網(wǎng)絡(luò)的 訓(xùn)練來獲得簡單而高效的網(wǎng)絡(luò)模型,如左圖的學(xué)生 是高效的小規(guī)模網(wǎng)絡(luò). 模型增強(qiáng)則強(qiáng)調(diào)利用其它資 源(如無標(biāo)簽或跨模態(tài)的數(shù)據(jù))或知識(shí)蒸餾的優(yōu)化策 略(如相互學(xué)習(xí)和自學(xué)習(xí))來提高一個(gè)復(fù)雜學(xué)生模型 的性能. 如右圖中,一個(gè)無標(biāo)簽的樣本同時(shí)作為教 師和學(xué)生網(wǎng)絡(luò)的輸入,性能強(qiáng)大的教師網(wǎng)絡(luò)通常能 預(yù)測出該樣本的標(biāo)簽,然后利用該標(biāo)簽去指導(dǎo)復(fù)雜 的學(xué)生網(wǎng)絡(luò)訓(xùn)練.

本文重點(diǎn)收集了近些年在人工智能、機(jī)器學(xué)習(xí) 以及數(shù)據(jù)挖掘等領(lǐng)域的國際頂級(jí)會(huì)議(如 ICCV, ICML,EMNLP,KDD)與重要學(xué)術(shù)期刊(如 PAMI, TOIS,TKDE,TMM)上有關(guān)知識(shí)蒸餾的論文并加以 整理、歸納和分析. 據(jù)我們所知,目前國內(nèi)沒有知 識(shí)蒸餾相關(guān)的中文綜述,而先前兩篇英文綜述[3,4] 和我們工作相似,但本文進(jìn)一步完善了知識(shí)蒸餾的 綜述. 具體地,本文與先前的英文綜述[3,4]至少有以 下三點(diǎn)的不同:?

(1)先前的研究都忽略了知識(shí)蒸餾在模型增強(qiáng) 上的應(yīng)用前景.?在本文的研究調(diào)查中,知識(shí)蒸餾不 僅可以用于模型壓縮,它還能通過互學(xué)習(xí)和自學(xué)習(xí) 等優(yōu)化策略來提高一個(gè)復(fù)雜模型的性能. 同時(shí),知 識(shí)蒸餾可以利用無標(biāo)簽和跨模態(tài)等數(shù)據(jù)的特征,對(duì) 模型增強(qiáng)也具有顯著的提升效果.?

(2)先前的研究都沒有關(guān)注到結(jié)構(gòu)化特征知 識(shí),而它在知識(shí)架構(gòu)中又是不可或缺的.?某個(gè)結(jié)構(gòu) 上的知識(shí)往往不是單一的,它們是有關(guān)聯(lián)的、多個(gè) 知識(shí)形式組合. 充分利用教師網(wǎng)絡(luò)中的結(jié)構(gòu)化特征 知識(shí)對(duì)學(xué)生模型的性能提升是有利的,因此它在近 兩年的工作中越發(fā)重要[5,6].?

(3)本文從不同視角給出了基于知識(shí)蒸餾的描 述,并提供了更多的知識(shí)介紹.?在知識(shí)蒸餾的方法 上,本文增加了知識(shí)合并和教師助理的介紹;在技 術(shù)融合的小節(jié),本文增加了知識(shí)蒸餾與自動(dòng)編碼器、 集成學(xué)習(xí)和聯(lián)邦學(xué)習(xí)的技術(shù)融合;在知識(shí)蒸餾的應(yīng) 用進(jìn)展中,本文分別介紹了知識(shí)蒸餾在模型壓縮和 模型增強(qiáng)的應(yīng)用,并增加了多模態(tài)數(shù)據(jù)和金融證券 的應(yīng)用進(jìn)展;在知識(shí)蒸餾的研究趨勢展望中,本文 給出了更多的研究趨勢,特別是介紹了模型增強(qiáng)的 應(yīng)用前景.

總的來說,本文在文獻(xiàn)[3,4]基礎(chǔ)上,以不同的 視角,提供更加全面的綜述,以便為后續(xù)學(xué)者了解 或研究知識(shí)蒸餾提供參考指導(dǎo).

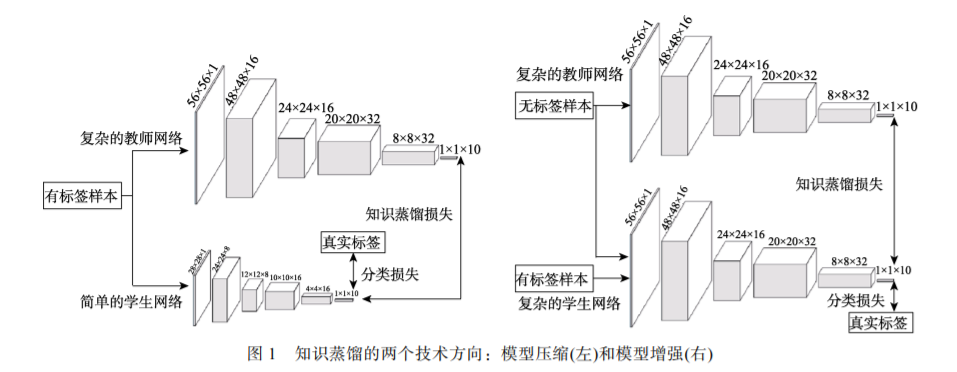

本文組織結(jié)構(gòu)如圖 2 所示. 第 2 節(jié)回顧了知識(shí) 蒸餾的背景知識(shí),包括它的由來;第 3 節(jié)解釋知識(shí) 蒸餾的作用機(jī)制,即為什么知識(shí)蒸餾是有效的;第 4 節(jié)歸納知識(shí)蒸餾中知識(shí)的不同形式;第 5 節(jié)詳細(xì) 分析了知識(shí)蒸餾的各種方法,其強(qiáng)調(diào)的是知識(shí)遷移 的方式;第 6 節(jié)介紹知識(shí)蒸餾與其它技術(shù)融合的相 關(guān)方法;第 7 節(jié)歸納知識(shí)蒸餾的應(yīng)用進(jìn)展;第 8 節(jié) 給出了知識(shí)蒸餾的研究趨勢展望. 最后,第 9 節(jié)對(duì) 本文工作進(jìn)行總結(jié).

2. 知識(shí)蒸餾的提出

知識(shí)蒸餾與較早提出的并被廣泛應(yīng)用的一種機(jī) 器學(xué)習(xí)方法的思想較為相似,即遷移學(xué)習(xí)[7]. 知識(shí)蒸 餾與遷移學(xué)習(xí)都涉及到知識(shí)的遷移,然而它們有以 下四點(diǎn)的不同:

?(1) 數(shù)據(jù)域不同. 知識(shí)蒸餾中的知識(shí)通常是在同 一個(gè)目標(biāo)數(shù)據(jù)集上進(jìn)行遷移,而遷移學(xué)習(xí)中的知識(shí)?往往是在不同目標(biāo)的數(shù)據(jù)集上進(jìn)行轉(zhuǎn)移.

(2) 網(wǎng)絡(luò)結(jié)構(gòu)不同. 知識(shí)蒸餾的兩個(gè)網(wǎng)絡(luò)可以是 同構(gòu)或者異構(gòu)的,而遷移學(xué)習(xí)通常是在單個(gè)網(wǎng)絡(luò)上 利用其它領(lǐng)域的數(shù)據(jù)知識(shí).?

(3) 學(xué)習(xí)方式不同. 遷移學(xué)習(xí)使用其它領(lǐng)域的豐 富數(shù)據(jù)的權(quán)重來幫助目標(biāo)數(shù)據(jù)的學(xué)習(xí),而知識(shí)蒸餾 不會(huì)直接使用學(xué)到的權(quán)重.

(4) 目的不同. 知識(shí)蒸餾通常是訓(xùn)練一個(gè)輕量級(jí) 的網(wǎng)絡(luò)來逼近復(fù)雜網(wǎng)絡(luò)的性能,而遷移學(xué)習(xí)是將已 經(jīng)學(xué)習(xí)到相關(guān)任務(wù)模型的權(quán)重來解決目標(biāo)數(shù)據(jù)集的 樣本不足問題.

3 知識(shí)蒸餾的作用機(jī)制?

Hinton 等人[2]認(rèn)為,學(xué)生模型在知識(shí)蒸餾的過 程中通過模仿教師模型輸出類間相似性的“暗知識(shí)” 來提高泛化能力. 軟目標(biāo)攜帶著比硬目標(biāo)更多的泛 化信息來防止學(xué)生模型過擬合. 雖然知識(shí)蒸餾已經(jīng) 獲得了廣泛的應(yīng)用,但是學(xué)生模型的性能通常是僅接 近于教師模型. 特別地,給定學(xué)生和教師模型相同的 大小卻能夠讓學(xué)生模型的性能超越教師模型[12],性 能越差的教師模型反倒教出了更好的學(xué)生模型[13]. 為了更好地理解知識(shí)蒸餾的作用,一些工作從數(shù)學(xué) 或?qū)嶒?yàn)上對(duì)知識(shí)蒸餾的作用機(jī)制進(jìn)行了證明和解 釋. 本文歸納為以下幾類:

(1) 軟目標(biāo)為學(xué)生模型提供正則化約束. 這一 結(jié)論最早可以追溯到通過貝葉斯優(yōu)化來控制網(wǎng)絡(luò)超 參數(shù)的對(duì)比試驗(yàn)[14],其表明了教師模型的軟目標(biāo)為 學(xué)生模型提供了顯著的正則化. 軟目標(biāo)正則化的作 用是雙向的,即還能將知識(shí)從較弱的教師模型遷移 到能力更強(qiáng)大的學(xué)生模型中[15,16]. 一方面,軟目標(biāo) 通過標(biāo)簽平滑訓(xùn)練提供了正則化[15,16],標(biāo)簽平滑是 通過避免了過分相信訓(xùn)練樣本的真實(shí)標(biāo)簽來防止訓(xùn) 練的過擬合[15]. 另一方面,軟目標(biāo)通過置信度懲罰 提供了正則化[12],置信度懲罰讓學(xué)生模型獲得更好 的泛化能力,其主要依賴于教師模型對(duì)正確預(yù)測的 信心. 這兩種正則化的形式已經(jīng)在數(shù)學(xué)上得到了證 明. 總的來說,軟目標(biāo)通過提供標(biāo)簽平滑和置信度 懲罰來對(duì)學(xué)生模型施加正則化訓(xùn)練. 因此,即使沒 有強(qiáng)大的教師模型,學(xué)生模型仍然可以通過自己訓(xùn) 練或手動(dòng)設(shè)計(jì)的正則化項(xiàng)得到增強(qiáng)[16].

(2) 軟目標(biāo)為學(xué)生模型提供了“特權(quán)信息” (Privileged Information). “特權(quán)信息”指教師模型 提供的解釋、評(píng)論和比較等信息[17]. 教師模型在訓(xùn) 練的過程中將軟目標(biāo)的“暗知識(shí)”遷移到學(xué)生模型 中,而學(xué)生模型在測試的過程中并不能使用“暗知 識(shí)”. 從這個(gè)角度看,知識(shí)蒸餾是通過軟目標(biāo)來為 學(xué)生模型傳遞“特權(quán)信息”.

(3) 軟目標(biāo)引導(dǎo)了學(xué)生模型優(yōu)化的方向. Phuong 等人[18]從模型訓(xùn)練的角度證明了軟目標(biāo)能引導(dǎo)學(xué)生 模型的優(yōu)化方向. 同時(shí),Cheng 等人[19]從數(shù)學(xué)上驗(yàn) 證了軟目標(biāo)使學(xué)生模型比從原始數(shù)據(jù)中進(jìn)行優(yōu)化學(xué) 習(xí)具有更高的學(xué)習(xí)速度和更好的性能.?

4 蒸餾的知識(shí)形式

原始知識(shí)蒸餾(Vanilla Knowledge Distillation)[2] 僅僅是從教師模型輸出的軟目標(biāo)中學(xué)習(xí)出輕量級(jí)的 學(xué)生模型. 然而,當(dāng)教師模型變得更深時(shí),僅僅學(xué) 習(xí)軟目標(biāo)是不夠的. 因此,我們不僅需要獲取教師 模型輸出的知識(shí),還需要學(xué)習(xí)隱含在教師模型中的 其它知識(shí),比如中間特征知識(shí). 本節(jié)總結(jié)了可以使 用的知識(shí)形式有輸出特征知識(shí)、中間特征知識(shí)、關(guān) 系特征知識(shí)和結(jié)構(gòu)特征知識(shí). 知識(shí)蒸餾的 4 種知識(shí) 形式的關(guān)系如圖 5 所示. 從學(xué)生解題的角度,這 4 種知識(shí)形式可以形象比喻為:輸出特征知識(shí)提供了 解題的答案,中間特征知識(shí)提供了解題的過程,關(guān) 系特征知識(shí)提供了解題的方法,結(jié)構(gòu)特征知識(shí)則提 供了完整的知識(shí)體系.

5 知識(shí)蒸餾的方法?

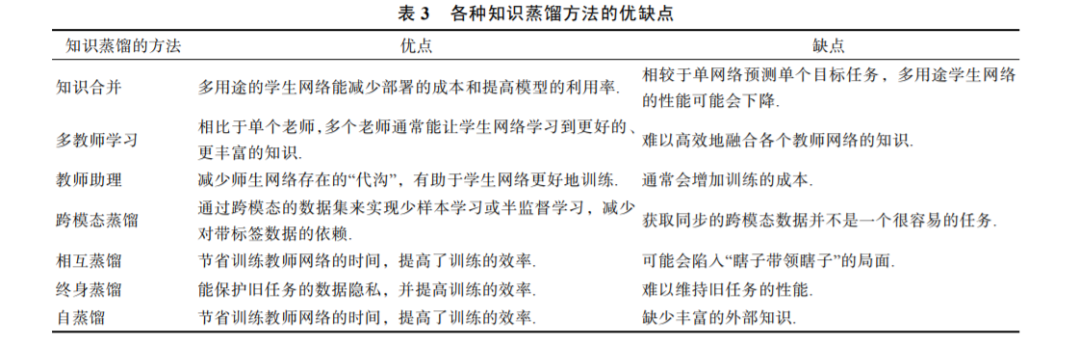

本節(jié)從知識(shí)利用的方式,歸納和分析知識(shí)蒸 餾的主要方法,包括知識(shí)合并、多教師學(xué)習(xí)、教 師助理、跨模態(tài)蒸餾、相互蒸餾、終身蒸餾以及 自蒸餾.

6 知識(shí)蒸餾與其它技術(shù)的融合?

近幾年,研究人員發(fā)現(xiàn)知識(shí)蒸餾結(jié)合其它主流 技術(shù)通常能夠提高其性能. 目前這些主流技術(shù)主要 有:生成對(duì)抗網(wǎng)絡(luò)、神經(jīng)架構(gòu)搜索、強(qiáng)化學(xué)習(xí)、圖 卷積、其它壓縮技術(shù)、自動(dòng)編碼器、集成學(xué)習(xí)以及 聯(lián)邦學(xué)習(xí).

7 知識(shí)蒸餾的應(yīng)用進(jìn)展?

知識(shí)蒸餾的最初目的是壓縮深度學(xué)習(xí)網(wǎng)絡(luò)模 型,這在資源受限的終端設(shè)備上具有廣泛的應(yīng)用. 但隨著研究的新進(jìn)展,知識(shí)蒸餾不僅可以用于壓縮 模型,還可以通過神經(jīng)網(wǎng)絡(luò)的互學(xué)習(xí)、自學(xué)習(xí)等優(yōu) 化策略和無標(biāo)簽、跨模態(tài)等數(shù)據(jù)資源對(duì)模型的性能 增強(qiáng)也具有顯著的提升效果. 目前知識(shí)蒸餾的主要 應(yīng)用領(lǐng)域有計(jì)算機(jī)視覺、自然語言處理、語音識(shí)別、 推薦系統(tǒng)、信息安全、多模態(tài)數(shù)據(jù)和金融證券. 知 識(shí)蒸餾在計(jì)算機(jī)視覺、自然語言處理、語音識(shí)別和 推薦系統(tǒng)上的應(yīng)用根據(jù)其目的的不同,可以分為模 型壓縮和模型增強(qiáng). 模型壓縮是為了獲得簡單而高 效的網(wǎng)絡(luò)模型,以方便部署于資源受限的設(shè)備. 而 模型增強(qiáng)通常是利用其它資源(如無標(biāo)簽或跨模態(tài) 的數(shù)據(jù))來獲取復(fù)雜的高性能網(wǎng)絡(luò).??

8 知識(shí)蒸餾的研究趨勢展望

知識(shí)蒸餾是一個(gè)新興的研究領(lǐng)域,它仍有許多 值得深入探索和亟待解決的問題. 在這一節(jié)中,我 們提出一些值得進(jìn)一步深入探討的研究點(diǎn),也是我 們今后需要解決完善的研究方向.

(1) 如何確定何種知識(shí)是最佳的.?知識(shí)蒸餾中 的知識(shí)是一個(gè)抽象的概念,網(wǎng)絡(luò)參數(shù),網(wǎng)絡(luò)的輸出 和網(wǎng)絡(luò)的中間特征等都可以理解為知識(shí). 但是何種 知識(shí)是最佳的,或者哪些知識(shí)以互補(bǔ)的方式能成為 最佳的通用知識(shí)表示?為了回答這個(gè)問題,我們需 要了解每種知識(shí)以及不同種類組合知識(shí)的作用. 比 如說,基于特征的知識(shí)通常用于模仿教師特征產(chǎn)生 的過程,基于關(guān)系的知識(shí)常用于捕獲不同樣本之間 或網(wǎng)絡(luò)層之間特征的關(guān)系. 當(dāng)教師和學(xué)生的模型容 量(“代溝”)較小的時(shí)候,學(xué)生只模仿教師的軟目 標(biāo)就可以獲得有競爭力的性能. 而當(dāng)師生的“代溝” 較大時(shí),需要將多種蒸餾的知識(shí)形式和方法結(jié)合來 表示教師模型. 雖然能明白多種知識(shí)的組合方式通 常能提高學(xué)生網(wǎng)絡(luò)的性能,但是使用哪些知識(shí)形式, 方法和技術(shù)的組合是最優(yōu)的,還尚無定論.

(2) 如何確定何處的知識(shí)是最佳的.?一些工作 隨機(jī)選擇中間網(wǎng)絡(luò)的某層特征作為知識(shí),比如 FitNets[27]將教師前幾層的網(wǎng)絡(luò)特征作為特征蒸餾的 位置. 然而他們都沒有提供一個(gè)理由,即為什么能 夠成為代表性知識(shí). 這主要是由于教師和學(xué)生模型 結(jié)構(gòu)的不一致導(dǎo)致的,即教師模型通常比學(xué)生模型 擁有更多的網(wǎng)絡(luò)層. 因此,需要篩選教師模型中最 具有代表性的特征. 然而教師模型中哪些特征層是 最具有代表性的?這也是一個(gè)未解決的問題. 在基 于關(guān)系的知識(shí)蒸餾中,也一樣無法解釋該選擇哪些 層的關(guān)系知識(shí)作為學(xué)生模仿的對(duì)象. 如 FSP 矩陣[31] 隨機(jī)選擇教師模型的兩個(gè)網(wǎng)絡(luò)層作為關(guān)系蒸餾的位 置. 關(guān)系知識(shí)蒸餾是容量無關(guān)的,即關(guān)系蒸餾僅僅 需要獲取的是網(wǎng)絡(luò)層間或樣本間的關(guān)系知識(shí). 因此 這不是師生間的“代溝”問題,而是歸咎于知識(shí)其實(shí)是一個(gè)“黑盒”問題.

(3) 如何定義最佳的師生結(jié)構(gòu).?知識(shí)蒸餾傳遞 的并不是參數(shù),而是抽取到的知識(shí). 因此知識(shí)蒸餾 是網(wǎng)絡(luò)架構(gòu)無關(guān)的,即任何學(xué)生都可以向任何教師 學(xué)習(xí). 通常,容量更大的學(xué)生模型可以學(xué)習(xí)更多的 知識(shí),但復(fù)雜度過大會(huì)延長推理的時(shí)間. 容量更大 的教師模型隱含著較多的知識(shí)和更強(qiáng)的能力,但是 并非能力越強(qiáng)的教師就能產(chǎn)生更佳的學(xué)生模型[13]. 同時(shí),每一個(gè)教師模型都有一個(gè)最強(qiáng)學(xué)生結(jié)構(gòu)[100]. 因此,我們只能在給定的教師模型的前提下,找到 最佳的學(xué)生模型. 然而在未指定教師模型的情況 下,目前還無法確定最佳的學(xué)生模型.?

(4) 如何衡量師生間特征的接近程度.?知識(shí)蒸 餾是要將教師網(wǎng)絡(luò)中的知識(shí)遷移到學(xué)生模型中,遷 移效果的好壞最終可以通過學(xué)生網(wǎng)絡(luò)性能來體現(xiàn). 然而在網(wǎng)絡(luò)訓(xùn)練的過程中,只能通過損失函數(shù)去判 斷教師和學(xué)生之間特征的接近程度. 因此需要提前 設(shè)計(jì)好知識(shí)蒸餾的損失函數(shù),如 KL 散度、均方誤 差(Mean Squared Error,MSE)和余弦相似性. 而損 失函數(shù)的選取受算法和離群點(diǎn)等因素的影響,并且, 不同損失函數(shù)的作用范圍是不一樣的. 例如,通過 KL 散度衡量的兩個(gè)隨機(jī)分布上的相似度是非對(duì)稱 的. 余弦相似性強(qiáng)調(diào)兩個(gè)向量的特征在方向上的差 異,卻沒有考慮向量大小. MSE 在高維特征中的作 用不明顯,且很容易被隨機(jī)特征混淆[4]. 因此,衡量 師生間特征接近程度的方法是多樣化的,我們需要 根據(jù)特定的問題和場景選取最合適的損失函數(shù).?

(5) 蒸餾的知識(shí)形式、方法和融合技術(shù)還需要 深入探索.?原始知識(shí)蒸餾將類間的關(guān)系信息作為知 識(shí),但這在“代溝”較大的師生網(wǎng)絡(luò)中效果不佳. 為 了解決這一問題,后續(xù)的研究者尋找不同形式的“知 識(shí)”來充實(shí)知識(shí)的內(nèi)涵,如關(guān)系知識(shí). 其知識(shí)的來 源應(yīng)該是多樣化的,可以來自于單個(gè)或多個(gè)的樣本 和網(wǎng)絡(luò)本身. 同樣,知識(shí)蒸餾的方法和融合技術(shù)也 能緩解甚至解決師生間的“代溝”問題,它們強(qiáng)調(diào) 充分地利用知識(shí)來提高模型的表征能力. 新的知 識(shí)形式、方法和融合技術(shù)的發(fā)現(xiàn)可能會(huì)伴隨著新的 應(yīng)用場景,這將豐富知識(shí)蒸餾的理論框架和實(shí)踐的 應(yīng)用.?

(6) 模型壓縮和模型增強(qiáng)的深度融合.?模型壓 縮是將強(qiáng)大的復(fù)雜教師模型中的“知識(shí)”遷移到簡 單的學(xué)生模型中以滿足低資源設(shè)備的應(yīng)用要求,而 模型增強(qiáng)用于獲取高性能的復(fù)雜網(wǎng)絡(luò). 模型壓縮和 模型增強(qiáng)的融合是將教師模型中的“特權(quán)信息”遷 移或繼續(xù)強(qiáng)化輕量級(jí)學(xué)生模型的性能. 例如,Liu 等人[206]通過從文本翻譯模型中遷移“特權(quán)信息”來改 進(jìn)輕量級(jí)的語音翻譯模型. 在未來的工作中,甚至 能將無標(biāo)簽或其它領(lǐng)域數(shù)據(jù)的“特權(quán)信息”來繼續(xù) 加強(qiáng)一個(gè)輕量級(jí)學(xué)生模型的性能.?

(7) 知識(shí)蒸餾在數(shù)據(jù)樣本增強(qiáng)上的應(yīng)用.?深度 學(xué)習(xí)是數(shù)據(jù)驅(qū)動(dòng)型的,往往需要大規(guī)模的數(shù)據(jù)集才 能避免過度擬合. 由于隱私和法律等原因,在一些 領(lǐng)域上,通常無法獲取大規(guī)模的原始數(shù)據(jù)集,如醫(yī) 療數(shù)據(jù). 知識(shí)蒸餾需要足夠的數(shù)據(jù),才能將教師網(wǎng) 絡(luò)中的知識(shí)遷移到學(xué)生網(wǎng)絡(luò)中. 換句話說,數(shù)據(jù)是 連接教師網(wǎng)絡(luò)和學(xué)生網(wǎng)絡(luò)的橋梁. 先前的研究已經(jīng) 證明了知識(shí)蒸餾在數(shù)據(jù)樣本增強(qiáng)上的廣闊應(yīng)用前景, 如通過知識(shí)蒸餾產(chǎn)生原始數(shù)據(jù)集的近似樣本[207]、 使用其它相關(guān)數(shù)據(jù)的知識(shí)來減輕對(duì)目標(biāo)數(shù)據(jù)集的依 賴[208]以及教師和學(xué)生間部分網(wǎng)絡(luò)的共同訓(xùn)練來提 高具有小樣本學(xué)生網(wǎng)絡(luò)的性能[114]. 未來的工作需 要繼續(xù)探索知識(shí)蒸餾在數(shù)據(jù)樣本增強(qiáng)上的應(yīng)用場景 和高效的蒸餾方法來實(shí)現(xiàn)小樣本學(xué)習(xí)(Few-Shot Learning)或零樣本學(xué)習(xí)(zero-shot learning).?

(8) 知識(shí)蒸餾在數(shù)據(jù)標(biāo)簽上的應(yīng)用. 給數(shù)據(jù)上 標(biāo)簽需要特定領(lǐng)域的專業(yè)知識(shí)、大量的時(shí)間和成本. 可以利用知識(shí)蒸餾減少標(biāo)注訓(xùn)練數(shù)據(jù)的麻煩,解決 數(shù)據(jù)標(biāo)簽的問題. 如果該領(lǐng)域存在著強(qiáng)大的教師網(wǎng) 絡(luò),能通過知識(shí)蒸餾給無標(biāo)簽的數(shù)據(jù)增加注釋. 具 體地,教師網(wǎng)絡(luò)對(duì)未標(biāo)記數(shù)據(jù)進(jìn)行預(yù)測,并使用它 們的預(yù)測信息充當(dāng)學(xué)生模型數(shù)據(jù)的自動(dòng)標(biāo)注[209]. 以無標(biāo)簽數(shù)據(jù)作為輸入的教師網(wǎng)絡(luò)會(huì)產(chǎn)生軟標(biāo)簽, 這恰好能為學(xué)生網(wǎng)絡(luò)提供學(xué)習(xí)的指導(dǎo)信息. 即使該 領(lǐng)域沒有強(qiáng)大的教師網(wǎng)絡(luò),也可以通過跨模態(tài)知識(shí) 蒸餾,將其它領(lǐng)域的知識(shí)充當(dāng)無標(biāo)簽數(shù)據(jù)的監(jiān)督信 號(hào)[66]. 因此,知識(shí)蒸餾能夠減少對(duì)數(shù)據(jù)標(biāo)簽的依賴, 需要繼續(xù)研究它在半監(jiān)督或無監(jiān)督學(xué)習(xí)上的應(yīng)用.