【語義分割】一篇看完就懂的最新深度語義分割模型綜述

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

本文轉(zhuǎn)自:AI算法與圖像處理

語義分割結(jié)合了圖像分類、目標(biāo)檢測和圖像分割,通過一定的方法將圖像分割成具有一定語義含義的區(qū)域塊,并識(shí)別出每個(gè)區(qū)域塊的語義類別,實(shí)現(xiàn)從底層到高層的語義推理過程,最終得到一幅具有逐像素語義標(biāo)注的分割圖像。

圖像語義分割方法有傳統(tǒng)方法和基于卷積神經(jīng)網(wǎng)絡(luò)的方法,其中傳統(tǒng)的語義分割方法又可以分為基于統(tǒng)計(jì)的方法和基于幾何的方法。隨著深度學(xué)習(xí)的發(fā)展,語義分割技術(shù)得到很大的進(jìn)步,基于卷積神經(jīng)網(wǎng)絡(luò)的語義分割方法與傳統(tǒng)的語義分割方法最大不同是,網(wǎng)絡(luò)可以自動(dòng)學(xué)習(xí)圖像的特征,進(jìn)行端到端的分類學(xué)習(xí),大大提升語義分割的精確度。

基于候選區(qū)域的語義分割方法首先從圖像中提取自由形式的區(qū)域并對(duì)他們的特征進(jìn)行描述,然后再基于區(qū)域進(jìn)行分類,最后將基于區(qū)域的預(yù)測轉(zhuǎn)換為像素級(jí)預(yù)測,使用包含像素最高得分的區(qū)域來標(biāo)記像素。

基于候選區(qū)域的模型方法雖然為語義分割的發(fā)展帶來很大的進(jìn)步,但是它需要生成大量的候選區(qū)域,生成候選區(qū)域的過程要花費(fèi)大量的時(shí)間和內(nèi)存空間。此外,不同算法提取的候選區(qū)域集的質(zhì)量也千差萬別,直接影響了最終的語義分割效果。

基于全卷積的深度語義分割模型,主要特點(diǎn)是,全卷積網(wǎng)絡(luò)沒有全連接層,全部由卷積層構(gòu)成。

主要思想

目前流行的深度網(wǎng)絡(luò),比如VGG,Resnet等,由于pooling和卷積步長的存在,feature map會(huì)越來越小,導(dǎo)致?lián)p失一些細(xì)粒度的信息(低層feature map有較豐富的細(xì)粒度信息,高層feature map則擁有更抽象,粗粒度的信息)。對(duì)于分類問題而言,只需要深層的強(qiáng)語義信息就能表現(xiàn)較好,但是對(duì)于稠密預(yù)測問題,比如逐像素的圖像分割問題,除了需要強(qiáng)語義信息之外,還需要高空間分辨率。

針對(duì)這些問題,很多方法都提出了解決方案:

1、針對(duì)pooling下采樣過程中的分辨率損失,采用deconvolution恢復(fù)。但是卻很難恢復(fù)位置信息。

2、使用空洞卷積保持分辨率,增大感受野,但是這么做有兩個(gè)缺點(diǎn):A.明顯增加了計(jì)算代價(jià)。B.空洞卷積是一種coarse sub-sampling,因此容易損失重要信息。

3、通過skip connection來產(chǎn)生高分辨率的預(yù)測。

? 基于全卷積的對(duì)稱語義分割模型

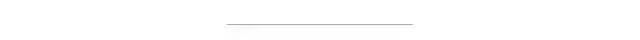

1.FCN

首先將一幅 RGB 圖像輸入到卷積神經(jīng)網(wǎng)絡(luò)后,經(jīng)過多次卷積及池化過程得到一系列的特征圖,然后利用反卷積層對(duì)最后一個(gè)卷積層得到的特征圖進(jìn)行上采樣,使得上采樣后特征圖與原圖像的大小一樣,從而實(shí)現(xiàn)對(duì)特征圖上的每個(gè)像素值進(jìn)行預(yù)測的同時(shí)保留其在原圖像中的空間位置信息,最后對(duì)上采樣特征圖進(jìn)行逐像素分類,逐個(gè)像素計(jì)算 softmax 分類損失。

主要特點(diǎn):

不含全連接層(fc)的全卷積(fully conv)網(wǎng)絡(luò)。從而可適應(yīng)任意尺寸輸入。

引入增大數(shù)據(jù)尺寸的反卷積(deconv)層,能夠輸出精細(xì)的結(jié)果。

結(jié)合不同深度層結(jié)果的跳級(jí)(skip)結(jié)構(gòu)。同時(shí)確保魯棒性和精確性。

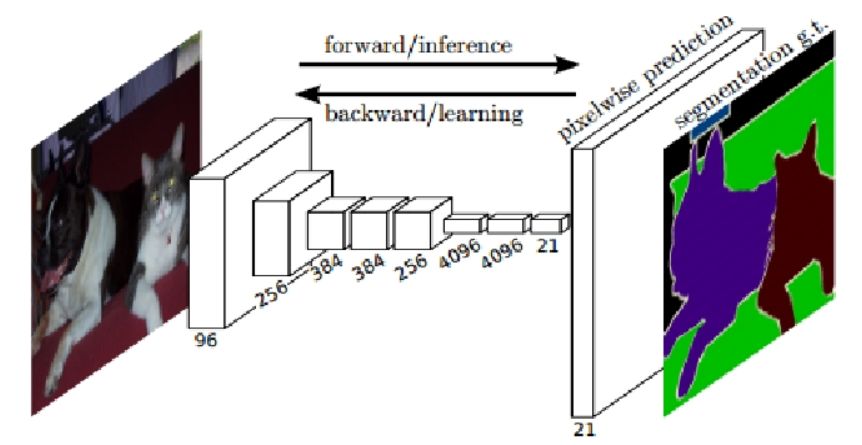

2.SegNet

針對(duì) FCN 在語義分割時(shí)感受野固定和分割物體細(xì)節(jié)容易丟失或被平滑的問題, SegNet被提出。SegNet和FCN思路十分相似,編碼部分主要由VGG16網(wǎng)絡(luò)的前 13 個(gè)卷積層和 5 個(gè)池化層組成,解碼部分同樣也由 13 個(gè)卷積層和 5 個(gè)上采樣層組成,最后一個(gè)解碼器輸出的高維特征被送到可訓(xùn)練的softmax 分類器中,用于分類每個(gè)獨(dú)立的像素。特別地,SegNet 網(wǎng)絡(luò)采用了 pooling indices 來保存圖像的輪廓信息,降低了參數(shù)數(shù)量。

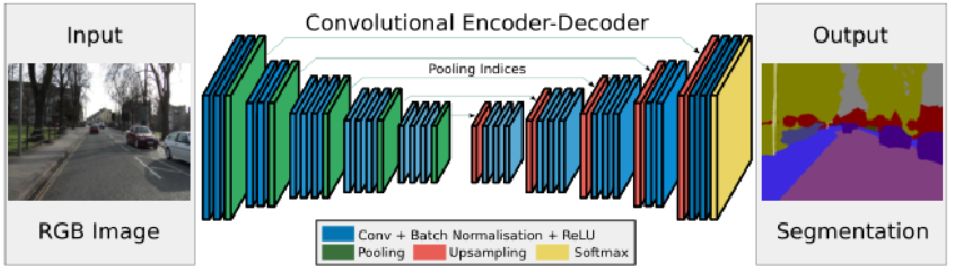

3.Unet及各種變體

U-net 對(duì)稱語義分割模型,該網(wǎng)絡(luò)模型主要由一個(gè)收縮路徑和一個(gè)對(duì)稱擴(kuò)張路徑組成,收縮路徑用來獲得上下文信息,對(duì)稱擴(kuò)張路徑用來精確定位分割邊界。U-net 使用圖像切塊進(jìn)行訓(xùn)練,所以訓(xùn)練數(shù)據(jù)量遠(yuǎn)遠(yuǎn)大于訓(xùn)練圖像的數(shù)量,這使得網(wǎng)絡(luò)在少量樣本的情況下也能獲得不變性和魯棒性。

主要特點(diǎn):

U 形的對(duì)稱結(jié)構(gòu),左半部分收縮路徑采用卷積,RELU 和最大池化獲得圖像的上下文信息,右邊的擴(kuò)展層直接復(fù)制過來,然后裁剪到與上采樣的圖片大小一樣,再將它們連接起來,實(shí)現(xiàn)了不同層特征相結(jié)合的上采樣特征圖。

模型實(shí)現(xiàn)了很好的分割效果,但只能處理 2D 圖像。

? 基于全卷積的擴(kuò)張卷積語義分割模型

基于全卷積對(duì)稱語義分割模型得到分割結(jié)果較粗糙,忽略了像素與像素之間的空間一致性關(guān)系。于是 Google 提出了一種新的擴(kuò)張卷積語義分割模型,考慮了像素與像素之間的空間一致性關(guān)系,可以在不增加參數(shù)量的情況下增加感受野。

1、DeepLab系列

DeepLabv1 是由深度卷積網(wǎng)絡(luò)和概率圖模型級(jí)聯(lián)而成的語義分割模型,由于深度卷積網(wǎng)絡(luò)在重復(fù)最大池化和下采樣的過程中會(huì)丟失很多的細(xì)節(jié)信息,所以采用擴(kuò)張卷積算法增加感受野以獲得更多上下文信息。考慮到深度卷積網(wǎng)絡(luò)在圖像標(biāo)記任務(wù)中的空間不敏感性限制了它的定位精度,采用了完全連接條件隨機(jī)場(Conditional Random Field,CRF)來提高模型捕獲細(xì)節(jié)的能力。

DeepLabv2 語義分割模型增加了 ASPP(Atrous spatial pyramid pooling)結(jié)構(gòu),利用多個(gè)不同采樣率的擴(kuò)張卷積提取特征,再將特征融合以捕獲不同大小的上下文信息。

DeepLabv3 語義分割模型,在 ASPP 中加入了全局平均池化,同時(shí)在平行擴(kuò)張卷積后添加批量歸一化,有效地捕獲了全局語境信息。

DeepLabv3+語義分割模型在 DeepLabv3 的基礎(chǔ)上增加了編-解碼模塊和 Xception 主干網(wǎng)絡(luò),增加編解碼模塊主要是為了恢復(fù)原始的像素信息,使得分割的細(xì)節(jié)信息能夠更好的保留,同時(shí)編碼豐富的上下文信息。增加 Xception 主干網(wǎng)絡(luò)是為了采用深度卷積進(jìn)一步提高算法的精度和速度。在inception結(jié)構(gòu)中,先對(duì)輸入進(jìn)行1*1的卷積,之后將通道分組,分別使用不同的3*3卷積提取特征,最后將各組結(jié)果串聯(lián)在一起作為輸出。

主要特點(diǎn):

在多尺度上為分割對(duì)象進(jìn)行帶洞空間金字塔池化(ASPP)

通過使用 DCNNs (空洞卷積)提升了目標(biāo)邊界的定位

降低了由 DCNN 的不變性導(dǎo)致的定位準(zhǔn)確率。

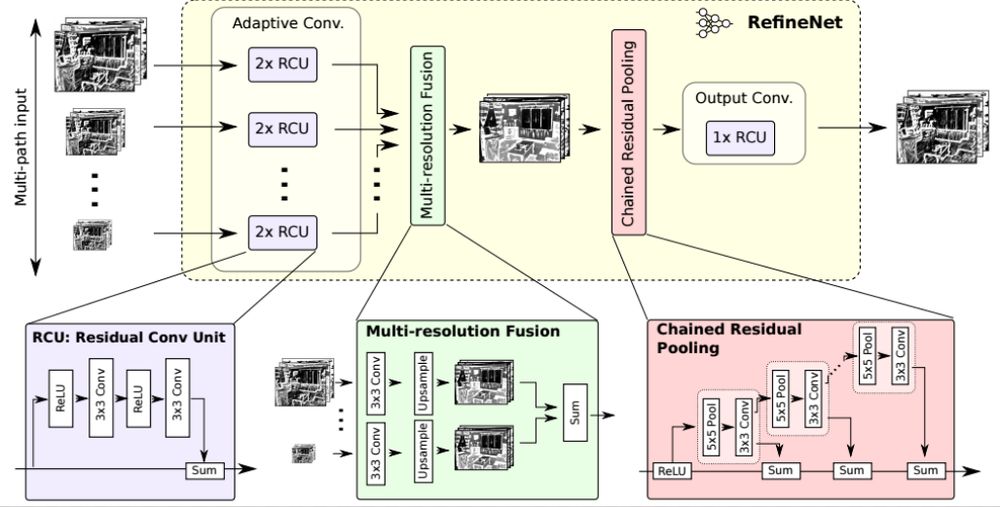

2.RefineNet

RefineNet采用了通過細(xì)化中間激活映射并分層地將其連接到結(jié)合多尺度激活,同時(shí)防止銳度損失。網(wǎng)絡(luò)由獨(dú)立的RefineNet模塊組成,每個(gè)模塊對(duì)應(yīng)于ResNet。每個(gè)RefineNet模塊由三個(gè)主要模塊組成,即:剩余卷積單元(RCU),多分辨率融合(MRF)和鏈?zhǔn)S喑?CRP)。RCU塊由一個(gè)自適應(yīng)塊組成卷積集,微調(diào)預(yù)訓(xùn)練的ResNet權(quán)重對(duì)于分割問題。MRF層融合不同的激活物使用卷積和上采樣層來創(chuàng)建更高的分辨率地圖。最后,在CRP層池中使用多種大小的內(nèi)核用于從較大的圖像區(qū)域捕獲背景上下文。

主要特點(diǎn):

提出一種多路徑refinement網(wǎng)絡(luò),稱為RefineNet。這種網(wǎng)絡(luò)可以使用各個(gè)層級(jí)的features,使得語義分割更為精準(zhǔn)。

RefineNet中所有部分都利用residual connections(identity mappings),使得梯度更容易短向或者長向前傳,使段端對(duì)端的訓(xùn)練變得更加容易和高效。

提出了一種叫做chained residual pooling的模塊,它可以從一個(gè)大的圖像區(qū)域捕捉背景上下文信息。

? 基于全卷積的殘差網(wǎng)絡(luò)語義分割模型

深度卷積神經(jīng)網(wǎng)絡(luò)的每一層特征對(duì)語義分割都有影響,如何將高層特征的語義信息與底層識(shí)別的邊界與輪廓信息結(jié)合起來是一個(gè)具有挑戰(zhàn)性的問題。

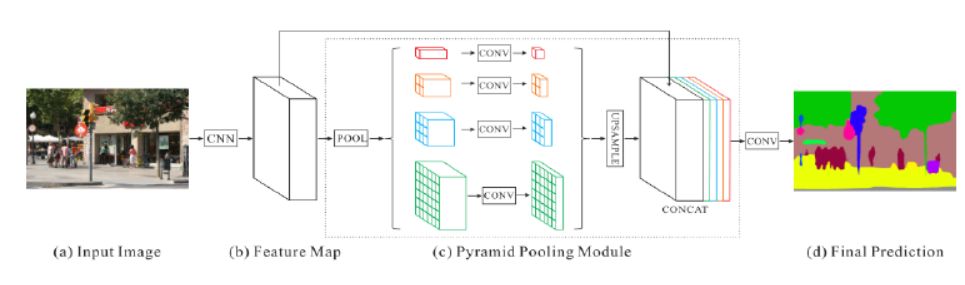

PSPNet

金字塔場景稀疏網(wǎng)絡(luò)語義分割模型(Pyramid Scene Parsing Network,PSP)首先結(jié)合預(yù)訓(xùn)練網(wǎng)絡(luò) ResNet和擴(kuò)張網(wǎng)絡(luò)來提取圖像的特征,得到原圖像 1/8 大小的特征圖,然后,采用金字塔池化模塊將特征圖同時(shí)通過四個(gè)并行的池化層得到四個(gè)不同大小的輸出,將四個(gè)不同大小的輸出分別進(jìn)行上采樣,還原到原特征圖大小,最后與之前的特征圖進(jìn)行連接后經(jīng)過卷積層得到最后的預(yù)測分割圖像。

主要特點(diǎn):

金字塔場景解析網(wǎng)絡(luò)是建立在FCN之上的基于像素級(jí)分類網(wǎng)絡(luò)。將大小不同的內(nèi)核集中在一起激活地圖的不同區(qū)域創(chuàng)建空間池金字塔。

特性映射來自網(wǎng)絡(luò)被轉(zhuǎn)換成不同分辨率的激活,并經(jīng)過多尺度處理池層,稍后向上采樣并與原始層連接進(jìn)行分割的feature map。

學(xué)習(xí)的過程利用輔助分類器進(jìn)一步優(yōu)化了像ResNet這樣的深度網(wǎng)絡(luò)。不同類型的池模塊側(cè)重于激活的不同區(qū)域地圖。

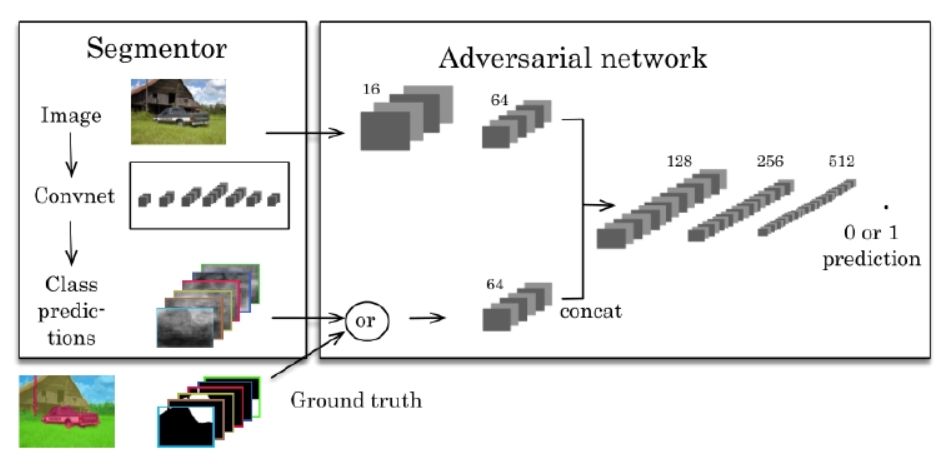

? 基于全卷積的GAN語義分割模型

生成對(duì)抗網(wǎng)絡(luò)模型(Generative Adversarial Nets,GAN)同時(shí)訓(xùn)練生成器 G 和判別器 D,判別器用來預(yù)測給定樣本是來自于真實(shí)數(shù)據(jù)還是來自于生成模型。

利用對(duì)抗訓(xùn)練方法訓(xùn)練語義分割模型,將傳統(tǒng)的多類交叉熵?fù)p失與對(duì)抗網(wǎng)絡(luò)相結(jié)合,首先對(duì)對(duì)抗網(wǎng)絡(luò)進(jìn)行預(yù)訓(xùn)練,然后使用對(duì)抗性損失來微調(diào)分割網(wǎng)絡(luò),如下圖所示。左邊的分割網(wǎng)絡(luò)將 RGB 圖像作為輸入,并產(chǎn)生每個(gè)像素的類別預(yù)測。右邊的對(duì)抗網(wǎng)絡(luò)將標(biāo)簽圖作為輸入并生成類標(biāo)簽(1 代表真實(shí)標(biāo)注,0 代表合成標(biāo)簽)。

? 基于全卷積語義分割模型對(duì)比

名稱 | 優(yōu)點(diǎn) | 缺點(diǎn) |

FCN | 可以接受任意大小的圖像輸入;避免了采用像素塊帶來的重復(fù)存儲(chǔ)和計(jì)算的問題 | 得到的結(jié)果不太精確,對(duì)圖像的細(xì)節(jié)不敏感,沒有考慮像素與像素之間的關(guān)系,缺乏空間一致性 |

SegNet | 使用去池化對(duì)特征圖進(jìn)行上采樣,在分割中保持細(xì)節(jié)的完整性;去掉全連接層,擁有較少的參數(shù) | 當(dāng)對(duì)低分辨率的特征圖進(jìn)行去池化時(shí),會(huì)忽略鄰近像素的信息 |

Deconvnet | 對(duì)分割的細(xì)節(jié)處理要強(qiáng)于 FCN,位于低層的filter 能捕獲目標(biāo)的形狀信息,位于高層的 filter能夠捕獲特定類別的細(xì)節(jié)信息,分割效果更好 | 對(duì)細(xì)節(jié)的處理難度較大 |

U-net | 簡單地將編碼器的特征圖拼接至每個(gè)階段解碼器的上采樣特征圖,形成了一個(gè)梯形結(jié)構(gòu);采用跳躍連接架構(gòu),允許解碼器學(xué)習(xí)在編碼器池化中丟失的相關(guān)性 | 在卷積過程中沒有加pad,導(dǎo)致在每一次卷積后,特征長度就會(huì)減少兩個(gè)像素,導(dǎo)致網(wǎng)絡(luò)最后的輸出與輸入大小不一樣 |

DeepLab | 使用了空洞卷積;全連接條件隨機(jī)場 | 得到的預(yù)測結(jié)果只有原始輸入的 1/8 大小 |

RefineNet | 帶有解碼器模塊的編碼器-解碼器結(jié)構(gòu);所有組件遵循殘差連接的設(shè)計(jì)方式 | 帶有解碼器模塊的編碼器-解碼器結(jié)構(gòu);所有組件遵循殘差連接的設(shè)計(jì)方式 |

PSPNet | 提出金字塔模塊來聚合背景信息;使用了附加損失 | 采用四種不同的金字塔池化模塊,對(duì)細(xì)節(jié)的處理要求較高 |

GCN | 提出了帶有大維度卷積核的編碼器-解碼器結(jié)構(gòu) | 計(jì)算復(fù)雜,具有較多的結(jié)構(gòu)參數(shù) |

DeepLabV3 ASPP | 采用了Multigrid;在原有的網(wǎng)絡(luò)基礎(chǔ)上增加了幾個(gè) block;提出了ASPP,加入了 BN | 不能捕捉圖像大范圍信息,圖像層的特征整合只存在于 ASPP中 |

GAN | 提出將分割網(wǎng)絡(luò)作為判別器,GAN 擴(kuò)展訓(xùn)練數(shù)據(jù),提升訓(xùn)練效果;將判別器改造為 FCN,從將判別每一個(gè)樣本的真假變?yōu)槊恳粋€(gè)像素的真假 | 沒有比較與全監(jiān)督+半監(jiān)督精調(diào)模型的實(shí)驗(yàn)結(jié)果,只體現(xiàn)了在本文中所提創(chuàng)新點(diǎn)起到了一定的作用,但并沒有體現(xiàn)有效的程度 |

邊界框標(biāo)注

為了擴(kuò)展可用數(shù)據(jù)集,Dai 等人使用易獲取的邊界框標(biāo)注數(shù)據(jù)集來訓(xùn)練分割模型,該模型在自動(dòng)生成候選區(qū)域與訓(xùn)練卷積網(wǎng)絡(luò)之間交替進(jìn)行,通過 MCG來選取帶有語義標(biāo)注的區(qū)域,采用卷積網(wǎng)絡(luò)生成候選區(qū)域的分割掩膜。在網(wǎng)絡(luò)迭代時(shí),由于邊界框可以增強(qiáng)網(wǎng)絡(luò)識(shí)別目標(biāo)的能力,通過更新卷積網(wǎng)絡(luò)中的參數(shù)來校正分割掩膜,提升語義分割效率。

簡筆標(biāo)注

Lin 等人提出基于用戶交互的圖像語義分割方法,該方法使用簡筆對(duì)圖像進(jìn)行注釋,利用圖模型訓(xùn)練卷積網(wǎng)絡(luò),用來對(duì)簡筆標(biāo)注的圖像進(jìn)行語義分割,基于圖模型將簡筆標(biāo)注的信息結(jié)合空間約束、外觀及語義內(nèi)容,傳播到未標(biāo)記的像素上并學(xué)習(xí)網(wǎng)絡(luò)參數(shù)。簡筆標(biāo)注無需仔細(xì)勾勒圖像邊界和形狀,只需對(duì)每類語義畫一條線作為標(biāo)記,有利于注釋沒有明確定義形狀的物體(例如,天空,草)。

圖像級(jí)標(biāo)注

Pinheiro 等人采用多示例學(xué)習(xí)模型構(gòu)建圖像標(biāo)簽與像素之間的關(guān)聯(lián)性,首先使用 ImageNet圖像級(jí)標(biāo)簽對(duì)模型進(jìn)行訓(xùn)練,利用 CNN 生成特征平面,然后將這些特征平面通過聚合層對(duì)模型進(jìn)行約束,該模型得到了很好的分割結(jié)果。

本文主要對(duì)于圖像語義分割技術(shù)的研究發(fā)展歷程進(jìn)行了詳細(xì)評(píng)述,對(duì)于傳統(tǒng)的語義分割方法到當(dāng)前主流的基于深度學(xué)習(xí)的圖像語義分割理論及其方法做出了綜合性的評(píng)估,對(duì)基于深度學(xué)習(xí)語義分割技術(shù)需要用到的網(wǎng)絡(luò)模型、網(wǎng)絡(luò)框架、分割流程進(jìn)行了詳細(xì)的評(píng)估。

在深入該領(lǐng)域后發(fā)現(xiàn)該領(lǐng)域仍然存在著非常多的未知問題值得深入探究。基于以上分析,提出今后的研究方向:

(1)實(shí)時(shí)語義分割技術(shù)。現(xiàn)階段評(píng)價(jià)應(yīng)用于語義分割的網(wǎng)絡(luò)模型主要著重點(diǎn)在精確率上,但是隨著應(yīng)用于現(xiàn)實(shí)場景的要求越來越高,需要更短的響應(yīng)時(shí)間,因此在維持高精確率的基礎(chǔ)上,盡量縮短響應(yīng)時(shí)間應(yīng)是今后工作的方向。

(2)弱監(jiān)督或無監(jiān)督語義分割技術(shù)。針對(duì)需要大量的標(biāo)注數(shù)據(jù)集才能提高網(wǎng)絡(luò)模型的精度這個(gè)問題,弱監(jiān)督或無監(jiān)督的語義分割技術(shù)將會(huì)是未來發(fā)展的趨勢。

(3)三維場景的語義分割技術(shù)。目前的諸多基于深度學(xué)習(xí)的語義分割技術(shù)所用以訓(xùn)練的數(shù)據(jù)主要是二維的圖片數(shù)據(jù),同時(shí)測試的對(duì)象往往也是二維的圖片,但是在實(shí)際應(yīng)用時(shí)所面對(duì)的環(huán)境是一個(gè)三維環(huán)境,將語義分割技術(shù)應(yīng)用至實(shí)際中,未來需要針對(duì)三維數(shù)據(jù)的語義分割技術(shù)進(jìn)行研究。

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競賽等微信群(以后會(huì)逐漸細(xì)分),請掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請進(jìn)入相關(guān)微信群。請勿在群內(nèi)發(fā)送廣告,否則會(huì)請出群,謝謝理解~