快速回顧:U-Net Family方法匯總

極市導(dǎo)讀

?Unet作為FCN 的一種變體,因為其結(jié)構(gòu)能夠結(jié)合底層和高層的信息,成為大多做醫(yī)療影像語義分割任務(wù)的基礎(chǔ)。本文是關(guān)于U-Net的體系結(jié)構(gòu)一篇匯總,分別介紹了U-Net,Attention U-Net,UNet++的概念及詳細(xì)分類。>加入極市CV技術(shù)交流群,走在計算機視覺的最前沿

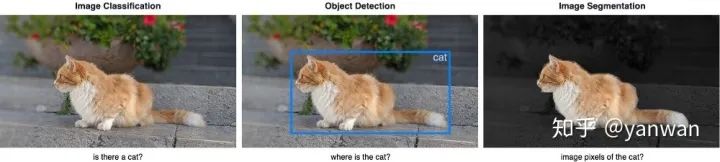

1 Image Segmentation

Image Classification: 幫助我們對圖像中包含的內(nèi)容進(jìn)行分類。目標(biāo)是通過預(yù)測是或否來回答“此圖像中是否有貓?”。

Object Detectio: 指定對象在圖像中的位置。目的是通過在感興趣的對象周圍繪制邊框來識別“貓在此圖像中的什么位置?”。

Image Segmentation: 為圖像中的每個對象創(chuàng)建一個像素級掩碼。目的是通過對每個像素進(jìn)行分類來識別圖像中不同對象的位置和形狀。

2 Metrics

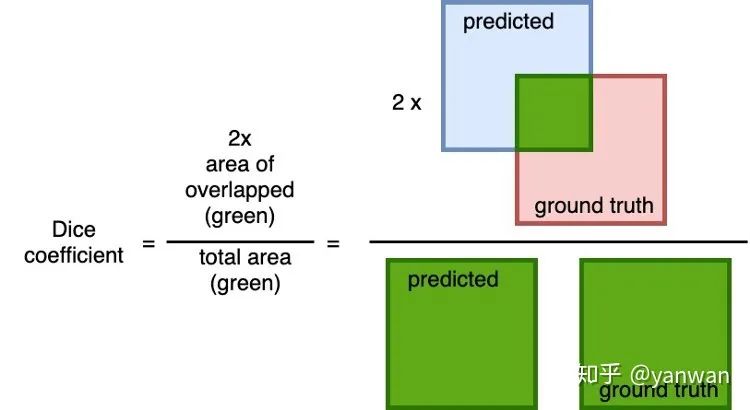

我們需要一組度量標(biāo)準(zhǔn)來比較不同的模型,通常有BCE,Dice系數(shù)和IoU。

Binary cross-entropy: 二分類的交叉熵?fù)p失;

Dice coefficient: 是預(yù)測值與之間之間的重疊的通用度量標(biāo)準(zhǔn)。計算公式為2 *重疊面積(預(yù)測值和真實值之間)除以總面積(預(yù)測的和真實的基礎(chǔ)相加)。此指標(biāo)的范圍是0到1,其中1表示完美和完全重疊。

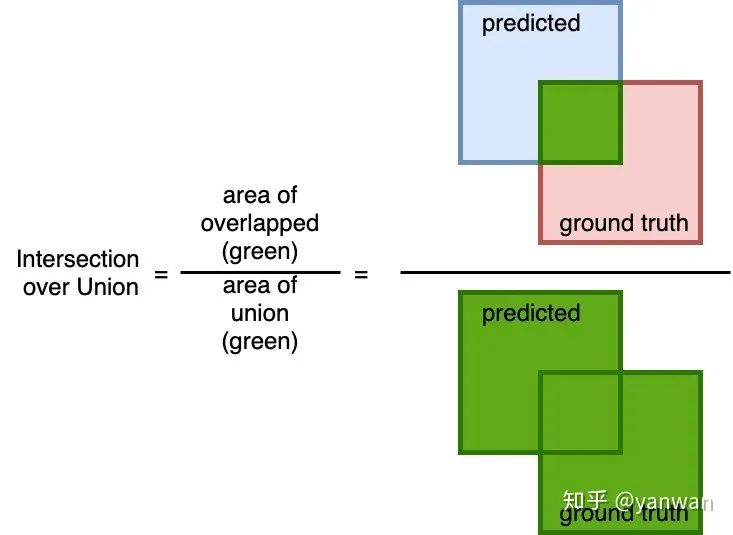

Intersection over Union: 一個簡單的度量標(biāo)準(zhǔn),重疊區(qū)域(在預(yù)測的和真實值之間)并除以并集的區(qū)域(在預(yù)測值和真實值之間)。與Dice系數(shù)相似,此度量范圍為0到1,其中0表示無重疊,而1表示預(yù)測的和地面真實情況之間的完全重疊。

3 U-Net

U-Net發(fā)表在2015年MICCAI上。盡管U-Net也可用于自然圖像的分割,但它在許多生物醫(yī)學(xué)圖像的圖像分割任務(wù)中都得到不錯得效果。

Requires fewer training samples

深度學(xué)習(xí)模型的成功訓(xùn)練需要成千上萬的帶注釋的訓(xùn)練樣本,但是獲取帶注釋的醫(yī)學(xué)圖像是巨大的。U-Net可以使用更少的訓(xùn)練樣本進(jìn)行端到端訓(xùn)練。

Precise segmentation

精確的分割掩碼在自然圖像中可能并不重要,但是醫(yī)學(xué)圖像中的邊緣分割錯誤會導(dǎo)致結(jié)果在臨床環(huán)境中不可靠。盡管培訓(xùn)師樣本較少,但U-Net仍可以產(chǎn)生更精確的細(xì)分。

Architecture

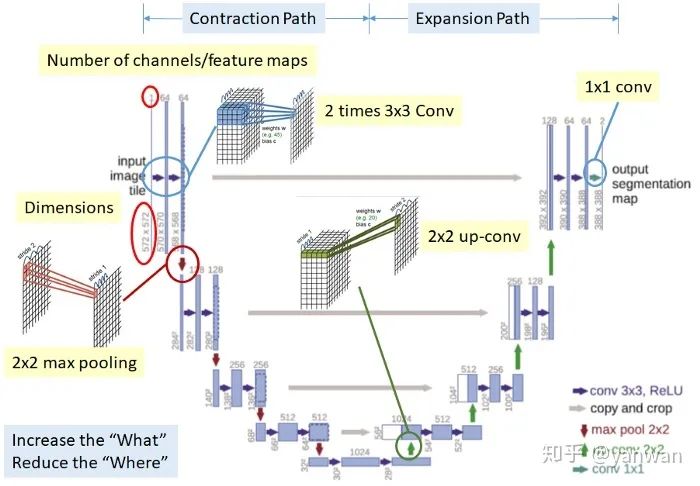

U-Net具有優(yōu)雅的結(jié)構(gòu),網(wǎng)絡(luò)是對稱得,并形成U形的結(jié)構(gòu)。

Contraction path (downsampling)

看起來像典型的CNN架構(gòu),通過連續(xù)堆疊兩個3x3卷積(藍(lán)色箭頭),然后進(jìn)行2x2最大池化(紅色箭頭)進(jìn)行下采樣。在每個下采樣步驟,通道數(shù)量都會加倍。

Expansion path (up-convolution)

一個用于上采樣的2x2向上卷積(綠色箭頭)和兩個3x3向上卷積(藍(lán)色箭頭)。在每個上采樣步驟中,通道數(shù)減半。

在每次2x2向上卷積之后,由于每次卷積中邊界像素的丟失,一系列特征映射從Contracting path(灰色箭頭)到有相應(yīng)的圖層,以提供從contraction path 到 expansion path 的定位信息。

Final layer

1x1卷積以將要素映射映射到所需的類數(shù)。

4 Attention U-Net

論文:Attention Gates for Image Analysis

代碼:ozan-oktay/Attention-Gated-Networks(https://github.com/ozan-oktay/Attention-Gated-Networks)

盡管U-Net具有良好的表示能力,但它依賴于多級級聯(lián)卷積神經(jīng)網(wǎng)絡(luò)。這些級聯(lián)框架提取感興趣的區(qū)域并做出密集的預(yù)測。這種方法在重復(fù)提取低層特征時會導(dǎo)致計算資源的過度和冗余使用。

What is new in Attention U-Net?

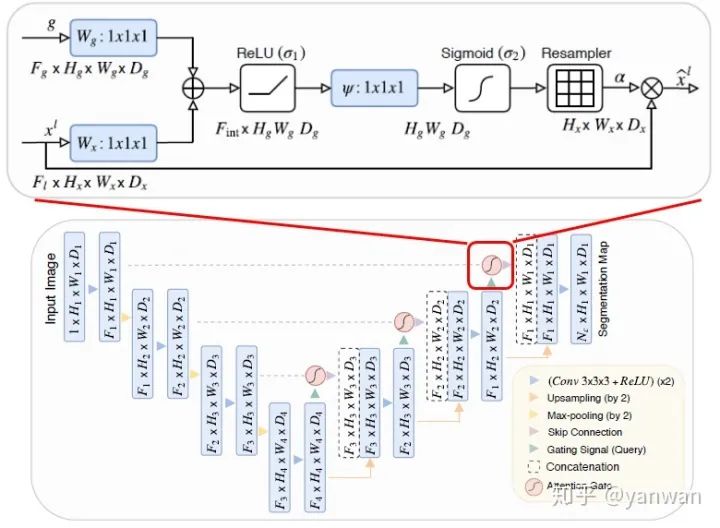

UNet++在原來的U-Net基礎(chǔ)上增加:Attention gates

Attention gates的結(jié)構(gòu)如上圖頂部所示。

首先,輸入分別經(jīng)過2個1×1×1卷積,然后將其相加再使用ReLU。

其次,再次執(zhí)行1×1×1轉(zhuǎn)換,但是這次以Sigmoid作為激活函數(shù)。

然后,它會經(jīng)過重采樣器(實際上是三線性插值),以使特征圖的大小與要乘元素的大小相同。

最后,使用較低級別的上采樣特征圖和原始特征進(jìn)行Element-wise。

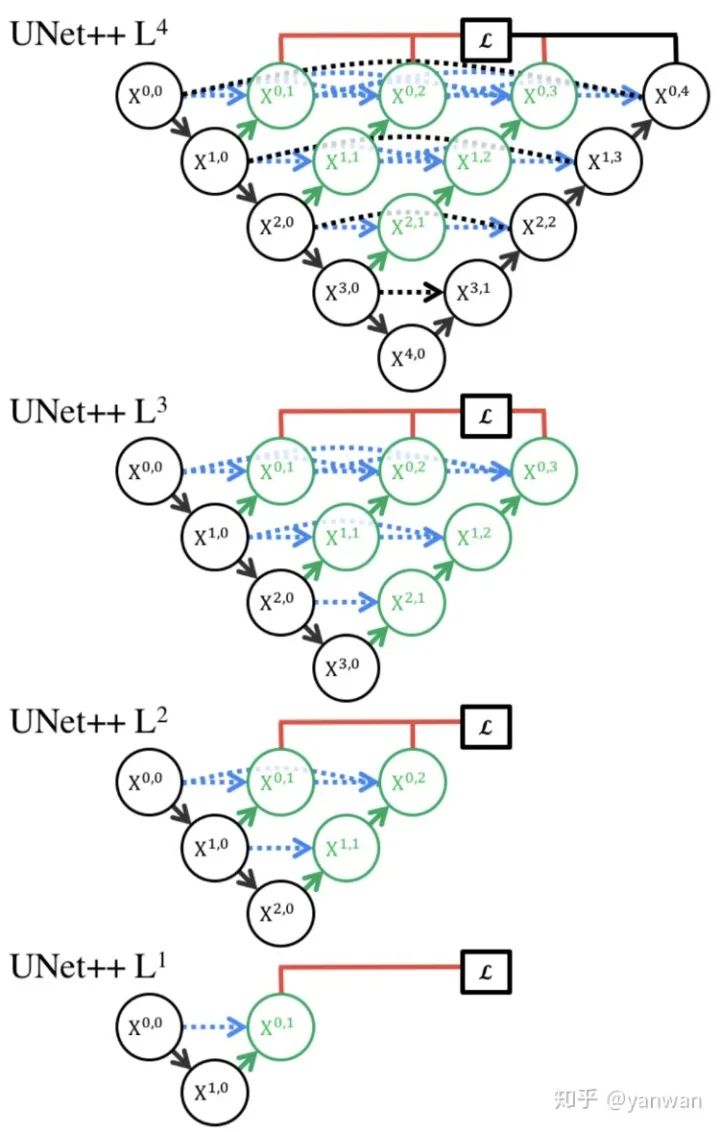

5 UNet++

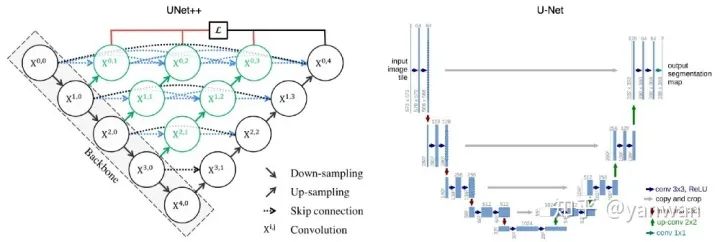

UNet++通過在編碼器和解碼器之間加入密集的塊和卷積層來提高分割精度。

What is new in UNet++?

UNet++在原來的U-Net基礎(chǔ)上增加了3項功能:

redesigned skip pathways(以綠色顯示) dense skip connections(以藍(lán)色顯示) deep supervision(紅色顯示)

Redesigned skip pathways

在UNet++中,添加了Redesigned skip pathways(以綠色顯示),從而導(dǎo)致語義上不同的特征映射的融合,以融合編碼器和解碼器子路徑映射之間的語義差距。

Redesigned skip pathways的所有卷積都使用3×3大小的核。

Dense skip connections

UNet++中的Dense skip connections(藍(lán)色顯示)在編碼器和解碼器之間實現(xiàn)了跳躍連接。這些稠密塊的設(shè)計靈感來自DenseNet,目的是提高分割精度和改善梯度流。

Deep supervision

在UNet ++中,添加了深度監(jiān)督(以紅色顯示),以便可以修剪模型以調(diào)整模型的復(fù)雜性,從而在速度(推理時間)和性能之間取得平衡。對于精確模式,平均所有細(xì)分分支的輸出。對于快速模式,從分割分支之一中選擇最終的輸出。

Conclusion

U-Net體系結(jié)構(gòu)非常適合生物醫(yī)學(xué)圖像分割,盡管僅使用50張圖像進(jìn)行訓(xùn)練,但實現(xiàn)了非常好的性能,并且訓(xùn)練時間非常合理。

參考:

http://weixin.qq.com/r/-S50bE3EahAVrQkP93vv?

推薦閱讀