【深度學(xué)習(xí)】頂刊TPAMI 2022!基于不同數(shù)據(jù)模態(tài)的行為識(shí)別:最新綜述

Human Action Recognition from Various Data Modalities: A Review

論文:https://arxiv.org/abs/2012.11866

1. 介紹

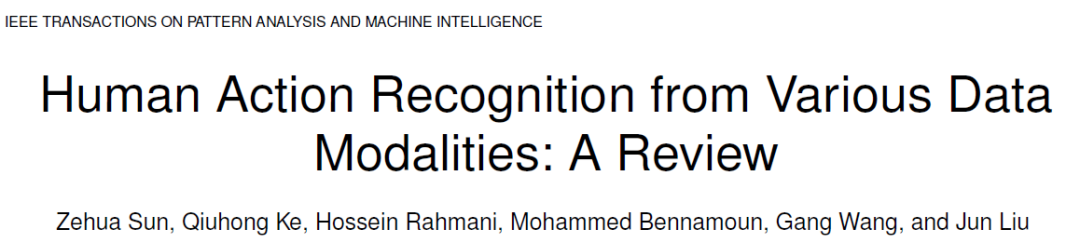

人類行為識(shí)別旨在了解人類的行為,并為行為指定標(biāo)簽,例如,握手、吃東西、跑步等。它具有廣泛的應(yīng)用前景,因此在計(jì)算機(jī)視覺(jué)領(lǐng)域受到越來(lái)越多的關(guān)注。人類行為可以使用各種數(shù)據(jù)模態(tài)來(lái)表示,如RGB、骨架、深度、紅外序列、點(diǎn)云、事件流、音頻、加速信號(hào)、雷達(dá)和WiFi,這些數(shù)據(jù)模態(tài)在不同的場(chǎng)景下具有不同的優(yōu)勢(shì)。因此,現(xiàn)有的論文試圖基于主流的深度學(xué)習(xí)來(lái)研究不同的數(shù)據(jù)模態(tài)的的行為識(shí)別方法。

該論文從模態(tài)的角度,對(duì)當(dāng)前基于深度學(xué)習(xí)的行為識(shí)別方法進(jìn)行了全面的綜述。具體來(lái)說(shuō),

(1)該論文回顧了基于單模態(tài)的行為識(shí)別方法,這些模態(tài)包括RGB、骨架、深度、紅外序列、點(diǎn)云、事件流、音頻、加速信號(hào)、雷達(dá)和WiFi。

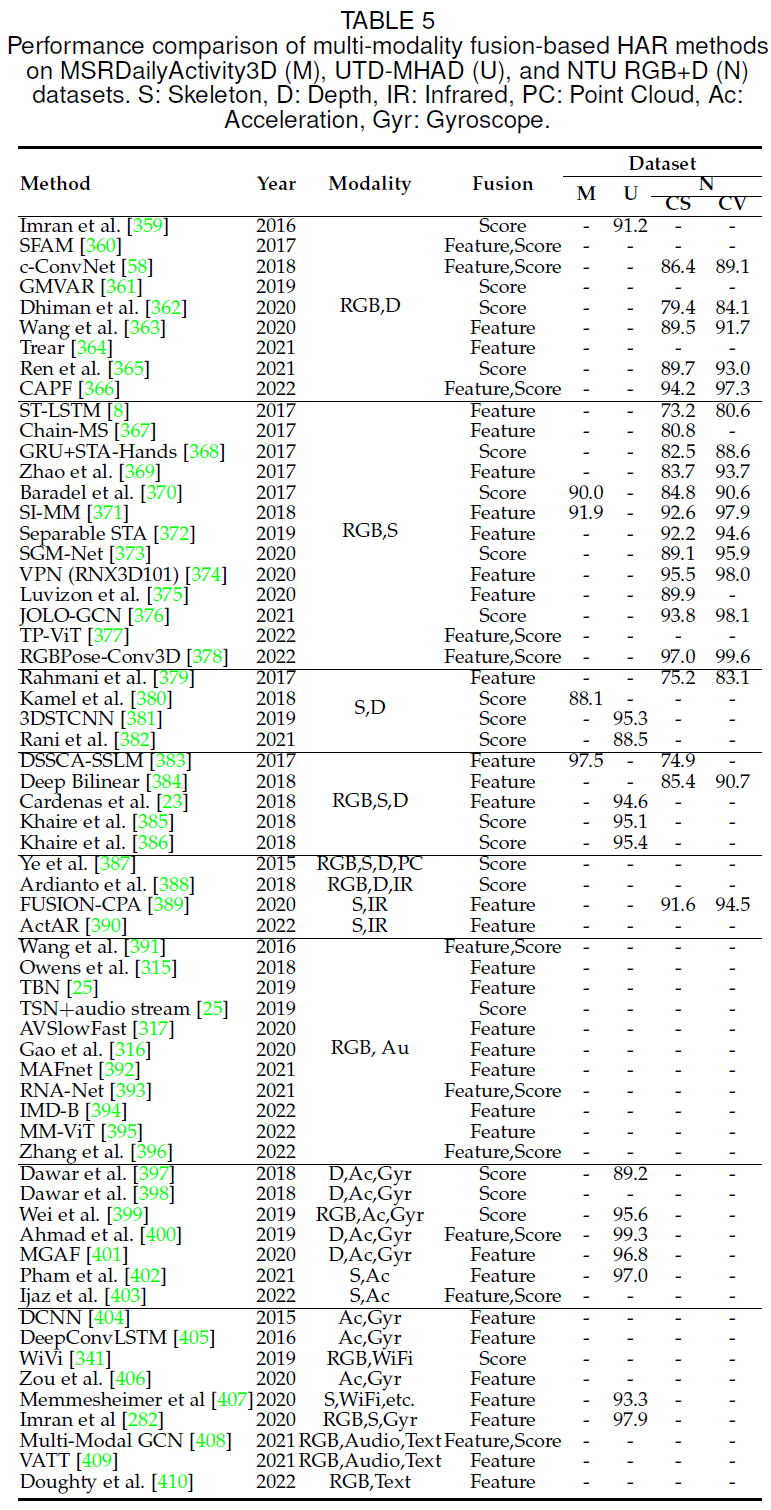

(2)該論文回顧了基于多模態(tài)的行為識(shí)別方法,并將其分為多模態(tài)融合和跨模態(tài)協(xié)同學(xué)習(xí)兩種類型。

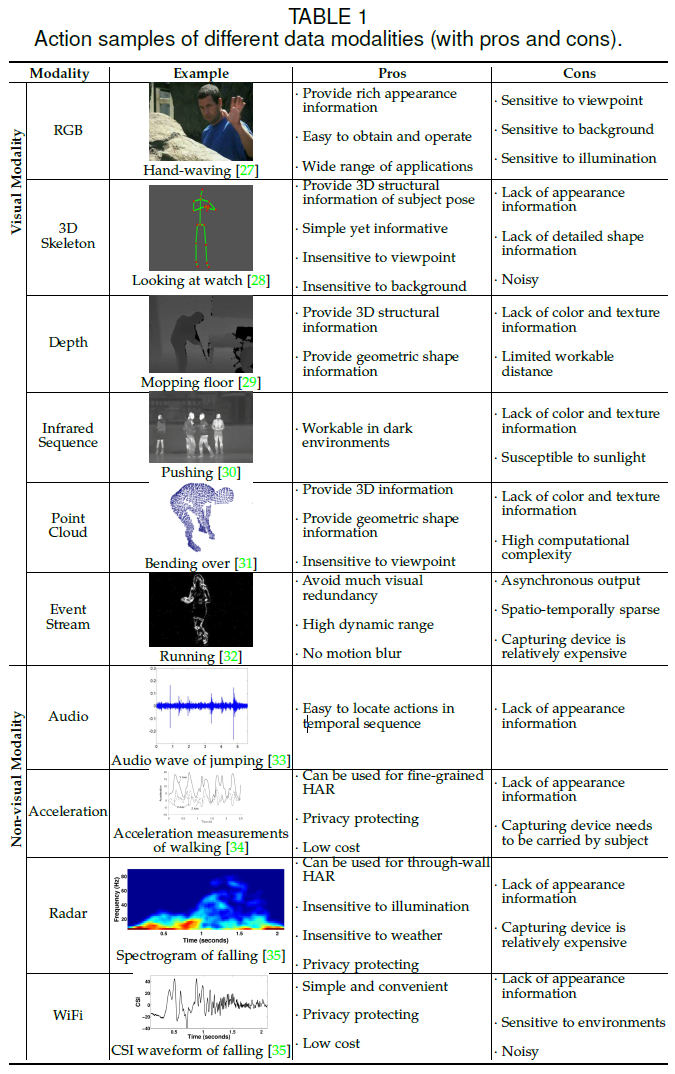

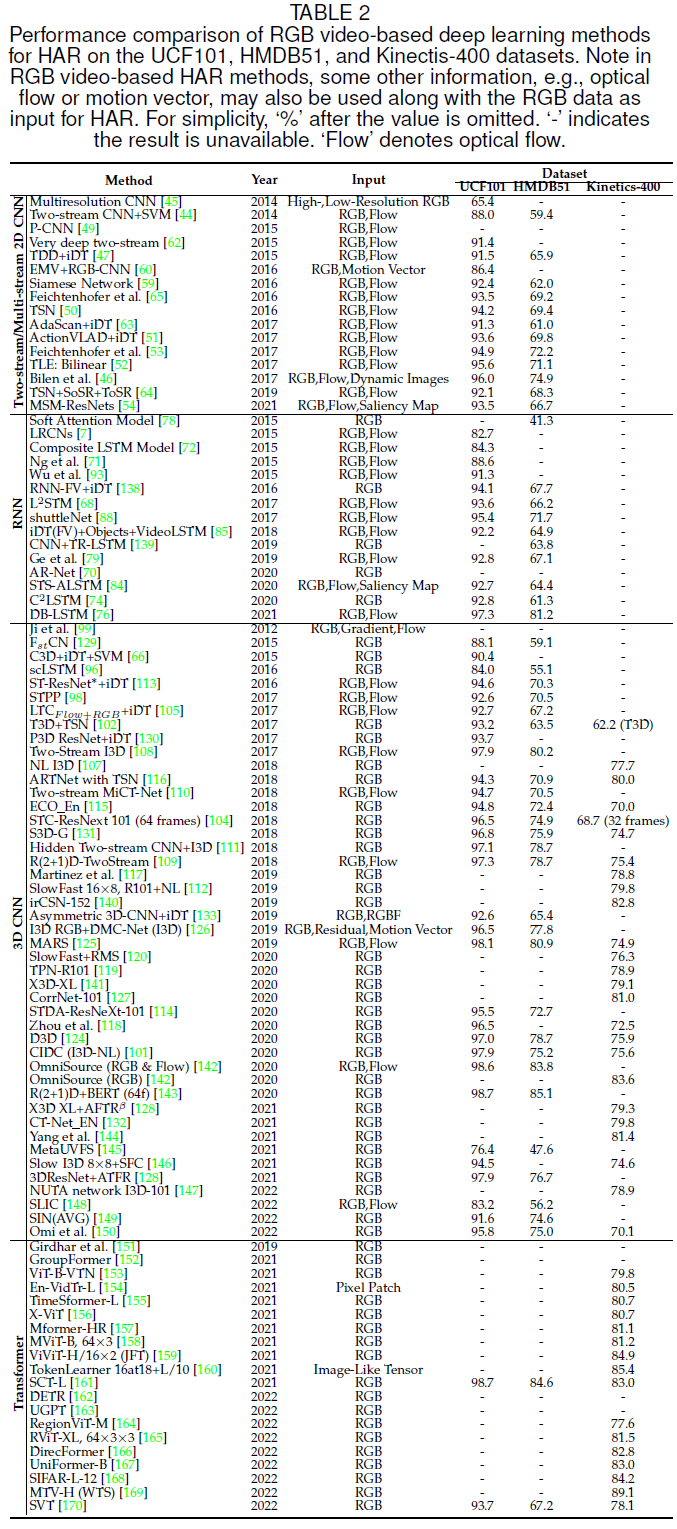

(3)該論文回顧了最新和最先進(jìn)的深度學(xué)習(xí)方法,包括CNN、RNN、GCN和Transformer,并在幾個(gè)基準(zhǔn)數(shù)據(jù)集上對(duì)現(xiàn)有方法及其性能進(jìn)行了全面比較。

2.「數(shù)據(jù)模態(tài)」都有哪些?

在本文中,主要回顧了基于RGB、骨架、深度、紅外序列、點(diǎn)云、事件流、音頻、加速信號(hào)、雷達(dá)和WiFi模態(tài)的行為識(shí)別方法。此外,其他的數(shù)據(jù)模態(tài),如角速度、射頻、肌電圖等等,也可被用于行為識(shí)別。

(1)RGB視頻:行為識(shí)別領(lǐng)域中最常見(jiàn)的數(shù)據(jù)模態(tài),被廣泛地應(yīng)用于視覺(jué)監(jiān)視、自主導(dǎo)航等應(yīng)用中。RGB模態(tài)包含了豐富的場(chǎng)景上下文外觀信息,但易于受到背景、視角、人體尺度和照明條件變化的影響。對(duì)于RGB模態(tài),最常見(jiàn)的四類深度學(xué)習(xí)網(wǎng)絡(luò)是雙流2D CNN,RNN,3D CNN,和Transformer。

(2)骨架序列:編碼人體關(guān)節(jié)的軌跡,當(dāng)動(dòng)作執(zhí)行不涉及物體或場(chǎng)景上下文時(shí)簡(jiǎn)潔高效,具有尺度不變性、對(duì)紋理和背景變化的魯棒性。對(duì)于骨架模態(tài),最常見(jiàn)的四類深度學(xué)習(xí)網(wǎng)絡(luò)是CNN,RNN,GCN,和Transformer。

(3)深度圖:本質(zhì)是將3D數(shù)據(jù)轉(zhuǎn)換為2D圖像,提供了可靠的人體三維結(jié)構(gòu)和幾何形狀信息,對(duì)顏色和紋理的變化具有魯棒性。

(4)紅外序列:不依賴外部環(huán)境光,適用于黑暗環(huán)境中的行為識(shí)別。

(5)點(diǎn)云:獲取目標(biāo)的三維結(jié)構(gòu)和距離信息,在機(jī)器人導(dǎo)航和自動(dòng)駕駛中得到廣泛應(yīng)用。點(diǎn)云由大量的點(diǎn)集合組成,這些點(diǎn)代表了在空間參考系統(tǒng)下目標(biāo)的空間分布和表面特征,具有很強(qiáng)的空間輪廓和三維幾何形狀表征能力,因此適用于行為識(shí)別研究。

(6)事件流:事件相機(jī),也被稱為神經(jīng)形態(tài)相機(jī)或動(dòng)態(tài)視覺(jué)傳感器,可以捕捉光照變化,并獨(dú)立地為每個(gè)像素產(chǎn)生異步事件輸出。因此,事件流數(shù)據(jù)保留了主體的運(yùn)動(dòng)信息,避免過(guò)多的背景視覺(jué)冗余。

(7)音頻:是視頻數(shù)據(jù)任務(wù)十分流行的輔助模態(tài)。由于視覺(jué)和音頻流之間的同步,音頻數(shù)據(jù)可以提供額外信息,并且可以用于定位動(dòng)作,以減少人類標(biāo)記工作和減少計(jì)算成本。

(8)加速信號(hào):通常由IMU傳感器獲取,用于細(xì)粒度和多模態(tài)的行為識(shí)別。

(9)雷達(dá):雷達(dá)高頻率和短波長(zhǎng)的信號(hào)使得其可用于細(xì)粒度的感知任務(wù)。雷達(dá)頻譜圖對(duì)光照和天氣條件變化具有魯棒性,保護(hù)隱私,可用于穿越墻壁的行為識(shí)別。

(10)WiFi:最常見(jiàn)室內(nèi)無(wú)線信號(hào)類型之一,主要利用信道狀態(tài)信息(CSI)的變化進(jìn)行行為識(shí)別的感知任務(wù)。

3.「多模態(tài)」方法有哪些?

在現(xiàn)實(shí)生活中,人們往往以多種認(rèn)知方式感知環(huán)境。同樣,多模態(tài)機(jī)器學(xué)習(xí)是一種旨在處理和關(guān)聯(lián)來(lái)自多個(gè)模態(tài)信息的建模方法。通過(guò)綜合各種數(shù)據(jù)模態(tài)的優(yōu)勢(shì)和能力,多模態(tài)機(jī)器學(xué)習(xí)通常可以提供更健壯和更準(zhǔn)確的行為識(shí)別結(jié)果。多模態(tài)學(xué)習(xí)方法主要分為兩種,即融合和協(xié)同學(xué)習(xí)。

融合是指將來(lái)自兩種或兩種以上模態(tài)的信息整合進(jìn)行訓(xùn)練和推理,例如,音頻數(shù)據(jù)可以作為骨架模態(tài)的補(bǔ)充信息來(lái)區(qū)分“拍盤子”和“拍袋子”動(dòng)作。

協(xié)同學(xué)習(xí)是指不同數(shù)據(jù)模態(tài)之間的知識(shí)遷移,例如,骨架數(shù)據(jù)可以作為輔助模態(tài),使模型能夠從RGB視頻中為行為識(shí)別提取更多的判別特征。同時(shí),協(xié)同學(xué)習(xí)還適用于現(xiàn)實(shí)生活中某些模態(tài)缺失的情況。

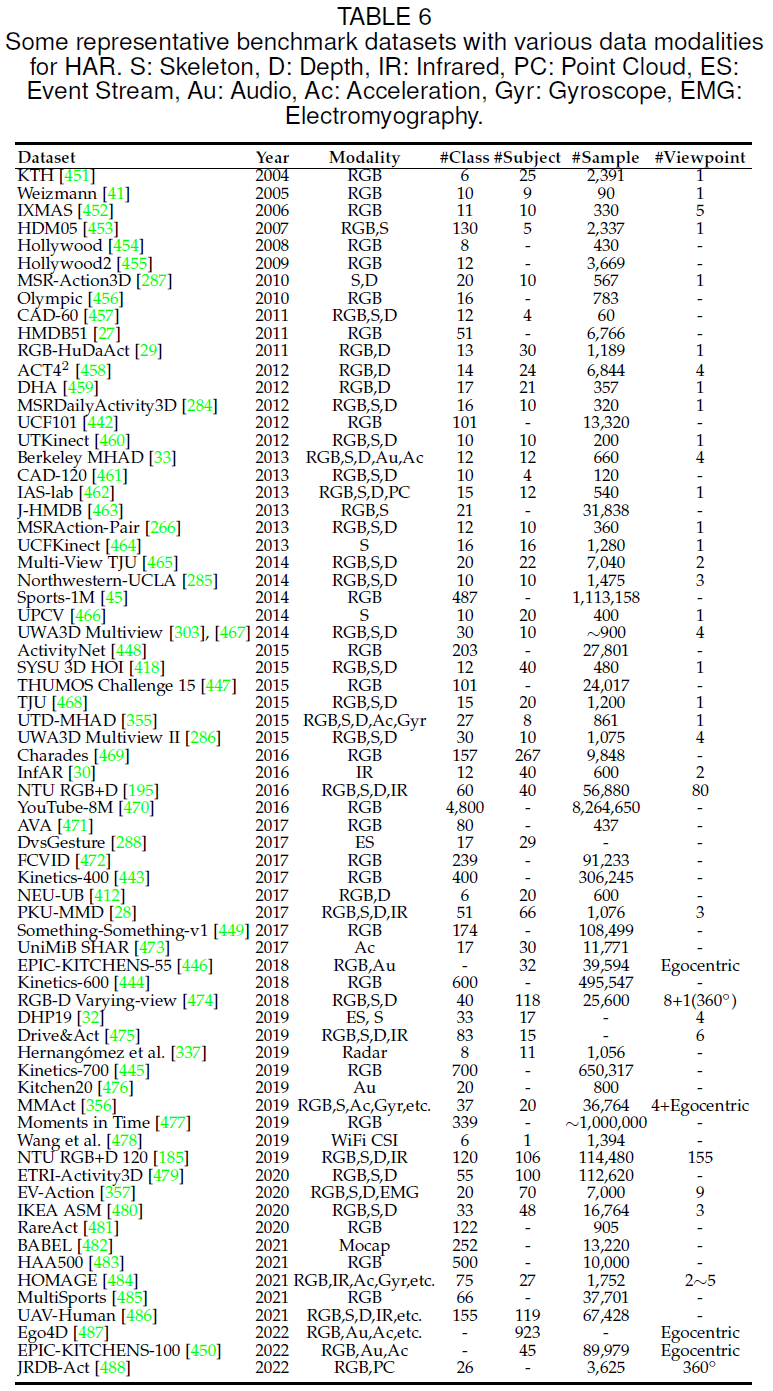

4.「數(shù)據(jù)集」有哪些?

近些年來(lái),大量的行為識(shí)別數(shù)據(jù)集被提出以訓(xùn)練和評(píng)估各種方法,該論文總結(jié)了適用于不同模態(tài)的基準(zhǔn)數(shù)據(jù)集,并提供了其相關(guān)屬性。

5. 結(jié)語(yǔ)

行為識(shí)別是近些年來(lái)備受關(guān)注的重要研究領(lǐng)域,各種具有不同特征的數(shù)據(jù)模態(tài)被研究使用。雖然已有大量的行為識(shí)別工作被提出,但在(1)數(shù)據(jù)集、(2)多模態(tài)學(xué)習(xí)、(3)低成本計(jì)算、(4)動(dòng)作預(yù)測(cè)、(5)小樣本學(xué)習(xí)、(6)非監(jiān)督和半監(jiān)督學(xué)習(xí)等方面仍需要進(jìn)一步的探索,堅(jiān)信行為識(shí)別將在未來(lái)發(fā)揮更加關(guān)鍵的作用。

該論文發(fā)表在 IEEE TPAMI - DOI: 10.1109/TPAMI.2022.3183112。

這是其最新版本(2022年6月更新),涵蓋最新的2022 CVPR。作者擬對(duì)此論文的arXiv版本進(jìn)行每年定期更新,以覆蓋人類行為識(shí)別領(lǐng)域的最新進(jìn)展。

最后附論文鏈接:https://arxiv.org/abs/2012.11866

往期精彩回顧

適合初學(xué)者入門人工智能的路線及資料下載 (圖文+視頻)機(jī)器學(xué)習(xí)入門系列下載 中國(guó)大學(xué)慕課《機(jī)器學(xué)習(xí)》(黃海廣主講) 機(jī)器學(xué)習(xí)及深度學(xué)習(xí)筆記等資料打印 《統(tǒng)計(jì)學(xué)習(xí)方法》的代碼復(fù)現(xiàn)專輯 機(jī)器學(xué)習(xí)交流qq群955171419,加入微信群請(qǐng)掃碼