TUM提出TrackFormer:基于Transformers的多目標(biāo)跟蹤

點(diǎn)擊上方“AI算法與圖像處理”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

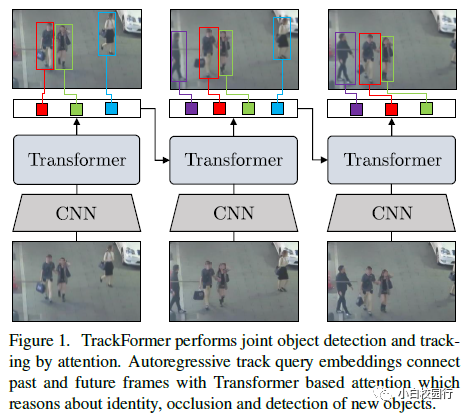

TrackFormer通過(guò)注意進(jìn)行聯(lián)合目標(biāo)檢測(cè)和跟蹤。自回歸跟蹤查詢嵌入將過(guò)去和未來(lái)的幀與基于變壓器的注意連接起來(lái),這將導(dǎo)致身份、遮擋和新對(duì)象的檢測(cè)。

作者提出了一種基于編碼器-解碼器轉(zhuǎn)換器結(jié)構(gòu)的端到端多目標(biāo)跟蹤和分割模型TrackFormer。作者的方法引入了跟蹤查詢嵌入,通過(guò)視頻序列利用一個(gè)自回歸的方式跟蹤對(duì)象。新的軌跡是由DETR對(duì)象檢測(cè)器產(chǎn)生的,并且隨著時(shí)間的推移嵌入相應(yīng)對(duì)象的位置。Transformers解碼器在幀之間調(diào)整跟蹤查詢嵌入,從而跟隨目標(biāo)位置的變化。TrackFormer在一個(gè)新的注意跟蹤范式中實(shí)現(xiàn)了幀之間的無(wú)縫數(shù)據(jù)關(guān)聯(lián),通過(guò)自我和編碼器-解碼器注意機(jī)制,同時(shí)推理位置、遮擋和對(duì)象身份。TrackFormer產(chǎn)生在多目標(biāo)跟蹤(MOT17)和分割(MOTS20)任務(wù)上的最先進(jìn)的性能狀態(tài)。作者希望作者的檢測(cè)和跟蹤的統(tǒng)一方式將促進(jìn)未來(lái)多目標(biāo)跟蹤和視頻理解的研究。

代碼將會(huì)于近期公布

在經(jīng)驗(yàn)評(píng)估中,作者將TrackFormer應(yīng)用到MOT17基準(zhǔn),在那里它達(dá)到了最優(yōu)的性能。此外,作者展示了作者的模型輸出分割蒙版的靈活性,并展示了多目標(biāo)跟蹤和分割(MOTS20)挑戰(zhàn)的最新成果。

綜上所述,作者做出了以下貢獻(xiàn):

一個(gè)基于Transformers的統(tǒng)一的檢測(cè)(或分割)和多目標(biāo)跟蹤方法,實(shí)現(xiàn)了一個(gè)新的跟蹤-注意范式的跟蹤單獨(dú)與注意關(guān)聯(lián)。

新概念的自回歸軌跡查詢嵌入對(duì)象的空間位置,并隨時(shí)間跟蹤它。

在兩個(gè)具有挑戰(zhàn)性的多目標(biāo)跟蹤基準(zhǔn)(MOT17和MOTS20)的最先進(jìn)的結(jié)果。

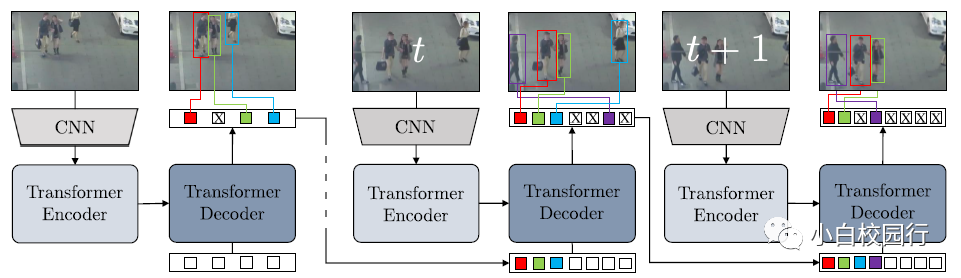

TrackFormer通過(guò)自回歸處理視頻實(shí)現(xiàn)聯(lián)合檢測(cè)和多目標(biāo)跟蹤。該體系結(jié)構(gòu)以檢測(cè)器為基礎(chǔ),由用于圖像特征提取的CNN、用于圖像特征編碼的Transformers 編碼器和Transformers解碼器組成,Transformers解碼器應(yīng)用自關(guān)注和編譯碼器的注意力,產(chǎn)生帶有包圍框和類信息的輸出嵌入。在幀t = 0時(shí),解碼器將Nobject對(duì)象查詢(白色)轉(zhuǎn)換為輸出嵌入或初始化新的軌跡查詢或預(yù)測(cè)背景類(交叉)。在隨后的幀中,解碼器處理Nobject + Ntrack查詢的聯(lián)合集合,以跟蹤或刪除(藍(lán)色)現(xiàn)有的軌道以及初始化新的軌道(紫色)。

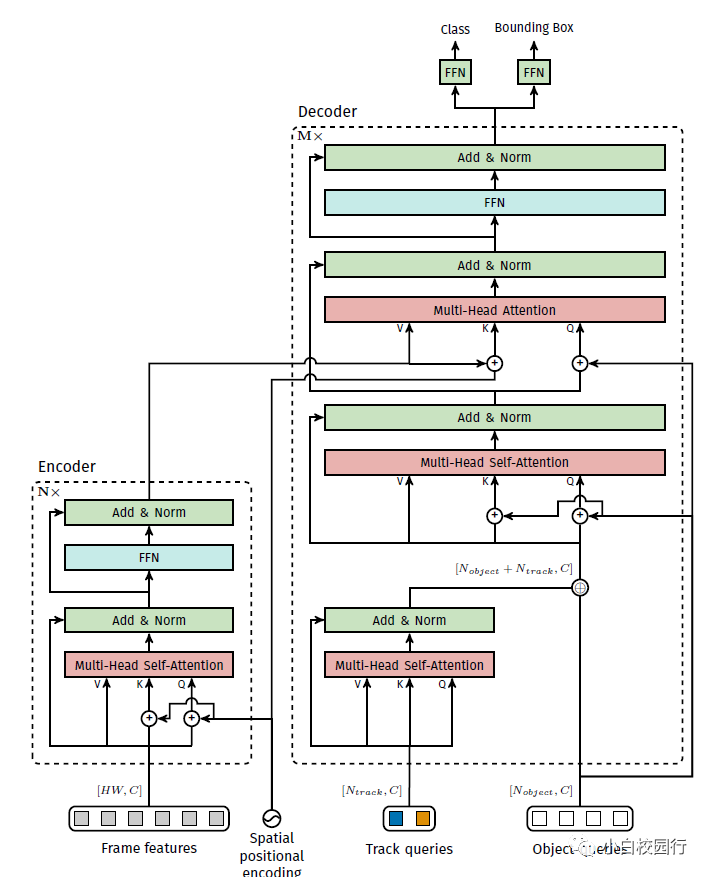

TrackFormer編碼器-解碼器架構(gòu)。作者用方括號(hào)表示張量的維數(shù)

作者在兩個(gè)mochallenge基準(zhǔn)上展示了TrackFormer的跟蹤結(jié)果,即MOT17和MOTS20。此外,作者在消融研究中驗(yàn)證了個(gè)人的貢獻(xiàn)。

TrackFormer遵循CNN特征提取和Transformers編碼器-解碼器架構(gòu)。前者是通過(guò)ResNet101骨干實(shí)現(xiàn)的,編碼器和解碼器都應(yīng)用了6層單獨(dú)的特征寬度256。每個(gè)注意層應(yīng)用8個(gè)注意頭的多自我注意。作者不使用主干的DC5(擴(kuò)張型conv5)版本,因?yàn)檫@將導(dǎo)致與最后剩余階段的較大分辨率相關(guān)的大量?jī)?nèi)存需求。然而,作者希望DC5或任何其他更重的骨干,或更高的分辨率,能夠進(jìn)一步改善結(jié)果,并將其留給未來(lái)的工作。

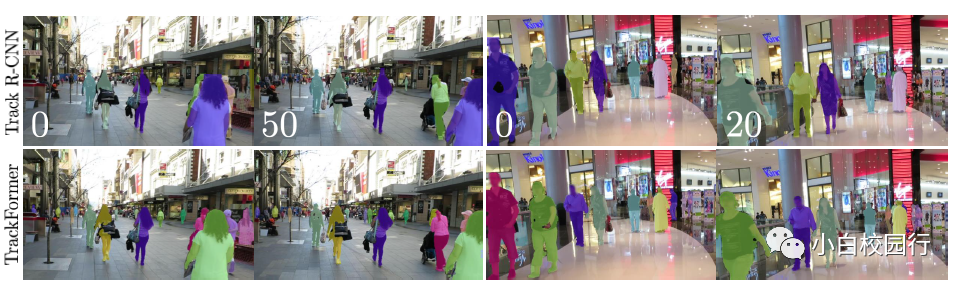

在選定的MOTS20測(cè)試序列上,作者將TrackFormer分割結(jié)果與流行的Track R-CNN進(jìn)行比較。通過(guò)像素掩模精度的差異,可以清楚地看出TrackFormer在MOTSA方面的優(yōu)勢(shì)

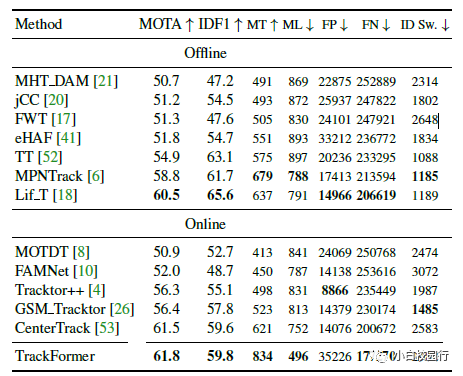

在MOT17測(cè)試集上評(píng)估的現(xiàn)代多目標(biāo)跟蹤方法的比較。作者報(bào)告了數(shù)據(jù)集提供的三組公共檢測(cè)以及在線和離線方法之間的平均結(jié)果。在所有的跟蹤方法中,TrackFormer在MOTA方面取得了最先進(jìn)的結(jié)果。箭頭指示低或高的最優(yōu)度量值。

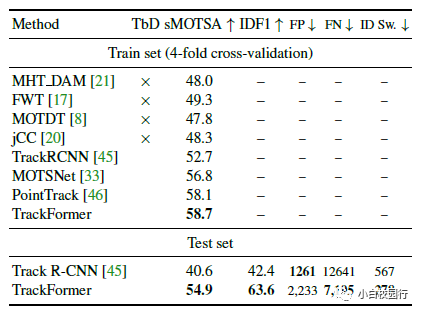

在MOTS20訓(xùn)練集和測(cè)試集上評(píng)價(jià)現(xiàn)代多目標(biāo)跟蹤和分割方法的比較。TbD所指出的方法最初是通過(guò)檢測(cè)進(jìn)行跟蹤,沒(méi)有分割。因此,他們?cè)赟DP公共檢測(cè)上進(jìn)行評(píng)估,并預(yù)測(cè)帶有附加口罩的R-CNN,在MOTS20上進(jìn)行微調(diào)。TrackFormer在motssa和IDF1兩套上實(shí)現(xiàn)了最先進(jìn)的結(jié)果。

作者提出了一種新的基于Transformers的檢測(cè)和多目標(biāo)跟蹤的端到端統(tǒng)一方法。作者的TrackFormer體系結(jié)構(gòu)引入了跟蹤查詢嵌入,它以自回歸的方式在一個(gè)序列上跟蹤對(duì)象。Transformers編碼器-解碼器體系結(jié)構(gòu)將每個(gè)軌道查詢轉(zhuǎn)換為其相應(yīng)對(duì)象的變化位置。TrackFormer associates只通過(guò)注意力操作進(jìn)行跟蹤,不依賴任何額外的匹配、圖形優(yōu)化、運(yùn)動(dòng)或外觀建模。作者的方法實(shí)現(xiàn)了多目標(biāo)跟蹤和分割的最先進(jìn)的結(jié)果。作者希望這種新的注意力跟蹤模式將促進(jìn)未來(lái)在視頻檢測(cè)和跟蹤方面的工作。

論文下載:https://arxiv.org/pdf/2101.02702.pdf

每日?qǐng)?jiān)持論文分享不易,如果喜歡我們的內(nèi)容,希望可以推薦或者轉(zhuǎn)發(fā)給周圍的同學(xué)。

下載1:何愷明頂會(huì)分享

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):何愷明,即可下載。總共有6份PDF,涉及 ResNet、Mask RCNN等經(jīng)典工作的總結(jié)分析

下載2:終身受益的編程指南:Google編程風(fēng)格指南

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):c++,即可下載。歷經(jīng)十年考驗(yàn),最權(quán)威的編程規(guī)范!

下載3 CVPR2020 在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):CVPR2020,即可下載1467篇CVPR?2020論文 個(gè)人微信(如果沒(méi)有備注不拉群!) 請(qǐng)注明:地區(qū)+學(xué)校/企業(yè)+研究方向+昵稱

覺(jué)得不錯(cuò)就點(diǎn)亮在看吧