多模態(tài)中NLP和CV的融合方式匯總

點擊上方,選擇星標或置頂,每天給你送干貨!

多種不同的信息源(不同的信息形式)中獲取信息表達

表示(Multimodal Representation)的意思,比如shift旋轉尺寸不變形,圖像中研究出的一種表示

表示的冗余問題

不同的信號,有的象征性信號,有波信號,什么樣的表示方式方便多模態(tài)模型提取信息

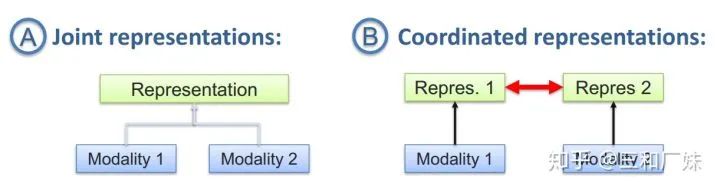

聯合表示將多個模態(tài)的信息一起映射到一個統一的多模態(tài)向量空間

協同表示負責將多模態(tài)中的每個模態(tài)分別映射到各自的表示空間,但映射后的向量之間滿足一定的相關性約束。

信號的映射,比如給一個圖像,將圖像翻譯成文字,文字翻譯成圖像,信息轉化成統一形式后來應用

方式,這里就跟專門研究翻譯的領域是重疊,基于實例的翻譯,涉及到檢索,字典(規(guī)則)等,基于生成方法如生成翻譯的內容

多模態(tài)對齊定義為從兩個或多個模態(tài)中查找實例子組件之間的關系和對應,研究不同的信號如何對齊(比如給電影,找出劇本中哪一段)

對齊方式,有專門研究對齊的領域,主要兩種,顯示對齊(比如時間維度上就是顯示對齊的),隱式對齊(比如語言的翻譯就不是位置對位置)

比如情感分析中語氣和語句的融合等

這個最難也是被研究最多的領域,比如音節(jié)和唇語頭像怎么融合,本筆記主要寫融合方式

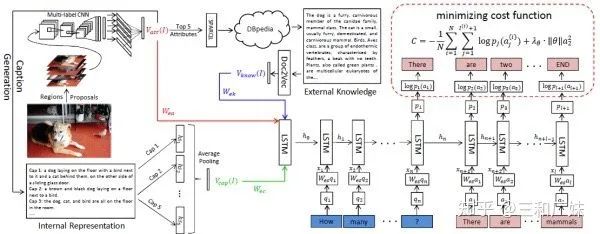

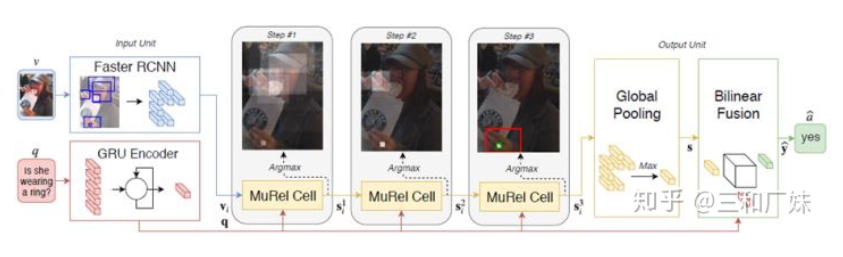

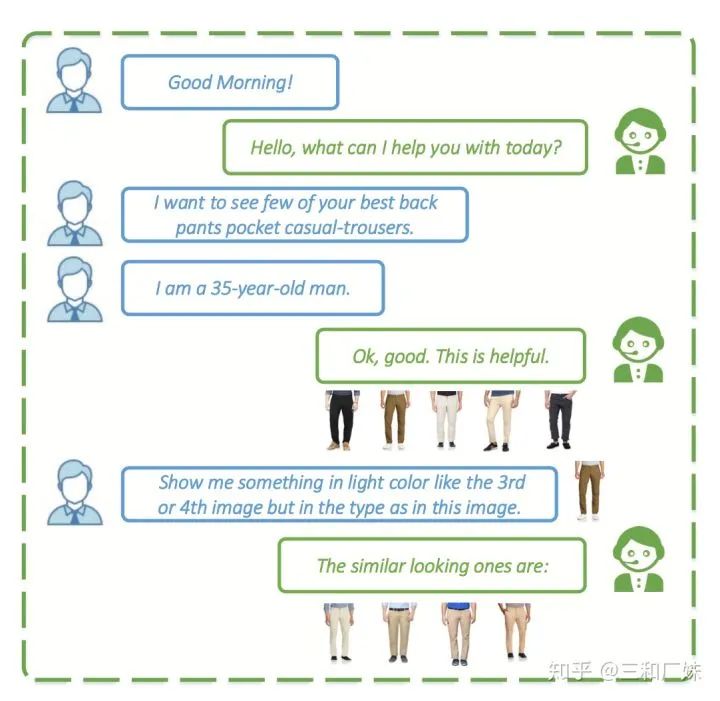

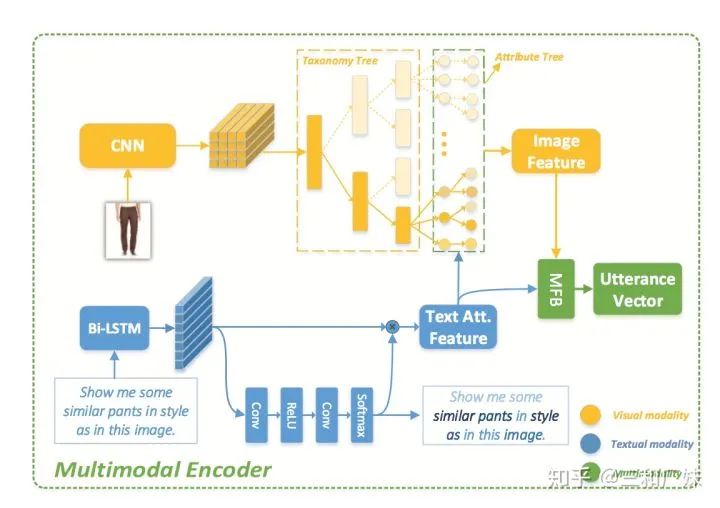

給定一張圖片(視頻)和一個與該圖片相關的自然語言問題,計算機能產生一個正確的回答。這是文本QA和Image Captioning的結合,一般會涉及到圖像內容上的推理,看起來更炫酷(不是指邏輯,就就指直觀感受)。

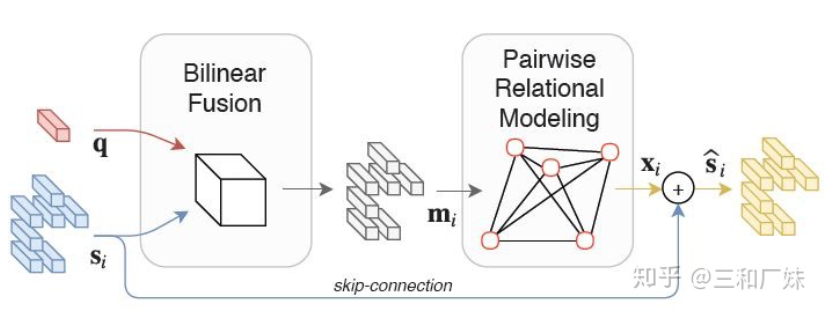

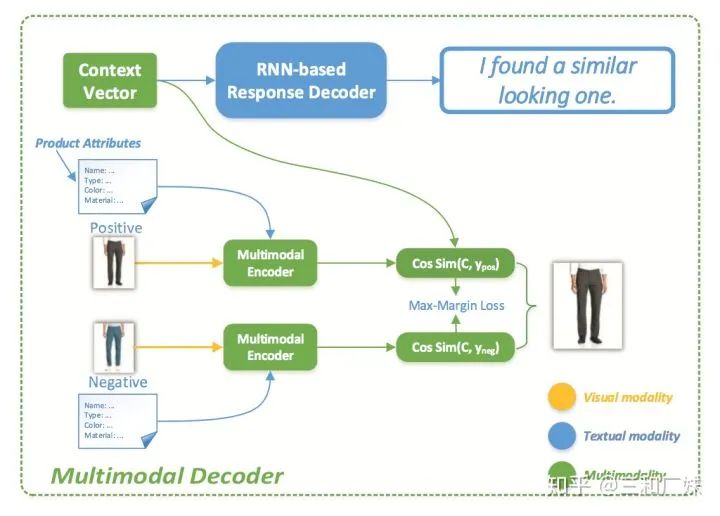

Joint embedding approaches,只是直接從源頭編碼的角度開始融合信息,這也很自然的聯想到最簡單粗暴的方式就是把文本和圖像的embedding直接拼接(ps:粗暴拼接這種方式很work),Billiner Fusion 最常用了,Fusion屆的LR

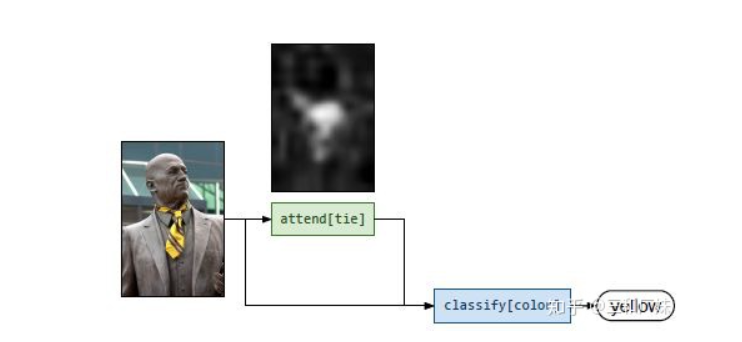

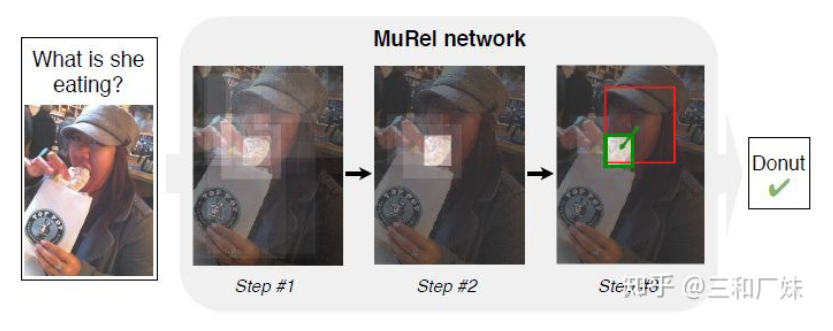

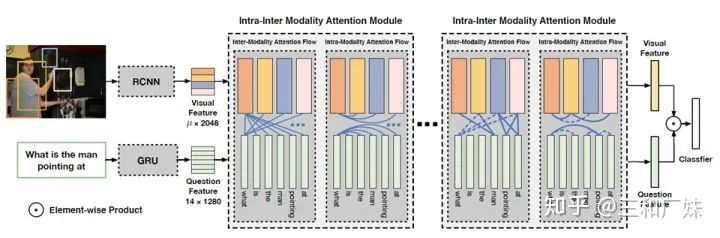

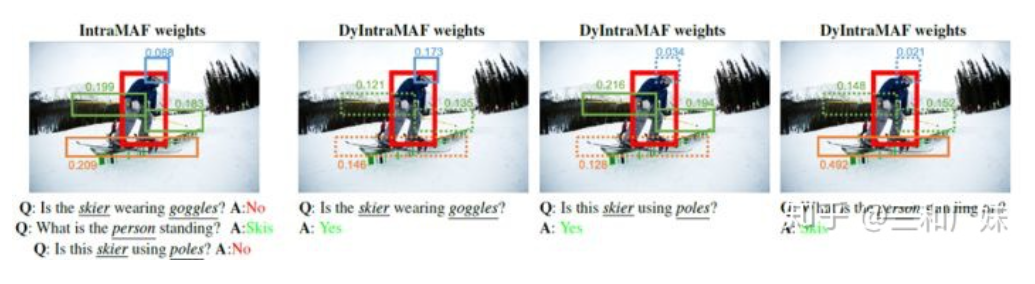

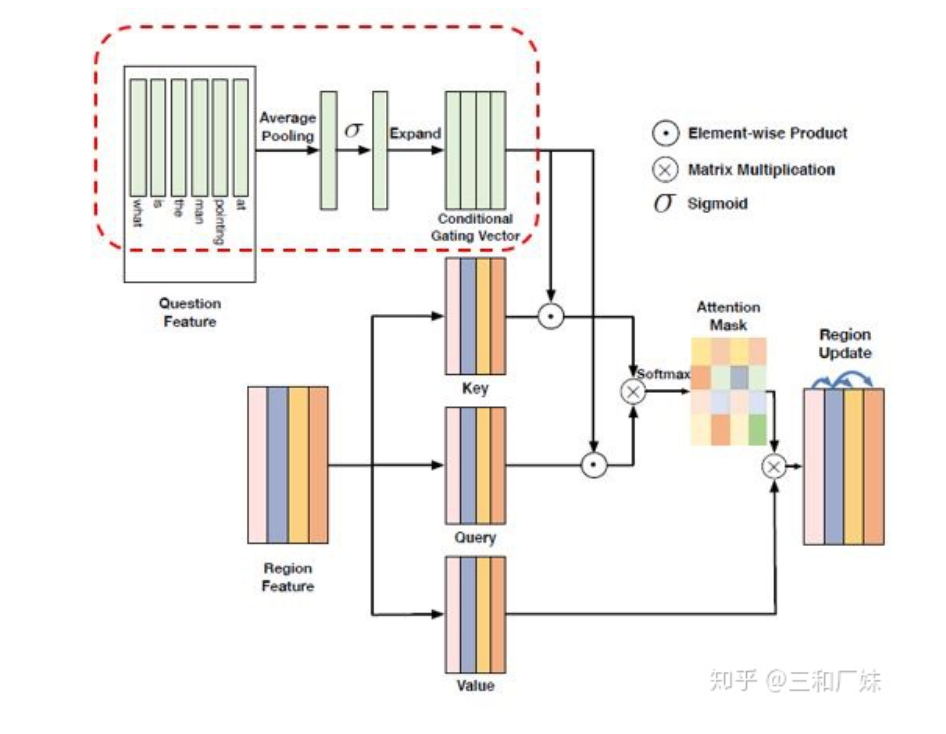

Attention mechanisms,很多VQA的問題都在attention上做文章,attention本身也是一個提取信息的動作,自從attention is all you need后,大家對attention的應用可以說是花式了,本文后面專門介紹CVPR2019的幾篇

Compositional Models,這種方式解決問題的思路是分模塊而治之,各模塊分別處理不同的功能,然后通過模塊的組裝推理得出結果

作者:三和廠妹

三和,一個城市邊緣貧瘠人群的棲息地。廠妹,在社會勞動中尋找價值的初心青年。目前在平安科技AI研究院做算法,主要感興趣方向包括對話系統,知識圖譜,文本搜索,推薦系統。三和什么都沒有,廠妹也無知,所以每一個任務都是全新的開始。

知乎ID:三和廠妹

參考

Neural Module Networks

Ask Me Anything: Free-form Visual Question Answering Based on Knowledge from External Sources

MUREL: Multimodal Relational Reasoning for Visual Question Answering

Dynamic Fusion with Intra- and Inter- Modality Attention Flow for Visual Question Answering

User Atention-guided Multimodal Dialog Systems

整理不易,還望給個在看!