13天搞定Python分布爬蟲【免費(fèi)視頻教程】

TIOBE 更新了 2021 年 10 月份編程語(yǔ)言指數(shù)排行榜。

榜單中共對(duì) 100 種編程語(yǔ)言進(jìn)行了評(píng)級(jí)排名,其中 Python 成為 “20 多年來的新語(yǔ)言霸主”,以 11.27% 的評(píng)級(jí)排名第 1 位;

C 和 Java 的“長(zhǎng)期霸權(quán)已經(jīng)結(jié)束”,分別以 11.16% 和 10.46% 的評(píng)級(jí)位列榜單第 2 和第 3 位。

Python穩(wěn)坐前三的寶座,只因當(dāng)下時(shí)代,大數(shù)據(jù)盛行。每一個(gè)成功的商業(yè)運(yùn)營(yíng)都會(huì)遇到它。

1、什么是爬蟲?

網(wǎng)絡(luò)爬蟲也叫網(wǎng)絡(luò)蜘蛛,如果把互聯(lián)網(wǎng)比喻成一個(gè)蜘蛛網(wǎng),那么爬蟲就是在網(wǎng)上爬來爬去的蜘蛛,爬蟲程序通過請(qǐng)求url地址,根據(jù)響應(yīng)的內(nèi)容進(jìn)行解析采集數(shù)據(jù)。比如:如果響應(yīng)內(nèi)容是html,分析dom結(jié)構(gòu),進(jìn)行dom解析、或者正則匹配,如果響應(yīng)內(nèi)容是xml/json數(shù)據(jù),就可以轉(zhuǎn)數(shù)據(jù)對(duì)象,然后對(duì)數(shù)據(jù)進(jìn)行解析。

2、爬蟲有什么作用?

通過有效的爬蟲手段批量采集數(shù)據(jù),可以降低人工成本,提高有效數(shù)據(jù)量,給予運(yùn)營(yíng)/銷售的數(shù)據(jù)支撐,加快產(chǎn)品發(fā)展。

目前互聯(lián)網(wǎng)產(chǎn)品競(jìng)爭(zhēng)激烈,業(yè)界大部分都會(huì)使用爬蟲技術(shù)對(duì)競(jìng)品產(chǎn)品的數(shù)據(jù)進(jìn)行挖掘、采集、大數(shù)據(jù)分析,這是必備手段,并且很多公司都設(shè)立了爬蟲工程師的崗位。

3、爬蟲可以用來干什么?

用爬蟲最大的好處是批量且自動(dòng)化得獲取和處理信息。用實(shí)際生活應(yīng)用舉例更加直觀:

1、獲得各個(gè)機(jī)場(chǎng)的實(shí)時(shí)流量

2、獲得熱點(diǎn)城市的火車票情況

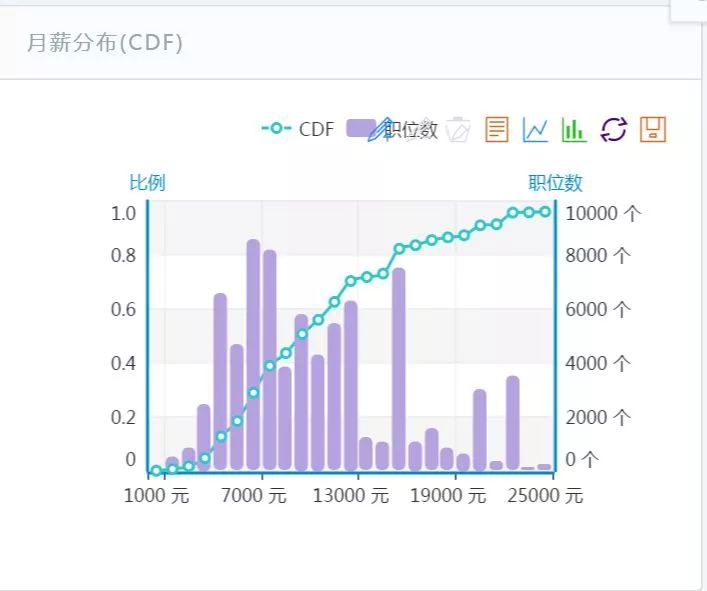

3、各種熱門公司招聘中的職位數(shù)及月薪分布

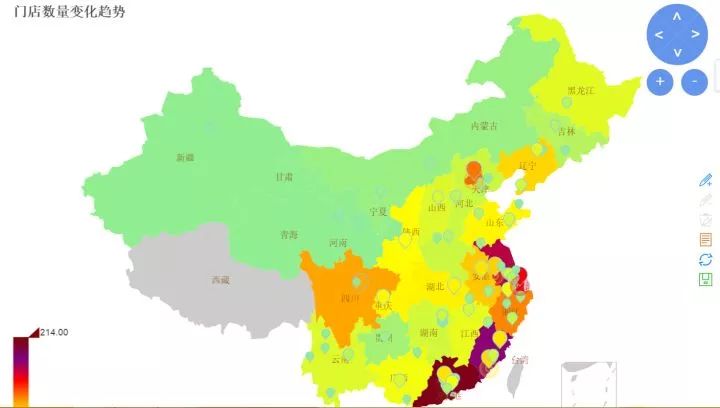

4、某公司的門店變化情況

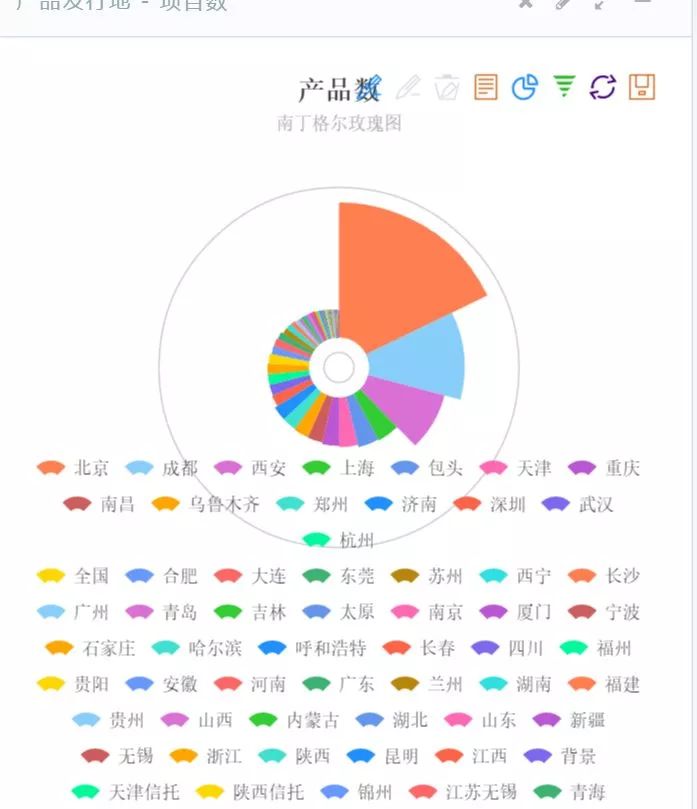

5、對(duì)某一類金融產(chǎn)品的檢測(cè)和跟蹤

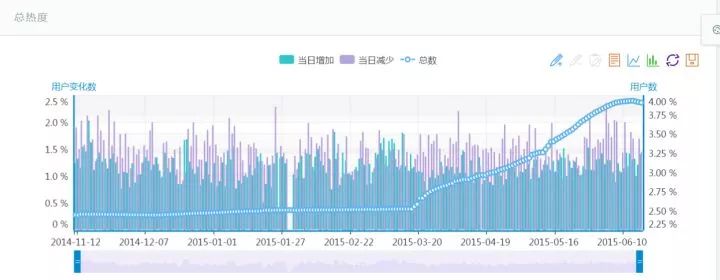

6、對(duì)某車型用戶數(shù)變化情況的跟蹤

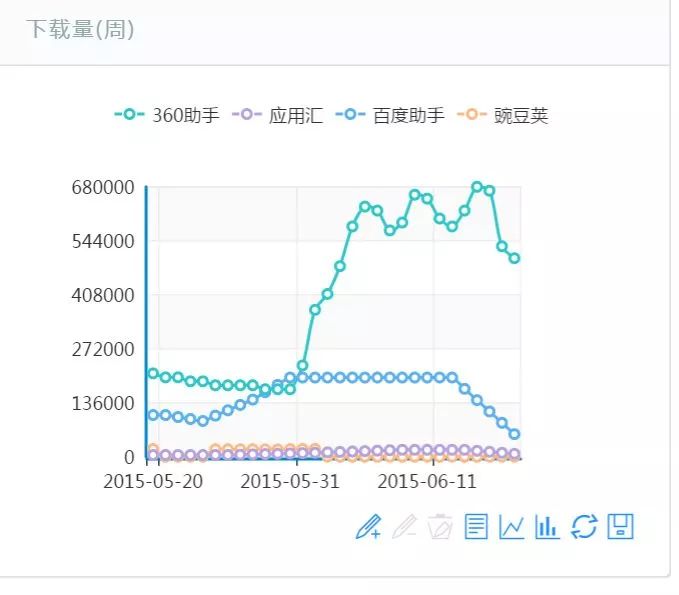

7、對(duì)某個(gè)App的下載量跟蹤

爬蟲技術(shù)好學(xué)嗎?一個(gè)視頻告訴你!

《13天搞定Python分布爬蟲》視頻教程,將爬蟲技術(shù)學(xué)習(xí)分為13天,逐步帶你入門,輕松上手,初學(xué)者也能學(xué)。

獲取方式

需要以上資料的朋友請(qǐng)?zhí)砑又淼奈?span style="outline: 0px;color: rgb(0, 0, 0);">信免費(fèi)領(lǐng)取

加微信請(qǐng)備注【777】

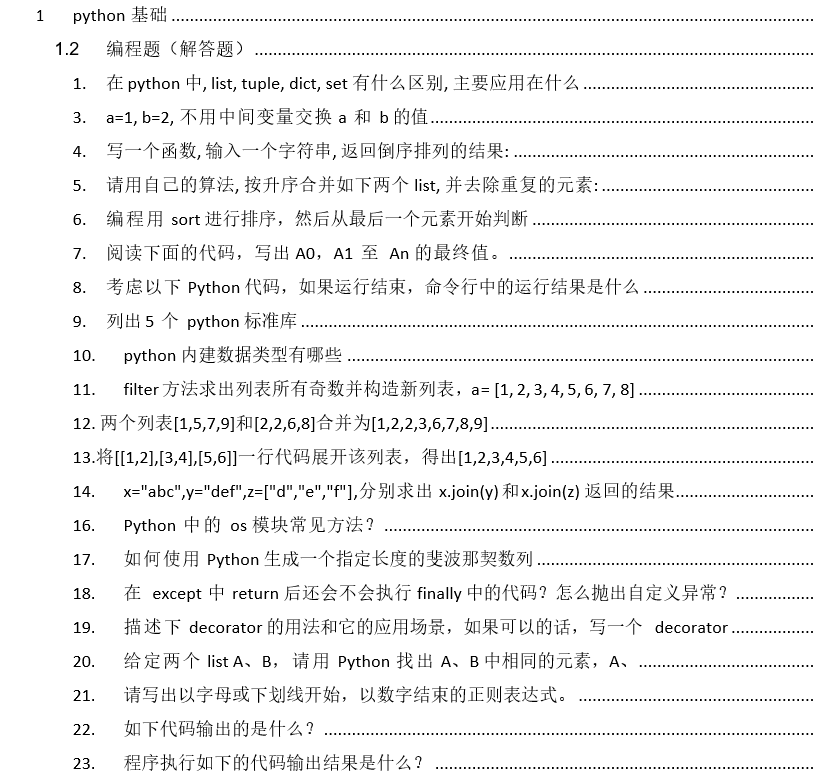

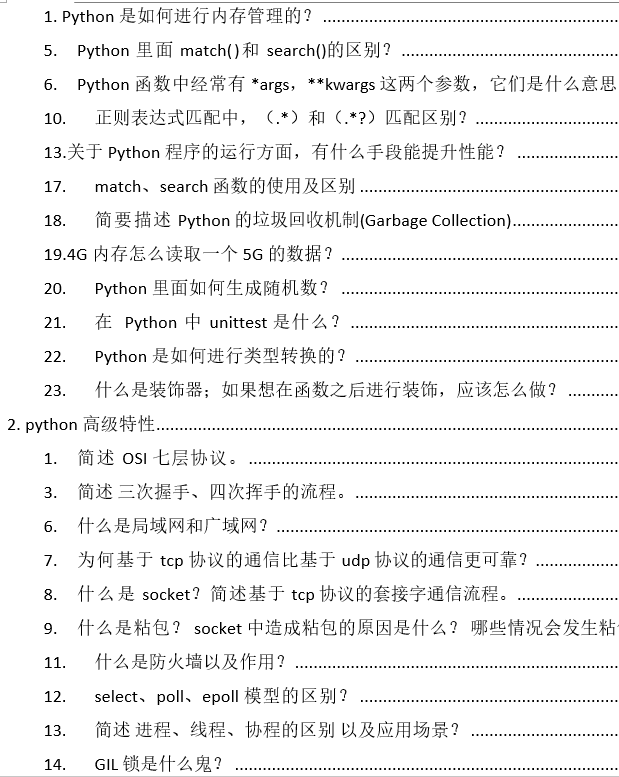

在這里,小編為大家準(zhǔn)備了一份面試資料給大家!希望能祝各位一臂之力!文件列表小編放在下方了,請(qǐng)各位有需要的同學(xué)掃描下方二維碼自行下載!

篇幅有限,展示部分。

需要以上資料的朋友請(qǐng)?zhí)砑又淼奈?span style="outline: 0px;color: rgb(0, 0, 0);">信免費(fèi)領(lǐng)取

前100名免費(fèi)領(lǐng)取

加微信請(qǐng)備注【777】