清華 CVer 對(duì)自監(jiān)督學(xué)習(xí)的一些思考(文末福利)

點(diǎn)擊上方“Jack Cui”,選擇“設(shè)為星標(biāo)”

第一時(shí)間關(guān)注技術(shù)干貨!

大家好,我是 Jack 。

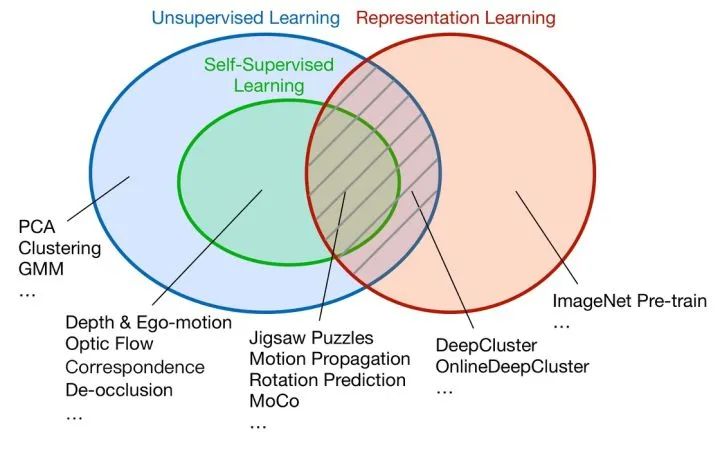

眾所周知,機(jī)器學(xué)習(xí)大致可分為有監(jiān)督學(xué)習(xí)和無(wú)監(jiān)督學(xué)習(xí)。

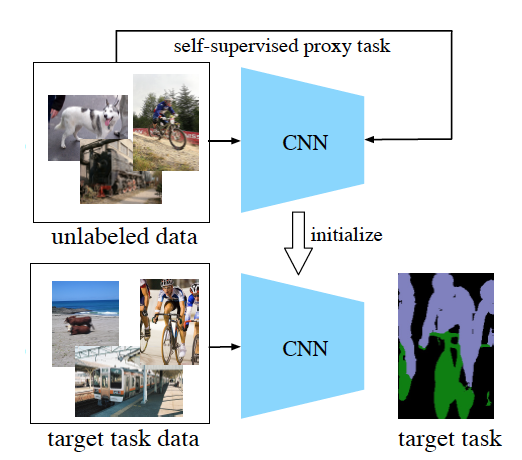

自監(jiān)督學(xué)習(xí)作為無(wú)監(jiān)督學(xué)習(xí)的一個(gè)特例,可以理解它是一種沒(méi)有人工標(biāo)注標(biāo)簽的監(jiān)督學(xué)習(xí),即沒(méi)有人類參與的監(jiān)督學(xué)習(xí)。

但標(biāo)簽仍然存在,只不過(guò)標(biāo)簽是從輸入數(shù)據(jù)中生成的,通常是使用啟發(fā)式算法生成。

自監(jiān)督學(xué)習(xí)的流行是勢(shì)在必然的。

在各種主流有監(jiān)督學(xué)習(xí)任務(wù)都做到很成熟之后,數(shù)據(jù)成了最重要的瓶頸。

從無(wú)標(biāo)注數(shù)據(jù)中學(xué)習(xí)有效信息一直是一個(gè)很重要的研究課題,其中自監(jiān)督學(xué)習(xí)提供了非常豐富的想象空間。

今天為大家?guī)?lái)的是一位本科清華,博士港中文畢業(yè)的大佬,對(duì)于自監(jiān)督學(xué)習(xí)的一些思考。

1

2

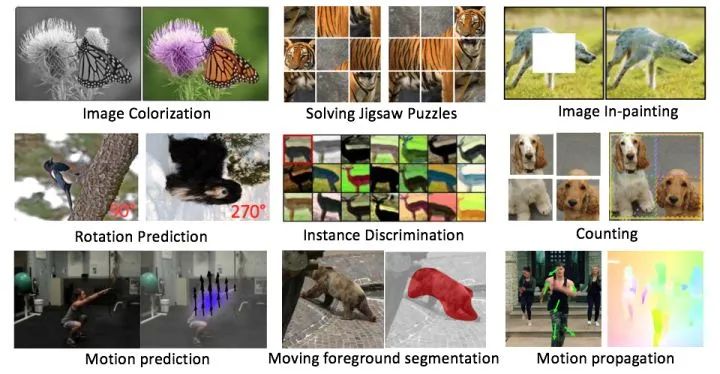

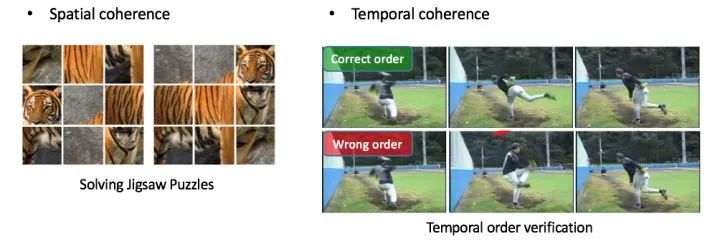

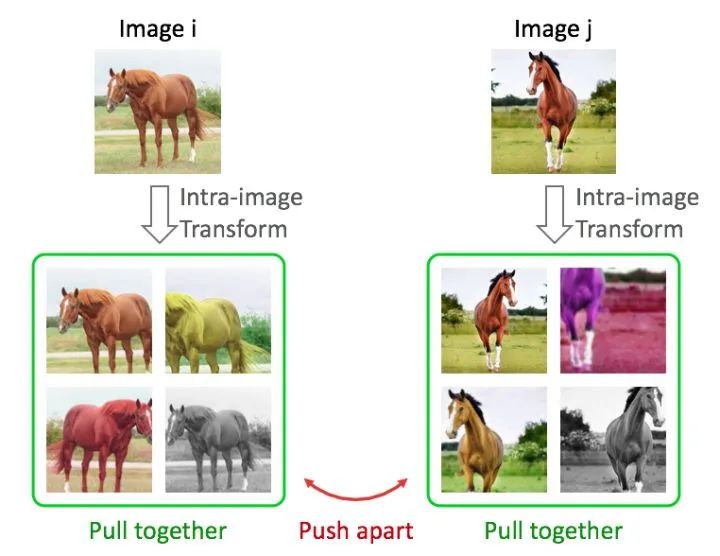

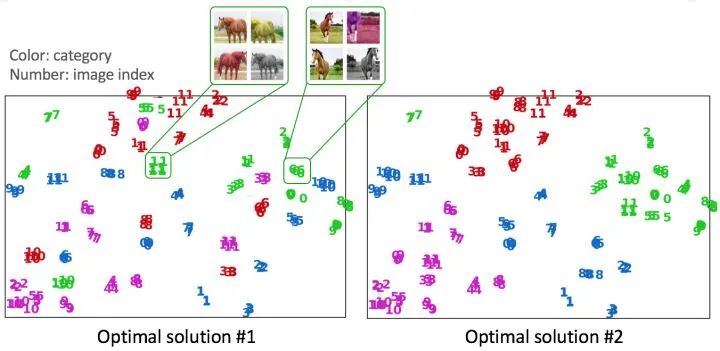

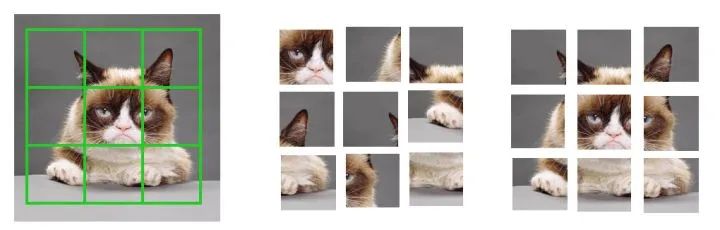

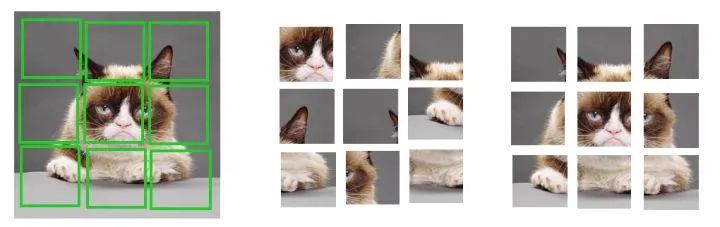

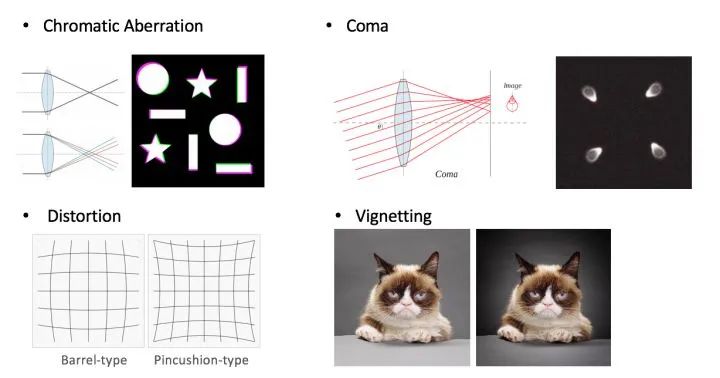

圖片具有空間連貫性,視頻具有時(shí)空連貫性。那么就可以利用這些特點(diǎn)來(lái)設(shè)計(jì)自監(jiān)督任務(wù)。如下圖,Solving Jigsaw Puzzles [4] 利用圖片中物體空間上的語(yǔ)義連貫性,Temporal order verification [5]任務(wù)利用了視頻中物體運(yùn)動(dòng)的時(shí)間連貫性。

圖五,利用數(shù)據(jù)空間、時(shí)間連貫性的自監(jiān)督任務(wù)

3

4

我們的世界是在嚴(yán)格的物理學(xué)、化學(xué)、生物學(xué)規(guī)則下運(yùn)行的,視覺(jué)信號(hào)是這些內(nèi)在規(guī)則的外在反映,而深度學(xué)習(xí),正好非常擅長(zhǎng)處理高維的視覺(jué)信號(hào)。

所以,無(wú)監(jiān)督、自監(jiān)督學(xué)習(xí)的存在和發(fā)展是必然的,因?yàn)槭澜绫旧砭褪怯行虻摹⒌挽氐模@使得數(shù)據(jù)本身就已經(jīng)包含了豐富的信息。

自監(jiān)督學(xué)習(xí)看似神奇,但理解了其本質(zhì)之后,也就會(huì)覺(jué)得是情理之中了。當(dāng)然,目前學(xué)術(shù)界對(duì)自監(jiān)督學(xué)習(xí)的理解程度,可能也只是九牛一毛而已。未來(lái)會(huì)走向什么方向,誰(shuí)也說(shuō)不準(zhǔn)。

目前是基于數(shù)據(jù)之間的結(jié)構(gòu)的instance discrimination處于state-of-the-art,未來(lái),基于priors的方法更勝一籌也是有可能的。

所以,千萬(wàn)不要受限于一類方法,不要讓自監(jiān)督學(xué)習(xí)變成了調(diào)參游戲,自監(jiān)督領(lǐng)域的想象空間其實(shí)非常大。

最后,這個(gè)總結(jié)主要基于自己的思考,也許不一定非常到位,權(quán)當(dāng)拋磚引玉。希望大家都能夠設(shè)計(jì)出有趣又有用的自監(jiān)督學(xué)習(xí)任務(wù),為這個(gè)領(lǐng)域添磚加瓦。

本文已由原作者授權(quán),不得擅自二次轉(zhuǎn)載。

https://zhuanlan.zhihu.com/p/150224914

References:

Pathak, Deepak, et al. "Context encoders: Feature learning by inpainting."Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

Walker, Jacob, Abhinav Gupta, and Martial Hebert. "Dense optical flow prediction from a static image."Proceedings of the IEEE International Conference on Computer Vision. 2015.

Noroozi, Mehdi, and Paolo Favaro. "Unsupervised learning of visual representations by solving jigsaw puzzles."European Conference on Computer Vision. Springer, Cham, 2016.

Misra, Ishan, C. Lawrence Zitnick, and Martial Hebert. "Shuffle and learn: unsupervised learning using temporal order verification."European Conference on Computer Vision. Springer, Cham, 2016.

Wu, Zhirong, et al. "Unsupervised feature learning via non-parametric instance discrimination."Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018.

Grill, Jean-Bastien, et al. "Bootstrap Your Own Latent: A New Approach to Self-Supervised Learning."arXiv preprint arXiv:2006.07733(2020).

5

看到這里的,都是真愛(ài),12 月份的福利來(lái)啦~

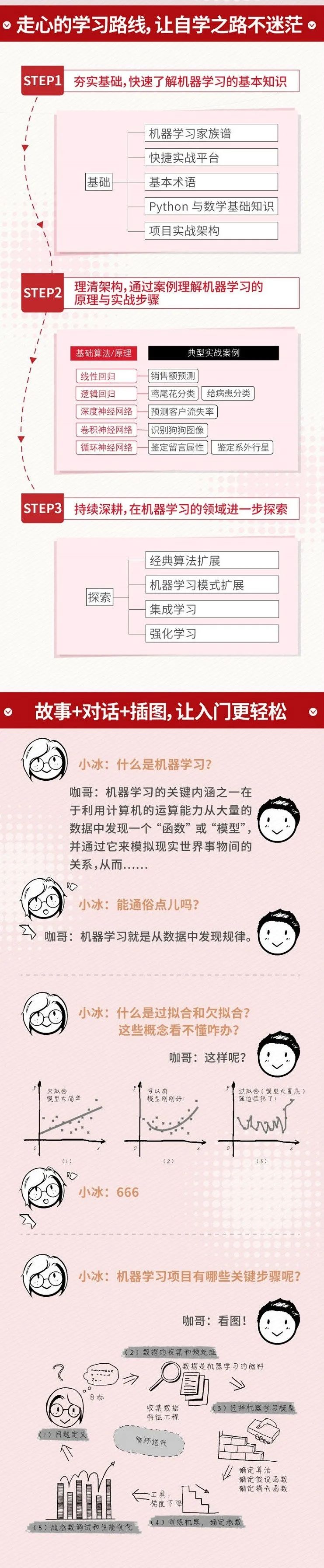

本書的內(nèi)容,可以看下圖的簡(jiǎn)介(上下滑動(dòng)查看):

作者黃佳,新加坡埃森哲公司高級(jí)顧問(wèn),人工智能專家,機(jī)器學(xué)習(xí)和云計(jì)算高級(jí)工程師。

6

參與活動(dòng)的記得加我微信,謹(jǐn)防失聯(lián)。

推薦閱讀

?? ?川普的退休生活?不,是AI算法的宅舞演繹?? ?「充電學(xué)習(xí)」物體檢測(cè)的主流方法????「修煉開(kāi)始」一文帶你入門深度學(xué)習(xí)